在官网使用DeepSeek时经常会出现服务器繁忙,且官方因最近客户过多,也关闭了API的购买。

那么,我们就换一种方式,利用硅基流动+Cherry Studio 轻松连接DeepSeek

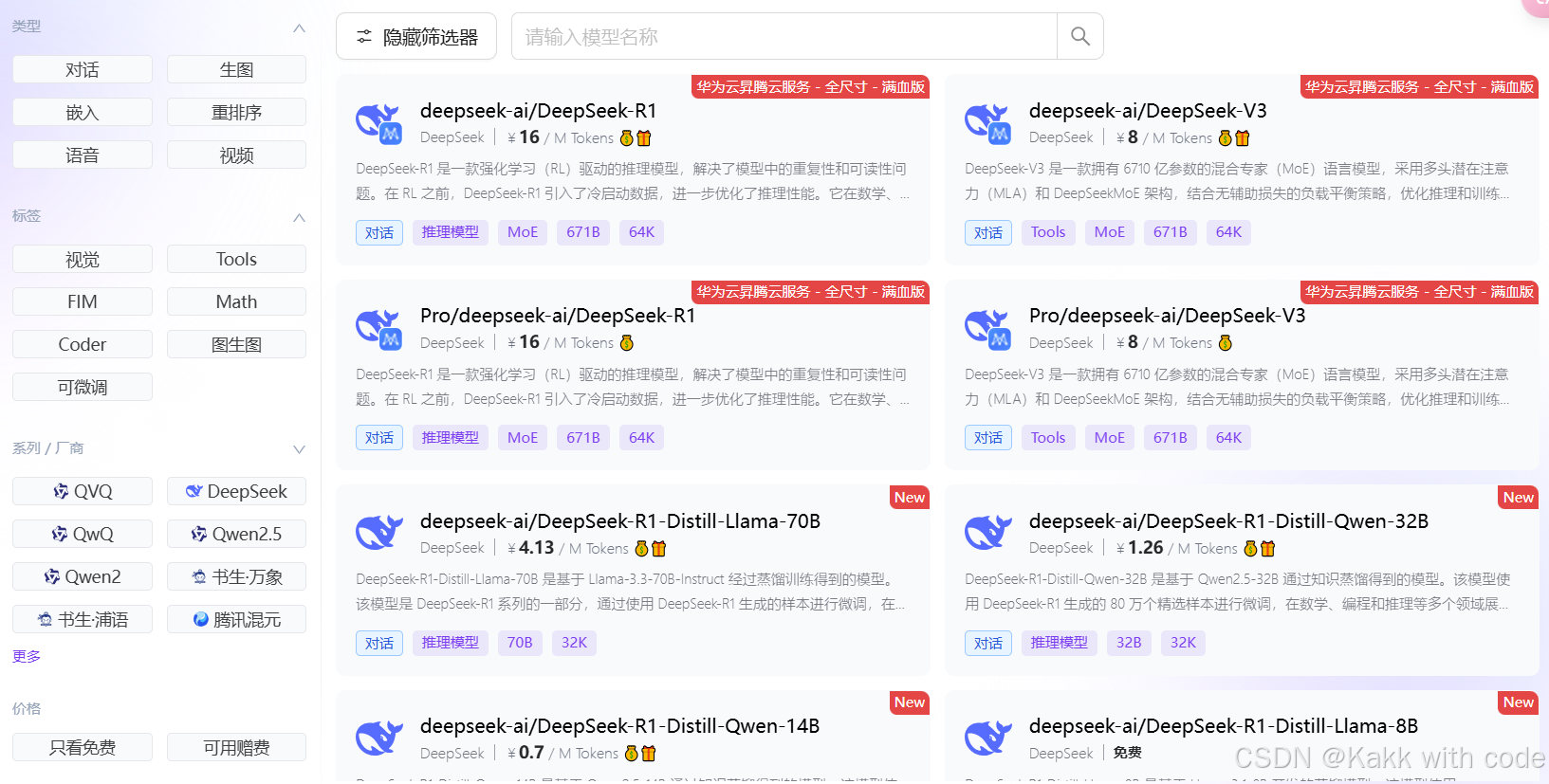

目前:硅基流动支持所有版本的DeepSeek使用。R1 V3 以及各个版本的蒸馏模型,都可以调用。

(其实不止DeepSeek,还有很多大模型都可以调用)。

话不多说,直接开始操作,用最简洁的办法帮你完成deepseek的接入。

一、安装应用

我这里用的是Cherry Studio,网上还有许多工具

(都可以,就是一个工具,以后直接打开工具即可对话)

Cherry Studio:https://cherry-ai.com/

二、注册硅基流动

官网:SiliconFlow, Accelerate AGI to Benefit Humanity

打开官网:

①log in

②输入手机号,获取验证码

③ 输入邀请码(一定记得填写,填写立即获取14块钱的token!)

邀请码:xjhU9yH7

调用三方软件的api的部分模型会产生费用,如上面图中的DeepSeek R1的满血版。

三、调用API

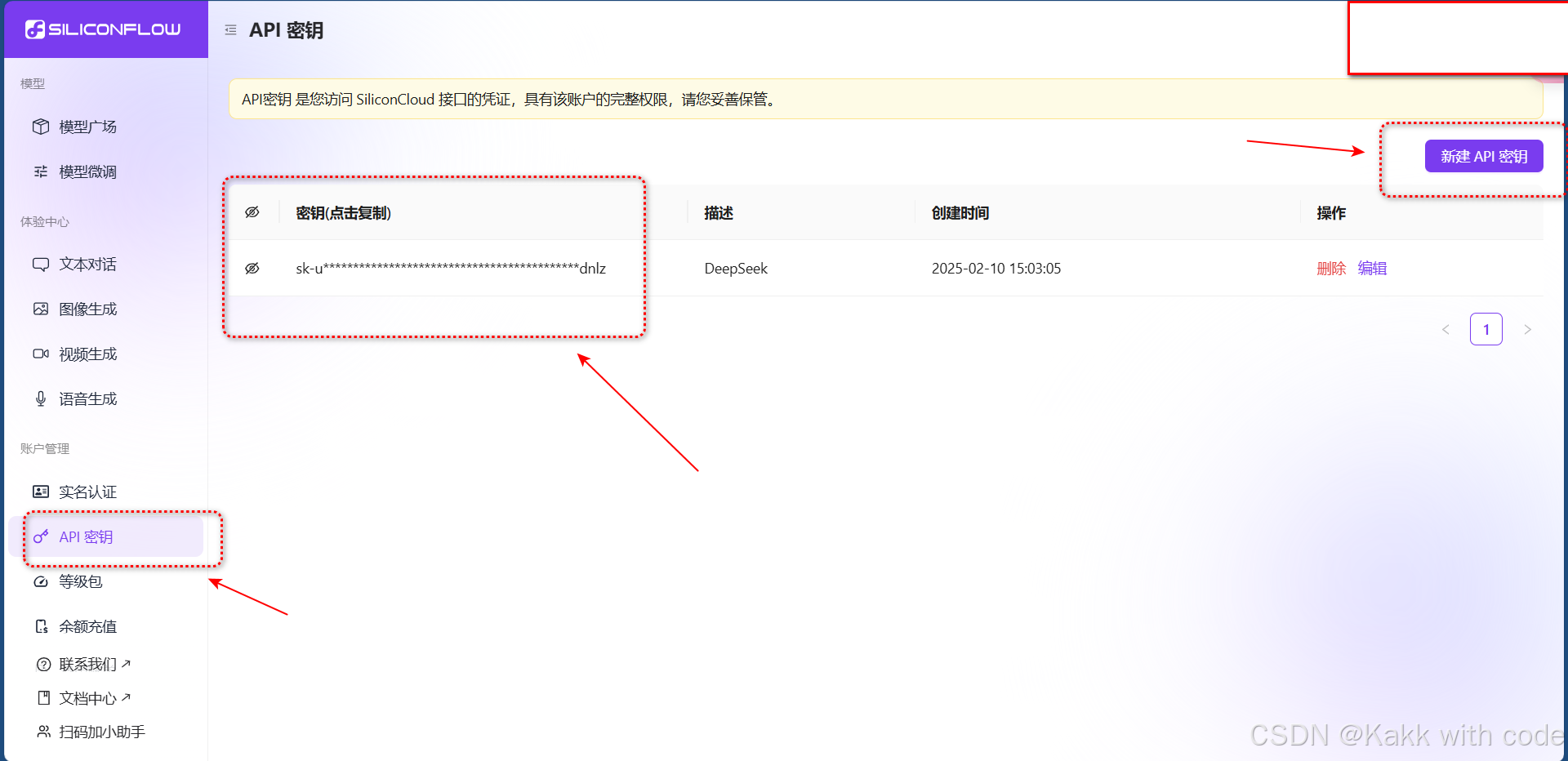

①获取API

进入主页后,我们点击”API密匙“——新建api密钥——点击复制,就获得了硅基流动的API了。

(流程如下图,创建过程中随意命名都可以)

②通过Cherry Studio接入API

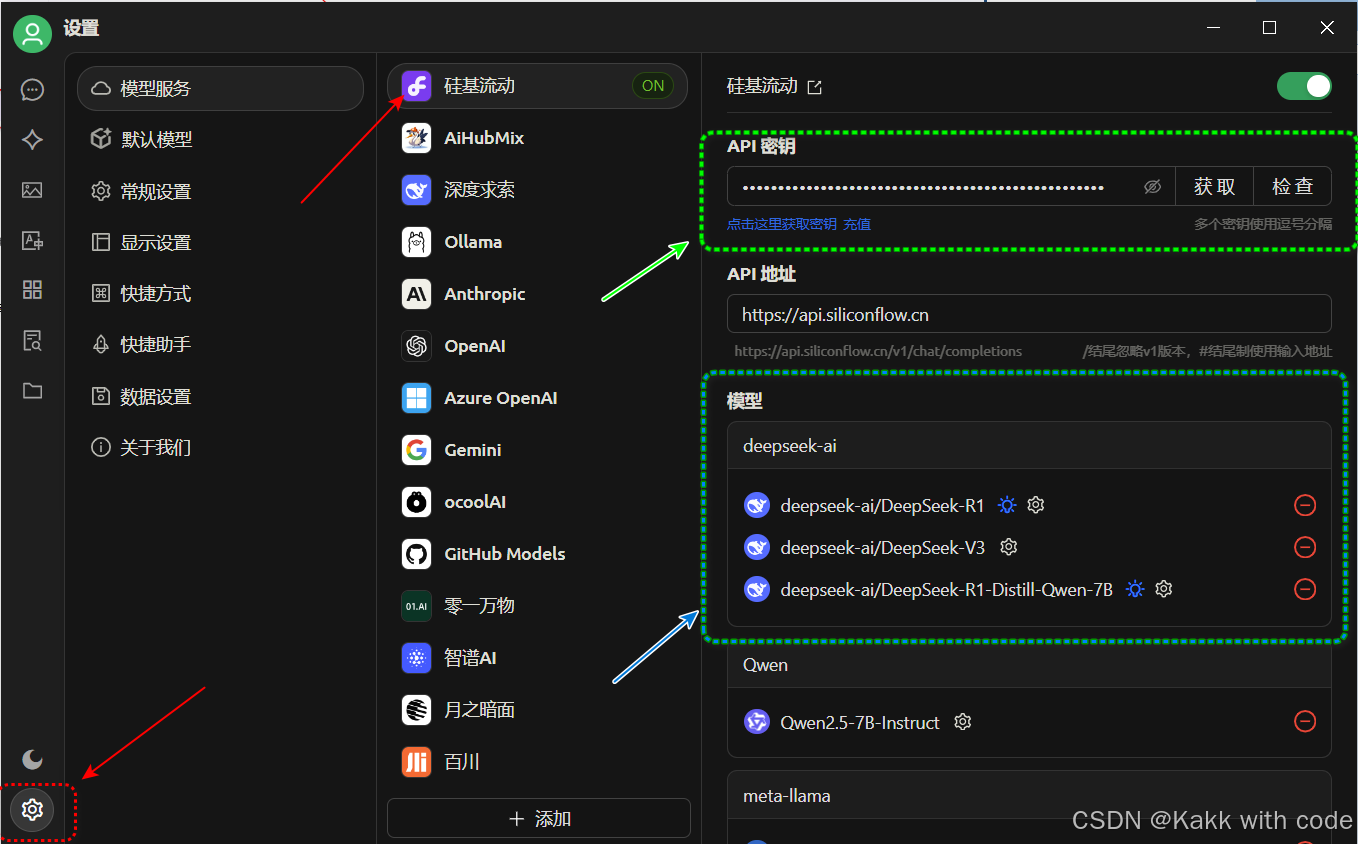

打开我们安装好的应用程序:Cherry Studio

我们需要在安装的Cherry Studio中添加API.

我们进入Cherry Studio后,点击左下角的设置,然后选择硅基流动,在API密钥一栏中粘贴刚才复制好的API密钥,这样就完成了部署。

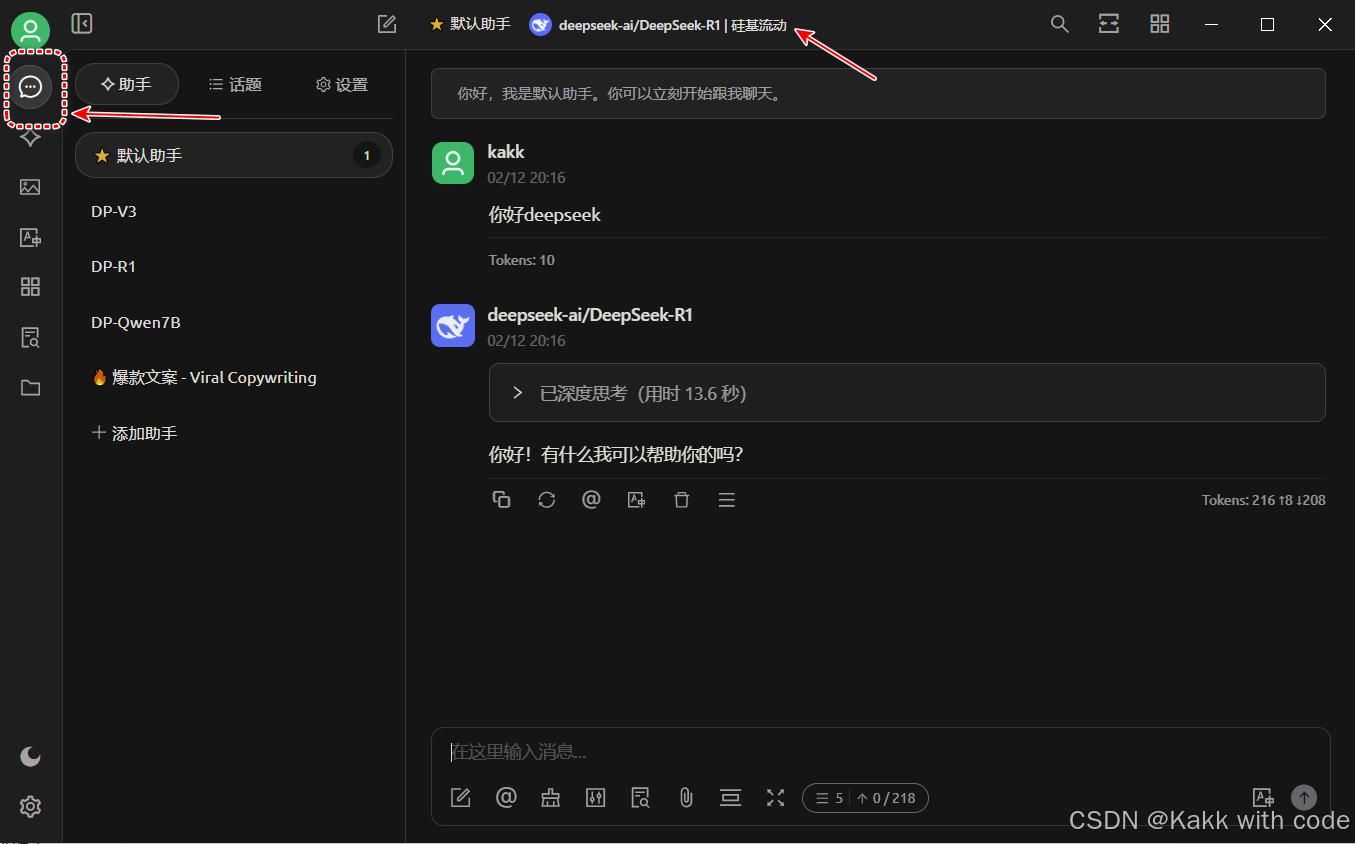

③最后一步:开始对话

进入到上面的聊天功能,在聊天框中选择:DeepSeek R1模型,就可以开始对话啦!

495

495

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?