系列文章目录

大模型实战入门(一):1. Linux 前置基础(基本命令、SSH及端口映射)

大模型实战入门(二):2. Python 前置基础(熟悉断点调试、依赖指定路径安装)

大模型实战入门(三):3. Git 前置基础(熟悉常见 Git 命令及GitHub 平台)

前言

目标:从0开始学习LLM

平台:InternStudio开发机

教程:书生大模型实战营

提示:以下是基于书生大模型实战营(第四期)——入门岛:玩转Hugging Face/魔搭/魔乐平台(熟悉模型下载上传及应用上传)的学习内容

一、Hugging Face简介

1. 什么是Hugging Face

Hugging Face 是一家专注于自然语言处理和机器学习的公司,以其开源的Transformers库而闻名该平台提供了丰富的预训练模型,支持多种语言任务,如文本生成、翻译和情感分析。HuggingFace 还致力于推动A!的民主化,鼓励开发者和研究人员共享和合作。

Hugging Face 最初专注于开发聊天机器人服务。尽管他们的聊天机器人项目并未取得预期的成功但他们在GitHub上开源的Transformers库却意外地在机器学习领域引起了巨大轰动。如今Hugging Face已经发展成为一个拥有超过1,000,000个模型和200,000+个数据集的平台,被誉为机器学习界的GitHub。

HF的Transformers库是HF最核心的项目,它可以:

- 直接使用预训练模型进行推理

- 提供了大量预训练模型可供使用

- 使用预训练模型进行迁移学习

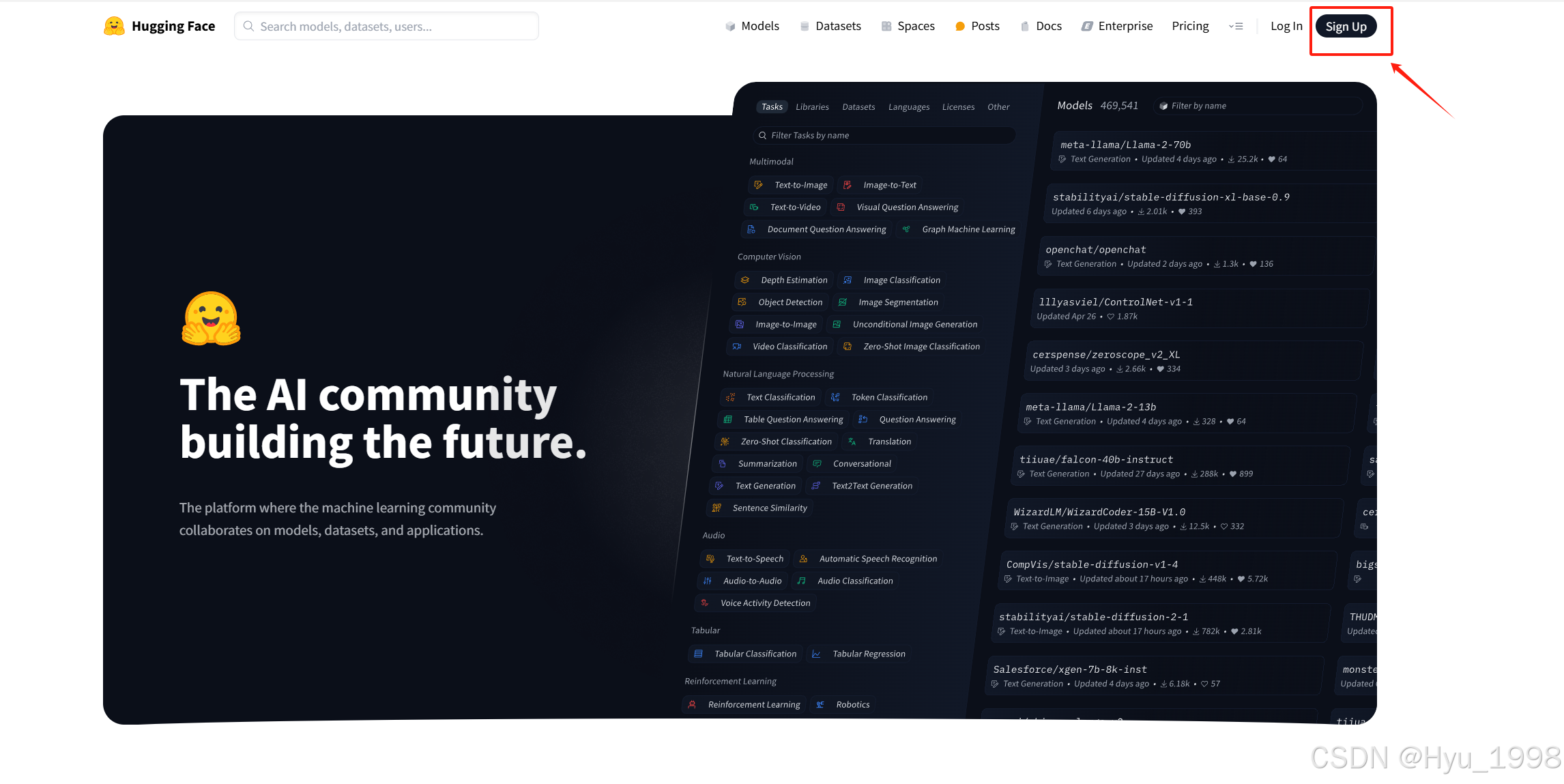

2. 注册Hugging Face

进入HF的官网:官网地址

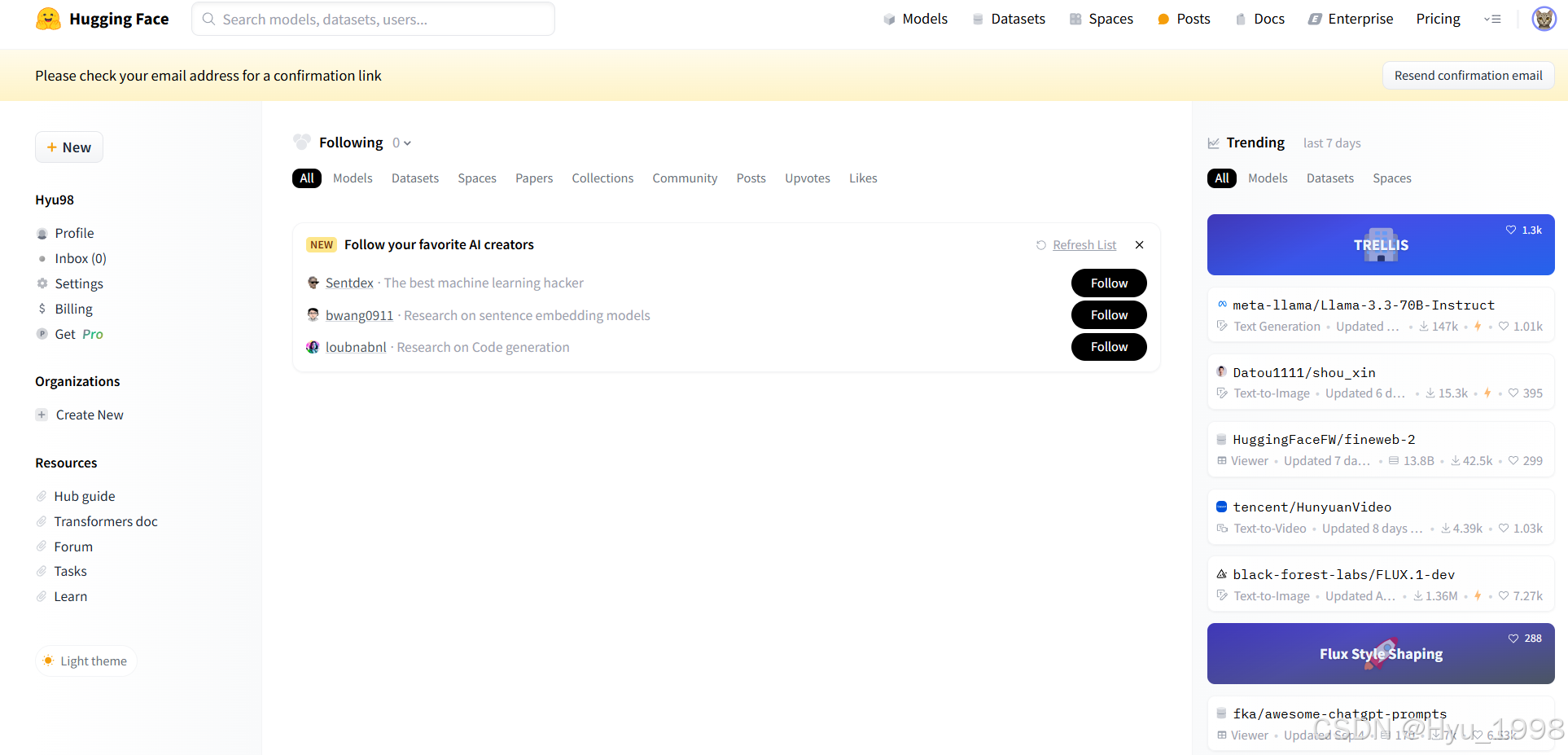

注册成功后便会进入首页

3. InternLM模型下载

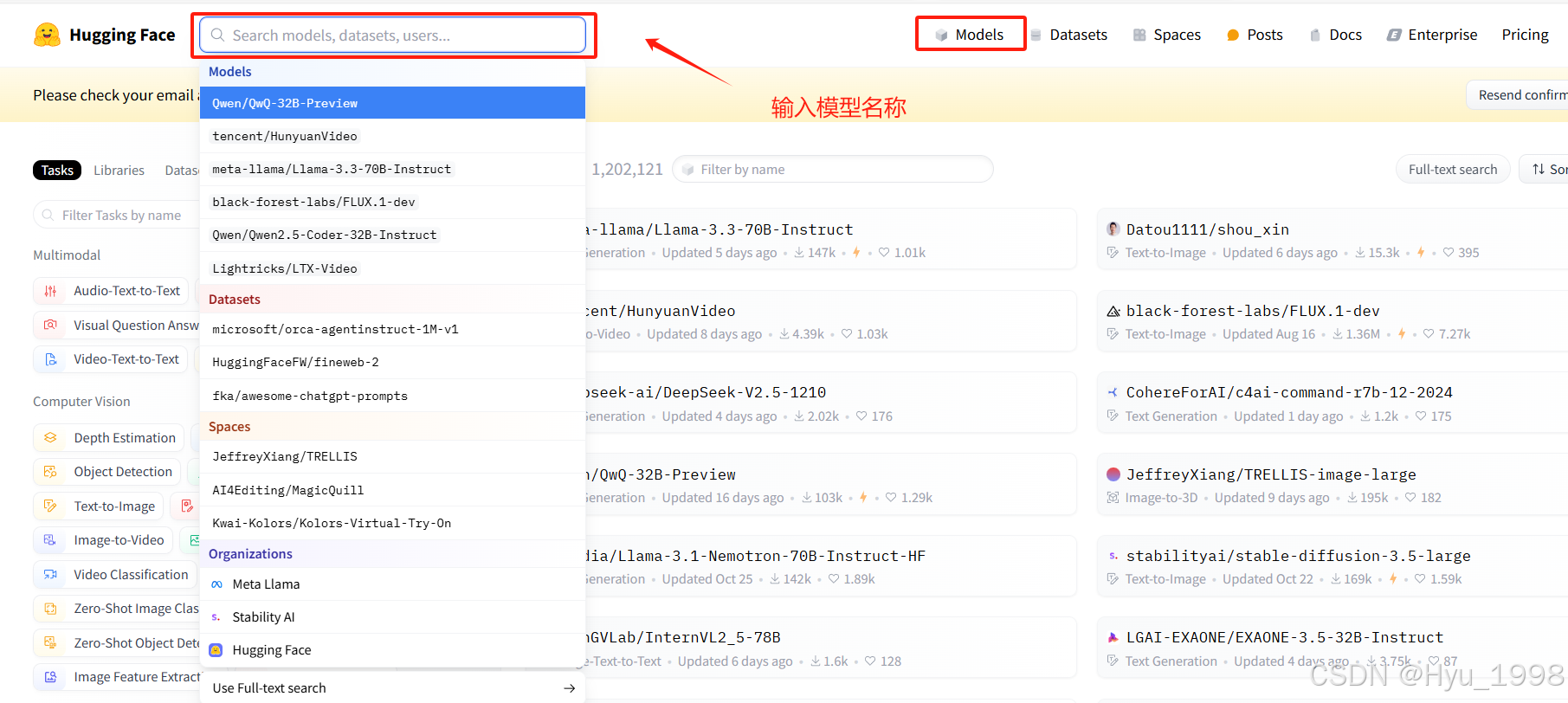

点击 models ,进入模型下载界面,输入需要下载的模型

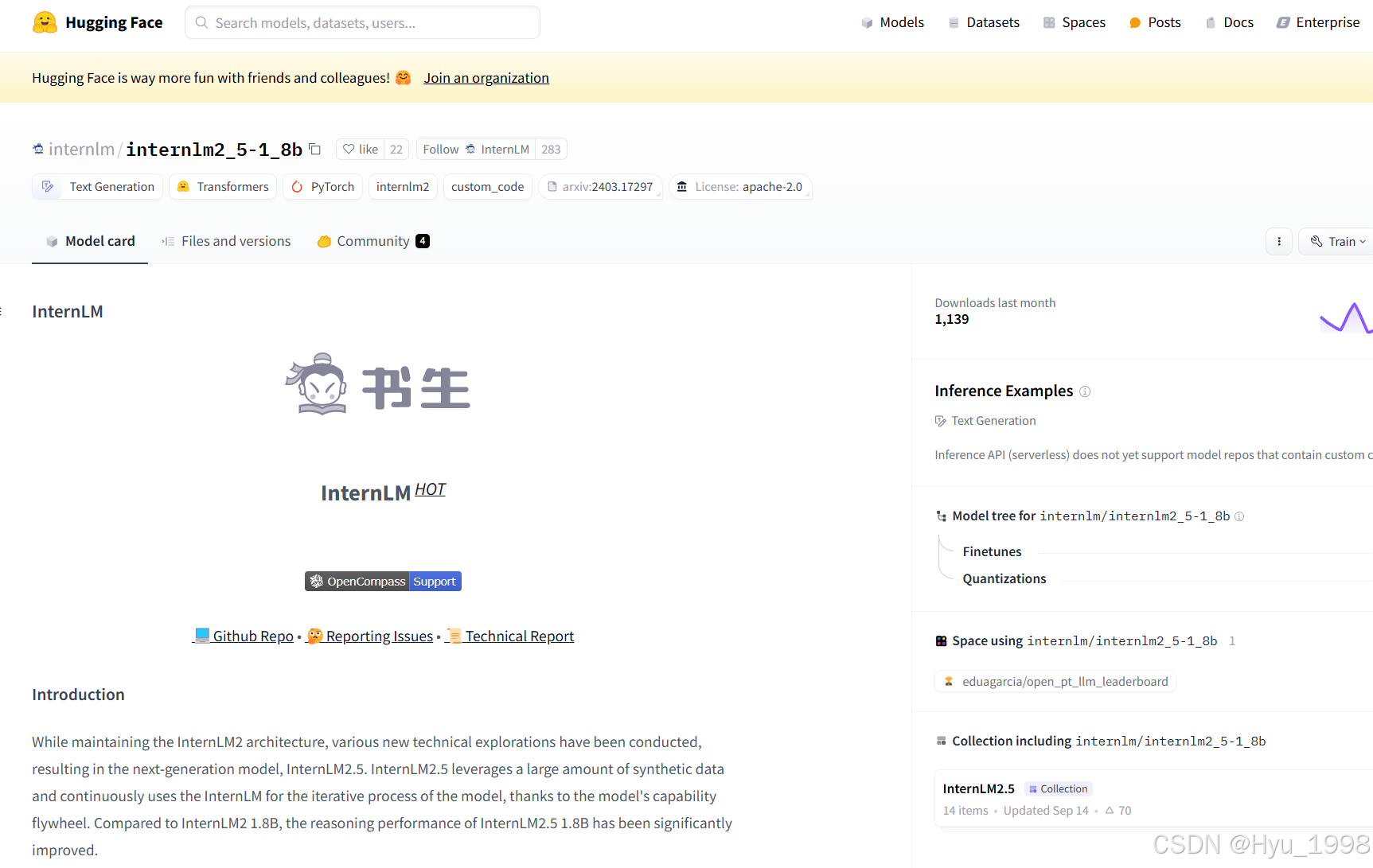

以“internlm2_5-1_8b”为例,输入后即可看见该模型详细信息

4. 使用GitHub CodeSpace

4.1 GitHub CodeSpace

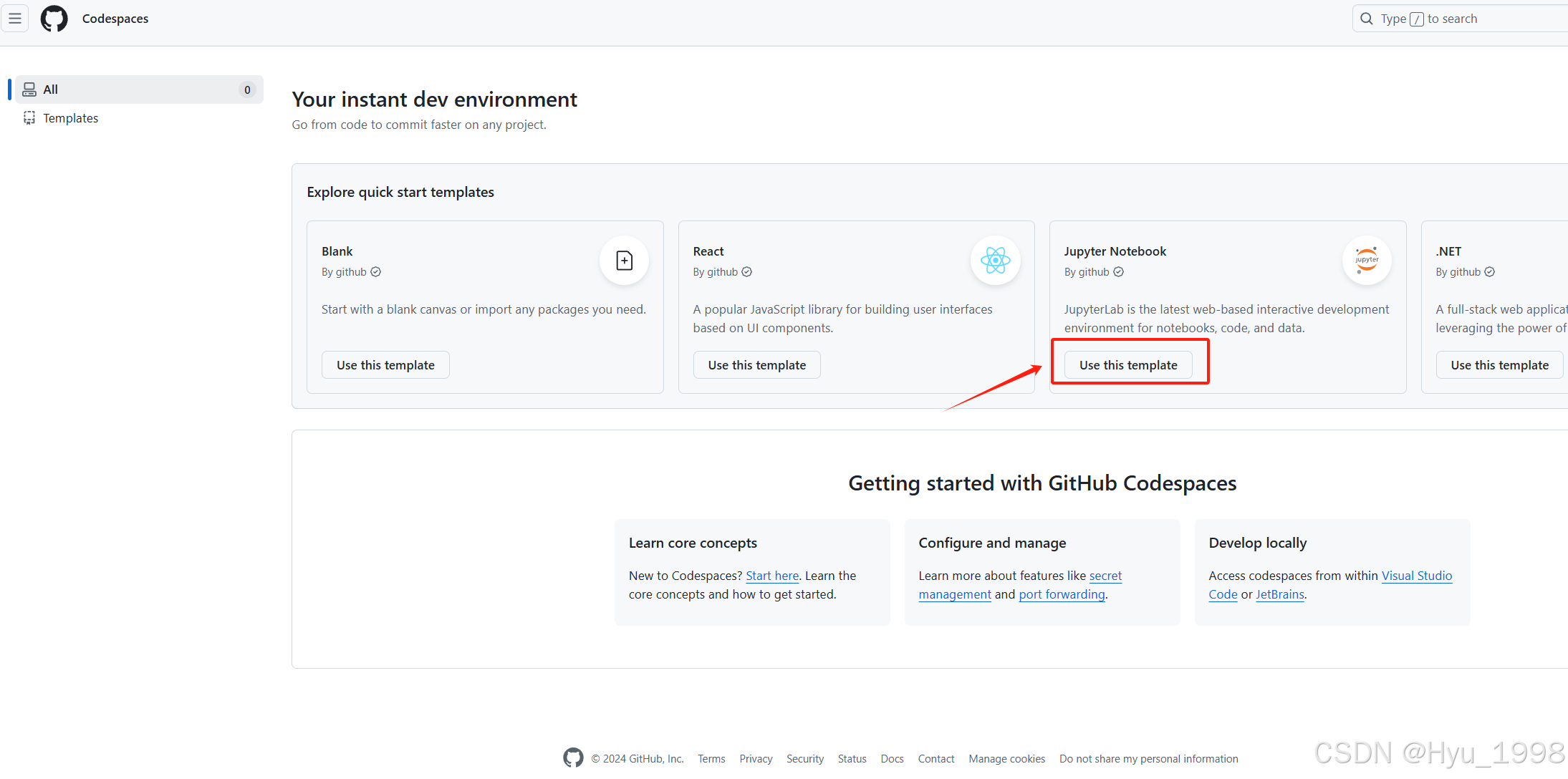

GitHub Codespace 通过 GitHub 原生的完全配置、安全的云开发环境,可以更快地启动和写代码它提供了一系列模板,我们在跑机器学习深度学习相关的实验的时候,可以选择它的Jupyter NoteBook模板。

GitHub CodeSpace:访问地址

4.2 配置环境

选择它的Jupyter NoteBook模板

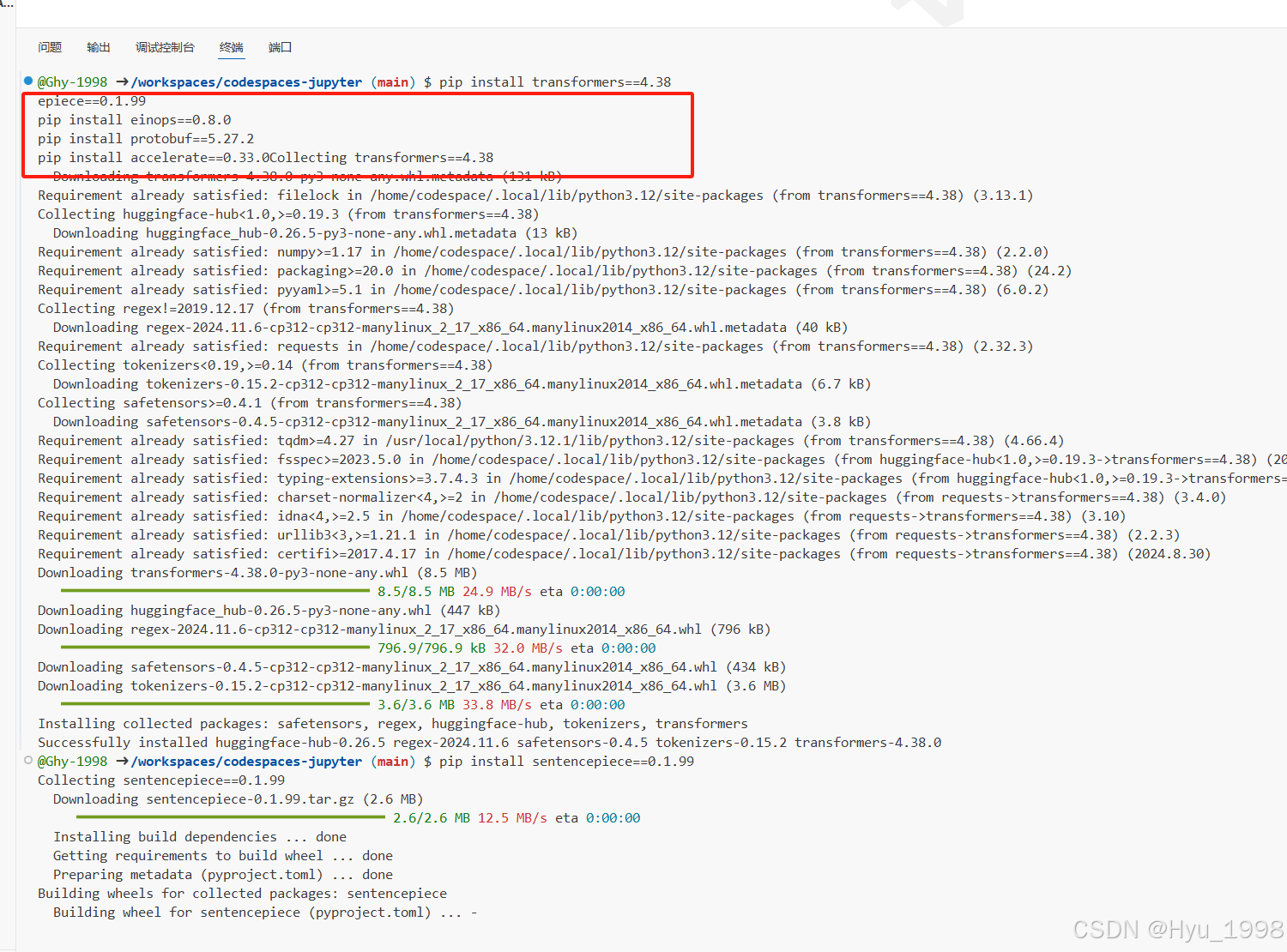

进入终端后,安装以下依赖,便于模型运行

# 安装transformers

pip install transformers==4.38

pip install sentencepiece==0.1.99

pip install einops==0.8.0

pip install protobuf==5.27.2

pip install accelerate==0.33.0

4.3 下载internlm2_5-7b-chat的配置文件

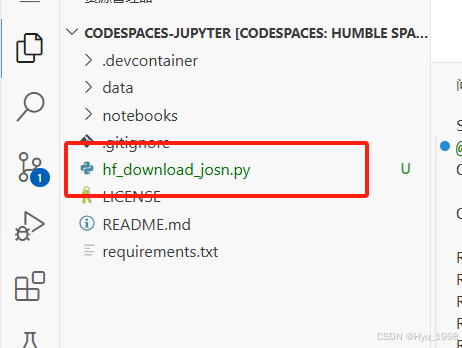

考虑到个人GitHub CodeSpace硬盘空间有限(32GB可用),而7B的模型相对较大,这里我们先演示如何下载模型文件夹的特定文件。 考虑到CodeSpace平台上默认的用户权限不是root权限,这里为方便演示直接在工作区创建文件,即 /workspaces/codespaces-jupyter 目录

以下载模型的配置文件为例,先新建一个hf_download_josn.py 文件

touch hf_download_josn.py

在这个文件中,粘贴以下代码:

import os

from huggingface_hub import hf_hub_download

# 指定模型标识符

repo_id = "internlm/internlm2_5-7b"

# 指定要下载的文件列表

files_to_download = [

{

"filename": "config.json"},

{

"filename": "model.safetensors.index.json"}

]

# 创建一个目录来存放下载的文件

local_dir = f"{

repo_id.split('/')[1]}"

os.makedirs(local_dir, exist_ok=True)

# 遍历文件列表并下载每个文件

for file_info in files_to_download:

file_path = hf_hub_download(

repo_id=repo_id,

filename=file_info["filename"],

local_dir

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2284

2284

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?