NAS+Ollama 打造个人专属 DeepSeek AI 实验室

基于 NAS 私有化部署 Ollama 和 open-webui 开源框架,打造低成本私有 AI 实验室

项目速览

- 🌐 传送门:

- ollama: https://github.com/ollama/ollama

- open-webui: https://github.com/open-webui

- 👨 维护现状:github 顶流项目,非常活跃

- 🛠️ 核心功能:

- 📚 支持 150+ 开源模型 : ollama library 有大量最新的模型,一键 pull 即可使用

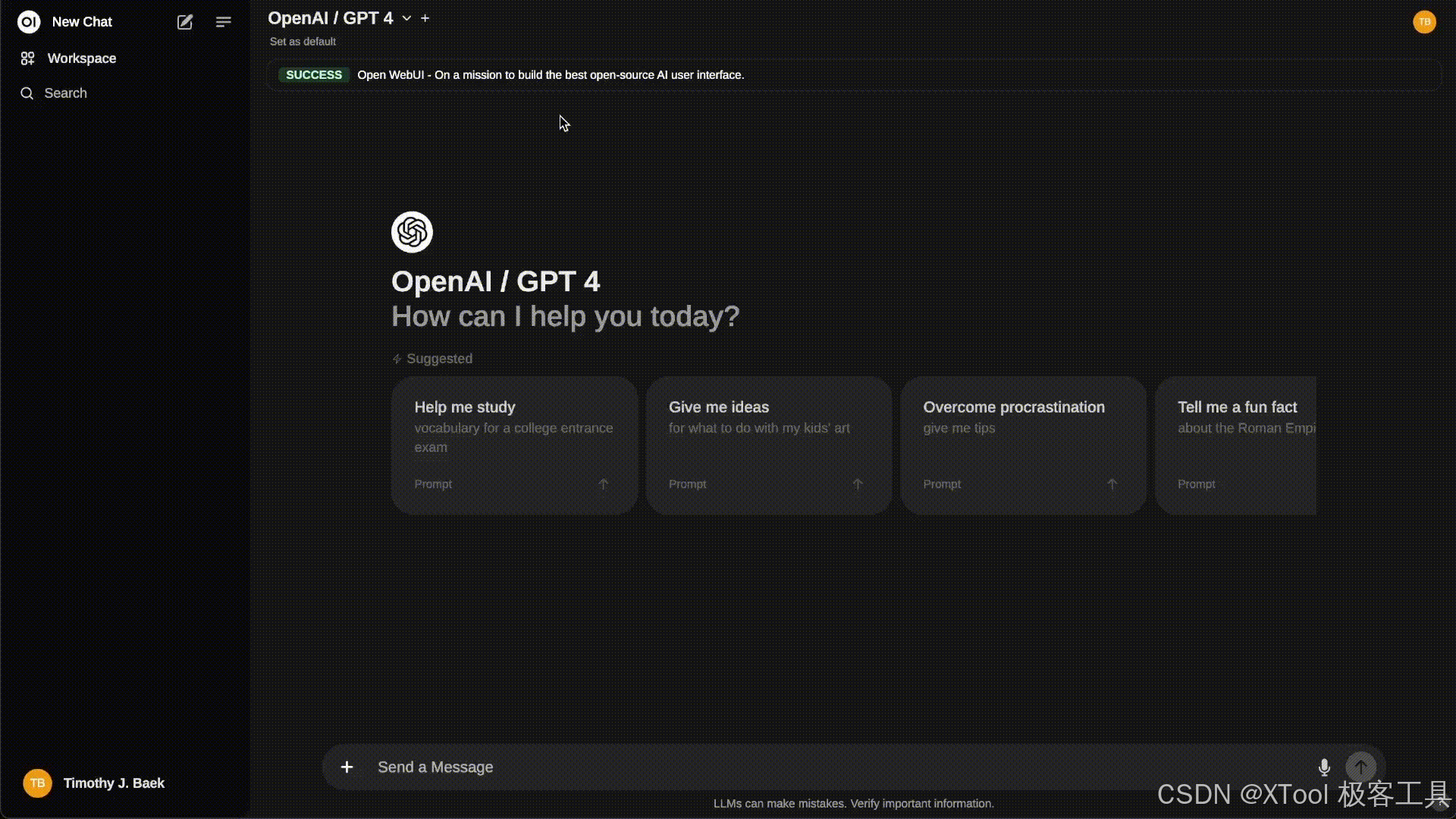

- 🖥️ ChatGPT 同款交互: open-webui

- 👍 多模态:支持联网搜索,语音,图片,文件等

- 📦 部署方式:

- Docker 一键部署(NAS 首选方案)

- 在线脚本一键安装

场景定位

🙋 推荐人群

- ✅ NAS 钉子户:4G 显卡就都能跑的 AI 神器

- ✅ 开发大咖:新模型随时远程开测

- ✅ 教育先锋:零门槛开展 AI 教学实践

🚨 劝退指南

- ❌ 图形界面依赖症(需要敲三行命令)

- ❌ 8G 内存守财奴(建议 16G+ 起步)

- ❌ 商业级需求(满血版请右转充值)

技术透视

💡小白解读

🤖相当于把「AI 研究所」塞进你家机柜,用树莓派的价格享受云计算厂的快乐

💰技术收益:比云服务便宜 90%,响应速度提升 3 倍!

🥇技术亮点

- 本地化部署与隐私安全:不怕隐私数据被曝光了,还不花钱

- 硬件优化与性能:量化做的好,4G 显卡也能跑 7b/14b 的 deepseek

- 全平台兼容与开发友好:易用性强,api 也丰富,

- 产品化程度高:ollama+open web-ui 非常成熟,很容易部署,而 lobechat 这类开源部署组件依赖多,折腾半天都起不来

快速上手

🐣 萌新急救包

ollama

# windows/mac到官网下载安装包

https://ollama.com/download

# linux本地安装

curl -fsSL https://ollama.com/install.sh | sh

open-webui

version: '3.9'

services:

ollama-webui:

image: ghcr.io/open-webui/open-webui:main

container_name: ollama-webui

restart: always

ports:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2450

2450

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?