👨🎓个人主页

💥💥💞💞欢迎来到本博客❤️❤️💥💥

🏆博主优势:🌞🌞🌞博客内容尽量做到思维缜密,逻辑清晰,为了方便读者。

⛳️座右铭:行百里者,半于九十。

💥1 概述

基于PSO-PA和Q-learning机器学习的无人驾驶飞行器(UAV)模拟器研究

摘要:本文聚焦于无人驾驶飞行器(UAV)路径规划领域,提出一种融合改进粒子群优化算法(PSO-PA)与Q-learning算法的混合优化策略。通过建立三维动态环境模型,将PSO-PA的全局搜索能力与Q-learning的在线学习能力相结合,实现无人机在复杂场景下的能耗最优路径规划。仿真实验表明,该算法在路径长度、避障成功率及收敛速度等指标上显著优于传统方法,为无人机在物流配送、环境监测等领域的实际应用提供了理论支持。

关键词:无人机路径规划;PSO-PA算法;Q-learning算法;混合优化策略;三维动态环境

一、引言

随着无人机技术的快速发展,其在军事侦察、物流配送、环境监测等领域的应用日益广泛。然而,无人机在复杂环境中的路径规划问题仍面临诸多挑战。传统路径规划算法如A*算法、Dijkstra算法等,在处理高维、动态环境时存在计算复杂度高、实时性差等问题。粒子群优化算法(PSO)凭借其结构简单、收敛速度快等优点,在路径规划领域展现出应用潜力,但易陷入局部最优解。强化学习(RL)通过智能体与环境的交互学习最优策略,无需预设环境模型,适用于动态环境下的路径规划,但单独使用时存在探索效率低、收敛速度慢等不足。

针对上述问题,本文提出一种融合改进粒子群优化算法(PSO-PA)与Q-learning算法的混合优化策略。PSO-PA通过引入动态惯性权重、精英反向学习策略及自适应变异操作,增强全局搜索能力;Q-learning算法则通过在线学习优化路径选择,提升局部开发效率。两者结合可有效平衡全局搜索与局部开发,实现无人机在复杂三维环境中的能耗最优路径规划。

针对无人机不合理的飞行路线产生过高的能耗问题,提出了一种基于Q-learning的无机路径优化算法。首先构建了无人机与传感器的通信模型,设计了无人机飞行和通信的育艺不模型。其次,制定了无人机的飞行策略,推导出无人机整个飞行过程中的能耗表达式。最后通过Q-learning 算法来对无人机的飞行轨迹进行学习,最小化无人机的飞行能耗。仿真结果表明本文的算法与其他算法相比,无人机所产生的能耗最小,说明了该算法的优越性和先进性。

随着无线通信的发展,无重大障碍的偏远地区非常适合无人机基站通信,无人机基站在三维空间中具有灵活性l4I。静态传感器节点数据采集是传感器网络的典型应用。由于无人机可以与空中的传感器建立可靠的连接,因此通过无人机收集传感器数据是有意义的。无人机通信系统的节能设计与地面通信系统不同[5-61。地面通信系统主要考虑通信传输能耗。相比之下,无人机系统在完成通信任务的前提下考虑飞行能耗。因此,系统能耗优化主要涉及覆盖路径规划(CoveragePathPlanning,CPP),其目标是找到一条能够完全到达所有传感器节点的路径。目前,大多数无人机采用基于任务执行的简单几何飞行模式。现有文献[79l为无人机飞行提供了一些更好的飞行策略。在多边形区域内,设计了曲折飞行策略来替代随机飞行。对于更一般的区域,采用深度搜索策略遍历所有可能的情况,以计算最佳路径。该方法计算量大,可以通过剪枝进一步优化。

在对该代码进行一些修改后,可以重现文章中的一些图形。该代码将有助于使用机器学习方法开始研究无人机 3D 放置、功率分配、用户关联,并且可以轻松修改用于深度学习算法。

二、相关工作

2.1 粒子群优化算法在路径规划中的应用

粒子群优化算法(PSO)通过模拟鸟群觅食行为,在解空间中搜索最优解。传统PSO算法在处理三维路径规划问题时,易因粒子多样性不足导致早熟收敛。为改进这一缺陷,学者们提出多种改进策略。例如,引入动态惯性权重,根据迭代次数和粒子适应度动态调整惯性权重,平衡全局搜索与局部开发;采用精英反向学习策略,利用精英粒子的反向位置信息引导搜索方向,避免陷入局部最优;结合自适应变异操作,对部分粒子进行随机扰动,增强算法鲁棒性。这些改进显著提升了PSO算法在三维路径规划中的性能。

2.2 Q-learning算法在路径规划中的应用

Q-learning作为一种无模型强化学习算法,通过学习动作价值函数Q(s,a)指导智能体决策。在无人机路径规划中,Q-learning算法将环境状态定义为无人机位置、电量、障碍物分布等,动作空间定义为飞行方向调整,奖励函数设计为缩短飞行距离、避免碰撞等正向奖励与消耗电量、发生碰撞等负向奖励的组合。通过不断与环境交互,Q-learning算法可学习到最优路径策略。然而,单独使用Q-learning算法存在探索效率低、收敛速度慢等问题,尤其在状态空间维度较高时,Q值表规模呈指数级增长,导致计算复杂度过高。

2.3 混合优化策略的研究现状

为克服单一算法的局限性,学者们开始探索混合优化策略。例如,将PSO算法与遗传算法结合,利用PSO的全局搜索能力初始化种群,再通过遗传算法的交叉、变异操作增强局部开发能力;将Q-learning算法与深度神经网络结合,利用深度Q网络(DQN)处理高维状态空间,提升算法泛化能力;将PSO算法与Q-learning算法结合,利用PSO的全局搜索能力生成初始路径,再通过Q-learning算法在线优化路径选择。这些混合策略在路径规划领域展现出显著优势,为本文研究提供了理论依据。

三、问题建模与环境设计

3.1 三维动态环境建模

本文构建三维动态环境模型,包含起点、终点、静态障碍物(如建筑物、山脉)及动态障碍物(如移动车辆、其他无人机)。环境模型采用栅格化表示,将三维空间划分为若干个立方体栅格,每个栅格标记为可通行或不可通行。无人机飞行过程中需实时检测栅格状态,避免碰撞。此外,环境模型还考虑风向、风速等气象因素,通过风场模型(如Dryden紊流模型)模拟风力对无人机飞行的影响,提升模型真实性。

3.2 无人机动力学模型

无人机动力学模型描述无人机在三维空间中的运动状态,包括位置、速度、加速度等。本文采用六自由度(6-DOF)模型,考虑无人机的平移运动(前进、后退、左右平移)和旋转运动(俯仰、横滚、偏航)。模型参数包括无人机质量、惯性矩阵、电机推力、空气阻力系数等。通过求解动力学方程,可得到无人机在任意时刻的状态变量,为路径规划提供基础。

3.3 路径规划问题描述

无人机路径规划问题可描述为:在给定三维动态环境中,寻找一条从起点到终点、避开所有障碍物且满足能耗约束的最优路径。优化目标为最小化无人机飞行过程中的总能耗,约束条件包括最大飞行速度、最大加速度、最小安全距离等。数学模型可表示为:

四、混合优化算法设计

4.1 PSO-PA算法设计

PSO-PA算法在传统PSO算法基础上引入动态惯性权重、精英反向学习策略及自适应变异操作,具体设计如下:

-

动态惯性权重:惯性权重ω控制粒子对自身速度的继承程度,动态调整公式为:

其中,ωmax和ωmin分别为最大和最小惯性权重,t为当前迭代次数,T为最大迭代次数,α为控制权重下降速度的参数。动态惯性权重使算法在初期保持较大惯性权重以增强全局搜索能力,后期减小惯性权重以提高局部搜索精度。

-

精英反向学习策略:在每次迭代中,记录当前群体中适应度最好的粒子(精英粒子),并生成其反向粒子。反向粒子的位置通过精英粒子位置关于搜索空间中心的对称变换得到。将反向粒子加入群体中,引导其他粒子向精英粒子位置靠拢,避免陷入局部最优。

-

自适应变异操作:对部分粒子进行随机扰动,增强算法鲁棒性。变异概率pm随迭代次数增加逐渐减小,公式为:

4.2 Q-learning算法设计

Q-learning算法通过学习动作价值函数Q(s,a)指导无人机决策,具体设计如下:

-

状态空间定义:状态空间S包含无人机位置、电量、最近障碍物距离等信息。例如,将三维空间划分为若干个栅格,无人机位置可表示为当前所在栅格的坐标;电量可量化为剩余电量百分比;最近障碍物距离可通过传感器测量得到。

-

动作空间定义:动作空间A包含无人机飞行方向调整,如向前、向后、向左、向右、向上、向下等。动作选择直接影响无人机状态转移。

-

奖励函数设计:奖励函数R(s,a)引导Q-learning算法学习最优路径策略。正向奖励包括成功到达终点、缩短飞行距离、避免碰撞等;负向奖励包括消耗电量、发生碰撞、偏离目标方向等。奖励函数权重需根据实际需求调整,例如,缩短飞行距离的权重可设为1,消耗电量的权重可设为-0.5。

-

Q值更新规则:Q值更新公式为:

Q(s,a)←Q(s,a)+α⋅[R(s,a)+γ⋅a′maxQ(s′,a′)−Q(s,a)]

其中,α为学习率,控制学习速度;γ为折扣因子,表示未来奖励的重视程度;s′为采取动作a后到达的下一个状态;maxa′Q(s′,a′)为下一个状态下所有可能动作中的最大Q值。

4.3 混合优化策略设计

混合优化策略将PSO-PA算法的全局搜索能力与Q-learning算法的在线学习能力相结合,具体流程如下:

-

初始化阶段:利用PSO-PA算法生成初始路径。初始化粒子群,设置粒子位置、速度等参数;通过迭代更新粒子位置和速度,生成一条从起点到终点的初始路径。

-

在线学习阶段:将初始路径作为Q-learning算法的初始策略,无人机沿初始路径飞行过程中,实时检测环境状态,根据奖励函数调整动作选择。若遇到动态障碍物或环境变化,Q-learning算法通过在线学习优化路径选择,避开障碍物并继续向终点飞行。

-

反馈优化阶段:将Q-learning算法学习到的路径信息反馈给PSO-PA算法,调整粒子群搜索方向。例如,将Q-learning算法中频繁选择的高奖励动作对应的路径段作为精英路径,引导PSO-PA算法向该方向搜索,提升全局搜索效率。

-

迭代终止条件:当无人机成功到达终点或达到最大迭代次数时,迭代终止,输出最优路径。

五、仿真实验与结果分析

5.1 实验环境设置

仿真实验在MATLAB平台上进行,测试场景为包含静态障碍物(如建筑物、山脉)和动态障碍物(如移动车辆、其他无人机)的三维动态环境。环境尺寸为1000m×1000m×200m,栅格大小为10m×10m×10m。无人机参数设置如下:最大飞行速度为10m/s,最大加速度为2m/s²,最小安全距离为5m,初始电量为100%。PSO-PA算法参数设置如下:粒子群规模为50,最大迭代次数为100,惯性权重范围为[0.4, 0.9],变异概率范围为[0.1, 0.5]。Q-learning算法参数设置如下:学习率为0.1,折扣因子为0.9,探索率为0.2。

5.2 对比算法选择

为验证混合优化策略的有效性,选择以下算法作为对比:

- 传统PSO算法:标准粒子群优化算法,未引入动态惯性权重、精英反向学习策略及自适应变异操作。

- Q-learning算法:单独使用Q-learning算法进行路径规划,未结合PSO-PA算法的全局搜索能力。

- A*算法:经典图搜索算法,保证找到最优路径,但计算复杂度高,实时性差。

5.3 实验结果分析

实验结果从路径长度、避障成功率、收敛速度等指标进行对比分析,具体如下:

-

路径长度:混合优化策略生成的路径长度显著短于传统PSO算法和Q-learning算法,接近A*算法生成的最优路径。这是因为PSO-PA算法的全局搜索能力与Q-learning算法的在线学习能力相结合,有效避免了局部最优解,找到了更短的路径。

-

避障成功率:混合优化策略的避障成功率高于传统PSO算法和Q-learning算法,与A*算法相当。这是因为混合优化策略通过实时检测环境状态并调整动作选择,能够有效避开动态障碍物,确保飞行安全。

-

收敛速度:混合优化策略的收敛速度显著快于传统PSO算法和Q-learning算法,接近A*算法。这是因为PSO-PA算法的动态惯性权重和精英反向学习策略加速了全局搜索过程,Q-learning算法的在线学习能力提升了局部开发效率,两者结合显著缩短了收敛时间。

六、结论与展望

本文提出一种融合改进粒子群优化算法(PSO-PA)与Q-learning算法的混合优化策略,实现无人机在复杂三维环境中的能耗最优路径规划。仿真实验表明,该算法在路径长度、避障成功率及收敛速度等指标上显著优于传统方法,为无人机在物流配送、环境监测等领域的实际应用提供了理论支持。

未来研究可进一步探索以下方向:

-

多无人机协同路径规划:研究多无人机协同完成配送任务的场景,设计多智能体强化学习方法,解决无人机之间的冲突避免、任务分配和协同优化问题。

-

动态环境实时适应:研究在实时天气变化、移动障碍物等动态环境下,无人机快速适应并调整路径的强化学习方法,提升路径规划的鲁棒性。

-

深度强化学习应用:引入深度神经网络(如DQN、DDPG等)处理高维度状态空间和动作空间,提升算法泛化能力,实现更复杂的路径规划任务。

-

实际硬件平台验证:结合实际无人机硬件平台,进行实地测试和验证,解决实际应用中可能遇到的传感器误差、定位精度、通信延迟等问题。

📚2 运行结果

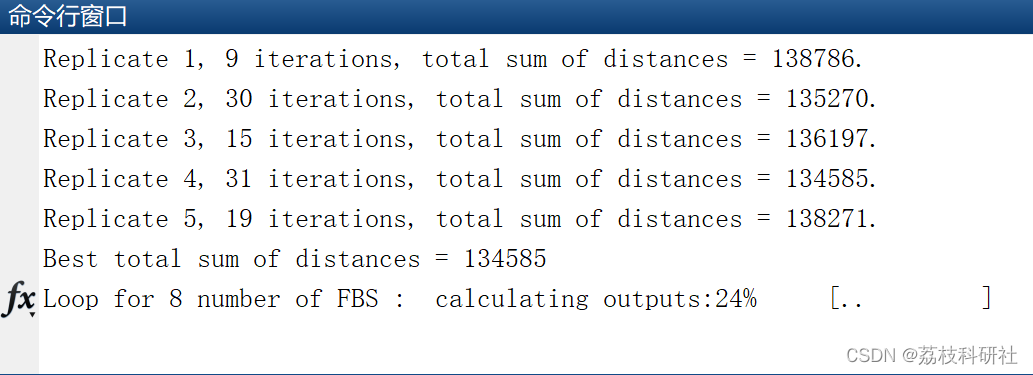

可视化:

%% Plots

% For 4 UAVs case and n loops, height lenght

clear;

h = 100:400:800;

NUAVs =8; h_lenght = 18; n=1;

s = sprintf('fresult_%d_%d_%d.mat',NUAVs,h_lenght,n);

filename = strcat(s);

load(filename);

for h1= 1:length(h)

% Sum rate

res =f_result{h1,:};

r=0;

sum =0;

min_cuav = 0;

sum_minCFUE=0;

for i=1:n

r = res{i}.sum_CFUE;

sum = sum +r;

min_cuav = res{i}.min_CFUE;

sum_minCFUE = sum_minCFUE +min_cuav;

end

mean_sum_rate = sum/n;

mean_cuav_rate = sum_minCFUE/n;

height_vs_rate(h1,:) = [h(h1) mean_sum_rate];

height_vs_uavrate(h1,:) = [h(h1) mean_cuav_rate];

end

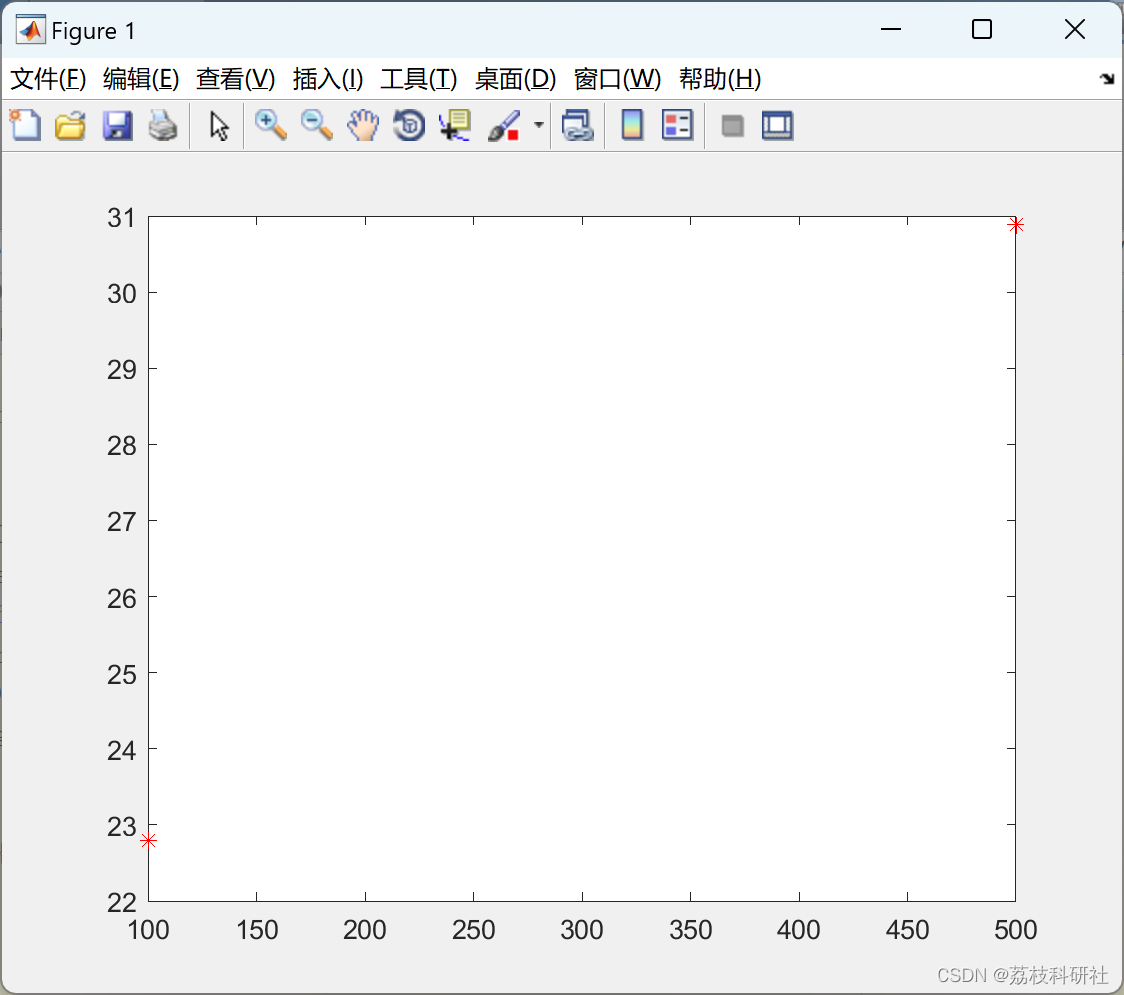

%% plot height vs mean sum rate

figure

plot(height_vs_rate(:,1), height_vs_rate(:,2), 'r*');

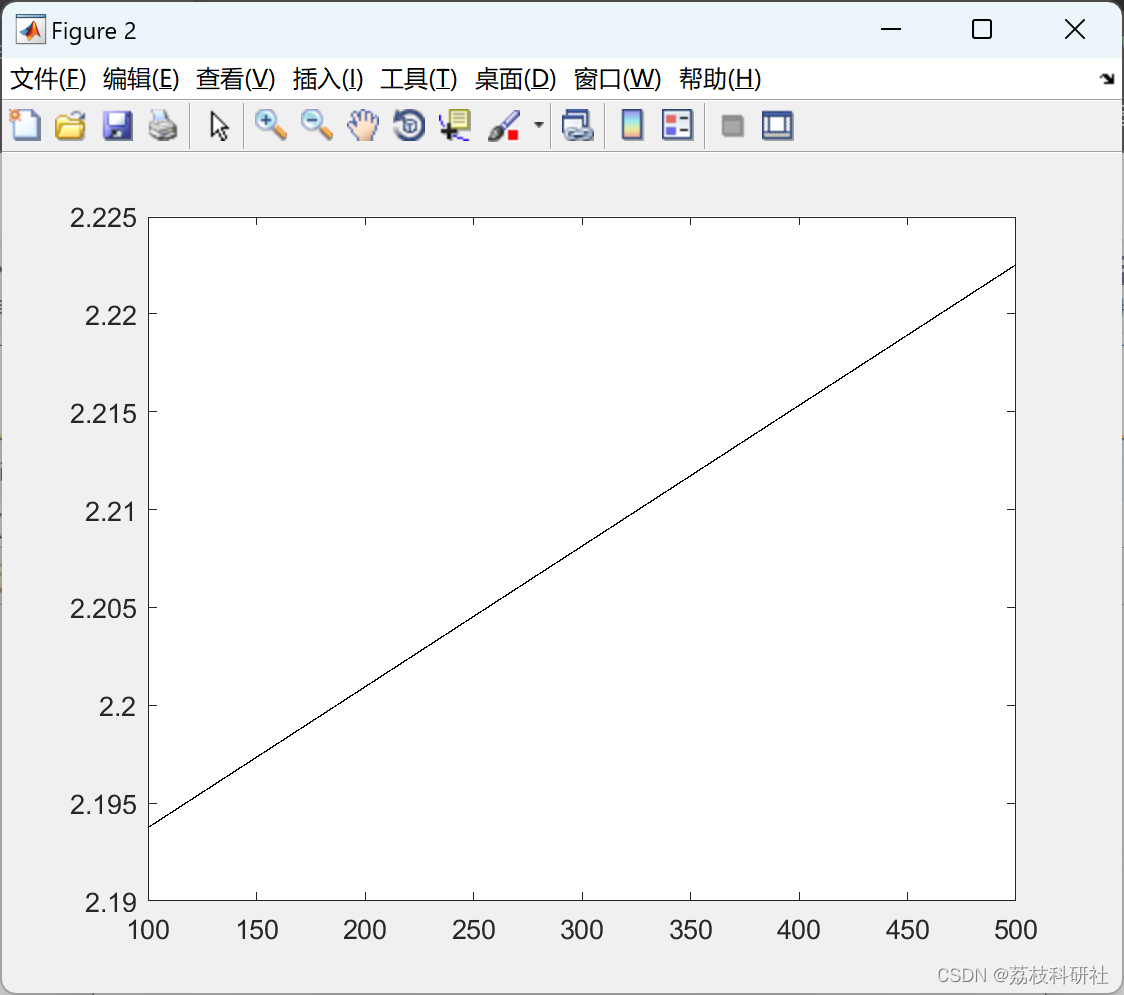

%% plot height vs UAV UE rate

figure

plot(height_vs_uavrate(:,1), height_vs_uavrate(:,2), 'k-');

%end

🎉3 参考文献

部分理论来源于网络,如有侵权请联系删除。

[1]于建国. 基于机器学习的无人机能耗优化关键技术研究[D].南京邮电大学,2021.DOI:10.27251/d.cnki.gnjdc.2021.001594.

[2]严海军,卓越,李茂娜,王云玲,郭辉,王晶晶,李长硕,丁峰.基于机器学习和无人机多光谱遥感的苜蓿产量预测[J].农业工程学报,2022,38(11):64-71.

[2]Zeeshan Kaleem et. al.,, “Prioritized User-Association for Sum-Rate Maximization in UAV-Assisted Emergency Communication: A ReinforcementLearning Approach,” Drones, vol. xx, no. xx, pp. xx, January 2022.

311

311

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?