1,Second Me 介绍

地址:Second Me

我的损失:随着人工智能获得力量,我们失去了意义

我们真正相信什么?像许多人一样,我们看到了通用人工智能(AGI)的巨大潜力。然而,有一个缺口——一个“缺失的部分”——让我们感到不安。担忧是真实的:随着通常被称为“上帝模型”的AGI的出现,我们有可能失去自己的身份,沦为超级智能力量控制下的棋子。

随着人工智能的进步,我们的个性面临风险:

•我们的数据掌握在企业手中,为科技巨头训练人工智能,而不是我们自己

•我们的经验和见解失去了相关性,取而代之的是标准化的人工智能反应

•我们的意志和价值观受到威胁,因为人工智能预测而不是代表我们真实的决定

我们成为人工智能未来的旁观者,而不是所有者。这是我们将屈服于创造的未来吗?

我们创造第二个我:代表而不是取代我的人工智能自我

-

这就是我们开创第二个我的原因:第一个开源人工智能身份系统,提供100%私人的、高度个性化的人工智能代理,专门为代表你真实的自我而构建。它不仅仅是学习你的偏好——它理解你独特的思维模式,在不同的环境中代表你,与其他第二个我形成协作网络,并在新兴的代理经济中创造新的价值。

我们的使命很明确:保护你独特的身份——你的“我”——同时给你一种在人工智能时代存在和表达自己的强大新方式。 -

第二个我如何更好地了解你?

HMM(分层记忆建模):我们首创了AI记忆,从短期交互记忆(即时上下文)到长期个性化认知记忆,采用三层(L0-L2)分层结构。这让您的AI自我能够快速识别模式,适应,并与您一起进化。

Me对齐(个性化对齐架构):基于尖端的强化学习技术,Me对齐将您分散的数据转化为深入的个性化理解。Me对齐优于市场领先的检索-增强生成GraphRag(1.0.1),在用户理解方面提高了37%,确保AI真正掌握您独特的偏好、行为模式和决策习惯。 -

为什么第二个我真的是你的人工智能?

100%隐私:第二个我可以在本地运行,因此您可以完全控制您的个人数据,只有在您明确许可的情况下才能共享。与此同时,人工智能实体形成了一个去中心化的网络——每个独立但相互访问。通信发生在点对点,让您牢牢掌握自己的信息。

SMP(第二个我协议):一个去中心化的人工智能框架,使独立的人工智能实体能够交互、学习和发展。与传统的人工智能模型不同,每个“自我”都保持完全独立,同时在点对点网络中安全地与他人通信——培育一个动态的、相互关联的知识网络,确保人工智能真正掌握你独特的偏好、行为模式和决策习惯。

我们创造第二个我:你的身份、网络和经济

1.创建第二个我的系统

我们开发了一个平台,您可以将您的精华上传到智能实体中,并将其部署在您信任的环境中,例如您的个人笔记本电脑,由我们开发的人工智能原生内存技术提供支持。把它想象成您的个人OpenAI——不是提供像GPT-4这样的通用模型,而是反映您的身份、经历、偏好和想法的定制智能。

•创建您的种子身份作为基础

•上传您的记忆和经历

•训练您的AI模型以了解是什么让您成为独一无二的您

2.第二个Mes的角色扮演框架

我们人类自然会在各种情况下呈现不同版本的自己——工作中专业,与朋友随意,学习时专注。 第二个我通过角色扮演框架拥抱这种自然的多样性,让你的人工智能自我根据情况进行适应,同时始终保持你真实的核心身份。

今天的人工智能无法理解这一点——他们版本的“你”是单一的,要么记住一切,要么根本不认识你。第二个我了解你身份的全谱,在上下文之间无缝过渡,同时保持你真实的核心自我。这使得你的数字存在与现实世界的自我一样微妙和多方面。

3.分散的第二个Mes网络

当前的人工智能范式在少数集中式系统中垄断了数据和决策。第二个我打破了这种模式,创建了一个真正分散的网络,每个人工智能代表一个真实的个人的价值观和利益。一旦你部署了你的第二个我,它就加入了一个相互关联的人工智能网络——每个人工智能都代表真实的个人。这些第二个我进行通信、协作和创造价值,无论是相互交互、其他代理还是人。事实上,它类似于20世纪90年代早期的互联网,但为人工智能重新构想。

4.未来第二个Mes应用平台

展望未来,我们正在为一个充满第二个我的世界设想一种新型应用程序。今天的应用程序是为人类设计的,功能围绕人类直觉组织。虽然人工智能代理可以在这些平台上运行,但它们需要一个新的基础来释放其全部潜力。

明天的应用程序将为您的第二个我设计使用——在您保持控制的同时寻找机会并提供价值。您的第二个我可以自主导航数字世界、做出决策并建立联系,同时节省您的时间和精力。想象一个第二个我LinkedIn,您的第二个我可以毫不费力地持续寻找适合您目标的完美工作机会。

2,安装过程

2.1,首先安装docker

安装方法参照:Ubuntu 20.04 安装Docker 全过程-优快云博客

2.2,克隆存储库

git clone git@github.com:Mindverse/Second-Me.git

cd Second-Me2.3,启动容器

make docker-up2.3.1,若可以顺利编译完成则忽略本节下面修改

2.3.1.1,修改Dockerfile.frontend

$ vim Dockerfile.frontend修改下列两行:

FROM registry.cn-hangzhou.aliyuncs.com/tmp2025/node:23

RUN npm config set registry https://registry.npmmirror.com && npm install完整文档:

$ cat Dockerfile.frontend

FROM registry.cn-hangzhou.aliyuncs.com/tmp2025/node:23

# Set working directory

WORKDIR /app

# Copy frontend package files

COPY lpm_frontend/package.json lpm_frontend/package-lock.json* /app/

# Install dependencies

RUN npm config set registry https://registry.npmmirror.com && npm install

# Copy frontend code

COPY lpm_frontend/ /app/

# Set environment variable for backend URL (can be overridden in docker-compose)

ENV DOCKER_API_BASE_URL=http://backend:8002

# Create logs directory

RUN mkdir -p /app/logs

# Expose frontend port

EXPOSE 3000

# Start frontend service

CMD ["npm", "run", "dev"]

2.3.1.2,修改Dockerfile.backend

$ vim Dockerfile.backend修改系列几行:

FROM registry.cn-hangzhou.aliyuncs.com/tmp2025/python:3.12

RUN sed -i 's@deb.debian.org@mirrors.ustc.edu.cn@g' /etc/apt/sources.list.d/debian.sources \

&& pip install -i https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple --upgrade pip \

RUN poetry source add --priority=primary mirrors https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple/ 完整文档:

$ cat Dockerfile.backend

FROM registry.cn-hangzhou.aliyuncs.com/tmp2025/python:3.12

# Set working directory

WORKDIR /app

# Install system dependencies, Poetry and configure it

RUN sed -i 's@deb.debian.org@mirrors.ustc.edu.cn@g' /etc/apt/sources.list.d/debian.sources \

&& apt-get update && apt-get install -y \

build-essential cmake git curl wget lsof vim unzip sqlite3 \

&& apt-get clean \

&& rm -rf /var/lib/apt/lists/* \

&& pip install -i https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple --upgrade pip \

&& pip config set global.index-url https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple \

&& pip install poetry \

&& poetry config virtualenvs.create false

# Create directories

RUN mkdir -p /app/dependencies /app/data/sqlite /app/data/chroma_db /app/logs /app/run /app/resources

# Copy dependency files - Files that rarely change

COPY dependencies/graphrag-1.2.1.dev27.tar.gz /app/dependencies/

COPY dependencies/llama.cpp.zip /app/dependencies/

# Build llama.cpp

RUN LLAMA_LOCAL_ZIP="dependencies/llama.cpp.zip" \

&& echo "Using local llama.cpp archive..." \

&& unzip -q "$LLAMA_LOCAL_ZIP" \

&& cd llama.cpp \

&& mkdir -p build && cd build \

&& cmake .. \

&& cmake --build . --config Release \

&& if [ ! -f "bin/llama-server" ]; then \

echo "Build failed: llama-server executable not found" && exit 1; \

else \

echo "Successfully built llama-server"; \

fi

#

# Copy project configuration - Files that occasionally change

COPY pyproject.toml README.md /app/

RUN poetry source add --priority=primary mirrors https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple/

RUN poetry install --no-interaction --no-root

RUN pip install --force-reinstall dependencies/graphrag-1.2.1.dev27.tar.gz

# Copy source code - Files that frequently change

COPY docker/ /app/docker/

COPY lpm_kernel/ /app/lpm_kernel/

# Check module import

RUN python -c "import lpm_kernel; print('Module import check passed')"

# Set environment variables

ENV PYTHONUNBUFFERED=1 \

PYTHONPATH=/app \

BASE_DIR=/app/data \

LOCAL_LOG_DIR=/app/logs \

RUN_DIR=/app/run \

RESOURCES_DIR=/app/resources \

APP_ROOT=/app \

FLASK_APP=lpm_kernel.app

# Expose ports

EXPOSE 8002 8080

# Set the startup command

CMD ["bash", "-c", "echo \"Checking SQLite database...\" && if [ ! -s /app/data/sqlite/lpm.db ]; then echo \"SQLite database not found or empty, initializing...\" && mkdir -p /app/data/sqlite && sqlite3 /app/data/sqlite/lpm.db \".read /app/docker/sqlite/init.sql\" && echo \"SQLite database initialized successfully\" && echo \"Tables created:\" && sqlite3 /app/data/sqlite/lpm.db \".tables\"; else echo \"SQLite database already exists, skipping initialization\"; fi && echo \"Checking ChromaDB...\" && if [ ! -d /app/data/chroma_db/documents ] || [ ! -d /app/data/chroma_db/document_chunks ]; then echo \"ChromaDB collections not found, initializing...\" && python /app/docker/app/init_chroma.py && echo \"ChromaDB initialized successfully\"; else echo \"ChromaDB already exists, skipping initialization\"; fi && echo \"Starting application at $(date)\" >> /app/logs/backend.log && cd /app && python -m flask run --host=0.0.0.0 --port=${LOCAL_APP_PORT:-8002} >> /app/logs/backend.log 2>&1"]

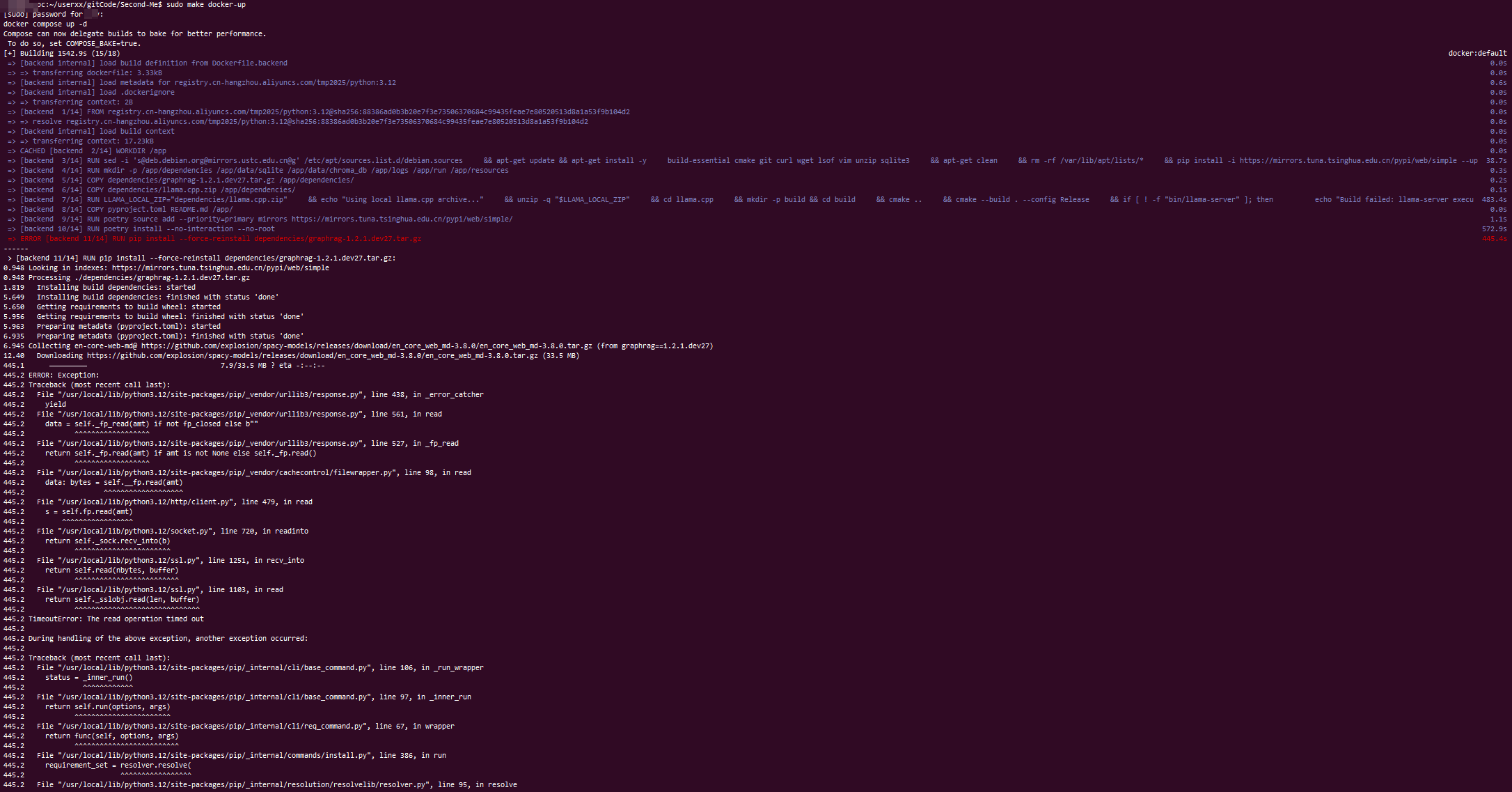

2.3.2,编译

sudo make docker-up 可能出现下列报错:

445.2 for chunk in response.raw.stream(

445.2 ^^^^^^^^^^^^^^^^^^^^

445.2 File "/usr/local/lib/python3.12/site-packages/pip/_vendor/urllib3/response.py", line 622, in stream

445.2 data = self.read(amt=amt, decode_content=decode_content)

445.2 ^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^

445.2 File "/usr/local/lib/python3.12/site-packages/pip/_vendor/urllib3/response.py", line 560, in read

445.2 with self._error_catcher():

445.2 ^^^^^^^^^^^^^^^^^^^^^

445.2 File "/usr/local/lib/python3.12/contextlib.py", line 158, in __exit__

445.2 self.gen.throw(value)

445.2 File "/usr/local/lib/python3.12/site-packages/pip/_vendor/urllib3/response.py", line 443, in _error_catcher

445.2 raise ReadTimeoutError(self._pool, None, "Read timed out.")

445.2 pip._vendor.urllib3.exceptions.ReadTimeoutError: HTTPSConnectionPool(host='objects.githubusercontent.com', port=443): Read timed out.

------

failed to solve: process "/bin/sh -c pip install --force-reinstall dependencies/graphrag-1.2.1.dev27.tar.gz" did not complete successfully: exit code: 2

make: *** [Makefile:162: docker-up] Error 1

详细如下:

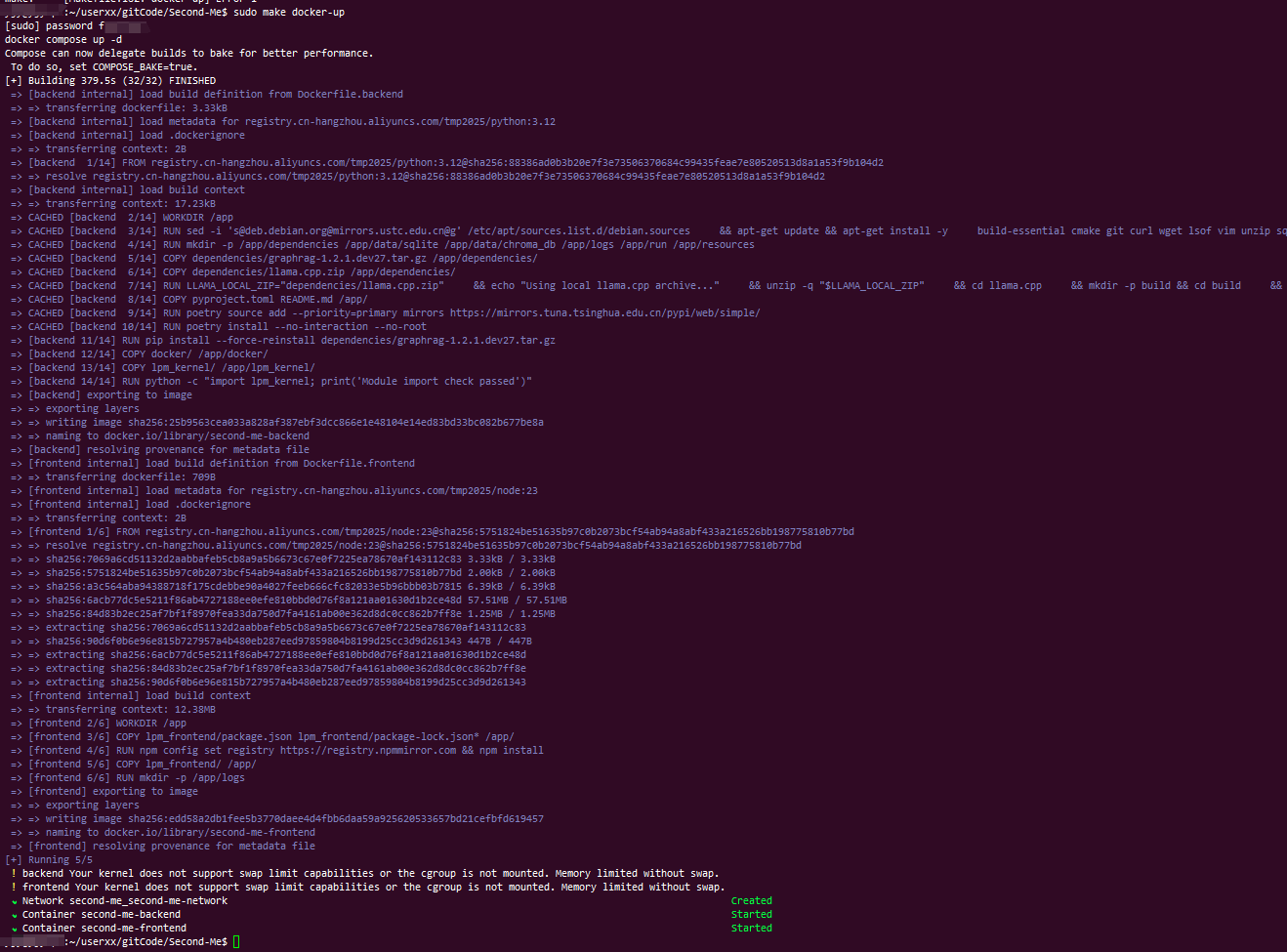

出现上述问题,检查2.3.1 是否正确,如果正确,则再次执行sudo make docker-up (本人执行第三次成功)

正常结果应为:

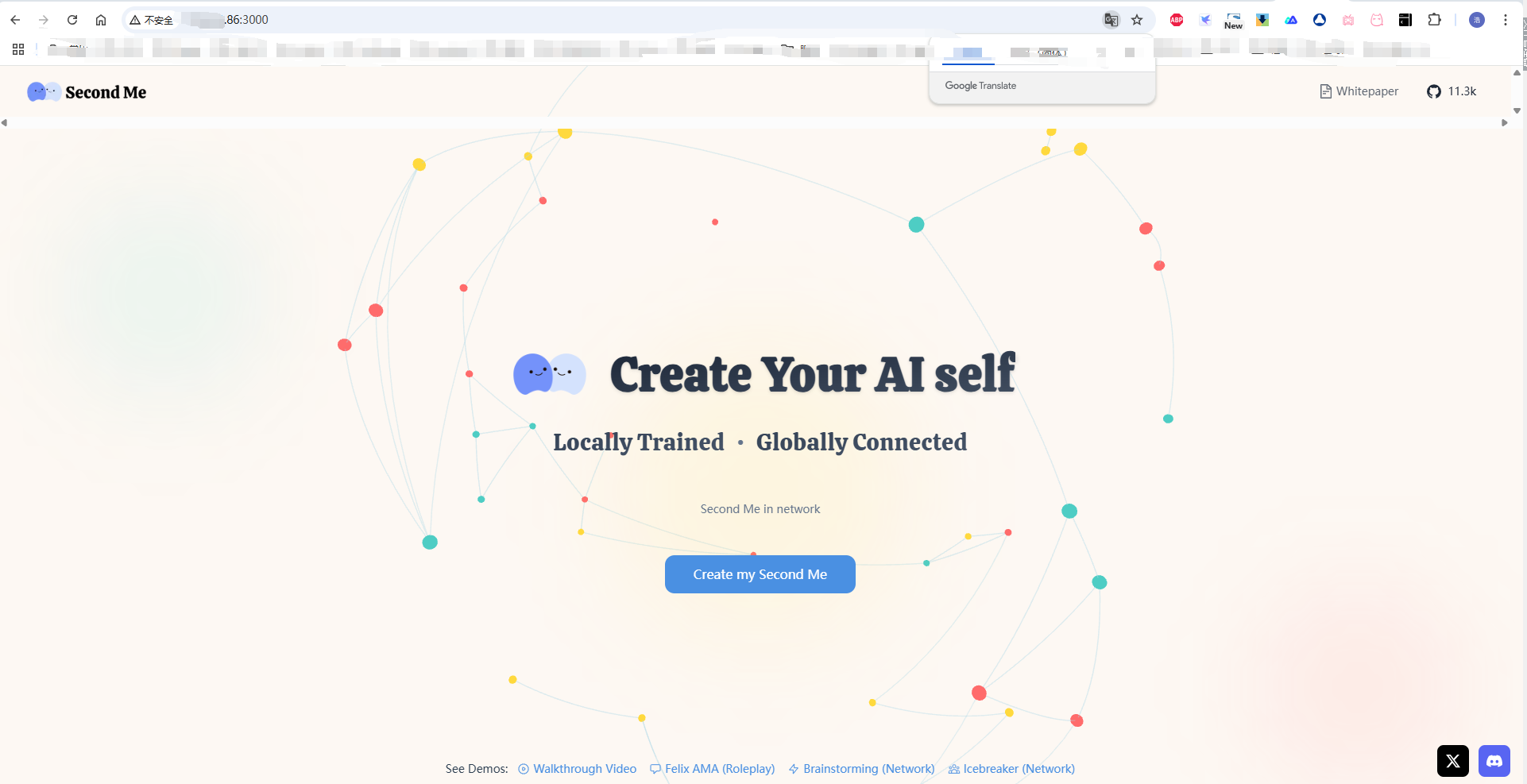

2.4,启动服务后(使用本地安装程序或Docker),打开浏览器并访问:

http://localhost:3000在相同局域网下可以使用安装设备地址:

2.5,查看帮助和更多命令

make help2.6,自定义Ollama

自定义Ollama模型配置请参考:自定义模型配置(Ollama)

1483

1483

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?