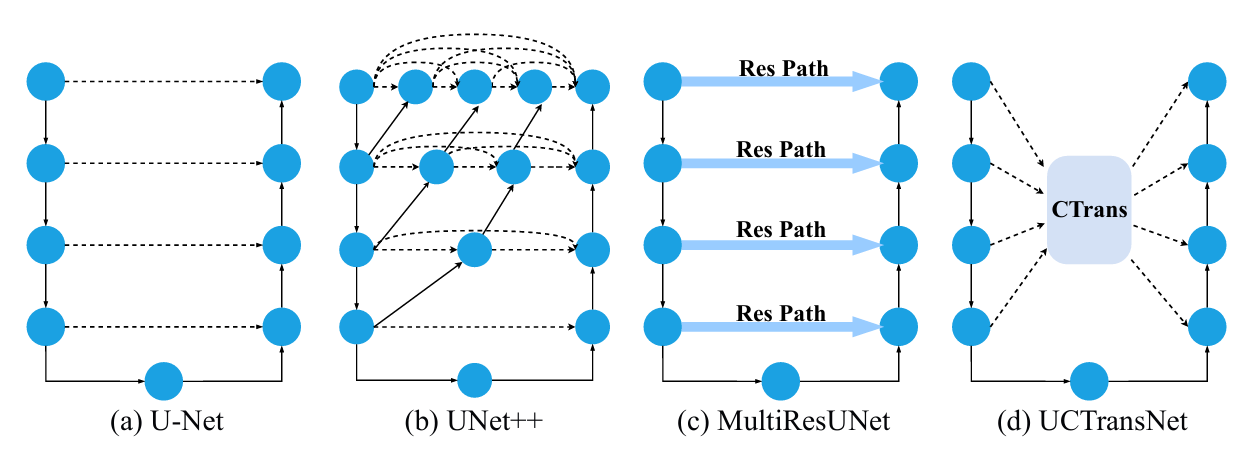

UCTransNet: Rethinking the Skip Connections in U-Net from a Channel-wise Perspective with Transformer

AAAI 2022

论文:https://arxiv.org/abs/2109.04335

代码:https://github.com/mcgregorwwww/uctransnet

U-Net 原始跳跃连接存在的核心问题:

- 并非所有跳跃连接都有效,部分跳跃连接因编码器与解码器特征集不兼容(存在语义差距),反而会降低分割性能;

- 在某些数据集上,完全去除跳跃连接的 U-Net 性能优于原始 U-Net;

- 跳跃连接的最优组合因数据集(目标病变的尺度和外观)而异,简单的 “复制 - 拼接” 模式不适用。

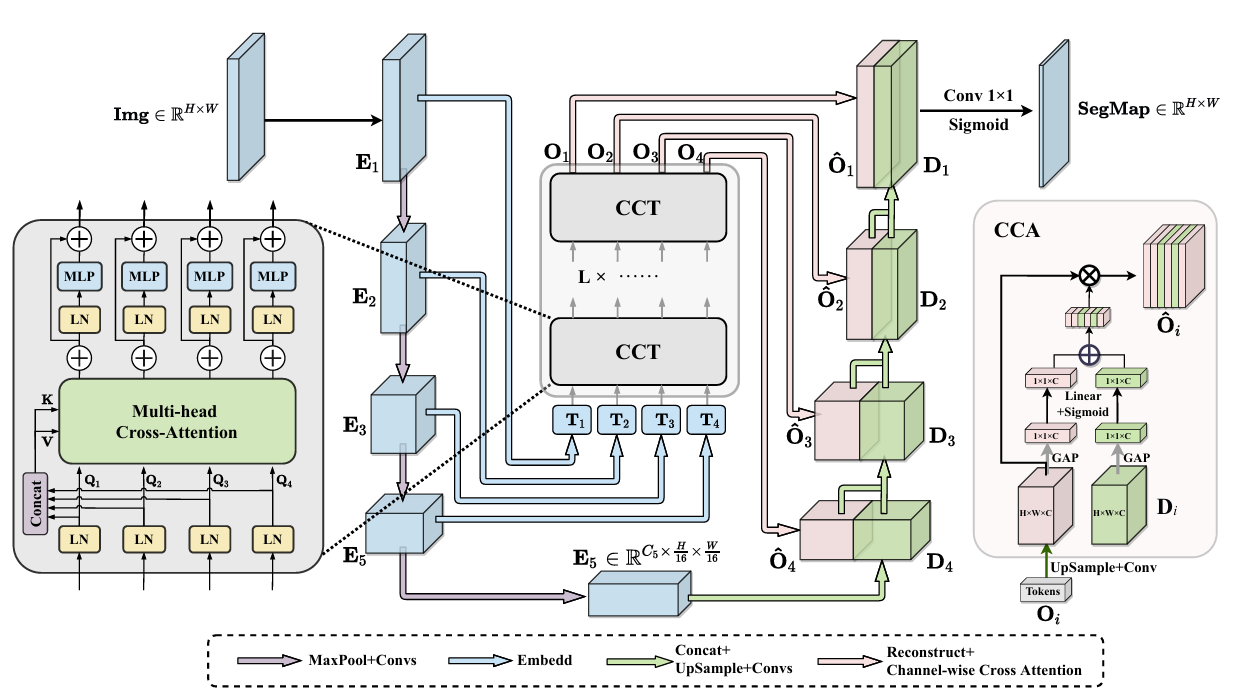

CTrans(Channel Transformer)模块

本文设计了CTrans(Channel Transformer)模块,完全替代 U-Net 中原始的跳跃连接,其核心是通过通道角度的交叉注意力机制,桥接编码器与解码器的语义和分辨率差距,具体包括两个子模块:

CCT(Channel-wise Cross Fusion Transformer):

- 从通道维度出发,通过多头部通道交叉注意力融合多尺度编码器特征。它将不同尺度的编码器特征作为查询(Query),并将所有尺度特征的拼接作为键(Key)和值(Value),通过交叉注意力捕捉通道间的非局部语义依赖,自适应解决多尺度特征间的语义差距(而非独立连接各尺度特征)。

CCA(Channel-wise Cross Attention):

- 用于融合 CCT 输出的多尺度特征与解码器特征,通过全局平均池化提取通道级全局信息,生成注意力掩码,动态筛选关键通道信息,解决编码器(经 CCT 处理)与解码器特征间的语义层次不一致问题,消除特征融合的模糊性。

效果&总结

- 从通道角度融合 Transformer 与 U-Net,实现更高效的特征交互

- 现有结合 Transformer 与 U-Net 的方法(如 TransUNet、Swin-Unet)多将 Transformer 用于替换卷积层以捕捉空间长程依赖,而 UCTransNet 的创新在于:

- 聚焦通道维度而非空间维度,利用 Transformer 的交叉注意力机制处理通道间的依赖关系,避免了将 Transformer 用于空间特征提取带来的高计算成本;

- 实现了 U-Net 与 Transformer 的轻量化结合:CTrans 模块仅替代跳跃连接,保留 U-Net 主体结构,在降低计算量(参数和 FLOPs 优于 TransUNet、Swin-Unet 等)的同时,显著提升性能。

** 思考**

- 交叉注意力模块的K和V可以将多头的内容concat后计算,减少K和V的参数和计算量

- FFN层逐个对应多头的注意力结果,不共享参数,便于保持多头输入的差异性

- 绘图方面,图一的对比非常清晰,图二像水管电路的排布,如果把CCT模块横过来可能会更简洁一些

113

113

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?