Datawhale课程

课程:AI 研究基础,编译:Datawhale

向顶级专家学习人工智能的机会来了。

Google DeepMind 和伦敦大学学院(UCL)合作,共同推出了一个免费课程——“AI 研究基础”(AI Research Foundations)

这门课旨在帮助学习者深入理解 Transformer,并通过动手实践掌握现代语言模型的构建与微调方法,现已在 Google Skills 平台全面上线!

课程主页:https://www.skills.google/collections/deepmind

课程由Gemini 负责人亲自指导:

Oriol Vinyals:Google DeepMind 研究副总裁兼深度学习主管,Gemini 共同负责人。 他共同发明了 “seq2seq” 模型、主导 TensorFlow 的关键发展,还领导了 AlphaStar 项目击败《星际争霸 II》顶级玩家。 在人工智能研究社区中具有极高影响力,被视为深度学习与强化学习领域的重要领军人物。

AI研究基础课程简介

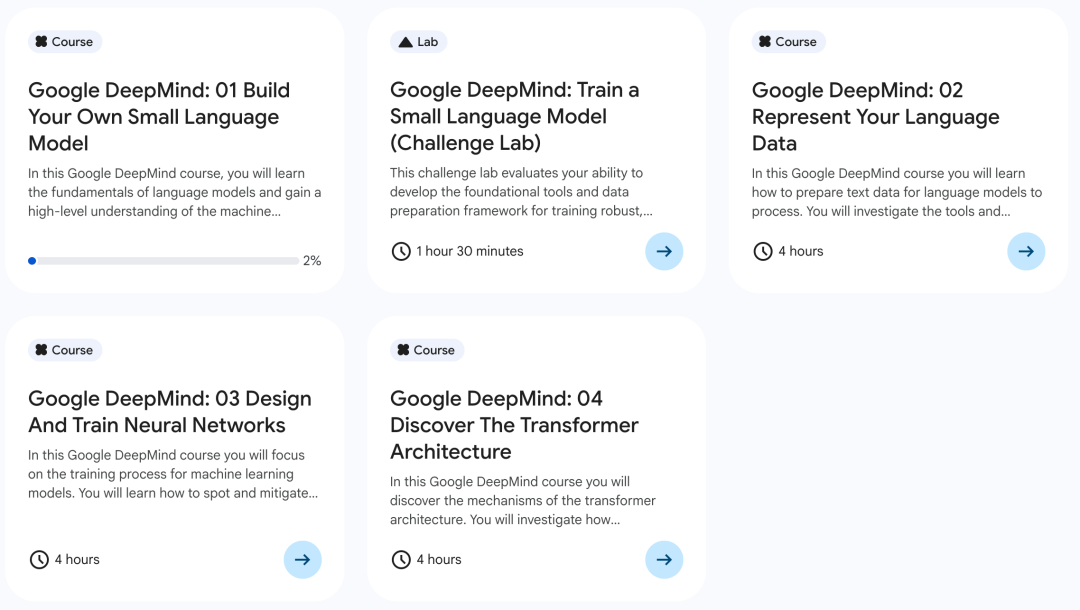

课程01:手把手教你构建小型语言模型

第一课专注于学习语言模型的基础知识,并全面了解机器学习的开发流程。

课程大纲如下:

语言模型基础——本模块介绍语言模型的核心概念,包括它们如何通过预测下一个词来工作,以及概率在建模语言模式中的基础作用。

传统与局限:N-gram 模型——学习 N-gram 模型的工作原理,并通过实际操作理解其在处理长距离依赖时的固有局限性。

现代架构:Transformer 模型内容——深入了解 Transformer 模型的结构,它是现代大型语言模型的基础,并将其与 N-gram 模型进行比较,理解其在理解语言上下文方面的优势。

模型训练与评估——学习完整的机器学习开发流程,从数据准备到实际训练一个小型语言模型(SLM),并掌握评估模型性能的方法。

课程02:表示你的语言数据

第二课专注于学习将文本数据转化为机器可理解格式所需的关键工具和技术,主要聚焦于分词(Tokenization)和嵌入(Embeddings)。

课程大纲如下:

数据处理流程——学习如何对原始文本数据进行预处理,使其适用于语言模型的输入。

分词技术——深入研究将文本分解为可管理单元(如字符、词、子词)的分词方法,并亲手实现 BPE (Byte-Pair Encoding) 分词器。

表示意义——掌握嵌入的概念,即如何将词语和文本转化为向量和矩阵,从而在数学空间中表示其含义和关系。

伦理与偏见——课程鼓励批判性思考数据准备中的决策,分析数据中可能引入的偏见,并教授使用“数据卡片”流程来设计合乎伦理、透明且负责任的数据集。

课程03:设计和训练神经网络

第三课专注于机器学习模型的训练过程,教授如何设计、实现和优化神经网络。

课程大纲如下:

神经网络训练机制——深入了解神经网络的训练机制和反向传播算法的原理。

实践与实现——通过实际编码实验,实现并评估多层感知器(MLP)用于简单的分类任务。

优化与故障排除——学习如何在模型训练过程中发现并解决常见问题,如过拟合(overfitting)和欠拟合(underfitting)。

——预测潜在风险、安全问题以及更深远的社会影响,培养负责任的创新意识。

课程04:探索 Transformer 架构

第四课深入探索现代大型语言模型(LLMs)的核心:Transformer 架构及其关键机制。

课程大纲如下:

Transformer 机制——揭示 Transformer 语言模型如何处理输入提示词来做出具有上下文感知能力的下一个词元预测。

注意力机制——重点研究 Transformer 的核心组件「注意力机制」。通过实践活动来可视化注意力权重,并学习蒙版注意力和多头注意力等进阶概念。

神经网络技术—— 学习构建适合用作语言模型的神经网络所需的其他必要技术。

一起“点赞”三连↓

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?