PCA原理

什么是主成分分析

如果一个数据集有1w个特征,针对研究目标,不可能分析每一个特征;有些特征间存在高度相关性,相关系数可能高达95%;有些特征是另一些特征的子集;因此需要降维,去掉作用较小的特征。

PCA中的数学一:向量的内积

向量默认是列向量

A和B的单位向量B’的内积,就会A在B上的投影

PCA中的数学二:基

线性无关:向量正交。正交向量的内积等于0。

将图中这组基(蓝色),旋转任意角度,都可以成为一组新的基

PCA中的数学三:基变换

同理,(3,2)和单位向量y1’、y2’的内积,就是(3,2)在新基上的投影

PCA中的数学四:基变换在PCA中如何应用

在y2上投影后,会有更多的数据重合;在y1投影后,重合的数据点更少

PCA中的数学五:如何找到最优基(方差最大的方向)

三维数据以橄榄型的为例子,当三维降二维的基为方差最大的方向,二维降三维的基也为方差最大的方向,这两个方向基本就是重合的。这样的话,这两个基不是线性无关的。

那么如何解决上述问题呢?

如何找到终极目标:找到一组合适的基呢?

利用协方差和协方差矩阵:可以找到一组正交且方差最大的正交基。

协方差矩阵(1/m)XX^T

由于协方差为0,则两个向量正交(线性不相关)。 为了找到方差最大的正交基,协方差矩阵需要是一个主对角线元素都最大且非主对角线全为0的对角阵。

矩阵转置后等于其本身的是实对称矩阵,C就是一个实对称矩阵,必定可以对角化

PCA手算实例

1、计算矩阵X:两个维度,5条数据,每条数据都减去均值都到矩阵X

2、计算矩阵X的协方差矩阵:m=5条数据

3:计算协方差矩阵的特征值和特征向量:根据特征值和特征向量的定义计算,行列式|λE-A| = 0,解得λ后;

当λ=2时,(λE-A)*(x1,x2)^ T = (0,0)^ T----->解得x1 = x2

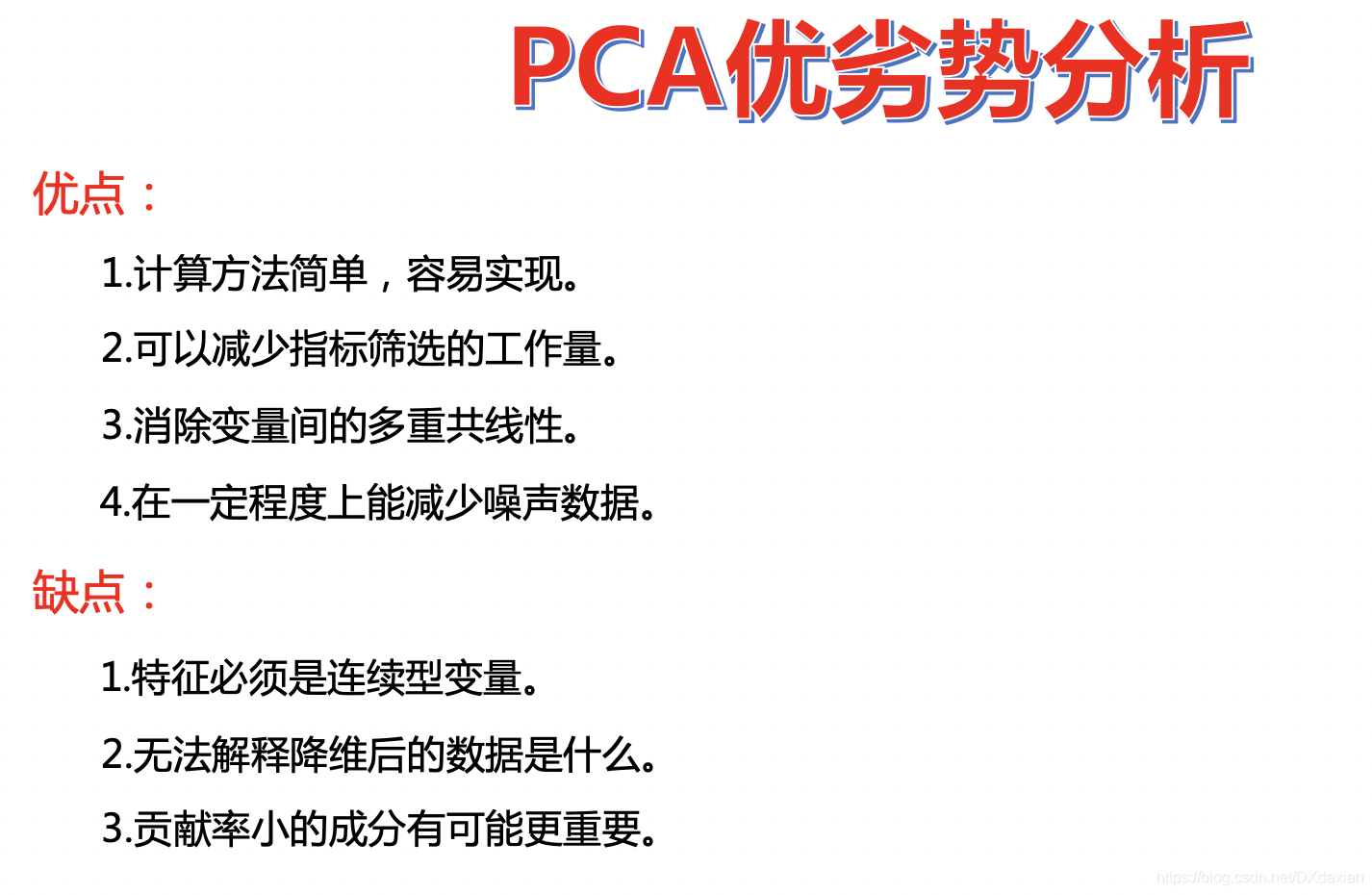

PCA优缺点

PCA主成分分析详解与应用

PCA主成分分析详解与应用

主成分分析PCA是一种有效的降维方法,尤其在高维数据中,通过找到方差最大的方向来降低数据的维度。PCA涉及向量的内积、基变换等数学概念,并可通过手算实例进行理解。PCA的优缺点包括能去除冗余特征,但可能丢失部分信息。在实际应用中,PCA算法的API参数如'n_components'决定了降维后的特征维度,'whiten'控制是否进行白化处理。

主成分分析PCA是一种有效的降维方法,尤其在高维数据中,通过找到方差最大的方向来降低数据的维度。PCA涉及向量的内积、基变换等数学概念,并可通过手算实例进行理解。PCA的优缺点包括能去除冗余特征,但可能丢失部分信息。在实际应用中,PCA算法的API参数如'n_components'决定了降维后的特征维度,'whiten'控制是否进行白化处理。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?