深度学习(Deep Learning)入门必备基本概念(这是一个超链接)

- 神经网络(Neural Network)基础

1.1 神经元(Neuron)

1.2 权重(weights)

1.3 偏差(bias)

1.4 激活函数(Activation function) - 常用的激活函数

2.1 sigmoid-用于隐层神经元的输出

2.2 ReLu(整流线型单位) - 用于隐层神经元输出 - 神经网络(Neural Network)

3.1 输入,输出,隐藏层

3.2 MLP(多层传感器)

3.3 正向传播(Forword Propagation)

3.4 成本/损失函数(Cost Function)

3.5 梯度下降

3.6 学习率(Learining rate)

3.7 反向传播(Back Propagation)

3.8 批次(Batches)

3.9 周期(Epoches)

3.10 丢弃(Dropout) - 卷积神经网络(CNN)

4.1 滤波器(filter)

深度学习的基本概念

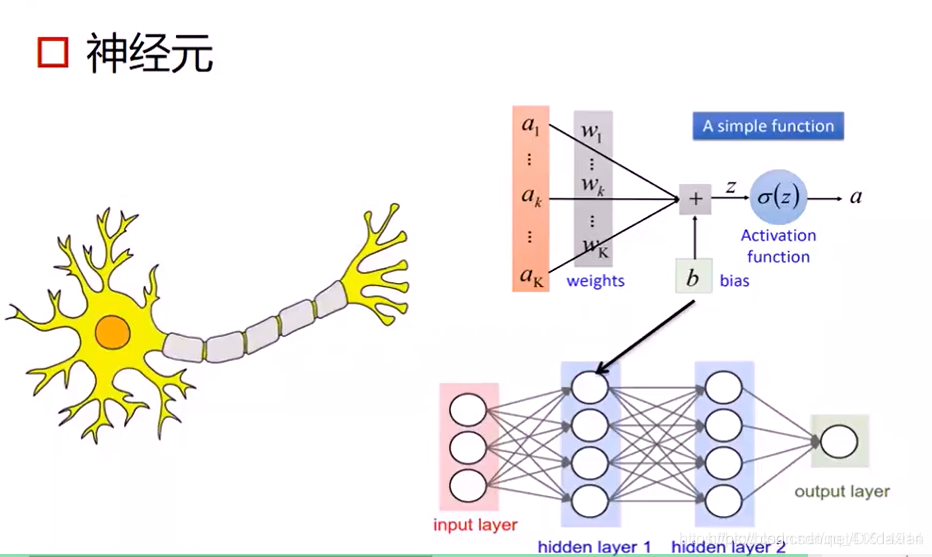

神经元

每个神经元都是由输入、权重、偏置以及激励函数组成的。

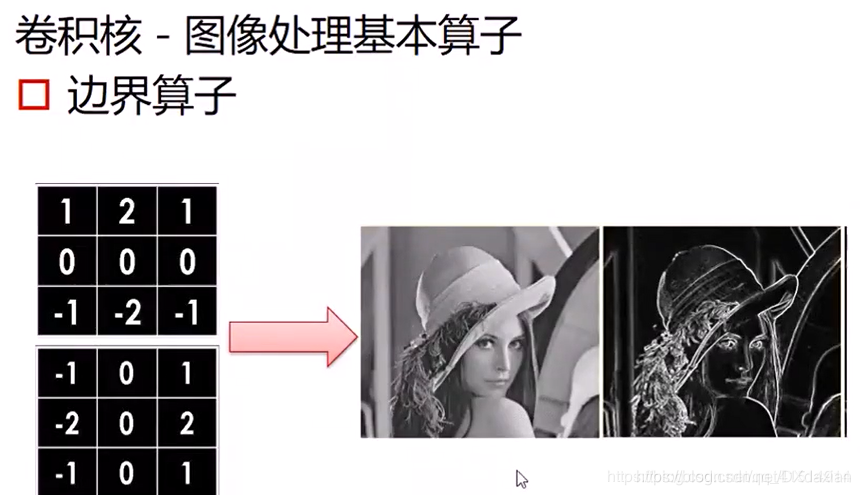

卷积核

卷积核是一种矩阵的形式,一般的卷积核大小为3*3,卷积核计算的过程类似于边界算子的计算过程, 将卷积核与图片中的像素点对应相乘,再相加,将得到的像素值作为该像素点的值。

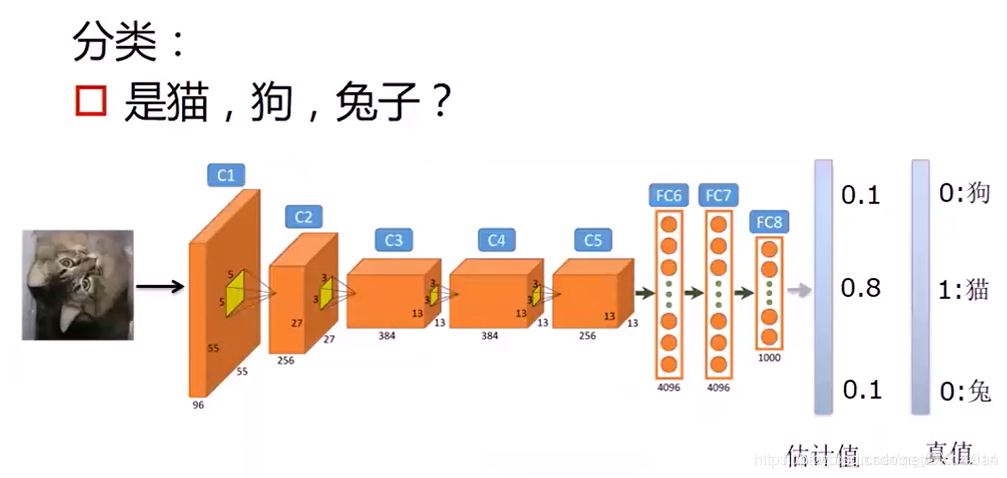

分类问题

分类问题是指预测的目标值为离散值

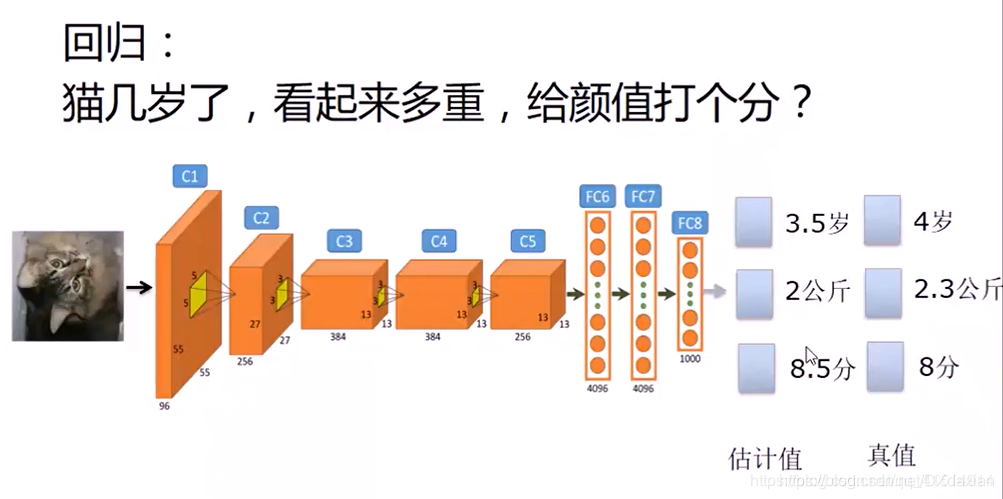

回归问题

回归是指预测的目标值为连续值

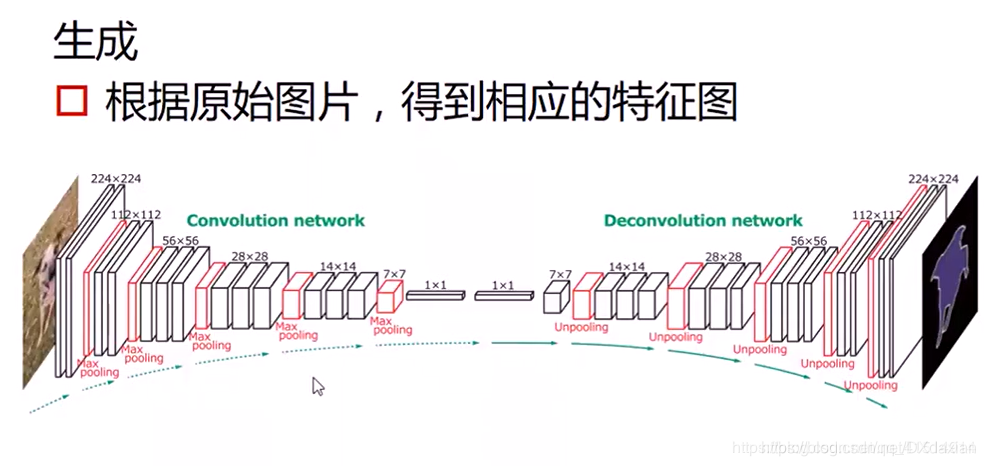

生成问题

本文概述了深度学习入门所需的基本概念,包括神经元、权重、偏差和激活函数。详细介绍了sigmoid和ReLU激活函数,以及神经网络的结构如输入、输出、隐藏层和正向传播。还涉及成本/损失函数、梯度下降、学习率、反向传播、批次、周期和丢弃等优化技术。此外,解释了卷积神经网络中滤波器的作用,以及深度学习在分类、回归和生成问题的应用。

本文概述了深度学习入门所需的基本概念,包括神经元、权重、偏差和激活函数。详细介绍了sigmoid和ReLU激活函数,以及神经网络的结构如输入、输出、隐藏层和正向传播。还涉及成本/损失函数、梯度下降、学习率、反向传播、批次、周期和丢弃等优化技术。此外,解释了卷积神经网络中滤波器的作用,以及深度学习在分类、回归和生成问题的应用。

1223

1223

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?