随着多语言交流的需求的增加,实时语音翻译正迅速受到关注。在本教程中,你将学习如何使用 H100 GPU + OpenAI API 在 Open WebUI 上部署实时语音翻译应用。我们马上开始吧。

准备工作

这里如果你有合适的 GPU 那么可以直接从 Docker 设置开始。如果你没有能跑起来大模型的 GPU ,那么可以选择 GPU 云服务器,获取 GPU 更快。本教程会使用GPU 服务器,以下是需要做的一些准备工作

- 一个DigitalOcean 账号。

- 在 DigitalOcean 后台部署并运行的GPU Droplet服务器。

- 一个用于访问 OpenAI 模型的 OpenAI API 密钥。

- 熟悉 SSH 和基础 Docker 命令。

- 用于登录 GPU Droplet 的 SSH 密钥,可参考我们往期教程。

一、设置 DigitalOcean GPU Droplet

1、创建新项目 - 你需要从后台控制面板创建一个新项目并将其关联到 GPU Droplet。

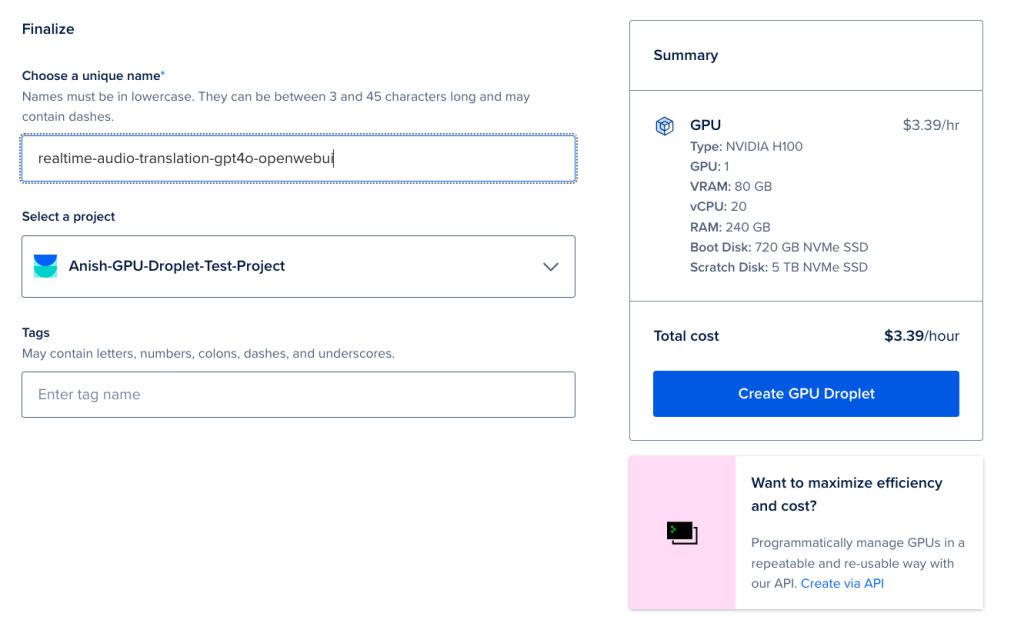

2、创建 GPU Droplet - 登录你的 DigitalOcean 账户,创建一个新的 GPU Droplet,并选择 AI/ML Ready 作为操作系统。这个操作系统镜像会安装所有必要的 NVIDIA GPU 驱动程序。你可以参阅我们的官方文档了解如何创建 GPU Droplet。这里用的是 H100的 GPU机器,详细的配置在本文中,我们不做赘述。

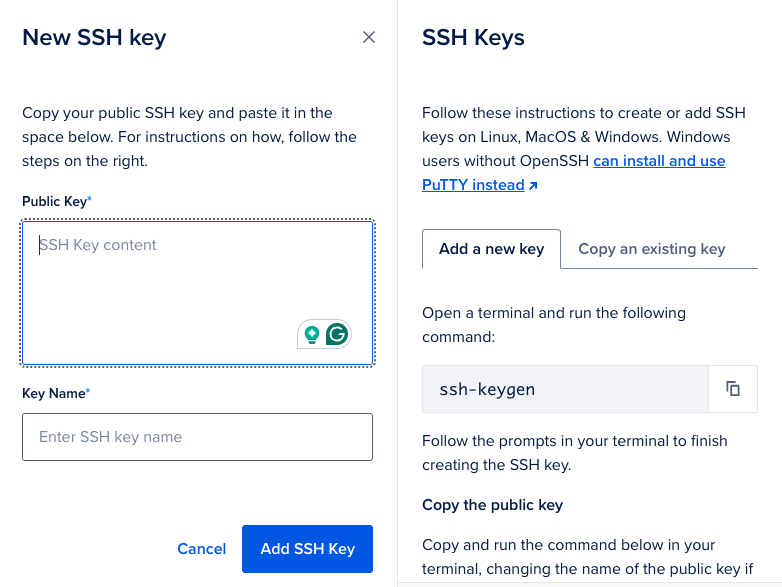

3、添加 SSH 密钥进行身份验证 - 需要 SSH 密钥来对 GPU Droplet 进行身份验证,通过添加 SSH 密钥,你可以从终端登录到 GPU Droplet。

4、完成并创建 GPU Droplet - 完成上述所有步骤后,完成并创建新的 GPU Droplet。

二、安装和配置 Open WebUI

Open WebUI 是一个允许用户与语言模型(LLM)互动的 Web 界面。它设计为用户友好、可扩展、自托管,并且可以离线运行。Open WebUI 的界面与 ChatGPT 类似,可以与多种 LLM 运行器配合使用,包括 Ollama 和与 OpenAI 兼容的 API。

有三种方法可以部署 Open WebUI:

- Docker:官方支持并推荐给大多数用户。

- Python:适合资源有限的环境或希望手动设置的用户。

- Kubernetes:适合需要扩展和编排的企业部署。

在本教程中,你将使用 Docker 作为 Docker 容器在支持 Nvidia GPU 的 GPU Droplet 上部署 Open WebUI。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

944

944

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?