本文系统介绍大模型领域五大热门研究方向:检索增强生成(RAG)借助外部知识库提升生成准确性;大模型Agent扩展AI应用场景;Mamba实现高效长上下文处理;LoRA提供参数高效微调方案;MoE优化模型资源利用。各方向包含HippoRAG、AutoDev、Jamba、DORA和Switch Transformers等创新技术,共同推动大模型效能提升与应用拓展,为研究者和开发者提供全面技术参考。

引言

人工智能领域大模型研究蓬勃发展,涵盖多个领域,各具特色与难题。热门方向包括RAG、大模型Agent、Mamba、MoE、LoRA等,致力于攻克大模型应用难题,提升效能与实用度。为寻找方向的朋友提供灵感。

检索增强生成RAG

RAG技术融合检索与生成,提升AI效能。其关键在于借助外部知识库,增强生成内容的准确与稳定性。依托大模型的卓越生成力,RAG在问答、文档、摘要、智能助手、检索与知识图谱等领域大放异彩。研究焦点包括检索与生成整合、跨模态应用及知识更新。挑战在于提升检索速度、生成品质,以及实现跨领域应用。

近期,人工智能大模型在多领域展现出卓越实力,但在知识融合与长期记忆上仍有明显不足。针对此问题,OSU与斯坦福的研究者提出创新方案——为模型构建类似人脑海马体的“记忆操作系统”。受海马体在记忆中的核心作用启发,研发了HippoRAG新检索增强模型。试验显示,具备这种“脑式”记忆系统的大模型在知识整合任务上显著提升了表现。

AI2推出的Adaptive-RAG问答框架,集成多种策略,可智能匹配请求难度,以优化大模型的响应精准度,显著提升问答效率。

依赖大模型参数知识生成文本易致幻觉,故采用检索增强生成(RAG)辅助。但RAG的准确性受限于检索文本的准确性,检索问题影响生成文本质量。为提升鲁棒性,中科大提出CRAG方法,专注于改进检索增强生成。

Infineon推出RAG-Fusion技术,集成了RAG与Reciprocal Rank Fusion。该技术首先利用指令遵循模型生成多个查询,接着针对每个查询执行矢量搜索,从预设集合中提取相关文档。随后,采用倒数排名融合算法,基于请求间的相关性对文档进行重新排序,最终输出优化后的文档列表。

Amazon推出的SYNTHESIZRR方法革新了LLMs在分类任务中的微缩化。此法摒弃了传统方法中提示生成数据集的弊端,通过检索增强引入多样性,让LLM生成更丰富的示例。在词汇、语义多样性和模仿人类文本等方面,SYNTHESIZRR均显著超越传统方法。

大模型Agent

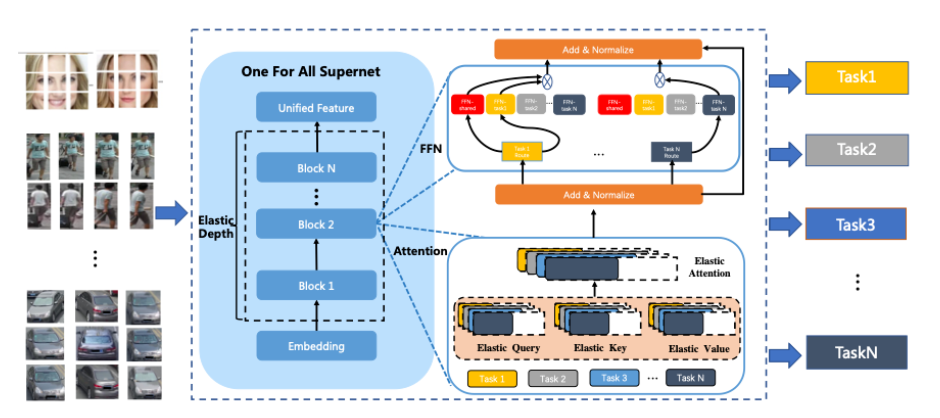

今年初,业界巨头吴恩达指出,大模型Agent将成为未来发展的关键。面对日益复杂的应用场景,单纯依赖大模型能力将遭遇重大挑战,故充分利用大模型构建Agent成为趋势。微软研究团队深入剖析Agent AI的基石,强调其在物理、虚拟、混合现实及感官交互领域的潜力,视Agent AI为下一代AI的核心。研究聚焦于“多任务学习”、“常识推理”和“持续学习”,旨在增强Agent在各种任务中的表现与适应能力。

AUTOWEBGLM:智谱发布新型智能网页导航代理,通过AI技术优化网页处理挑战,采用独特算法提取关键信息,结合AI训练与强化学习,提升网页理解和任务执行效率。

微软推出AI驱动自动开发框架AutoDev,实现软件工程目标自动化。用户设定目标后,AutoDev的智能Agent可在代码库中自主进行编辑、检索、构建、执行、测试及Git操作。

Google推出SceneCraft,这是一款革命性大语言模型Agent,可将文本描述转化为Blender中运行的Python脚本,助力构建复杂3D场景。它通过高级抽象、策略规划和库学习,有效解决空间规划和布局难题。

生成模型在软件工程领域,尤其在代码生成与调试中成效斐然。然而,在自动生成代码文档方面,其潜力尚待挖掘。为此,清华大学打造了开源框架REPOAGENT,依托大型语言模型,专注于代码文档的自动创建、维护与更新。经多维度评估,包括定性与定量分析,REPOAGENT在构建高品质代码仓库文档方面的实力得到验证。

本研究探讨提升大型语言模型如ChatGPT和GPT-4效能的方法,尤其针对复杂任务的多技能需求。为此,清华大学开发了GITAGENT,该工具能协助模型自主从GitHub筛选并整合相关代码库。GITAGENT运作流程分为四步,并在遇到难题时,借鉴GitHub上其他用户的解决方案,不断学习进步。

关于大语言模型的规划与推理,观点各异。亚利桑那州立大学研究者认为,LLMs无法独立进行规划推理,但能在规划问题中发挥关键作用。为此,他们提出了一种LLM-Modulo框架,整合LLMs与外部验证工具,显著提升LLMs在规划任务中的效能。

Mamba

Mamba,一种高效的选择性结构状态空间模型,擅长长上下文任务,实现线性时间推理和并行训练。源于CMU,Mamba通过全局视野与动态权重优化卷积神经网络,兼具Transformers建模优势,降低计算复杂度。研究致力于强化长序列处理、多模态融合及计算效率。

波兰研究团队最新成果MoE-Mamba融合Mamba与混合专家层,显著提高SSM与MoE效率。研究显示,专家数量变动时,MoE-Mamba表现可预测。

中科大等团队将Mamba与视觉研究融合,创新推出Vim架构。在ImageNet分类、COCO对象检测及ADE20k语义分割等任务中,Vim超越DeiT等成熟视觉Transformer,性能更优且显著提升计算和内存效率。以1248×1248分辨率图像为例,Vim在特征提取上的速度比DeiT快2.8倍,GPU内存消耗减少86.8%。

华为诺亚方舟实验室创新提出DenseMamba,优化了SSM中隐藏信息流动。通过精准融合浅层至深层,DenseMamba确保关键信息不失真。此方法在维持训练并行与推理高效的同时,通过密集连接显著提升性能,适用于多种SSM模型。

浙大融合Mamba和多模型大模型,创新推出Cobra,这是线性计算复杂度的MLLM,巧妙地将Mamba语言模型融入视觉模态。实证表明,Cobra在效能上匹敌顶级方案,速度更优,尤其在视觉错觉与空间关系识别上更显优势。Cobra的参数仅为LLaVA的43%,却能保持同等性能。

AI21 Labs开源了Jamba新法,其在多个基准测试中胜过transformer。Jamba结合Mamba的SSM架构,有效缓解transformer的内存与上下文限制,但输出效果略逊。Jamba融合了SSM和transformer优势,实现长上下文吞吐量超越Mixtral 8x7B三倍,效率远超同等规模的基于Transformer的模型。

大模型高效微调(LoRA)

在微调大模型时,策略多样,主要分为全面微调和高效微调。全面微调调整预训练模型的全部参数,需庞大计算力,易引发灾难性遗忘,即增强特定任务性能或削弱其他领域表现。

为解决这些问题,PEFT技术通过调整模型部分参数缩短训练周期和成本。该技术涵盖多种策略,如Prefix Tuning(预置可学习虚拟token),Prompt Tuning(输入层增入prompt token),P-Tuning(prompt转Embedding层,配合MLP+LSTM),Adapter Tuning(插入小型神经网络模块),以及LoRA(引入低秩矩阵模拟微调)。这些方法旨在提升训练效率,并确保或增强模型表现。

LORA及其变种在参数高效微调(PEFT)领域因省去额外推理成本而广受欢迎。它大幅降低微调成本,效果逼近全模型微调。因此,LORA的优化版本不断涌现,成为研究焦点。研究重点包括参数效率、保微调策略、上下文扩展和模型压缩等。

DORA(权重分解低阶适应)由英伟达提出,显著提升了LoRA的学习效率和训练稳定性,且不增加推理成本。实验验证,DORA在多种下游任务中的模型微调效果均超越LORA。

华盛顿大学推出QLORA算法,能在维持16位微调性能的同时,在单卡48G GPU上实现650亿参数大模型微调。研究团队发布的Guanaco系列模型,在Vicuna基准测试中超越先前所有公开模型,仅需单个GPU微调24小时,即可达到ChatGPT性能的99.3%。

MIT创新性地推出LongLORA微调算法,显著提升Token上下文长度,尤其在资源紧张时,大幅扩充LLMS预训练模型能力。该算法将LLaMA2-7B模型上下文容量从4K提升至100K。

斯坦福的S-LORA系统专为高效扩展LORA适配服务而构建,集中存储所有适配器于主内存,并将实时使用适配器加载至GPU内存。它能在单个或多GPU环境中为数千个LORA适配器提供支持,同时将额外计算成本降到最低。反观LLM-packed,需频繁维护权重副本,且受限于GPU内存,仅能支持少数几个适配器。

MoE

MoE并非新兴技术,即混合专家模型(Mixed Expert Models)。该理念最早由剑桥学者在1991年论文《Adaptive Mixture of Local Experts》中提出。然而,随着大模型参数规模扩张和多任务应用兴起,MoE研究亦成为当下热点。

模型参数规模扩大,性能提升,涌现现象频现,驱动了大模型的热潮。但如何在资源受限下,以更少步数训练更大模型?MoE技术正是为此而生。

MoE模型低资源需求、快速训练、低推理成本、强扩展性和多任务学习。其显著特点是即使在比Dense模型少的计算资源下也能有效预训练,使得在固定预算下能大幅提升模型或数据集规模。尤其在预训练期,MoE模型往往能比Dense模型更快达到同等质量。研究焦点包括“专家网络协同”、“动态路由”、“低专家激活率”及“模型可扩展性”。以下为近期研究进展供参考。

2022年,Google的Switch Transformers在降低模型复杂性和微调稳定性问题上取得显著进展。该技术优化了MoE路由算法,并提出了易于理解的改进模型,大幅减少通信与计算开销。此外,Switch Transformers的训练策略增强了稳定性,并开创性地实现了以bfloat16低精度格式训练大规模稀疏模型的新路径。

北大优化MoE路由机制,创新推出动态Expert选取策略。对于复杂任务,采用更多Expert协同,简单任务则减少Expert使用,提升资源利用率。实验显示,该方法在多基准测试中超越传统Tp-2路由,平均提升效率0.7%,激活参数仅90%。

微软研发的MH-MOE,通过多头机制将输入token拆分并行处理,有效提升专家激活率与扩展性,实现更精细的理解。

ByteDance推出CuMo技术,将MOE融入多模态LLM,通过融合视觉编码器与MLP的Top-K稀疏门控MOE模块,显著增强模型多模态任务表现,且成本控制优异。在多尺寸模型基准测试中,实现SOTA性能。

我们如何系统学习掌握AI大模型?

AI大模型作为人工智能领域的重要技术突破,正成为推动各行各业创新和转型的关键力量。抓住AI大模型的风口,掌握AI大模型的知识和技能将变得越来越重要。

学习AI大模型是一个系统的过程,需要从基础开始,逐步深入到更高级的技术。

这里给大家精心整理了一份

全面的AI大模型学习资源,包括:AI大模型全套学习路线图(从入门到实战)、精品AI大模型学习书籍手册、视频教程、实战学习、面试题等,资料免费分享!

1. 成长路线图&学习规划

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

这里,我们为新手和想要进一步提升的专业人士准备了一份详细的学习成长路线图和规划。可以说是最科学最系统的学习成长路线。

2. 大模型经典PDF书籍

书籍和学习文档资料是学习大模型过程中必不可少的,我们精选了一系列深入探讨大模型技术的书籍和学习文档,它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。(书籍含电子版PDF)

3. 大模型视频教程

对于很多自学或者没有基础的同学来说,书籍这些纯文字类的学习教材会觉得比较晦涩难以理解,因此,我们提供了丰富的大模型视频教程,以动态、形象的方式展示技术概念,帮助你更快、更轻松地掌握核心知识。

4. 大模型行业报告

行业分析主要包括对不同行业的现状、趋势、问题、机会等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

5. 大模型项目实战

学以致用 ,当你的理论知识积累到一定程度,就需要通过项目实战,在实际操作中检验和巩固你所学到的知识,同时为你找工作和职业发展打下坚实的基础。

6. 大模型面试题

面试不仅是技术的较量,更需要充分的准备。

在你已经掌握了大模型技术之后,就需要开始准备面试,我们将提供精心整理的大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以

微信扫描下方优快云官方认证二维码,免费领取【保证100%免费】

7457

7457

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?