智能主体分块(Agentic Chunking)是一种先进的文档分割方法,通过识别逻辑断点、利用LLM生成摘要标题、保持分块间内容重叠,解决传统分块导致的上下文丢失问题。该方法结合Hugging Face、Pinecone和LangChain工具,将非结构化文本转化为可检索的知识,提升AI检索效果和总结质量,应用于RAG、企业文档搜索、聊天机器人等领域,使AI响应更具上下文关联性。

人工智能应用面临的挑战之一是处理海量文本数据。传统分块技术常常会遗漏上下文关联,这降低了基于检索的 AI 模型的效用。而智能主体分块(Agentic Chunking) 作为一种更智能的文档分割方法,能够提升检索、总结和处理效率,可有效解决这一问题。

本文主要有以下内容:

- 智能主体分块的定义及其重要性

- 大型语言模型(LLMs)如何助力生成有意义的文本片段

- 向量存储与嵌入(Embeddings)在智能检索中的作用

- 一个实用的 Python 实现方案,该方案运用了 Hugging Face、Pinecone 和 LangChain 工具

通过阅读本文,你将了解智能主体分块如何通过将非结构化文本转化为可检索的知识,从而释放 AI 应用的潜力。

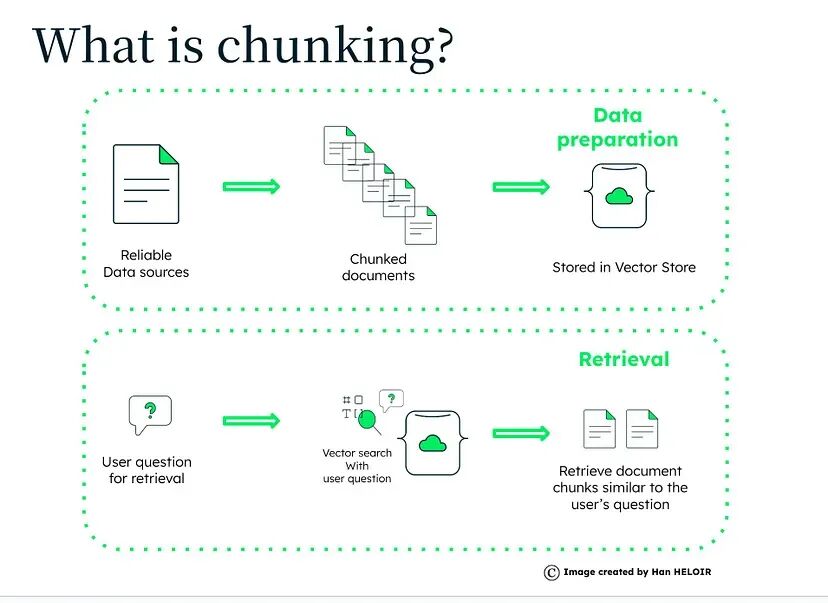

一、什么是智能主体分块?

传统分块技术会使用任意分隔符(如换行符)、固定令牌数量限制或句子数量来自动分割文本。这往往会导致上下文丢失,关键概念要么被遗漏,要么分散在多个片段中。

智能主体分块则采用了更智能的方法:

- 识别逻辑断点,例如章节、主题或论证流程的自然分隔处

- 借助 AI 为每个分块生成标题和摘要,以便于检索

- 通过分块间的内容重叠,保持上下文的连贯性

这种方法确保每个分块都包含一个完整、独立的概念,从而提升了 AI 驱动的检索和总结效果。

二、智能主体分块的工作原理

1. 文本提取与清洗

- PDF 和各类文档中通常包含冗余信息(如页眉、页脚、页码)

- 我们使用 PDFMiner 工具提取原始文本,并清理其中不必要的元素

2. 智能文本分割

智能主体分块不采用僵化的令牌数量限制,而是动态分割文本:

- 一级分割:按逻辑结构(页面、章节、段落)分割

- 二级分割:采用滑动窗口法,确保分块间存在内容重叠

3. 借助 LLM 生成摘要与标题

利用大型语言模型(如 deepseek)对每个分块进行优化:

- 生成关键信息的简洁摘要

- 创建描述性标题,方便快速查阅

4. 嵌入处理与 Pinecone 存储

- 将每个分块转换为向量嵌入(使用 Hugging Face 模型)

- 存储到 Pinecone 中,实现语义搜索和高效检索

三、智能主体分块的核心优势

-

更精准的 AI 检索

AI 不再检索随机的文本片段,而是获取连贯、带摘要的完整章节

-

更优质的总结效果

AI 生成的摘要能保留关键信息,降低 “幻觉”(生成虚假信息)的风险

-

更快的搜索与检索速度

Pinecone 向量存储支持基于语义含义的即时查询,而非仅依赖关键词

-

更贴近人类的 AI 响应

应用于聊天机器人和检索增强生成(RAG)时,响应会更具上下文关联性和针对性

四、代码实现:智能主体分块的实际应用

下面将逐步介绍 Python 实现方案。该系统可实现以下功能:

- 从 PDF 中提取文本

- 采用上下文感知方法对文本进行分块

- 借助 deepseek 为每个分块生成摘要和标题

- 使用 Hugging Face 对分块进行嵌入处理

- 存储到 Pinecone 中,以备检索使用

1. 从 PDF 中提取文本

from pdfminer.high_level import extract_text

def extract_text_from_pdf(pdf_path: str) -> str:

"""从pdf中抽取文本"""

try:

return extract_text(pdf_path)

except Exception as e:

print(f"提取错误 {pdf_path}: {e}")

return ""

2. 文本清洗与预处理

import re

def clean_text(text: str) -> str:

"""移除不需要的字符"""

text = re.sub(r'[^A-Za-z0-9\s.,;:()\-]', '', text)

return re.sub(r'\s+', ' ', text).strip()

3. 带重叠的智能分块

class AgenticChunker:

def __init__(self, llm):

self.llm = llm

def chunk_document(self, text: str, target_chars=2000, overlap_chars=200):

"""将文本分割成重叠的块,并为每个块提供摘要。"""

segments = text.split("\n\n")

full_text = " ".join(segments)

chunks, start = [], 0

while start < len(full_text):

end = start + target_chars

chunk = full_text[start:end]

chunks.append(chunk)

start = max(0, start + target_chars - overlap_chars)

return [{"text": chunk, "summary": self._get_summary(chunk)} for chunk in chunks]

def _get_summary(self, text: str):

"""利用llm生成摘要"""

return self.llm.generate_summary(text)

4. 借助 deepseek生成摘要与标题

from langchain_openai import ChatOpenAI

llm = ChatOpenAI(model_name='deepseek', temperature=0.2)

def generate_summary(text):

"""摘要"""

prompt = f"请用一句话概括这段文本:\n\n{text}"

return llm.predict(prompt)

5. 将分块转换为向量嵌入(使用 Hugging Face)

from transformers import AutoTokenizer, AutoModel

import torch

tokenizer = AutoTokenizer.from_pretrained("dwzhu/e5-base-4k")

model = AutoModel.from_pretrained("dwzhu/e5-base-4k")

def get_embedding(text: str):

inputs = tokenizer(text, return_tensors='pt', truncation=True, max_length=512)

with torch.no_grad():

outputs = model(**inputs)

return outputs.last_hidden_state.mean(dim=1).squeeze().numpy().tolist()

6. 存储到 Pinecone 中以备检索

from pinecone import Pinecone

pinecone_api_key = "您的PINECONE API密钥"

pc = Pinecone(api_key=pinecone_api_key)

index = pc.Index("agentic-chunks")

def upsert_to_pinecone(chunk_id, text, summary, embedding):

vector = {

"id": chunk_id,

"values": embedding,

"metadata": {"text": text, "summary": summary}

}

index.upsert(vectors=[vector])

五、智能主体分块的潜在应用场景

目前,这项技术已被应用于多种高级 AI 应用中,例如:

-

检索增强生成(RAG)

AI 模型获取上下文相关的文本片段,以提供精准响应

-

企业文档搜索

大型企业利用智能主体分块检索内部文档

-

AI 聊天机器人

更智能的聊天机器人能够检索包含完整上下文的数据库响应

-

法律与医疗 AI

在检索大型数据库时,不丢失已提取的文本信息

六、总结

智能主体分块将非结构化文本转化为可利用的知识。与简单的基于令牌的分割方法相比,这种方法具有以下优势:

- 保留上下文关联性

- 生成具有洞察力的摘要

能的聊天机器人能够检索包含完整上下文的数据库响应 - 法律与医疗 AI

在检索大型数据库时,不丢失已提取的文本信息

如何系统学习掌握AI大模型?

AI大模型作为人工智能领域的重要技术突破,正成为推动各行各业创新和转型的关键力量。抓住AI大模型的风口,掌握AI大模型的知识和技能将变得越来越重要。

学习AI大模型是一个系统的过程,需要从基础开始,逐步深入到更高级的技术。

这里给大家精心整理了一份

全面的AI大模型学习资源,包括:AI大模型全套学习路线图(从入门到实战)、精品AI大模型学习书籍手册、视频教程、实战学习、面试题等,资料免费分享!

1. 成长路线图&学习规划

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

这里,我们为新手和想要进一步提升的专业人士准备了一份详细的学习成长路线图和规划。可以说是最科学最系统的学习成长路线。

2. 大模型经典PDF书籍

书籍和学习文档资料是学习大模型过程中必不可少的,我们精选了一系列深入探讨大模型技术的书籍和学习文档,它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。(书籍含电子版PDF)

3. 大模型视频教程

对于很多自学或者没有基础的同学来说,书籍这些纯文字类的学习教材会觉得比较晦涩难以理解,因此,我们提供了丰富的大模型视频教程,以动态、形象的方式展示技术概念,帮助你更快、更轻松地掌握核心知识。

4. 大模型行业报告

行业分析主要包括对不同行业的现状、趋势、问题、机会等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

5. 大模型项目实战

学以致用 ,当你的理论知识积累到一定程度,就需要通过项目实战,在实际操作中检验和巩固你所学到的知识,同时为你找工作和职业发展打下坚实的基础。

6. 大模型面试题

面试不仅是技术的较量,更需要充分的准备。

在你已经掌握了大模型技术之后,就需要开始准备面试,我们将提供精心整理的大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以

微信扫描下方优快云官方认证二维码,免费领取【保证100%免费】

362

362

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?