一、引言

大语言模型(LLMs)的发展日新月异,每一次重大更新都可能带来性能的显著提升和应用场景的拓展。在这个背景下,阿里巴巴院最新发布的Qwen2.5系列模型引起了广泛关注。这篇技术报告详细介绍了Qwen2.5的开发过程、创新点和性能表现,展示了其在自然语言处理领域的最新进展。

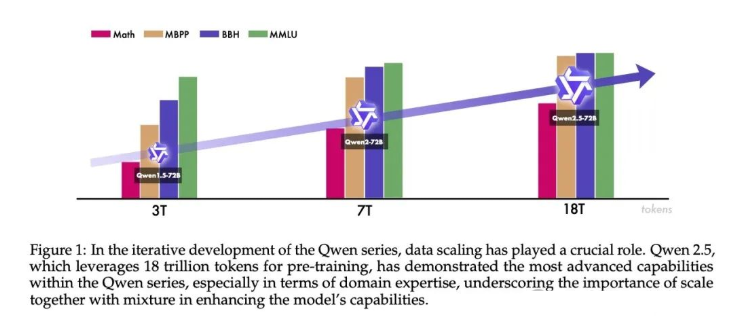

Qwen2.5系列模型的核心创新主要体现在两个方面:预训练和后训练。在预训练阶段,研究团队将训练数据规模从7万亿token扩大到18万亿token,这一巨大的数据量级的提升为模型的知识获取和理解能力奠定了坚实基础。在后训练阶段,研究者采用了包含100万样本的监督微调(SFT)和分阶段强化学习(包括离线学习DPO和在线学习GRPO)的复杂技术,这些方法显著提高了模型对人类偏好的对齐程度,并增强了长文本生成、结构化数据分析等能力。

本文将深入探讨Qwen2.5模型的开发过程,包括其在预训练和后训练阶段的创新方法,以及在各种基准测试中的表现。通过这篇报告,我们可以一窥当前大语言模型技术发展的前沿,了解Qwen2.5如何在众多竞争对手中脱颖而出,成为推动自然语言处理技术进步的重要力量。

二、预训练阶段的创新

1、数据处理的突破

Qwen2.5在预训练数据的处理上有几个显著的创新点,这些创新极大地提高了训练数据的质量和多样性。

智能数据过滤

研究团队巧妙地利用了Qwen2模型来对预训练数据进行智能过滤。这种方法不仅提高了数据质量,还增强了模型对多语言数据的处理能力。通过这种自我迭代的方式,Qwen2.5能够更好地识别和保留高质量的训练样本,同时有效过滤掉低质量的数据。

专业领域数据的融入

Qwen2.5的另一个亮点是融入了来自Qwen2.5 Math和Qwen2.5 Coder的专业数据。这些数据涵盖了数学和编程领域的高质量样本,极大地增强了模型在这两个关键领域的能力。这种专业数据的引入,使得Qwen2.5在处理数学问题和编程任务时表现出色。

高质量合成数据

研究团队还利用Qwen2-72B和Qwen2-Math模型生成高质量的合成数据。更值得注意的是,他们使用Qwen2-Math-RM模型对这些合成数据进行进一步筛选,确保了合成数据的质量和相关性。这种方法不仅扩大了训练数据的规模,还保证了数据的高质量和多样性。

智能数据混合

为了平衡不同类型的数据,研究者使用Qwen2模型对数据进行分类,然后对不同类别的数据进行均衡处理。这种方法确保了模型能够从各种类型的数据中学习,避免了某些领域数据过多而导致的偏差。

2、突破性的扩展法则

Qwen2.5的另一个重要创新在于其扩展法则(Scaling Law)的应用。研究团队深入研究了在不同模型大小(N)和数据量(D)下的最优学习率和批量大小(Batch Size)。这种方法允许研究者为不同规模的模型找到最佳的训练参数,从而在训练效率和模型性能之间取得平衡。

3、长上下文处理的创新

Qwen2.5在处理长上下文方面也有显著突破:

-

多阶段训练:模型训练分为两个阶段,首先在4K上下文长度上训练,然后扩展到32K。这种渐进式的方法使模型能够逐步适应更长的上下文。

-

RoPE基础值调整:通过ABF技术调整RoPE的基础值,进一步增强了模型处理长序列的能力。

-

Qwen2.5-Turbo的创新:这个特殊版本采用了四阶段训练策略(4K, 32K, 64K, 128K),每个阶段都确保40%的数据达到最大长度,而60%是较短的序列。这种平衡的方法使得模型在各种长度的输入上都能表现出色。

-

推理阶段的优化:引入YARN和Dual Chunk Attention技术,进一步提升了模型在实际应用中处理长序列的能力。

这些创新使得Qwen2.5在处理长文本和复杂上下文时表现出色,大大扩展了模型的应用场景。

三、后训练阶段的优化

后训练阶段是Qwen2.5模型提升性能的关键环节。研究团队在这一阶段采用了一系列创新方法,包括复杂的监督微调(SFT)和多阶段强化学习。

1、监督微调(SFT)的创新

长序列生成能力的提升

Qwen2.5突破性地将输出长度提升到8K tokens。研究团队巧妙地从预训练数据集中生成查询(Query),并添加长度控制指令,使模型能够生成更长、更连贯的文本。这一改进极大地增强了模型在长文本生成任务中的表现。

数学能力的增强

研究者利用Qwen2.5 Math的链式思考(Chain of Thought, CoT)数据,并通过拒绝采样(Rejection Sampling)技术生成逐步推理过程。这种方法不仅提高了模型的数学推理能力,还使其能够清晰地展示解题步骤。

编程能力的提升

Qwen2.5整合了来自Qwen2.5 Coder的数据,涵盖近40种编程语言。这种广泛的语言覆盖使得模型在各种编程任务中都能表现出色,从而大大增强了其在软件开发领域的应用潜力。

指令遵循能力的优化

研究团队实现了一个创新的代码验证框架,其中LLM不仅生成指令,还生成相应的检查代码框架。通过执行反馈的拒绝采样,确保了模型能够准确理解和执行各种指令。

结构化数据理解的增强

通过构建全面的结构化数据理解数据集并引入推理链,Qwen2.5显著提高了从复杂数据结构中推理和提取信息的能力。这一改进使模型在处理表格、JSON等结构化数据时更加得心应手。

逻辑推理能力的提升

研究者构建了一个包含7万条数据的多样化数据集,涵盖多选、是非和开放式问题。这些问题系统地包含了演绎推理、归纳概括、类比推理、因果推理和统计推理等多种推理方法,全面提升了模型的逻辑思维能力。

多语言能力的增强

研究团队采用翻译模型将高资源语言的指令翻译到低资源语言,并评估多语言响应与原始响应的语义一致性。这种方法不仅扩展了模型的语言覆盖范围,还保证了跨语言性能的一致性。

系统指令鲁棒性的提高

通过构建多样化的系统提示(system prompt)并确保其与对话内容的一致性,Qwen2.5在处理不同类型的系统指令时表现更加稳定和可靠。

响应质量的严格把控

研究者采用多种自动评估方法,包括专门的判别器和多智能体打分系统,只保留被所有评估方法认定为高质量的样本。这种严格的筛选确保了训练数据的高质量。

2、离线强化学习(Offline RL)的创新

为了解决奖励模型(Reward Model, RM)在某些任务上评分不准确的问题,研究团队创新性地采用了执行反馈和答案匹配来构建正负样本。这种方法特别适用于数学、编程等客观任务领域。此外,研究者还引入了双重人工检查机制,进一步保证了训练信号的可靠性和准确性。

3、在线强化学习(Online RL)的突破

奖励模型的优化

研究团队为奖励模型制定了全面的评估标准,包括真实性、有用性、简洁性、相关性、无害性和去偏见性。这些标准确保了模型输出的高质量和道德性。

数据集的多样性

RM和RL训练使用了开源数据集和更复杂的私有数据集的组合。响应来源于不同训练阶段的Qwen模型,并使用不同的温度系数生成,确保了数据的多样性。

创新的训练框架

研究者采用了GRPO(Group Relative Policy Optimization)框架进行在线RL训练,这是一种新型的强化学习算法,能够更有效地优化模型策略。

智能采样策略

在训练过程中,每次为每个查询采样8个输出,这种策略平衡了探索和利用,有助于模型学习更多样化的响应。

通过这些创新的后训练方法,Qwen2.5不仅在各种任务上表现出色,还展现了较强的指令遵循能力和人类偏好对齐程度。这些改进使得Qwen2.5成为一个更加智能、可靠和易用的大语言模型。

四、Qwen2.5的性能评估

Qwen2.5系列模型经过了全面而严格的评估,涵盖了开放基准测试和内部专业评估。这些评估不仅展示了模型在各种任务上的卓越表现,还凸显了其在长上下文处理方面的突出能力。

1、开放基准测试

研究团队使用了一系列广泛认可的基准测试来评估Qwen2.5的性能:

-

通用能力测试:包括MMLU-Pro、MMLU-redux和LiveBench 0831等,用于评估模型的综合理解和推理能力。

-

科学和数学能力:使用GPQA、GSM8K和MATH等测试,评估模型在科学推理和数学问题解决方面的表现。

-

编程能力:通过HumanEval、MBPP、MultiPL-E和LiveCodeBench等测试,全面评估模型的代码生成和理解能力。

-

指令遵循能力:使用IFEval等测试,评估模型对指令的理解和执行能力。

-

人类偏好对齐:采用MT-Bench和Arena-Hard等测试,评估模型输出与人类期望的一致性。

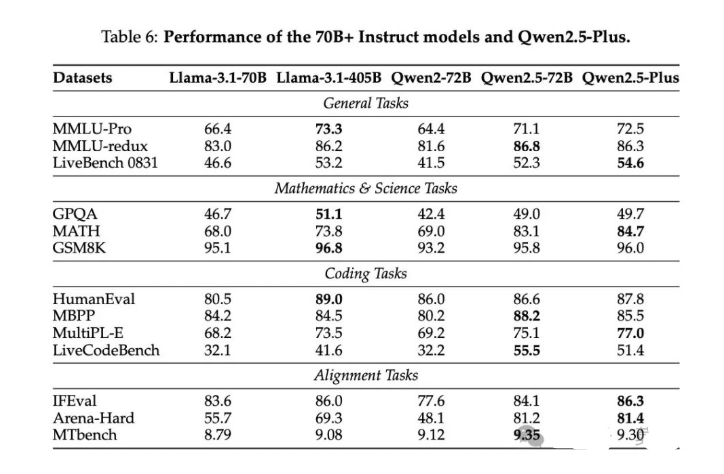

结果显示,Qwen2.5-72B-Instruct在多个基准测试中表现卓越,甚至超越了一些参数量更大的模型,如Llama-3.1-405B-Instruct。特别是在MMLU-redux、MATH、MBPP等测试中,Qwen2.5展现了领先优势。

2、内部专业评估

除了开放基准测试,研究团队还进行了一系列内部专业评估:

-

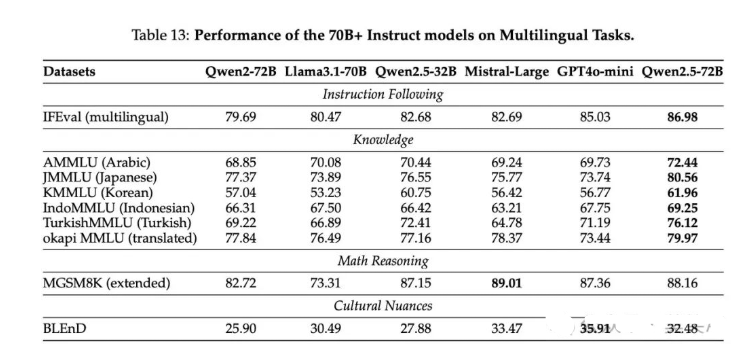

多语言能力评估:使用AMMLU、JMMLU等多语言测试,评估模型在不同语言环境下的表现。

-

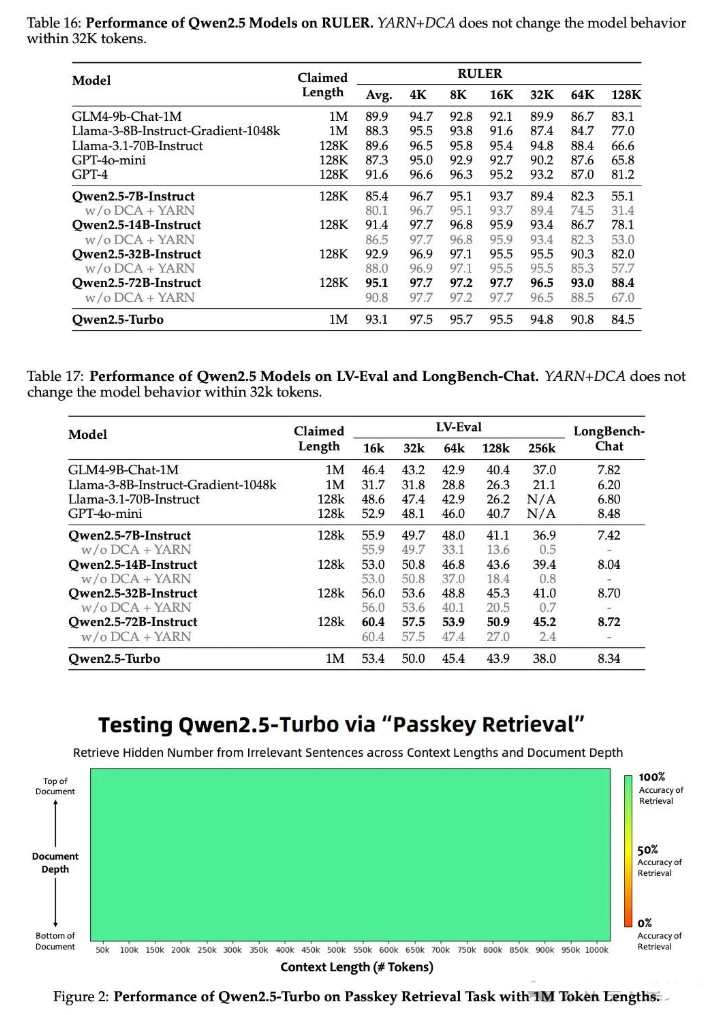

长上下文能力评估:采用RULER、LV-Eval和Longbench-Chat等测试,评估模型处理长文本的能力。结果显示,Qwen2.5-72B-Instruct在各种上下文长度下都表现出色,优于许多开源和专有模型。

-

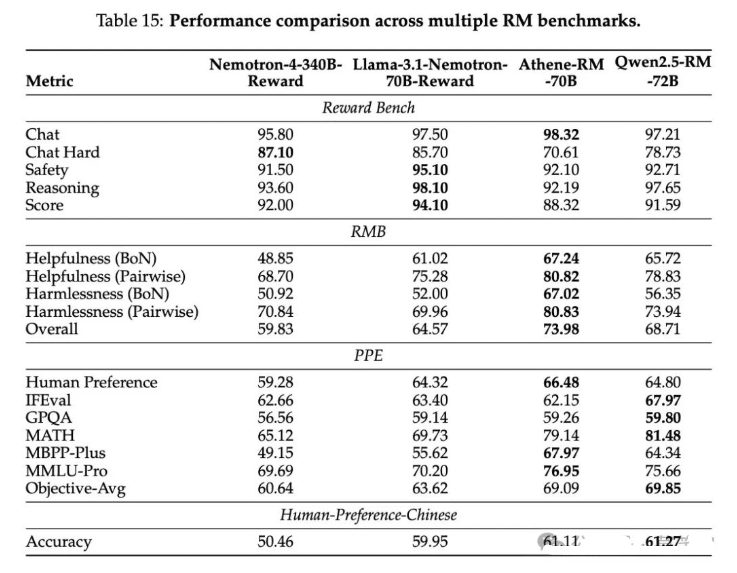

奖励模型评估:使用Reward Bench、RMB等测试,评估用于强化学习的奖励模型的性能。

3、长上下文处理能力的突破

Qwen2.5在长上下文处理方面取得了显著突破:

-

Qwen2.5-Turbo:在100万token的密钥检索任务中达到100%的准确率,展示了处理超长上下文的卓越能力。

-

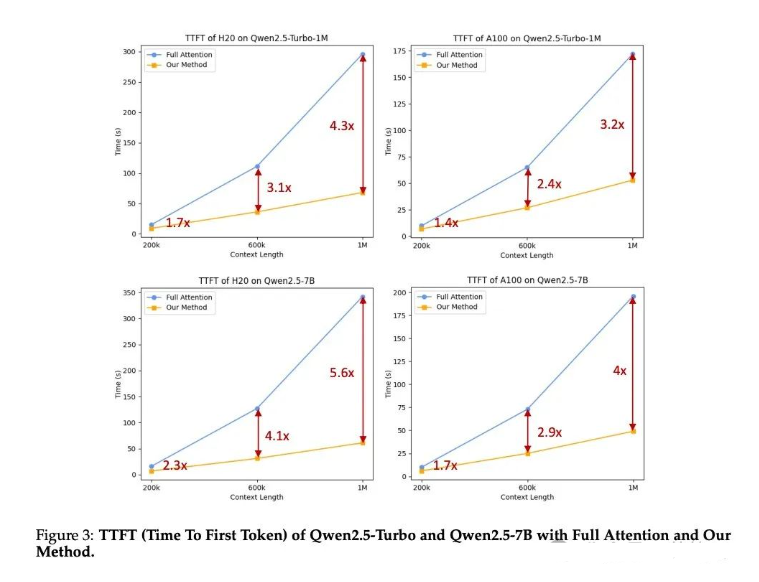

推理速度优化:通过引入稀疏注意力机制,显著提高了长上下文处理的推理速度。对于100万token的序列,计算负载减少了12.5倍。

-

首个token生成时间(TTFT):在不同硬件配置下,Qwen2.5-Turbo的TTFT比传统方法快3.2到4.3倍。

这些评估结果充分证明了Qwen2.5系列模型在各种任务上的卓越表现,尤其是在处理长上下文方面的突出能力。Qwen2.5不仅在标准基准测试中表现优异,还在实际应用中展现了处理复杂、长文本的强大能力,这为其在各种实际场景中的应用奠定了坚实基础。

五、总结

Qwen2.5系列模型的发布标志着大语言模型技术的又一重大进步。通过对预训练和后训练阶段的全面创新,Qwen2.5在多个方面都取得了显著突破:

-

预训练数据规模的飞跃:将训练数据从7万亿token扩展到18万亿token,为模型提供了更广泛、更深入的知识基础。

-

后训练技术的创新:采用包含100万样本的监督微调和分阶段强化学习,大幅提升了模型的指令遵循能力和人类偏好对齐程度。

-

长上下文处理能力的突破:特别是Qwen2.5-Turbo在处理百万级token的长文本时展现出的卓越性能,为长文档处理、复杂任务解决等应用开辟了新的可能。

-

多语言和多领域能力的增强:通过多样化的数据集和专门的训练策略,Qwen2.5在多语言理解、科学计算、编程等领域都表现出色。

-

模型系列的丰富性:从0.5B到72B参数的开源模型,以及Qwen2.5-Turbo和Qwen2.5-Plus等专有模型,为不同应用场景提供了灵活的选择。

Qwen2.5的成功不仅体现在其强大的性能上,更重要的是它展示了大语言模型技术发展的新方向。通过创新的数据处理方法、训练策略和架构设计,Qwen2.5实现了在模型大小和计算资源相对有限的情况下,达到甚至超越更大模型的性能。这种高效而强大的模型设计理念,对于推动AI技术的普及和应用具有重要意义。

六、如何系统学习掌握AI大模型?

AI大模型作为人工智能领域的重要技术突破,正成为推动各行各业创新和转型的关键力量。抓住AI大模型的风口,掌握AI大模型的知识和技能将变得越来越重要。

学习AI大模型是一个系统的过程,需要从基础开始,逐步深入到更高级的技术。

这里给大家精心整理了一份

全面的AI大模型学习资源,包括:AI大模型全套学习路线图(从入门到实战)、精品AI大模型学习书籍手册、视频教程、实战学习、面试题等,资料免费分享!

1. 成长路线图&学习规划

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

这里,我们为新手和想要进一步提升的专业人士准备了一份详细的学习成长路线图和规划。可以说是最科学最系统的学习成长路线。

2. 大模型经典PDF书籍

书籍和学习文档资料是学习大模型过程中必不可少的,我们精选了一系列深入探讨大模型技术的书籍和学习文档,它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。(书籍含电子版PDF)

3. 大模型视频教程

对于很多自学或者没有基础的同学来说,书籍这些纯文字类的学习教材会觉得比较晦涩难以理解,因此,我们提供了丰富的大模型视频教程,以动态、形象的方式展示技术概念,帮助你更快、更轻松地掌握核心知识。

4. 2024行业报告

行业分析主要包括对不同行业的现状、趋势、问题、机会等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

5. 大模型项目实战

学以致用 ,当你的理论知识积累到一定程度,就需要通过项目实战,在实际操作中检验和巩固你所学到的知识,同时为你找工作和职业发展打下坚实的基础。

6. 大模型面试题

面试不仅是技术的较量,更需要充分的准备。

在你已经掌握了大模型技术之后,就需要开始准备面试,我们将提供精心整理的大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以

微信扫描下方优快云官方认证二维码,免费领取【保证100%免费】

1671

1671

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?