作者 | Trisimo崔思莫 编辑 | 大模型之心Tech

原文链接:https://zhuanlan.zhihu.com/p/1938174154500215724

点击下方卡片,关注“大模型之心Tech”公众号

本文只做学术分享,如有侵权,联系删文,自动驾驶课程学习与技术交流群事宜,也欢迎添加小助理微信AIDriver004做进一步咨询

前言:Scaling Laws成立,不必然导向AGI,甚至会远离AGI。

——这是我的一个推论

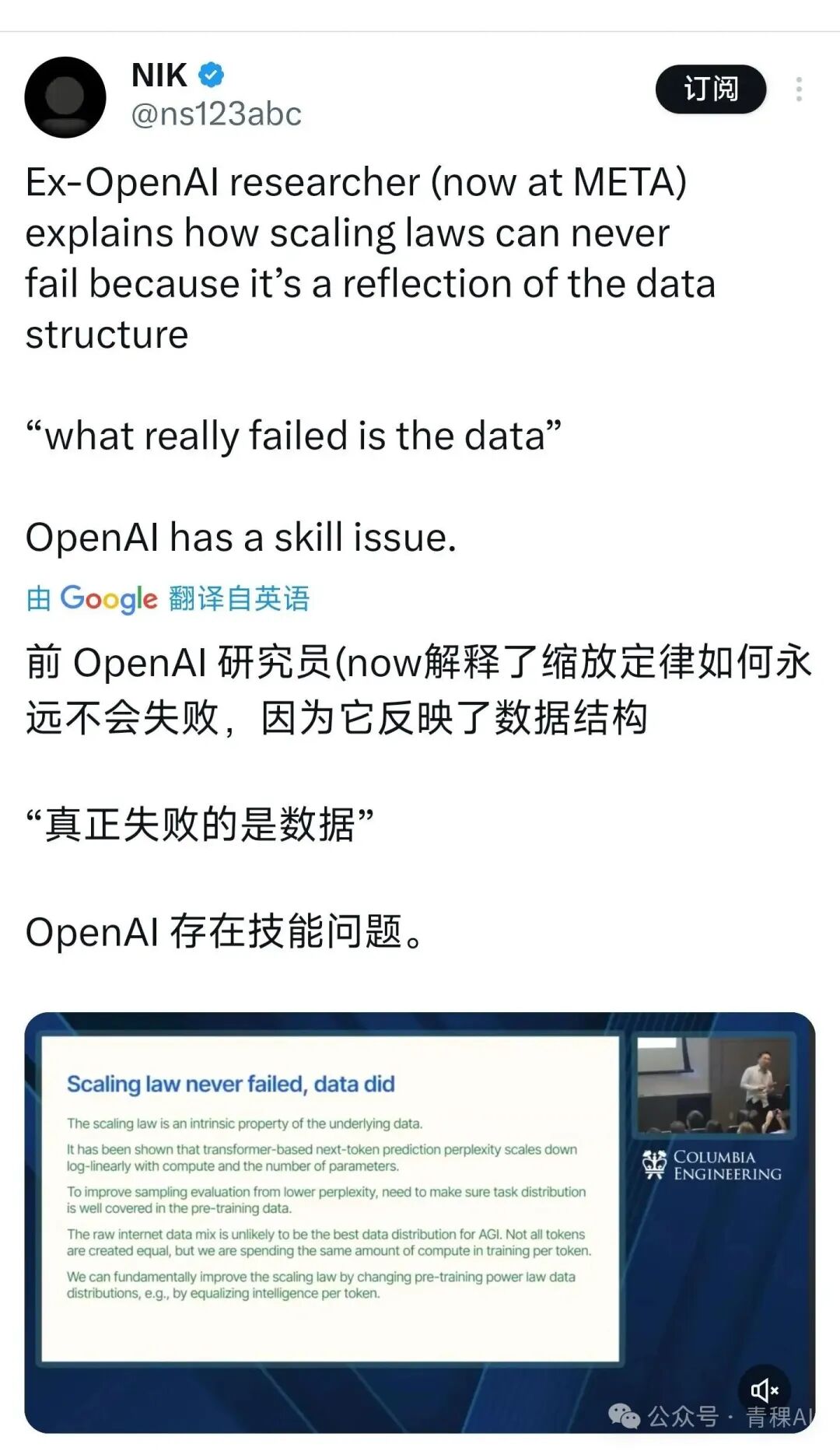

今天在推特看到了Nik转发的图。这是一个PPT,原文我会放在最后。

演讲者是——毕书超。

他的大意是:Scaling Laws永远不会失效,是因为数据不足,分布不合理,低价值数据匹配到了等价算力,让模型智力受阻。

我长话短说,因为很多东西,从去年下半年开始陆陆续续提到过。我主要建立一个推理逻辑:

1.互联网数据看似很多,实则很少

互联网数据就像村口一个大锅,熬了满满一锅粥(AI模型),但喝粥的人非常之多,消费者远远大于数据的贡献者,导致每个人能舀到自己的任务中的数据是极度稀疏的。通常就是"润色一下",把你的文本润色到一种"通用模式",但不能解决你的核心思考问题。

2.GPT-4的智能性是基础的 "语言智能"

GPT-4这代实际上已经把互联网数据基本吃光了,它所涌现出来的智能,是承载在基本语言表达方式的知识与智能。除了语言本身,它,并不精通某一行。

3.改变从Claude Opus 3 开始,Anthropic开始加入合成数据,Claude的野性得到收敛,代码能力开始出现。

4.到了Sonnet 3.5 模型尺寸相比较Sonnet 3小了很多,但由于合成数据密度更大,它在代码方面的能力变得更强。

5.这种现象到了GPT-5这里就达到极致,尺寸越来越小,专业性越来越强,通用性越来越差。

6.Scaling Laws没有失效,只是GPT-5把专业性做到了极致。这也是ChatGPT用户吵翻天的原因,那种依赖"通用性"的Chatting能力被削弱了。

7.由于模型厂的成本压力,一定会逐渐放弃通用性和超大模型,把智能堆到高价值领域,比如Coding这种盘子大利润高的领域,还有搜索领域可以想象出一个两万亿美元的估值。

8.这种高密度的合成数据暴力拉升模型的"模式匹配"能力,再配合高强度的RL,让模型在某一行表现出自动化水平。 但问题是,假设全球有1000个行业,能有几个像Coding和Search领域价值如此之高,能让本身成本就极高的AI公司垂青呢?

9.单个语言模型走向AGI这条路子天然受到了成本的限制。 我想,如果我们一直是以这种"你喂我吃"的深度学习的范式为主,而不是模型自主学习,那人工智能对全球的影响力会是有限的。

如果你对AGI抱有念想,可以多关Ilya Sutskever,Demis Hassabis,Rich Sutton,在坚持做底层研究的人。Dario Amodei看起来已经吊死在LLM上了。

——毕书超PPT——

Scaling law never failed, data did

The scaling law is an intrinsic property of the underlying data.

It has been shown that transformer - based next - token prediction perplexity scales down log - linearly with compute and the number of parameters.

To improve sampling evaluation from lower perplexity, need to make sure task distribution is well covered in the pre - training data.

The raw internet data mix is unlikely to be the best data distribution for AGI. Not all tokens are created equal, but we are spending the same amount of compute in training per token.

We can fundamentally improve the scaling law by changing pre - training power law data distributions, e.g., by equalizing intelligence per token.

大模型之心Tech知识星球交流社区

我们创建了一个全新的学习社区 —— “大模型之心Tech”知识星球,希望能够帮你把复杂的东西拆开,揉碎,整合,帮你快速打通从0到1的技术路径。

星球内容包含:每日大模型相关论文/技术报告更新、分类汇总(开源repo、大模型预训练、后训练、知识蒸馏、量化、推理模型、MoE、强化学习、RAG、提示工程等多个版块)、科研/办公助手、AI创作工具/产品测评、升学&求职&岗位推荐,等等。

星球成员平均每天花费不到0.3元,加入后3天内不满意可随时退款,欢迎扫码加入一起学习一起卷!

604

604

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?