点击下方卡片,关注“自动驾驶之心”公众号

今天自动驾驶之心为大家分享清华大学团队IROS'25中稿的工作!WHALES:支持多智能体调度的大规模协同感知数据集!如果您有相关工作需要分享,请在文末联系我们!

自动驾驶课程学习与技术交流群加入,也欢迎添加小助理微信AIDriver005

>>自动驾驶前沿信息获取→自动驾驶之心知识星球

论文作者 | Yinsong Wang等

编辑 | 自动驾驶之心

引言

自动驾驶技术在预防交通事故、提升交通效率与安全性方面展现出巨大潜力。然而,现有单车自动驾驶系统存在固有的感知局限性,特别是在处理非视距 (NLOS) 区域信息时,由于遮挡导致的感知盲区会带来潜在的安全风险。

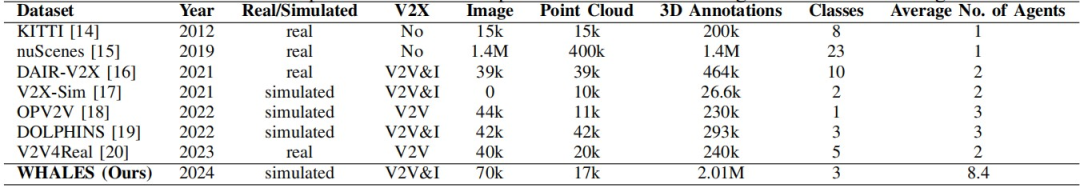

为克服这一挑战,研究人员提出了协同式驾驶 (Cooperative Autonomous Driving) 方案,通过车辆间无线通信实现信息共享,显著增强了系统在复杂场景下的安全性。尽管协同式感知为自动驾驶提供了广阔前景,但现有研究仍受限于数据集智能体数量的不足,无法充分探索智能体调度这一关键任务,从而制约了协同感知的实际落地应用。

为弥合此研究鸿沟,作者团队正式发布 WHALES (Wireless enHanced Autonomous vehicles with Large number of Engaged agentS),首个专门设计用于评估通信感知智能体调度与可扩展协同感知的大规模车联网数据集。数据集整合了详细的通信元数据,模拟真实场景中的通信瓶颈,为调度策略评估提供严格标准。为推动领域发展,作者团队提出覆盖范围自适应的历史调度算法 (Coverage-Aware Historical Scheduler, CAHS),这种新型调度基准通过基于历史视角覆盖度的智能选择机制,在感知性能上超越现有方法。WHALES成功弥合了仿真与真实车联网挑战之间的鸿沟,为探索感知-调度协同设计、跨数据泛化及扩展性极限提供了坚实框架。作者团队使用 MMDetection3D 实现了数据集,并提供了基线模型以及相应的性能指标。预处理流程集成了现有的智能体调度方法,使研究人员能够轻松地提出和评估新的调度策略。

论文标题:WHALES: A Multi-agent Scheduling Dataset for Enhanced Cooperation in Autonomous Driving

论文链接:https://arxiv.org/pdf/2411.13340

代码仓库:https://github.com/chensiweiTHU/WHALES

WHALES:支持多智能体调度的大规模数据集

核心特点与主要贡献

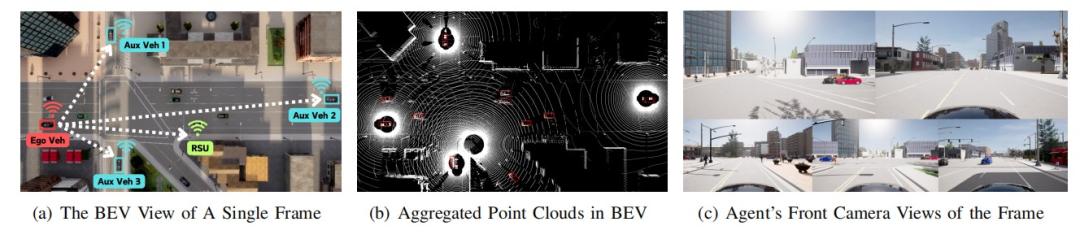

大规模多智能体协同环境:WHALES支持V2V和V2I感知,通过优化CARLA模拟器的速度和计算成本,实现了平均每个驾驶场景有8.4个协同智能体,包含17k帧LiDAR点云, 70k张图像和2.01M个有效3D标注框的大规模模拟。该数据集包含了超过2.01M个3D标注框,以及物体索引和智能体行为信息,使其具有很强的可扩展性。

创新性引入多智能体调度任务:WHALES支持3D目标检测和智能体调度等协同式驾驶任务。WHALES 是第一个将调度问题纳入协同感知的数据集。作者团队为这两个任务都提供了详细的基准,并分析了各种现有的单智能体和多智能体调度算法。

较低的时间成本:平均而言,每增加一个智能体只需要160ms,有效地将时间成本降至线性函数,使得数据集生成的时间和计算成本可以接受。

传感器和智能体配置

每个智能体都配备了传感器,包括一个64通道的LiDAR ,四个1920×1080的相机以及V2X通信设备。通过这种设置,它们可以执行感知和通信任务。

数据集中有四种类型的智能体:

非受控网联自动驾驶车辆:使用CARLA自动驾驶系统进行规划和控制。

受控网联自动驾驶车辆:可通过强化学习专家模型进行控制。

路侧单元 (RSU):安装在路边,配备LiDAR和摄像头,并能进行感知和规划。

普通智能体:没有传感器,轨迹非受控。

通过这种设置,能够评估协同对自动驾驶安全性和其他基准的增强作用。

强化学习专家模型进行规控

轨迹真值对自动驾驶模型至关重要,但是基于规则的CARLA pilot过于保守,无法探索智能体行为的多样性。为了更好地生成轨迹,作者团队继承了Roach的强化学习环境,利用强化学习专家模型生成更高质量的轨迹。该强化学习模型以自身BEV的真实值作为输入,并输出控制信号(油门、刹车和转向)给车辆。然后,另一个深度学习模型通过模仿学习训练,以近似在理想观测条件下的真实车辆行为。为了在后续任务中进行扩展,本车的行为和奖励函数存储在标签中。

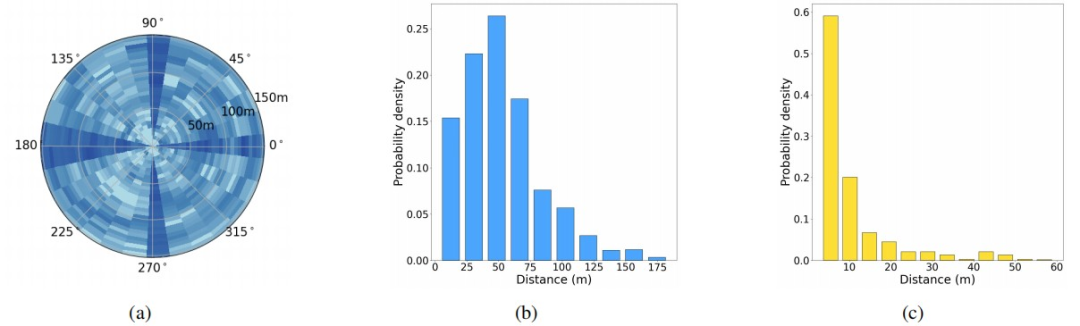

数据分析

自车周围的边界框分布在各种方向上,由于道路方向的限制,许多物体与自车方向平行或垂直对齐。大多数车辆彼此靠近,提供互补的视野,而一些车辆则相距较远,以提供长距离信息。WHALES的数据存储格式遵循nuScenes数据集,除了现有的nuScenes标签外,还包括了用于协同感知任务的新标签,例如智能体之间的距离和遮挡关系图。

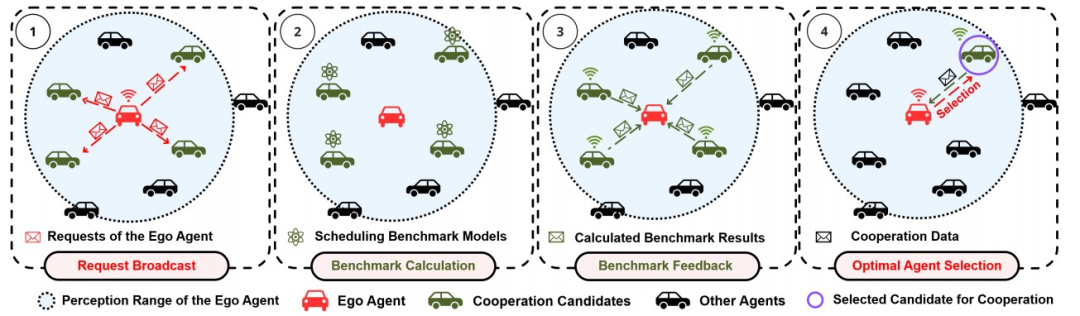

WHALES支持的调度算法

WHALES支持的调度算法包括全通信 (Full Communication)、最临近调度 (Closest Agent)、随机调度 (Single/Multiple Random)、移动条件下协作车辆选择算法 (Mobility-Aware Sensor Scheduling, MASS) 以及作者团队提出的CAHS算法。CAHS调度算法是一种新型调度方法,根据本车感知范围内的历史视角覆盖率对智能体进行优先级排序。通过握手机制,CAHS能够动态选择具有最大空间相关性的候选对象。

全通信算法允许本车从所有其他智能体获取数据,这种理想化场景可视为感知性能的上限,而No Fusion则对应下限。

最临近调度算法采用更直接的方式,仅通过距离不依赖历史信息来选择最近智能体。

随机调度算法从环境中随机选取一个智能体作为通信对象。

MASS算法通过结合车辆动态特性与Upper置信边界 (UCB) ,能够实现去中心化调度并最大化感知增益。

CAHS算法(本文提出)会选择候选车辆中,在上一帧范围内为其本车提供最多边界框数量的车辆,该机制可通过握手协议实现。具体而言,对于候选智能体 ,定义其奖励 定义为先前检测结果与本车过去感知范围 相交的数量:

最后本车选择相交数量最多的智能体进行通信:

实验结果

作者团队在WHALES数据集上进行了三种类型的实验,所有模型都在8个NVIDIA GeForce RTX 3090 GPU上训练,对于每个任务以8:2的比例分为训练集和测试集。所有模型都训练了24个epoch,基础学习率为0.001。实验在50米和100米的检测范围内训练和测试。每次传输的数据量限制为每帧2MB。

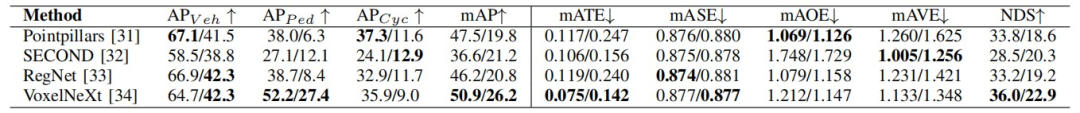

独立 3D 目标检测 (Stand-alone 3D Object Detection):使用Pointpillars、RegNet和SECOND等主流模型进行实验。结果表明,在100米的检测范围内,性能显著下降,这强调了协同在增强长距离感知方面的重要性。

协同 3D 目标检测 (Cooperative 3D Object Detection):通过使用不同的融合方法(如原始数据级融合和特征级融合),协同模型在检测性能上显著优于单车独立模型。与基线相比,F-Cooper在50米和100米下mAP分别提高了19.5%和38.4%,而VoxelNeXt则分别提高了25.7%和81.3%。

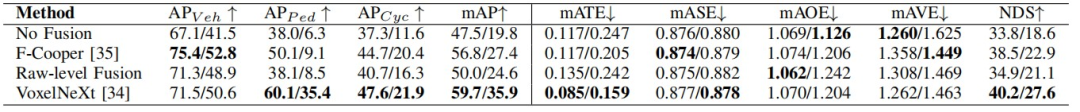

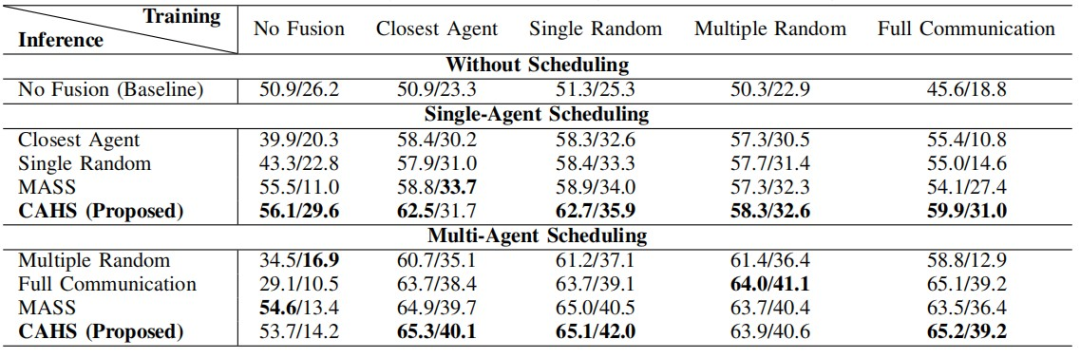

智能体调度 (Agent Scheduling):这是WHALES数据集引入的一项新任务。单智能体调度部分展示了当本车选择单一协同对象时各策略的性能表现,而多智能体调度部分则涉及在协同场景中协调两个及以上智能体的调度算法。

研究发现,Historical Best和MASS算法在单智能体调度中表现最好。同时,使用随机训练策略的模型比确定性训练策略的模型表现更好,因为它能生成更多样化的输入,从而在有限的训练周期内更好地泛化。

结论

作者团队提出了WHALES数据集,包含1.7万帧激光雷达数据、7万张RGB图像及总计201万个三维标注数据,旨在推动自动驾驶领域中协同式感知和调度研究的进展。通过深度学习模型同步智能体进程,显著提升了CARLA仿真系统的数据生成速度。作者团队还建立了三维目标检测与智能体调度的基准测试体系,充分展现数据集的优势。此外,WHALES还支持智能体行为的可控性,为智能体交互与控制策略研究提供可能。未来将基于该数据集构建模块化、端到端的自动驾驶系统,进一步拓展感知协同之外的协同应用,并评估协同带来的安全性能提升。

自动驾驶之心

论文辅导来啦

自驾交流群来啦!

自动驾驶之心创建了近百个技术交流群,涉及大模型、VLA、端到端、数据闭环、自动标注、BEV、Occupancy、多模态融合感知、传感器标定、3DGS、世界模型、在线地图、轨迹预测、规划控制等方向!欢迎添加小助理微信邀请进群。

知识星球交流社区

近4000人的交流社区,近300+自动驾驶公司与科研结构加入!涉及30+自动驾驶技术栈学习路线,从0到一带你入门自动驾驶感知(大模型、端到端自动驾驶、世界模型、仿真闭环、3D检测、车道线、BEV感知、Occupancy、多传感器融合、多传感器标定、目标跟踪)、自动驾驶定位建图(SLAM、高精地图、局部在线地图)、自动驾驶规划控制/轨迹预测等领域技术方案、大模型,更有行业动态和岗位发布!欢迎加入。

独家专业课程

端到端自动驾驶、大模型、VLA、仿真测试、自动驾驶C++、BEV感知、BEV模型部署、BEV目标跟踪、毫米波雷达视觉融合、多传感器标定、多传感器融合、多模态3D目标检测、车道线检测、轨迹预测、在线高精地图、世界模型、点云3D目标检测、目标跟踪、Occupancy、CUDA与TensorRT模型部署、大模型与自动驾驶、NeRF、语义分割、自动驾驶仿真、传感器部署、决策规划、轨迹预测等多个方向学习视频

学习官网:www.zdjszx.com

1540

1540

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?