点击下方卡片,关注“自动驾驶之心”公众号

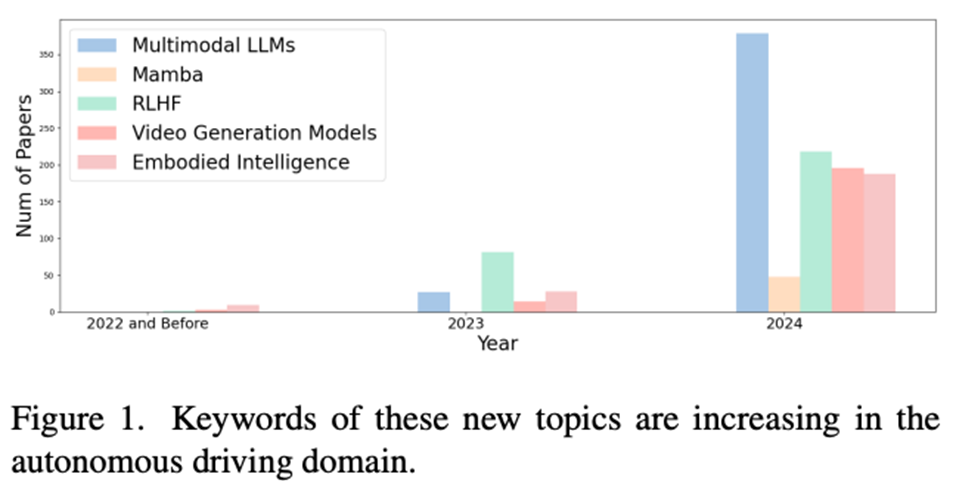

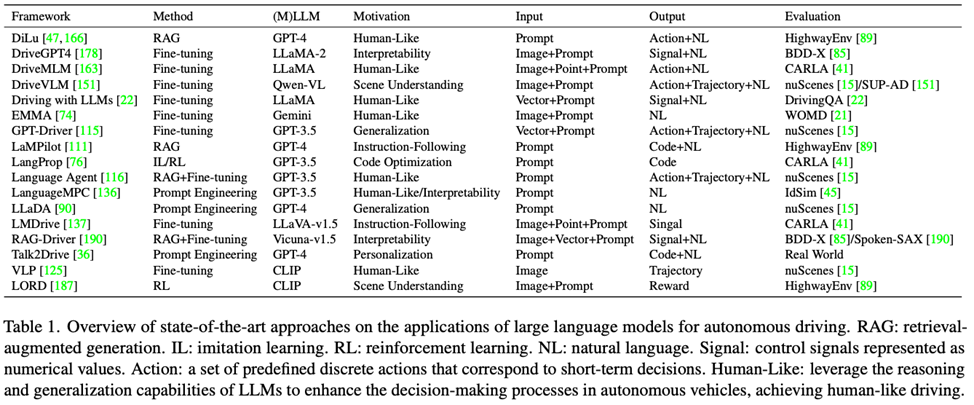

近日,第三届大型语言与视觉模型自动驾驶研讨会(LLVM-AD 2025)在WACV 2025会议成功举办!作为连接AI技术与自动驾驶领域的重要桥梁,本次研讨会汇聚了全球顶尖专家学者,共同探讨前沿技术与未来发展方向。基于本次研讨会的内容,团队发布了一篇Position Paper: Position: Prospective of Autonomous Driving - Multimodal LLMs, World Models, Embodied Intelligence, AI Alignment, and Mamba 讨论了自动驾驶未来的重点方向。

Link: Position: Prospective of Autonomous Driving - Multimodal LLMs World Models Embodied Intelligence AI Alignment and Mamba

LLVM-AD研讨会介绍

LLVM-AD研讨会致力于促进大型语言模型与计算机视觉技术在自动驾驶领域的创新应用。随着人工智能技术的迅猛发展,如何有效利用这些技术突破自动驾驶的关键挑战,成为学术界与产业界共同关注的焦点。首届研讨会在WACV 2024举办,本次研讨会是LLVM-AD的第三届,共展示了共十篇精选论文,涵盖场景理解、轨迹预测、多模态融合、感知系统优化等自动驾驶核心技术。每篇论文均安排8分钟展示与2分钟问答环节,确保深入而高效的学术交流。

最佳论文奖揭晓:经LLVM-AD评审委员会严格评选,本届研讨会最佳论文奖授予”Query3D: LLM-Powered Open-Vocabulary Scene Segmentation with Language Embedded 3D Gaussians”,该论文创新性地将大型语言模型与3D高斯表示相结合,实现了开放词汇的场景分割,为自动驾驶感知系统带来了全新解决方案。

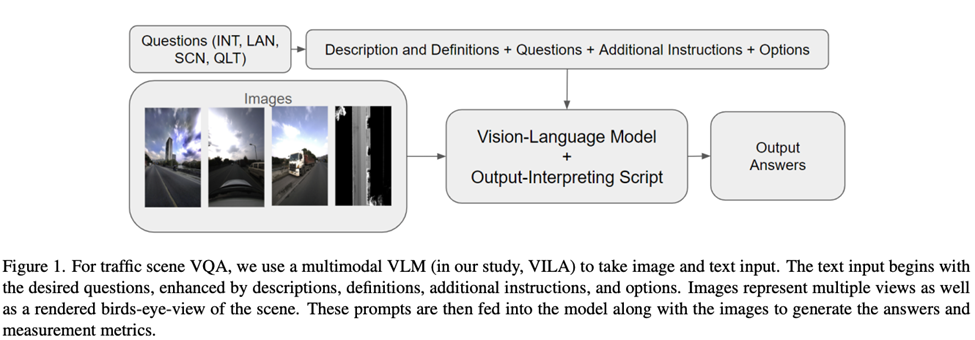

最佳挑战论文奖:”Evaluating Multimodal Vision-Language Model Prompting Strategies for Visual Question Answering in Road Scene Understanding ”荣获最佳挑战论文奖,该研究系统评估了多模态视觉-语言模型在道路场景理解中的提示策略,为自动驾驶系统中的视觉问答任务提供了重要参考。

开放数据集挑战:研讨会重磅推出面向真实世界高精地图理解的开放数据集MAPLM-QA v2.0挑战,包含丰富的多样化交通场景,旨在促进自动驾驶感知算法的公平比较与快速迭代。该挑战将为参与者提供宝贵的实验平台,推动算法从实验室走向实际应用环境。

顶级学者分享前沿研究

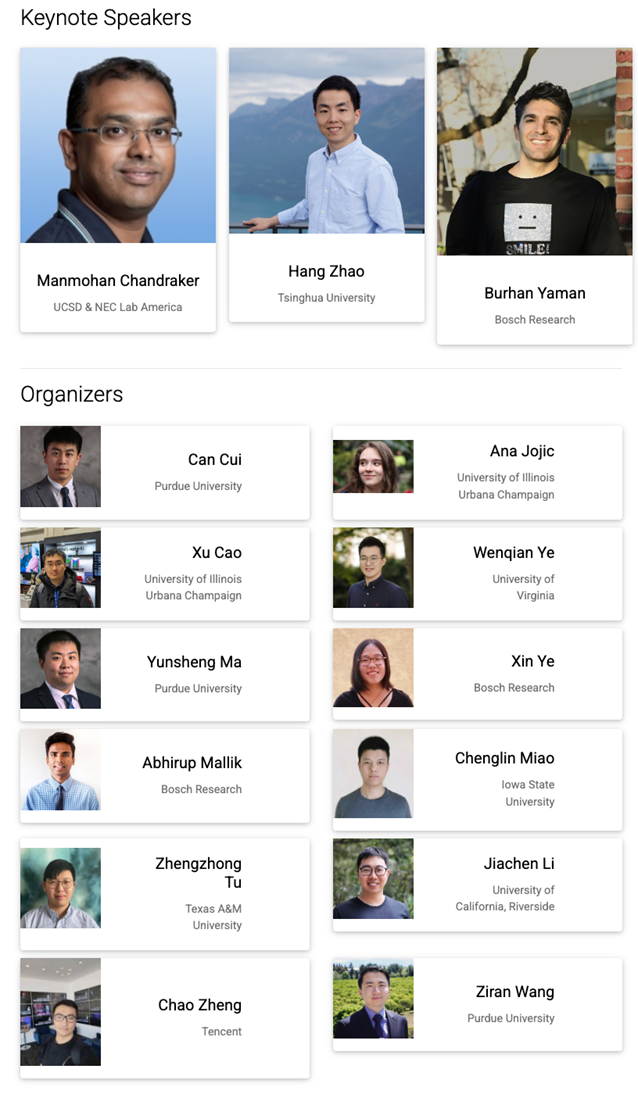

三位来自学术界与产业界的国际知名专家带来了精彩纷呈的主题演讲:

Burhan Yaman博士(博世研究院):Representation Alignment for Autonomous Driving深入探讨了如何通过表示学习优化自动驾驶感知系统,解决数据多样性与模型泛化能力的关键问题,提供了弥合算法研究与实际部署差距的新思路。

Manmohan Chandraker博士(UCSD & NEC美国实验室):Towards Safe Open-World Autonomy分享了在开放、动态环境中构建高可靠性自动驾驶系统的最新研究成果,特别关注如何处理边缘情况和未知场景,为自动驾驶安全保障提供了理论与技术支撑。

Hang Zhao博士(清华大学):Fast-Slow Dual Autonomous Driving Systems创新性地提出了结合快速反应与深度规划的自动驾驶架构,平衡了实时性与决策质量的关系,展示了自动驾驶系统设计的新范式。

🌐 更多研讨会详情,请访问官方网站:https://llvm-ad.github.io/

509

509

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?