扩散策略:重新定义机器人智能控制的未来

具身智能,作为机器人学习与人工智能紧密交织的前沿交叉领域,正以一种颠覆性的姿态重新诠释着智能机器人与环境之间的交互模式。在这一领域中,扩散策略通过将扩散模型的创新性原理引入运动控制,开创了一种全新的范式。其核心机制是通过精妙的逐步去噪过程,生成精确的机器人动作序列。这一过程恰似一位技艺精湛的工匠,从一块粗糙的原石开始,经过精心雕琢,逐渐使其成为一件精美的艺术品。在复杂任务的执行中,扩散策略的独特优势展露无遗。例如,当机器人需要在复杂的迷宫环境中规划路径,或机械臂需要将物体精准放置到指定位置等强调终点约束的任务中,扩散策略能够一次性生成完整的运动轨迹,既保证了路径的连续性,又确保了终点的精确性,充分体现了其在目标导向控制方面的卓越性能。正因如此,扩散策略已毫无争议地成为模仿学习(Imitation Learning)领域中最具潜力与发展前景的方法之一。

扩散策略的发展历程令人瞩目。最初的 Diffuser 作为先驱,率先将扩散模型的理念引入机器人领域。尽管在当时存在诸多不足,但为后续的研究开启了新的方向。随后,Diffusion Policy 的提出成为该领域的第一个里程碑。通过直接对机器人动作进行建模,Diffusion Policy 使得机器人能够更加逼真、灵活地执行任务,并展现出多样化的动作模式。在多个仿真环境(如 Robomimic、Franka Kitchen)和 UR5 真机任务中,Diffusion Policy 相比现有最先进方法取得了平均 46.9% 的性能提升,同时实现了超过 100Hz 的控制频率。

最近,扩散策略大模型 RDT(Robotic Diffusion Transformer)的诞生,更是为该领域带来了新的突破。作为迄今最大规模的扩散策略模型,RDT 拥有 12 亿参数量,创新性地提出了物理可解释的统一动作空间,使其能够在不同机器人平台间迁移物理知识。通过在海量多机器人数据集上预训练,RDT 展现出了强大的零样本泛化能力,能够适应未见过的物体和场景,理解并遵循语言指令,仅需 1-5 个示例即可学习新技能,并能有效处理复杂的双臂操作任务。

值得注意的是,扩散策略的应用范围正在不断扩大。除了机器人操作任务,它在自主导航、灵巧手抓取等领域也展现出了良好的潜力。其独特优势在于能够根据实时的环境约束,动态生成符合约束的动作轨迹,显著提升了任务完成的成功率。最近火热的流策略(flow policy)亦是在扩散模型基础上的进一步演进,扩散模型在复杂环境下的适应性和任务完成能力已经得到了充分验证。

在扩散策略的技术体系中,从基础的状态扩散策略Diffuser开始,经过Decision Diffuser的发展,以及动作扩散策略(Diffusion Policy)的提出,扩散策略不断完善其理论框架。利用扩散模型本身作为数据生成器自适应自进化的AdaptDiffuser与MTDIFF的出现则开创了新的技术方向。与此同时,链式扩散器ChainedDiffuser和基于score function的BESO等方法的提出,进一步拓展了扩散策略的应用范围。

同时,比较重要的一个分支是扩散策略在三维空间应用上的扩展。从基础的3D Diffusion Policy到更先进的3D Diffuser Actor,再到结合几何先验的GenDP和G3Flow,扩散策略在复杂三维环境中的应用变得更加可靠和高效。

而等变扩散策略(Equivariant Diffusion Policy)、安全扩散策略(FISOR)以及扩散策略与在线强化学习的结合,都为这一领域带来了新的研究方向。

扩散策略的重要性

在学术界和工业界,扩散策略都已展现出丰富的应用。学术界的MIT、UC Berkeley、Stanford等顶尖实验室正在积极推进扩散策略的理论研究和算法创新;而在工业界,从Boston Dynamics、Toyota Research等机器人公司到Google、Meta等科技巨头,扩散策略已经在机械臂控制、工业自动化、精密装配等领域展现出巨大潜力。它不仅提高了机器人动作的精确度,还大大提升了系统的鲁棒性和适应性。

这种技术正在改变传统工业自动化的面貌,为智能制造注入新的活力。这一技术方向已经且预计在未来5年内保持高速发展,成为连接AI大模型与实体机器人的关键桥梁,有望解锁更多复杂机器人操作任务,推动具身智能进入新的发展阶段。

首个Diffusion Policy算法与实战课程

Diffusion Policy的知识体系较为庞大,范式多,很多小白想入门并不是那么简单,甚至会踩很多坑。如果没有一个完整的知识体系支撑,往往半年都难找到正确的学习方法。具身智能之心联合业内知名算法专家,自研了一套国内首个面向具身智能diffusion policy的算法与实战课程。

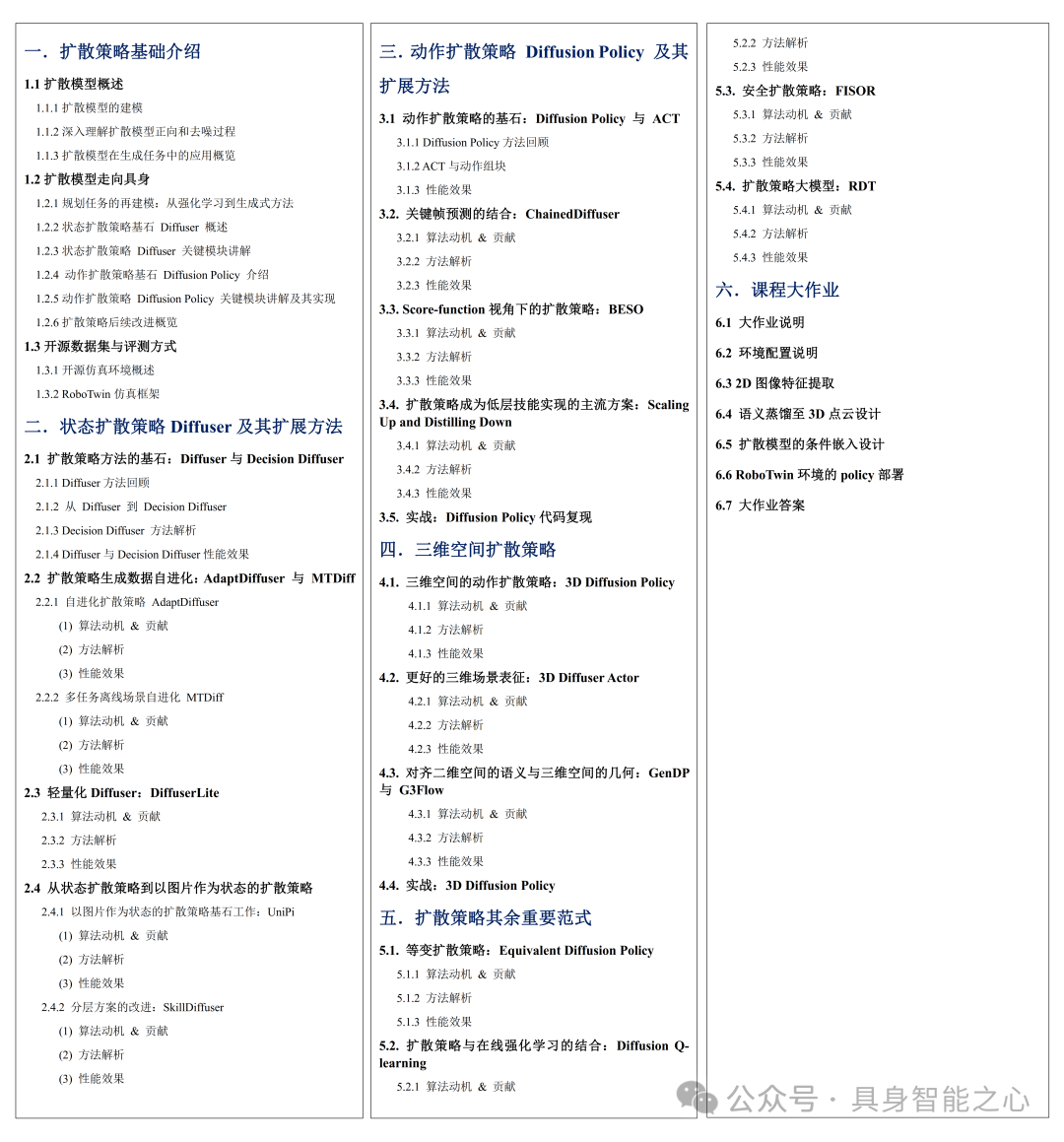

本课程将基于RoboTwin这一先进的双臂机器人数字孪生仿真环境进行实践。通过这个平台,学员能够直观地理解和实现各类扩散策略算法,从而掌握扩散策略在实际机器人控制中的应用方法。让大家从0到1真正掌握扩散策略与具身机器人的各种技巧,助力科研和求职。课程大纲如下:

主讲老师

Mark,香港大学博士,在智能机器人和人工智能领域具有深厚的学术背景和丰富的实践经验。曾在多个顶级会议:NIPS、ICLR、CVPR、ICML、ICRA和IROS上发表研究。丰富的具身智能实战和研究经验,运用生动的案例和互动式教学,帮助学员深入理解复杂概念,激发对该领域的兴趣与探索。

Herry,香港大学博士生,研究方向为具身智能和生成式模型。在CVPR、ICML等机器学习国际顶会上发表研究。在扩散策略方面有多项原创成果,在具身智能算法设计和模型部署等方面具有丰富经验。

适合人群

机器人领域尤其是机械臂操作方向的从业人员,需要进一步进阶提升;

从事具身智能研究的本科、硕士、博士生;

希望从传统机器人控制或计算机视觉领域转向具身智能的专业人士;

对机器人学习与扩散策略感兴趣的工程师和研究人员;

工业机器人相关企业的技术骨干和研发人员。

学后收获

能够掌握扩散策略的基本原理和技术框架;

了解从状态扩散策略到动作扩散策略的完整技术体系;

掌握多种扩散策略算法的实现方法和调优技巧;

能够在RoboTwin仿真环境中开发和测试扩散策略;

了解扩散策略在三维空间中的应用方法和技术挑战;

获得将扩散策略应用于实际机器人系统的实践经验;

无论是工程落地还是科学研究都能有所收获;

学习课程后,达到1-2年左右扩散策略从业经验。

学习基础

一定的深度学习和矩阵论基础;

一定的python和pytorch编程基础;

对具身智能与机器人领域有一定了解;

显卡建议3090及以上,20G显存;

课程说明

课程为离线视频,微信群内答疑。由于课程为虚拟商品,购买后不支持退款。自购买日起,一年内有效,支持反复观看。已经购买课程的同学,欢迎添加小助理微信邀请进课程答疑群。

咨询我们

新课优惠中,扫码学习课程

更多咨询小助理

版权说明

课程所属视频和课件,归具身智能之心团队所有。我们谴责所有盗版行为,一经发现,我们将第一时间寄出律师函。

827

827

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?