作者 | lovely_yoshino 编辑 | 古月居

点击下方卡片,关注“自动驾驶之心”公众号

ADAS巨卷干货,即可获取

点击进入→自动驾驶之心【多传感器融合】技术交流群

本文只做学术分享,如有侵权,联系删文

0. 简介

作为无人车以及智能机器人而言,在装配过程中各个传感器之间的外参标定一直是比较头疼的问题。这里作者也系统的学习了一下,传感器的外参标定和在线标定问题。

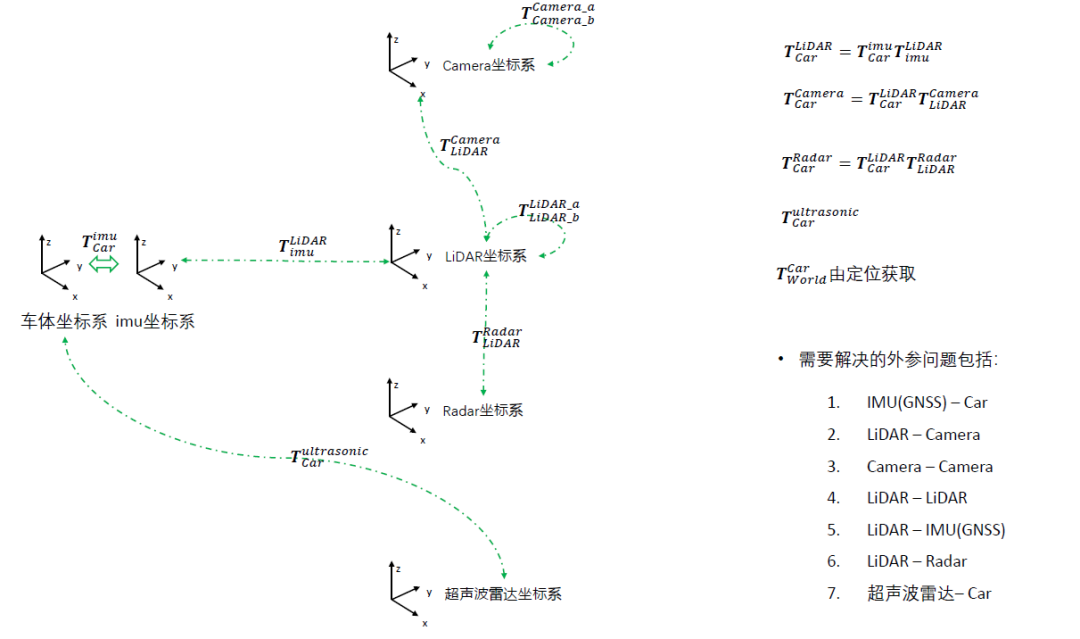

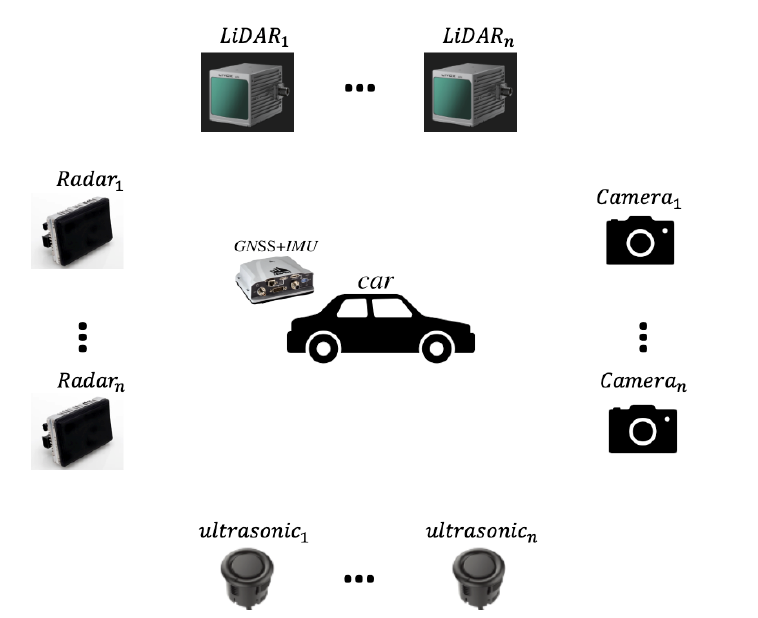

下图是我们常用的几个坐标系,而对于常用的外参问题经常是IMU/GNSS与车体坐标的外参、Lidar和Camera的外参、Lidar和Lidar的外参、Lidar和IMU/GNSS的外参。

1. 离线外参标定

1.1 IMU/GNSS与车体外参标定

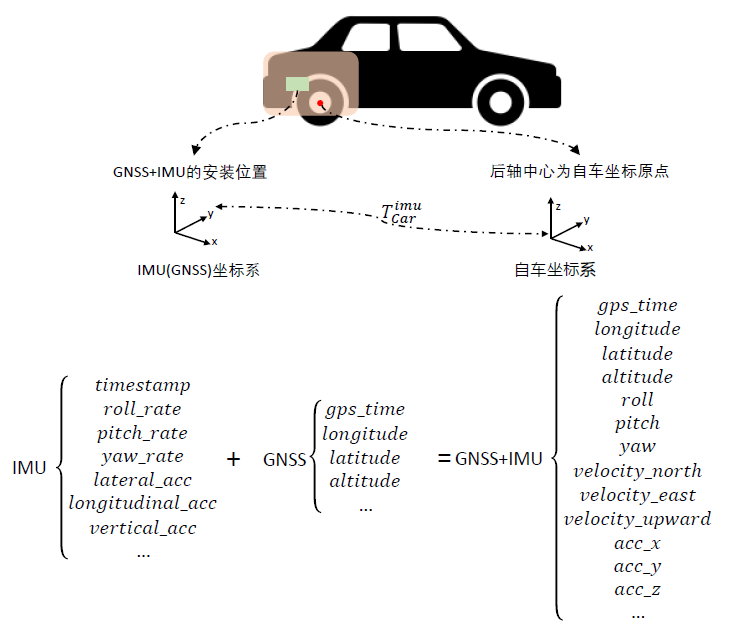

这个IMU/GNSS与车体外参标定如下图所示,主要需要获取$T_{car}^{imu}$坐标系,这一类IMU/GNSS设备通过内部的紧耦合可以综合输出一系列校准后的位姿信息。

同时IMU的输出频率是很高的,所以通过插值的形式可以有效地提高整体综合的频率输出。

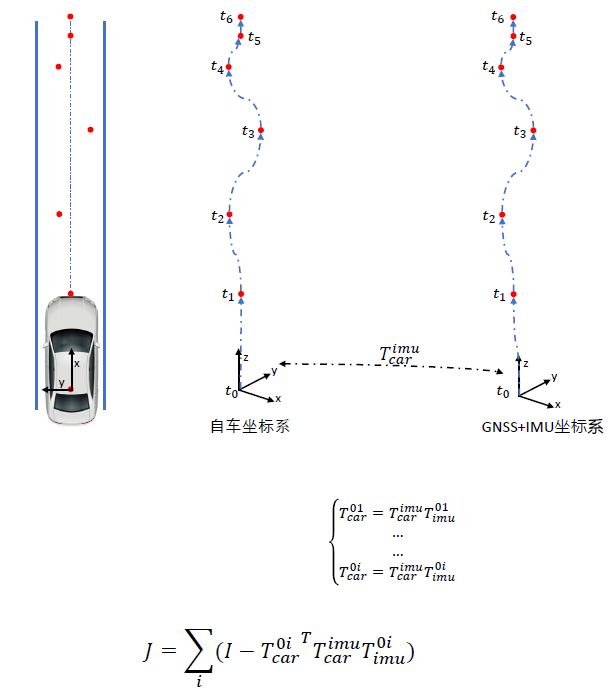

为了去标定外参,一般的方法是获取位姿运动的位姿序列,并通过GNSS/IMU来观测车辆自身的运动(有的时候我们可以通过绕圈的形式+手持点测绘来对车辆自身坐标和GNSS坐标进行匹配计算)。

通过获取很多个观测和gnss的转换可以得到cost fuction参与到里面去优化。

这里我们也给出了基于车体坐标系odom和IMU的位姿联合矫正的相关代码,考虑到IMU和轮速计的数据收集过程中本身在时间上就很难做到完全对齐,此时引入时间偏移(delta_t)用于表示两者采集时间片之间的误差,通过循环标定新产生的轮速计数据和原先的IMU 数据,选取误差最小的结果作为最终两者之间的标定,相应的(delta_t)即认为两者采集时间的偏差。

参考链接:

https://github.com/smallsunsun1/imu_veh_calib

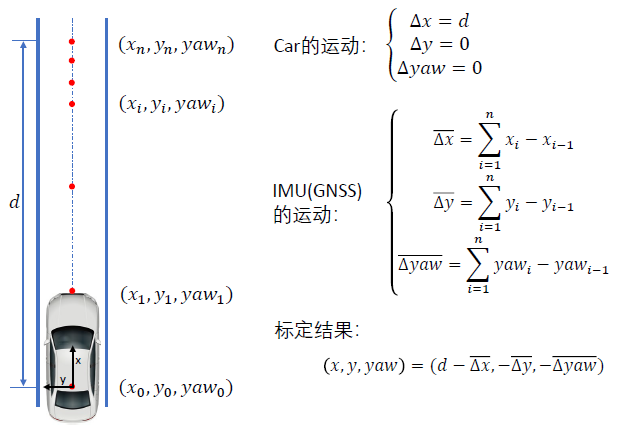

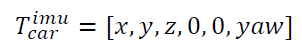

其实作为车辆来说,在平面测量后,其实只需要观测$x,y,yaw$即可。所以可以将用直线来做约束和校准,得到下图的公式:

1.2 Camera 与 Camera 外参标定

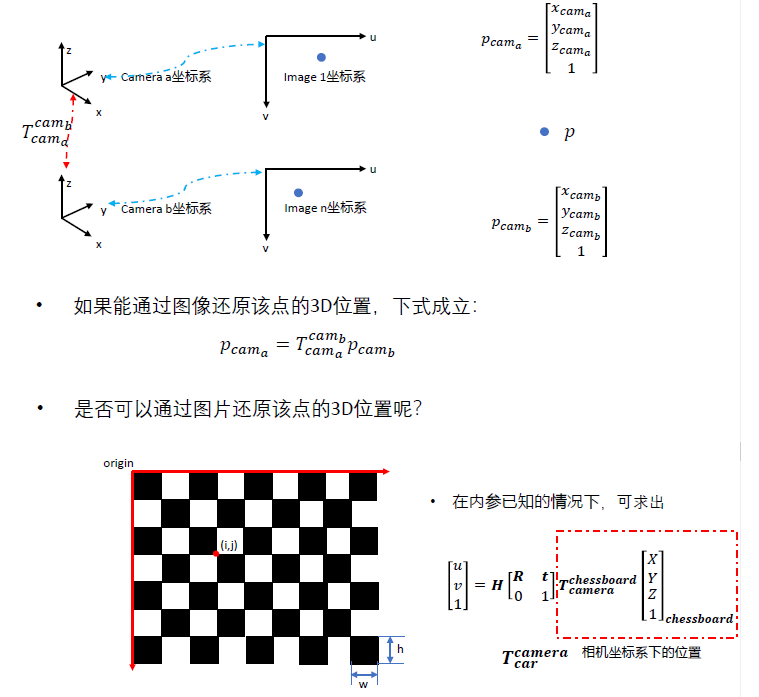

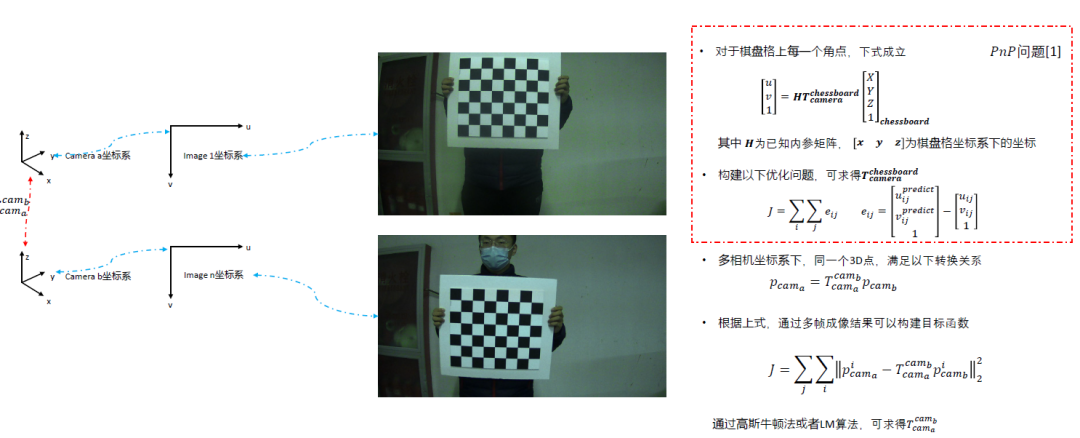

作为相机与相机之间的标定,其本质和双目摄像头的标定步骤类似,通过拿到的图像信息来还原点在3D空间下的位置。如果获取两个相机与点的转换关系就可以得到$T_{cam_a}^{cam_b}$的坐标系变换。

然后根据棋盘格的坐标系转换就可以得到同一个点通过内参+外参后转到的$uv$坐标系下的情况,然后利用PNP非线性优化得到旋转平移矩阵$T_{camera}^{chessboard}$。然后通过多帧来综合约束$T_{cam_a}^{cam_b}$。

这里是经常使用的方法,Opencv也有自带的方法,代码如下:

参考链接:

https://github.com/sourishg/stereo-calibration

1.3 Lidar 与 Camera 外参标定

雷达和相机的校准作为自动驾驶中最为重要的部分,其主要分为雷达的三维点位姿估计和相机的像素点的三维点位姿估计。

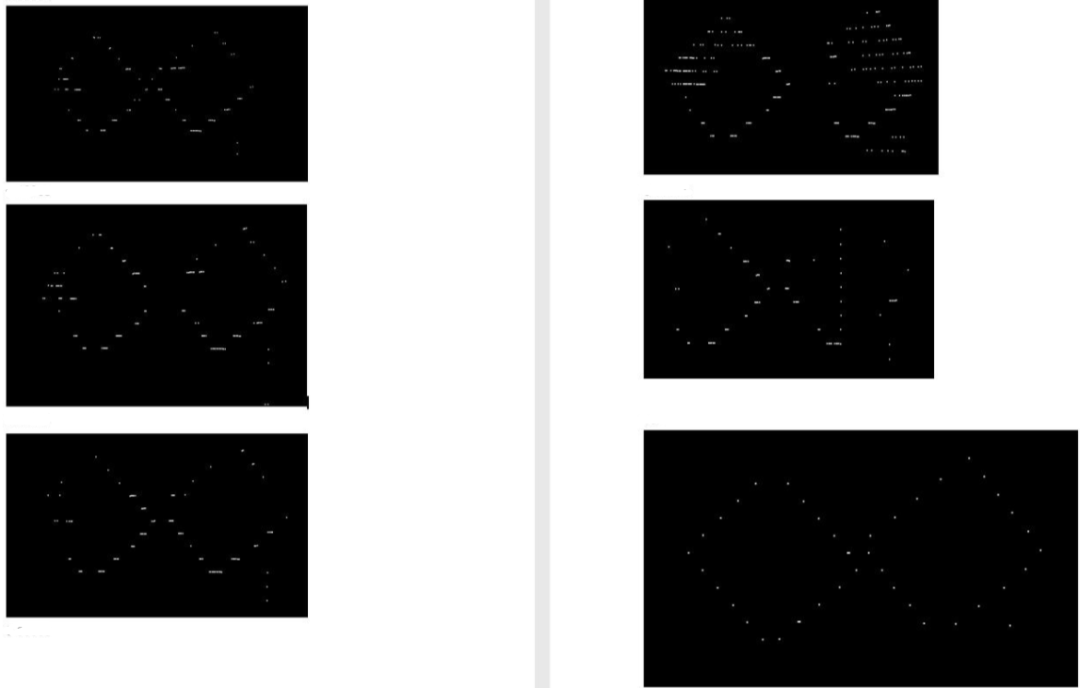

这里我们可以看到其核心思想仍然是获取三维点的方式来完成对应。这里当然会因为Lidar存在扫描导致的误差造成的角点提取不准的原因,例如我们使用这类方法。

可以看到不同的激光得到了不一样的角点提取效果,因此我们可以通过角点拟合的方法去实现,比如说我们可以通过Ransec提取出空间中的标定板的位置区域,并获得初步的位移量,然后在标定板中存在几个凸起,并通过分割和聚类的方法提取出凸起的中心点,并将点与最近的点进行映射,得到$T_{lidar}^{chessboard}$。

然后摄像头可以通过标定板来预估出$T_{camera}^{chessboard}$,然后这两个通过$chessboard$的Lidar和Camera求得旋转的TF坐标系。

参考链接:

1.2D标定板:

https://github.com/TurtleZhong/camera_lidar_calibration_v2

2.3D标定板:

https://github.com/heethesh/lidar_camera_calibration

3.镂空标定板:

https://github.com/beltransen/velo2cam_calibration

4.球体标定:

https://github.com/545907361/lidar_camera_offline_calibration

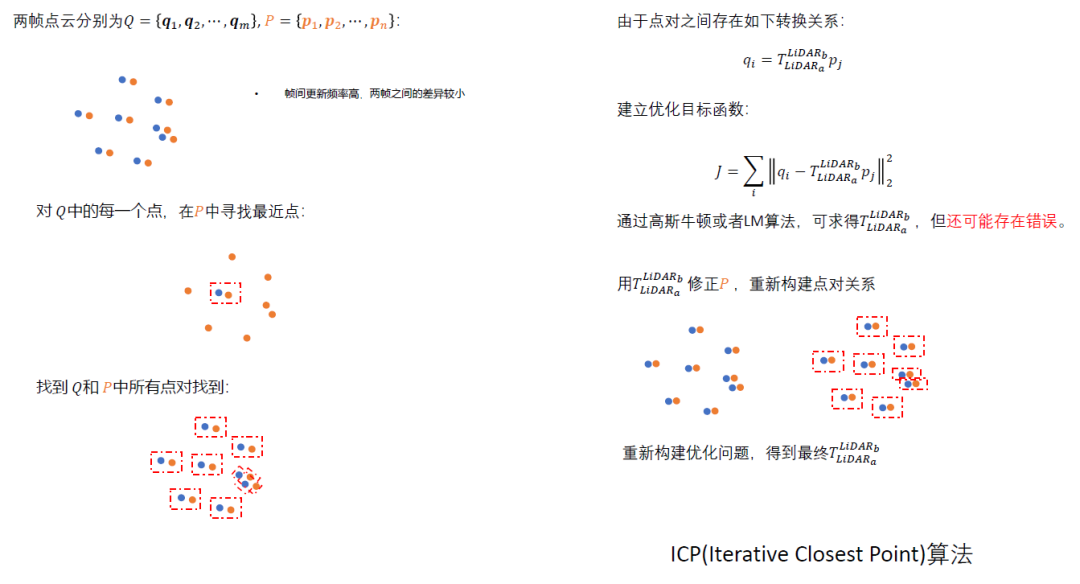

1.4 Lidar 与 Lidar 外参标定

Lidar与Lidar的标定其实就是两个点云校准配对的方式,一般使用PCL库即可。这个在之前的博客中已经详细说过了,这里也不再展开说了。

参考链接:

2D雷达:

https://hermit.blog.youkuaiyun.com/article/details/120726065

https://github.com/ram-lab/lidar_appearance_calibration

3D雷达:

https://github.com/AbangLZU/multi_lidar_calibration

https://github.com/yinwu33/multi_lidar_calibration

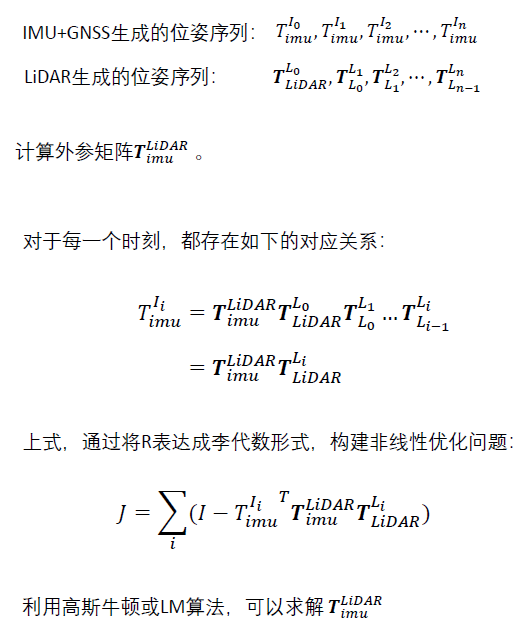

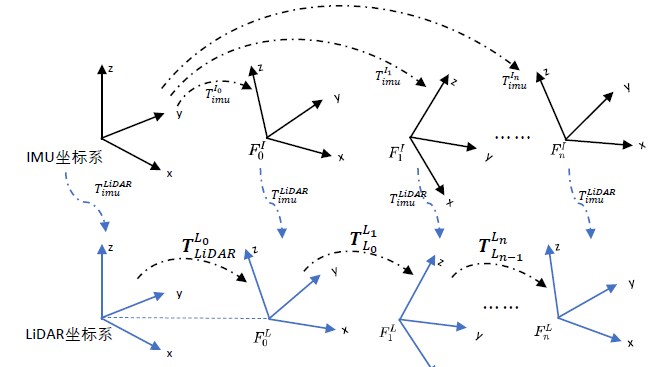

1.5 Lidar 与 IMU/GNSS 外参标定

Lidar和IMU/GNSS的外参标定和车体外参的外参标定类似,都可以通过相对位移来估算出位姿态变化,从而实现对齐。

当然近年来也有一些比较好的开源方案供我们参考和选择:

参考链接:

https://github.com/APRIL-ZJU/lidar_IMU_calib

https://github.com/chennuo0125-HIT/lidar_imu_calib

https://github.com/FENGChenxi0823/SensorCalibration。

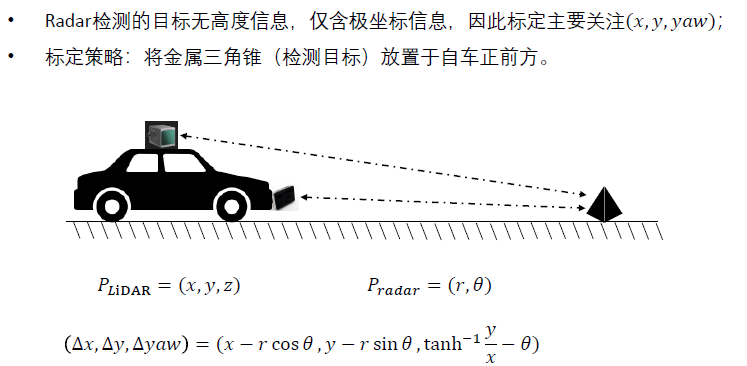

1.6 Lidar 和 Radar 外参校准

与其他不一样的是,Radar只有极坐标信息,没有高度信息。所以很多时候Radar和Lidar的标注只需要标定$x,y,yaw$信息。

而Radar对三角锥标注更敏感,所以这也会导致我们的结果更准确一些。

当然也可以使用一些配准的方法来实现标定的功能。

参考链接:

https://github.com/keenan-burnett/radar_to_lidar_calib

https://github.com/gloryhry/radar_lidar_static_calibration

1.7 数据同步

数据同步作为所有传感器外参标定后需要做的步骤,作者也多次撰文写过这方面的工作(https://hermit.blog.youkuaiyun.com/article/details/120489694),这里发现一个开源解决方案(https://github.com/lovelyyoshino/sync_gps_lidar_imu_cam),一并贴上来。

2. 在线外参标定

在车辆运行期间,动态修正传感器之间的相对位姿参数。与离线标定不同,在线标定不能摆场景(如标定板),因此难度更大。其原因在于在车辆运行期间,传感器的安装位置因为振动或者外力碰撞会发生变化,以实现在当参数异常时发出报警。

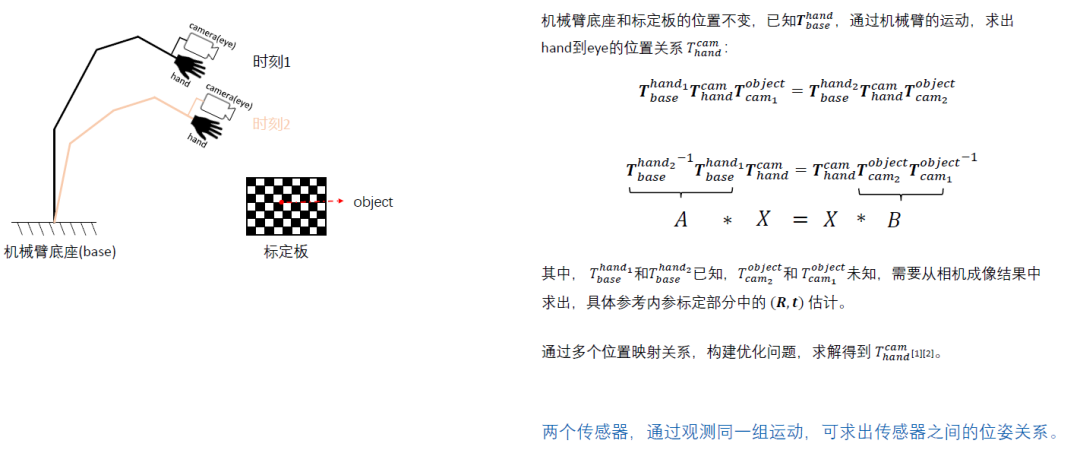

2.1 手眼标定

手眼标定这一块的工作作者也在文章中讲过,通过形成$AX=XB$的形式来估算出当前的情况。这里是Lidar和RTK的手眼标定方案(https://github.com/liyangSKD/lidar_rtk_calibration)。

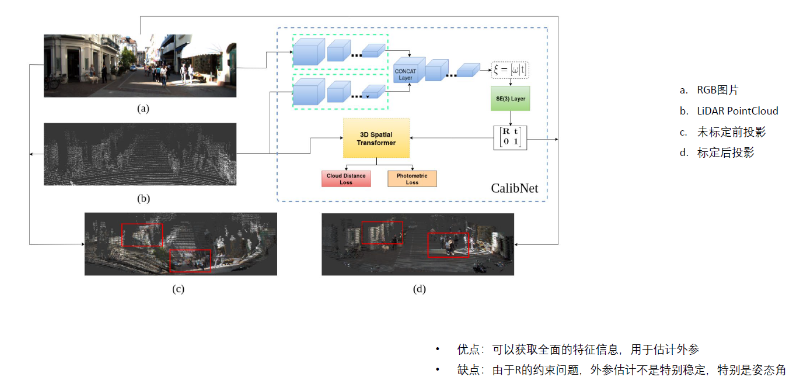

2.2 深度学习方法

这类方法应该是未来的趋势方法,通过深度学习的输出,来根据输入的情况估算出最优的投影情况,并作为输出。这一块作者没有深入的研究,等后续有时间再详细说说吧。

https://github.com/gogojjh/M-LOAM

https://github.com/KleinYuan/RGGNet

① 全网独家视频课程

BEV感知、毫米波雷达视觉融合、多传感器标定、多传感器融合、多模态3D目标检测、点云3D目标检测、目标跟踪、Occupancy、cuda与TensorRT模型部署、协同感知、语义分割、自动驾驶仿真、传感器部署、决策规划、轨迹预测等多个方向学习视频(扫码即可学习)

视频官网:www.zdjszx.com

视频官网:www.zdjszx.com

② 国内首个自动驾驶学习社区

近2000人的交流社区,涉及30+自动驾驶技术栈学习路线,想要了解更多自动驾驶感知(2D检测、分割、2D/3D车道线、BEV感知、3D目标检测、Occupancy、多传感器融合、多传感器标定、目标跟踪、光流估计)、自动驾驶定位建图(SLAM、高精地图、局部在线地图)、自动驾驶规划控制/轨迹预测等领域技术方案、AI模型部署落地实战、行业动态、岗位发布,欢迎扫描下方二维码,加入自动驾驶之心知识星球,这是一个真正有干货的地方,与领域大佬交流入门、学习、工作、跳槽上的各类难题,日常分享论文+代码+视频,期待交流!

③【自动驾驶之心】技术交流群

自动驾驶之心是首个自动驾驶开发者社区,聚焦目标检测、语义分割、全景分割、实例分割、关键点检测、车道线、目标跟踪、3D目标检测、BEV感知、多模态感知、Occupancy、多传感器融合、transformer、大模型、点云处理、端到端自动驾驶、SLAM、光流估计、深度估计、轨迹预测、高精地图、NeRF、规划控制、模型部署落地、自动驾驶仿真测试、产品经理、硬件配置、AI求职交流等方向。扫码添加汽车人助理微信邀请入群,备注:学校/公司+方向+昵称(快速入群方式)

④【自动驾驶之心】平台矩阵,欢迎联系我们!

1015

1015

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?