训练一个模型 8 小时才跑 4 个 epoch,训练极慢!!!问了一下GPT,有以下方法改进:

训练过慢的常见原因

一、可能的瓶颈原因

- 数据加载速度慢(最常见)

是否使用了 DataLoader + 多进程?

是否每次训练都重新处理原始 txt/csv?

是否数据太大但预处理没缓存?

🧪 检查方法:

在模型代码外加日志:

start = time.time()

batch = next(iter(train_loader)) # 或 dat.load_data(...)

print("加载一个 batch 耗时:", time.time() - start)

- 模型结构太复杂

网络层数过多、参数量大,GPU 无法吃满(尤其是 LPKT 模型带有图神经网络、注意力机制时)。

是否用了循环结构(如 LSTM)?这些比 CNN 慢很多。

是否做了复杂的动态计算图,如 sequence 分批处理、mask 等?

- batch size 太小

小 batch size 会导致 GPU 频繁等待 CPU 准备数据,训练慢。

建议从 batch_size=64 或 batch_size=128 开始。

如果 OOM(显存不足),逐步调低 batch size。

- GPU 没有吃满

你发的 nvidia-smi 显示 GPU 使用率只有 2%,说明你的 GPU 大部分时间都在等 CPU、I/O 或内存加载数据,不是 GPU 慢,而是 GPU 被饿死了。

训练加速建议

✅ 1. 使用 DataLoader + 多线程(PyTorch 常规加速方式)

train_loader = torch.utils.data.DataLoader(train_dataset, batch_size=64,

shuffle=True, num_workers=4, pin_memory=True)

num_workers=4 表示使用 4 个子线程加载数据。

✅ 2. 缓存预处理后的数据

如果你每次都读取 train0.txt 做 split() + 处理成 tensor,建议 第一次加载后保存为 .pt 文件,之后直接 torch.load 加载:

# 第一次保存

torch.save(processed_data, 'cached_train0.pt')

# 之后就能直接用

data = torch.load('cached_train0.pt')

✅ 3. 模型结构调优

减少冗余网络层(如 attention 层、嵌套结构)。

替换慢层(如 LSTM)为更快的 CNN(如 TCN)或 Transformer。

用 torch.compile()(PyTorch 2.0+)做动态图加速:

model = torch.compile(model) # 加速训练

✅ 4. 使用 AMP 自动混合精度训练(显著提升速度)

from torch.cuda.amp import GradScaler, autocast

scaler = GradScaler()

for input, target in train_loader:

optimizer.zero_grad()

with autocast(): # 自动混合精度计算

output = model(input)

loss = criterion(output, target)

scaler.scale(loss).backward()

scaler.step(optimizer)

scaler.update()

这能提升速度 20%-50% 且节省显存。

✅ 5. 实时监控 GPU 占用

你可以用这个命令持续观察 GPU 利用率:

watch -n 1 nvidia-smi

或者装 GPUtil 在 Python 中监控:

import GPUtil

GPUtil.showUtilization()

✅ 三、进一步排查建议

你可以贴出以下信息,我帮你具体定位:

dat.load_data() 的实现代码(是不是每次都读 txt 做预处理)

模型结构代码(特别是 forward 函数)

batch size 设置

是否使用 DataLoader,是否有 num_workers

一次 epoch 大概多少个 batch(或样本数量)

✅ 总结优化优先级

优先级–方法–提升幅度

⭐⭐⭐ 用 DataLoader 多线程加载 🚀🚀🚀 极大

⭐⭐ 缓存预处理数据 🚀🚀 中等

⭐⭐ AMP 自动混合精度训练 🚀🚀 中等

⭐ 模型结构简化 🚀 低-中

⭐ 增大 batch size 🚀 低-中

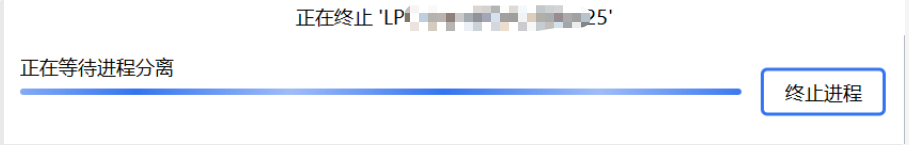

中断pycharm退出不了

你这个界面说明 PyCharm 正在尝试终止一个仍未退出的子进程,卡在了“正在等待进程分离”这一步,原因大概率如下:

🔍 根本原因:子进程还没退出,通常是 DataLoader 中设置了 num_workers > 0

PyTorch 的 DataLoader 在 Windows 下使用 num_workers > 0 时,会启动多个子进程来预加载数据。

当你点击“中止”按钮或按 Ctrl+C 时:

主进程会尝试等待子进程“干净地退出”

但子进程正在阻塞(比如读取数据、等待锁、内存资源),导致 PyCharm 卡在这一步

✅ 解决方案一:改成 num_workers=0

找到你训练时构造 DataLoader 的地方(如果有),改成这样:

train_loader = DataLoader(..., num_workers=0)

这会避免多进程读取数据,训练稍慢一点,但调试和中止会非常顺畅。

✅ 解决方案二:终止所有子进程(一次性干掉)

如果你已经卡在 PyCharm 停不下来,试试:

🛠 方法一:手动杀掉进程

打开任务管理器(Ctrl + Shift + Esc)

找到类似 python.exe 的进程(有时是多个)

全部结束任务

或者在命令行里输入:

taskkill /f /im python.exe

✅ 解决方案三:设置 PyCharm “调试中中止所有进程” 选项

PyCharm 默认在中止时不会强制结束子进程。你可以打开强制终止选项:

打开 PyCharm > Settings(或 Preferences)

搜索 Python Debugger

勾选选项:

✅ “Gevent compatible”

✅ “Kill subprocesses when terminating process”(终止时杀掉子进程)

✅ 加速调试建议

每次训练时不要设置 num_workers > 0,调试时用 0

用 print() 看是否卡在某个 batch 或某个 epoch

每轮训练控制 epoch 数,比如只跑一轮 for epoch in range(1) 测试

若用 notebook,建议用 Jupyter Notebook 而不是 PyCharm 调试多进程任务

避免再次卡死的方法

✅ 一次性解决:避免训练时 PyCharm 卡死的 5 个建议

- 调试阶段:永远设定 num_workers=0

你之前出现问题很可能是:

DataLoader(..., num_workers=4) # ⚠️ 多进程,调试时易卡死

改成:

DataLoader(..., num_workers=0) # ✅ 单进程安全,退出快

📌 建议:

写成参数变量,方便切换:

num_workers = 0 if debug_mode else 4

- 加上 KeyboardInterrupt 异常捕获,优雅退出

训练时你按下 Ctrl+C,如果没有异常处理,会卡主:

try:

for epoch in range(num_epochs):

train(...)

except KeyboardInterrupt:

print("中断训练,正在清理资源...")

# 可以加上 torch.save(model.state_dict(), 'xxx.pth')

这样 PyCharm 会快很多地响应中断。

- 开启 PyCharm 设置:中止时一并终止子进程

操作步骤:

PyCharm ➜ Settings(或 Preferences)

搜索 Python Debugger

找到并勾选:

✅ Kill subprocesses when terminating process

✅ Attach to subprocess automatically

✅(可选)Gevent compatible

💡这样,按 stop 按钮时 PyCharm 会主动干掉所有子进程,而不是“等它们自己慢慢退出”。

- 设置 PyTorch 的多线程环境变量(可选)

有时 PyTorch 会额外使用 CPU 多线程(不是 num_workers),也会卡:

import os

os.environ["OMP_NUM_THREADS"] = "1"

os.environ["MKL_NUM_THREADS"] = "1"

这个设置会降低 CPU 多线程使用,在调试时更稳定。

- 使用调试用的小数据集 + 少量 epoch + batch_size=1 先跑通流程

每次调试建议:

只训练 1~2 个 epoch

batch_size 小一些(如 2 或 4)

删减训练集(或写个 debug=True 分支)

代码模板:

if debug:

dataset = Subset(dataset, range(100))

num_epochs = 2

batch_size = 2

1798

1798

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?