前言

摘要:随着开源大模型如Qwen3、Llama 3等进入“千亿级”战场,直接训练一个顶尖模型已成为巨头公司的游戏。但对于大多数企业和开发者而言,更具现实意义的路径是:微调。将一个通用的基座模型,用特定领域的数据进行“再教育”,使其成为某个垂直领域的专家。

那么,一个核心问题浮出水面:微调一个像Qwen3-32B这样的大模型,究竟要付出多少成本?今天,我们就来详细算一笔账。

- 什么是微调

- 微调的基本流程

- 微调一个Qwen3-32B的大模型需要多少钱?

1、什么是微调?

一、 微调 vs. 训练:本质区别与资源鸿沟

在计算成本前,必须厘清微调与从头训练的巨大差异。

训练:相当于从零开始“培养一个大学生”。需要海量、高质量的通识数据(数TB文本),让模型学习语言、语法、逻辑、常识等一切知识。这个过程耗时极长,需要成千上万张顶级GPU(如H100)集群运算数月,成本动辄数百万乃至上千万美元。

微调:相当于让一个“通才大学生”进修成为“医学博士”或“法律专家”。我们利用已经具备强大通识能力的基座模型,只用相对少量(几千到几万条)的领域数据,对其参数进行小幅调整。它不改变模型的核心知识结构,而是引导其更擅长解决特定任务。

资源对比:微调所需的计算资源、时间和数据量,通常只有从头训练的1%到10%。这使得中小团队也能拥有定制化大模型的能力。

核心区别表:

| 特性 | 预训练 | 微调 |

| 目标 | 从零开始学习通用语言能力和世界知识 | 在已有的基础上,适应特定任务和领域 |

| 数据 | 海量、无标注的通用文本(TB-PB级别) | 少量、高质量的标注或者指令数据(MB-GB) |

| 算力需求 | 极其巨大(数千张A100/H800,数月) | 相对很小(几张到10张A100,几个小时或者几天) |

| 产出 | 基础模型 | 领域专家模型 |

二、微调的主要作用

微调的核心目的是让大模型 **“对齐”**我们的特定需求,具体作用包括:

1、指令跟随:让模型学会严格按照人类指令的格式和意图来回答问题。

2、领域适应:让模型精通某个垂直领域(如医疗、法律、金融),使用该领域的专业术语和知识。

3、风格模仿:让模型的输出符合特定的风格(如官方正式、幽默风趣、儿童化语言)。

4、纠正偏见/错误:通过特定数据,纠正基础模型在某些问题上的错误认知或偏见。

2、微调基本流程

一、微调的完整流程

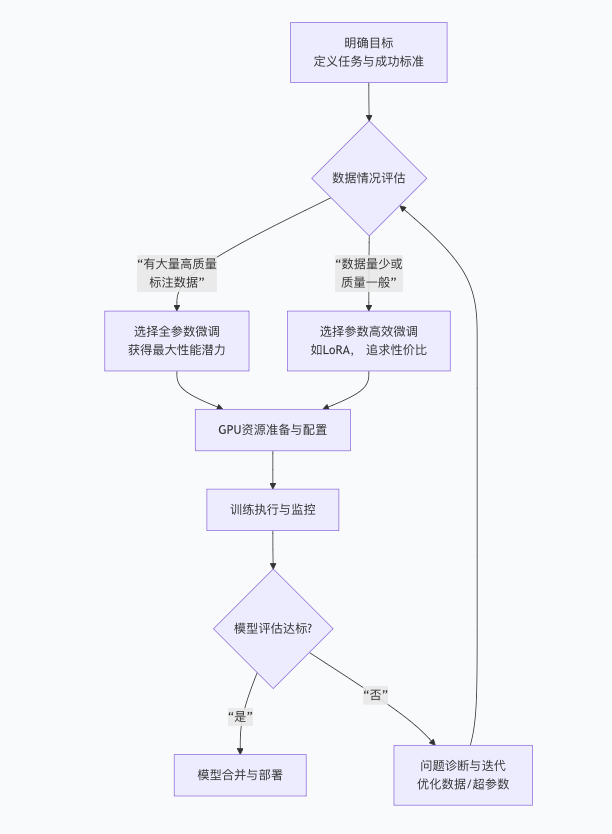

一个标准的微调流程如同一个精密的项目,可以概括为以下几个关键阶段,其核心决策路径如下图所示:

上述流程中的关键环节详解如下:

1、目标定义与数据准备

指令:“用Python写一个快速排序函数。”

输出:“def quicksort(arr): ...”

明确任务:要模型做什么?是充当客服、生成代码、还是分析财报?

数据收集与清洗:这是最关键的一步。数据质量决定模型上限。数据格式通常是“指令-输出”对。

2、环境与模型配置:选择微调框架(如Hugging Face的TRL, DeepSpeed),加载基座模型(Qwen3-32B)。

3、选择微调方法

全参数微调:更新模型的所有参数。效果最好,但资源消耗最大。

参数高效微调:如 LoRA, 只在原始模型旁边添加和训练一些小的适配器层,极大降低资源消耗,效果可接近全参数微调,是当前的主流选择。

4、配置训练参数与资源

学习率、训练轮次等:这些是模型的“学习节奏”,需要小心设置。

GPU服务器:根据模型大小选择。

5、训练执行与监控

启动训练,并实时监控损失函数下降情况,确保训练正常。

6、评估与迭代

训练完成后,在预留的“测试集”上评估模型表现,如果不好,需要回到第1或第2步进行优化。

二、关键问题详解

1. 需要准备多少数据?

指令微调:通常 几百到几千条高质量的指令-输出对就能看到显著效果。例如,有1,000-5,000条精心编写的样本,就足以让模型学会很好的指令跟随能力。

领域知识深度微调:如果需要模型深刻掌握某个领域的深层知识,可能需要 数万到数十万条数据。

核心原则:质量 >> 数量。10条干净、准确、多样化的数据,远胜于1000条重复、低质、有噪音的数据。

2. GPU服务器算力需求是平时的多少倍?

“平时”通常指推理。微调(训练)的算力需求远高于推理。

推理:只需将输入数据在前向传播中计算一次。消耗资源少,延迟低。

微调:需要前向传播 + 反向传播 + 梯度更新,涉及大量矩阵运算,显存占用极高。

以Qwen2.5-32B模型为例:

推理:使用 fp16精度,模型加载需约 32B * 2字节 = 64GB显存。一张 **A100(80GB)**或 **H100(80GB)**即可胜任。

全参数微调:除了加载模型,还需要存储优化器状态、梯度、激活值等。粗略估计,全参数微调32B模型需要 至少4-8张A100(80GB)进行分布式训练。算力需求可能是单次推理的数百甚至上千倍(考虑多卡和长时间训练)。

LoRA微调:显存需求大幅降低。一张或两张A100(80GB)就可能完成,是性价比最高的选择。

3. 验证微调效果好坏的指标?

定性评估(主要):

让人(专家或用户)去看模型的输出,判断其准确性、相关性、流畅性、安全性。这是最可靠的方法。

例如:“微调后的法律模型生成的合同条款是否专业且无漏洞?”

定量评估(辅助):

损失/困惑度:在测试集上的损失值越低,说明模型对数据的拟合越好。

任务特定指标:如果是分类任务,用准确率、F1分数;如果是文本生成,可以用 BLEU/ROUGE分数(与标准答案的相似度),但这些指标有时与人类判断有差距。

3、微调一个Qwen3-32B的大模型需要多少钱?

现在,我们进入核心环节——算账。成本主要由数据、算力、时间三者决定。

1、需要准备多少数据?

这取决于任务复杂度。一个简单的风格迁移任务可能只需几千条高质量数据。一个复杂的推理任务可能需要数万条。数据的质量远重于数量,1000条精标数据的效果可能优于10万条噪音数据。对于Qwen3-32B,通常建议从5,000 - 50,000条指令样本开始。

微调的数据样例:

{“instruction”: “Dify和FastGPT的主要区别是什么?”, “output”: “Dify和FastGPT都是优秀的AI应用开发平台,但侧重点不同…”}

2、需要多大的算力(GPU服务器)?

32B参数的模型对显存要求很高。我们以主流的QLoRA微调方法为例,因为它能最大程度节省显存。

全参数微调:估计需要至少8张80GB显存的A100/H100显卡,成本极其高昂。

QLoRA微调:这是性价比最高的方案。仅需1张A100(40GB/80GB)或2张A6000(48GB)即可完成!算力需求降至平时的1到2倍(因为QLoRA只引入了极少的可训练参数,计算开销小)。

3、具体要花多少钱?

取中间值20小时: 20小时 * ¥40/小时 = ¥800。

这意味着,理论上,用不到一千元人民币就能完成一次Qwen3-32B的定制化微调!

服务器配置:1台搭载1张A100(40GB)的实例。

云服务单价:假设约¥40/小时(根据平台和折扣有所不同)。

微调时间:在1万条数据上,用QLoRA微调1-3个 epoch(完整遍历数据的次数),大约需要10-30小时。

我们以云服务商租用GPU为例:

总成本计算:

注:如果使用更便宜的A6000显卡或消费级显卡(如RTX 4090 24GB)通过特殊方法进行微调,成本可能进一步降低,但可能会面临显存瓶颈和更长的训练时间。

如果,你自己购买服务器,那成本主要是新增1张A100 GPU卡的成本。NVIDIA Tesla A100 80GB显卡的当前市场价格在86,000元至92,700元人民币之间,具体价格因购买渠道、促销活动及供应商政策而异。

通过以上分析,我们可以看到,得益于QLoRA等高效微调技术的发展,微调一个320亿参数的顶级模型(如Qwen3-32B)的门槛已从“高不可攀”降至“触手可及”。核心成本从“天价硬件投入”转向了“高质量数据制备”和“工程师的调参经验”。

对于企业而言,这意味着可以以数千元到数万元的可控成本,快速打造一个属于自己垂直领域的“专家模型”,从而在激烈的AI竞争中赢得先机。下一次当你考虑定制大模型时,不妨先拿起计算器,这笔账可能比你想象的要划算得多。

最后

为什么要学AI大模型

当下,⼈⼯智能市场迎来了爆发期,并逐渐进⼊以⼈⼯通⽤智能(AGI)为主导的新时代。企业纷纷官宣“ AI+ ”战略,为新兴技术⼈才创造丰富的就业机会,⼈才缺⼝将达 400 万!

DeepSeek问世以来,生成式AI和大模型技术爆发式增长,让很多岗位重新成了炙手可热的新星,岗位薪资远超很多后端岗位,在程序员中稳居前列。

与此同时AI与各行各业深度融合,飞速发展,成为炙手可热的新风口,企业非常需要了解AI、懂AI、会用AI的员工,纷纷开出高薪招聘AI大模型相关岗位。

最近很多程序员朋友都已经学习或者准备学习 AI 大模型,后台也经常会有小伙伴咨询学习路线和学习资料,我特别拜托北京清华大学学士和美国加州理工学院博士学位的鲁为民老师给大家这里给大家准备了一份涵盖了AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频 全系列的学习资料,这些学习资料不仅深入浅出,而且非常实用,让大家系统而高效地掌握AI大模型的各个知识点。

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

AI大模型系统学习路线

在面对AI大模型开发领域的复杂与深入,精准学习显得尤为重要。一份系统的技术路线图,不仅能够帮助开发者清晰地了解从入门到精通所需掌握的知识点,还能提供一条高效、有序的学习路径。

但知道是一回事,做又是另一回事,初学者最常遇到的问题主要是理论知识缺乏、资源和工具的限制、模型理解和调试的复杂性,在这基础上,找到高质量的学习资源,不浪费时间、不走弯路,又是重中之重。

AI大模型入门到实战的视频教程+项目包

看视频学习是一种高效、直观、灵活且富有吸引力的学习方式,可以更直观地展示过程,能有效提升学习兴趣和理解力,是现在获取知识的重要途径

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

海量AI大模型必读的经典书籍(PDF)

阅读AI大模型经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验。对于想要深入学习AI大模型开发的读者来说,阅读经典书籍是非常有必要的。

600+AI大模型报告(实时更新)

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

AI大模型面试真题+答案解析

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

406

406

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?