前言

本文将深入探讨MoE技术如何实现万亿参数模型的高效训练与推理,揭示其在现代AI系统中的核心价值。

大模型时代,模型规模的持续扩张已成为提升性能的关键驱动力。 然而,传统的 “密集”(Dense)模型架构,即每次推理都需要动用模型全部参数,正面临着计算成本和能耗的巨大瓶颈。

在此背景下,混合专家模型(Mixture-of-Experts, MoE)作为一种革命性的稀疏架构,应运而生。2025年,MoE技术已成为构建万亿参数级别超大语言模型(LLM)以及高效多模态模型的首选技术路线之一。

MoE的核心思想是"条件计算"(Conditional Computation),它将一个庞大的神经网络分解为多个相对独立的"专家"子网络,并引入一个 **“门控网络”(Gating Network)或"路由器"(Router)**来动态地、有选择性地激活一部分专家处理当前输入。

简而言之,MoE****将一个复杂的任务分解为多个子任务,每个子任务由一个专门的专家来处理。

在MoE摸型中,**“专家”负责学习并处理不同的信息,而”路由器”**则负责根据输入智能地选择最合适的专家进行处理,并将选定专家的输出作为最终输出。

这种机制使得模型总参数量可以极大增加,从而提升模型容量和知识存储能力,但每次前向传播的实际计算量(FLOPs)却能维持在较低水平,实现了模型规模与计算效率的"解耦"。

一、MoE模型简史

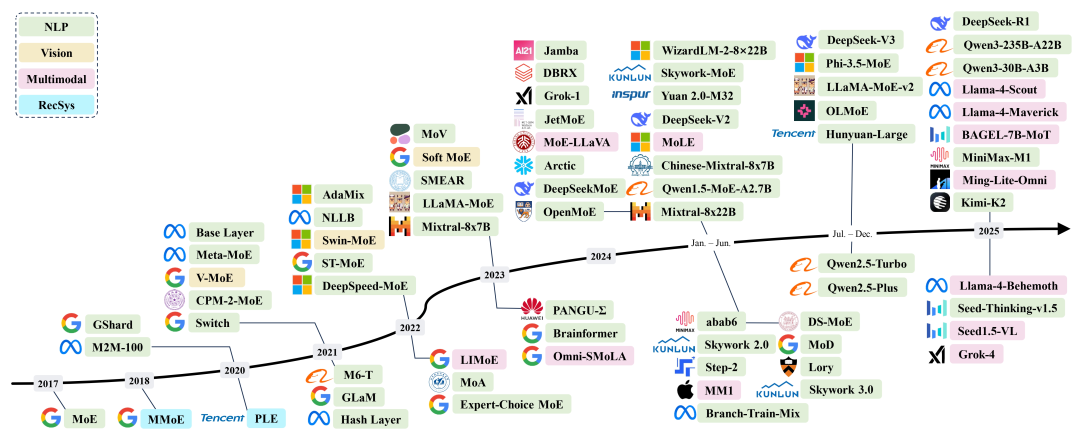

MoE模型的概念最早可以追溯到1991年的论文“Adaptive Mixture of Local Experts[1]”,由Michael Jordan和Geoffrey Hinton等人提出。这篇开创性的论文为MoE模型奠定了基础,其核心思想是通过"分而治之"的策略,将复杂问题分解为子问题并分配给专门的模型处理。MoE架构模拟了人类专家团队的协作模式,每个专家专注于特定任务或领域,而门控网络则负责根据输入特征动态分配计算资源 。这一设计使得模型能够在保持高性能的同时,显著降低计算复杂度。

近年来具有代表性的混合专家(MoE)模型的编年史概述

在2010至2015年间,组件专家和条件计算两个领域推动了混合专家模型(MoE)的发展。组件专家将MoE嵌入深层网络,使其高效且规模更大;条件计算则通过动态激活网络组件提升计算效率。

2017年,谷歌的研究团队在论文“Outrageously Large Neural Networks: The Sparsely-Gated Mixture-of-Experts Layer[2]”中,将MoE模型与LSTM(长短期记忆网络)相结合,引入稀疏性,实现了大规模模型的快速推理,主要应用于翻译领域,但也面临高通信成本和训练不稳定等挑战。

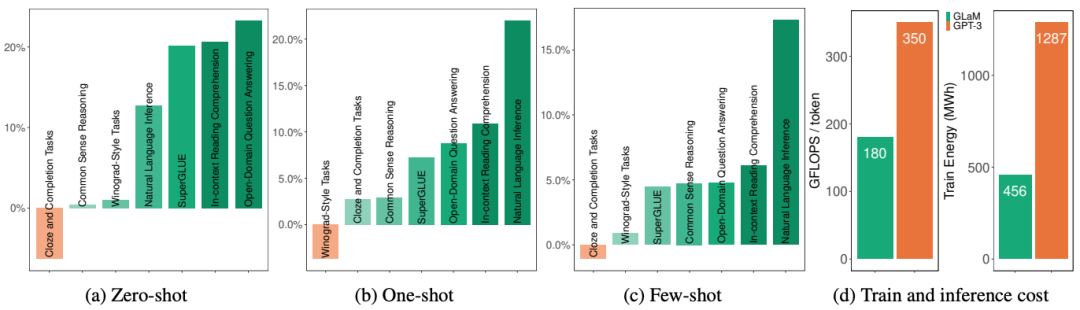

**此后,MoE模型的研究不断深入和拓展。**2020年,谷歌的GShard[3]项目首次将MoE技术引入Transformer架构中,并提供了高效的分布式并行计算架构,使得MoE模型能够在分布式环境中进行大规模的训练和推理,进一步推动了MoE模型在自然语言处理领域的应用。2021年,谷歌的Switch Transformer[4]和GLaM[5]模型进一步挖掘了MoE技术在自然语言处理中的应用潜力,通过优化门控机制和专家设计,实现了更优秀的性能表现。

近年来, MoE模型的应用范围不断扩大,除了在自然语言处理领域继续取得突破外,还在计算机视觉、多模态学习等领域得到了广泛的研究和应用。

二、MoE模型的核心架构与工作原理

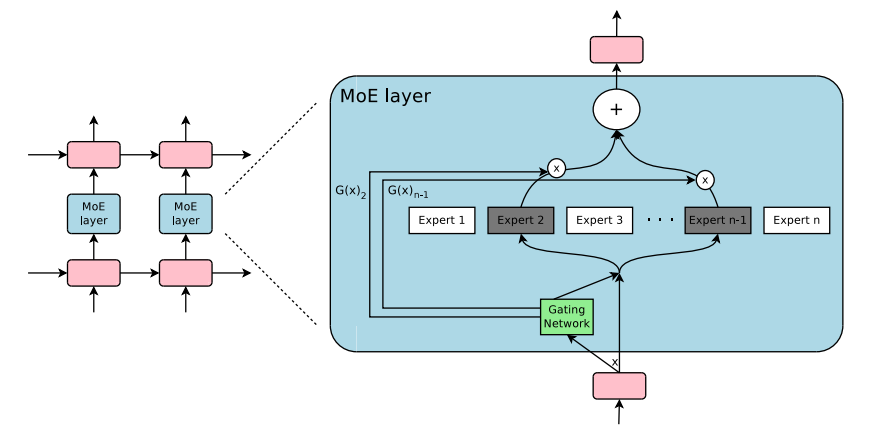

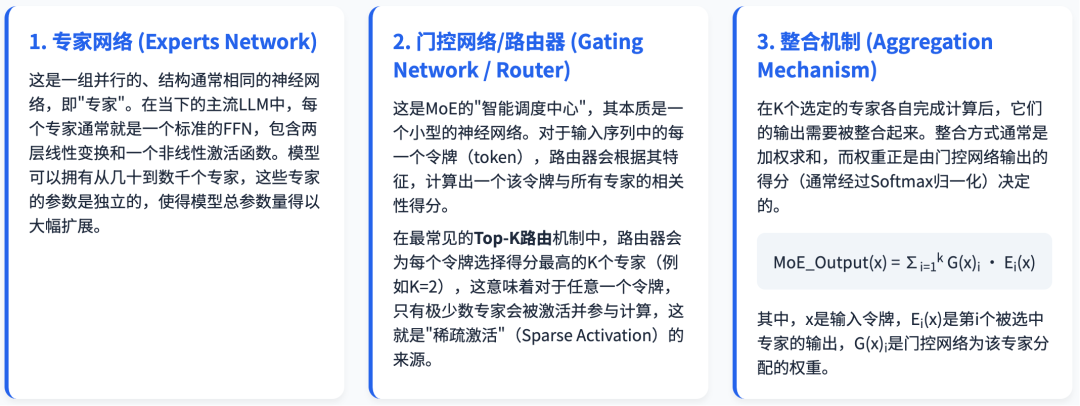

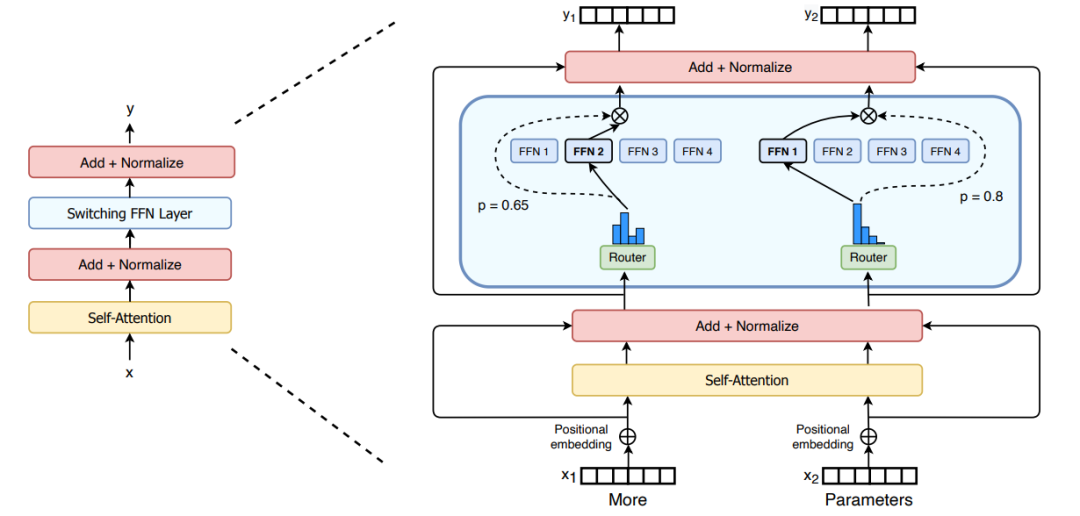

MoE架构并非单一固定的设计,但其核心组件和工作流程具有共通性。一个典型的MoE层通常嵌入在Transformer架构中,用于替代其中的前馈网络(Feed-Forward Network, FFN)层。

Outrageously Large Neural Network 论文中的 MoE layer

其结构如下:

输入: MoE层接收来自前一层(通常是自注意力层)的每个Token的表征向量(Token Representation)。

门控网络 (Gating Network) : 输入的Token表征首先被送入一个轻量级的门控网络。该网络负责为每个Token计算一组权重,这组权重决定了该Token应该被分配给哪些专家网络进行处理。

专家网络 (Expert Networks) : 模型包含一组(例如8个、64个或更多)并行的专家网络。每个专家本身通常就是一个标准的FFN(即两个线性层加一个非线性激活函数)。它们在结构上是相同的,但在训练后会学习到不同的参数,从而形成功能上的“专长”。

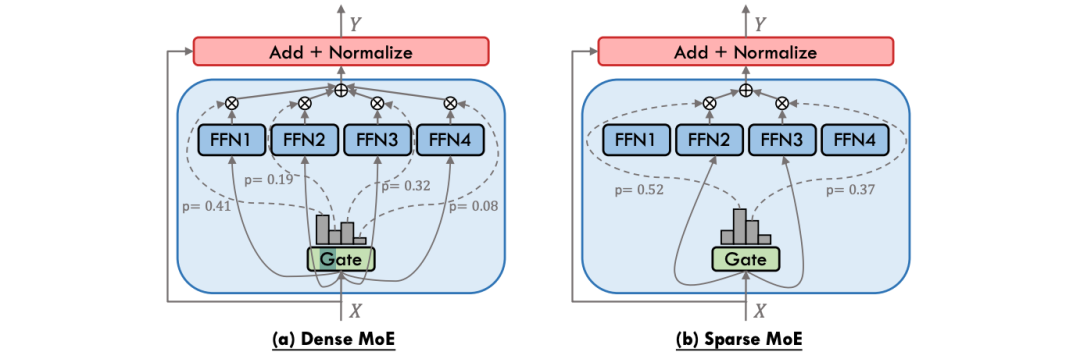

稀疏激活与加权组合: 根据门控网络的输出,每个Token仅被发送给得分最高的k个专家(k通常为1或2)。在这些专家处理完Token后,它们的输出会根据门控网络计算出的权重进行加权求和,形成MoE层的最终输出。

残差连接: 与标准Transformer一样,MoE层的输出会通过一个残差连接与该层的输入相加,然后进行层归一化。

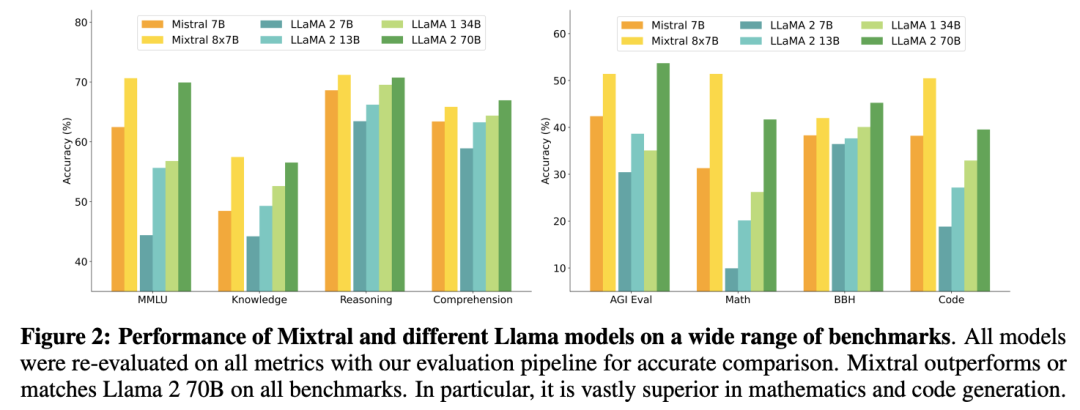

这种设计的革命性在于,它实现了总参数量与激活参数量的分离。一个拥有8个专家的MoE模型,其总参数量约等于一个FFN层参数量乘以8,但对于任何一个Token的单次前向传播,其计算量(FLOPs)仅相当于激活了k个专家(例如k=2),远小于一个同等总参数量的稠密模型。这正是Mixtral 8x7B模型(总参数46.7B,激活参数约13B)能够以远低于Llama 2 70B的推理成本,却达到甚至超越其性能的根本原因。

MoE架构三大核心组件

工作原理:条件计算与稀疏激活

MoE的工作流程可以概括为**“分发-计算-整合”**三部曲:

- 分发 (Dispatch) :输入批次中的每个令牌,都经过门控网络,门控网络为其选择Top-K个最合适的专家。

- 计算 (Compute) :将令牌发送给各自被选中的专家进行并行计算。未被选中的专家则保持静默,不参与此次计算。

- 整合 (Combine) :将每个令牌对应的K个专家的输出,根据门控网络给出的权重进行加权求和,形成最终的输出。

通过这种方式,MoE模型虽然总参数量巨大(例如, Mixtral 8x7B[6] 模型拥有8个专家,总参数约47B,但实际推理时每个令牌只激活2个专家,计算量仅相当于一个12.9B的密集模型),但其推理时的计算成本(FLOPs)仅与激活的专家数量成正比,远低于同等参数规模的密集模型 。

三、MoE模型的训练挑战与关键优化技术

尽管MoE在扩展性上优势显著,但其训练过程远比密集模型复杂,需要一系列精巧的算法技术来保证训练的稳定性和效率。

核心挑战:负载不均衡

在训练过程中,一个常见的棘手问题是负载不均衡(Load Imbalance):门控网络可能倾向于频繁选择少数几个“热门”专家,而其他专家则很少被激活,成为“冷门”专家。这会导致模型训练效率低下,部分参数得不到充分训练,最终损害模型性能 。

关键优化技术详解

- 辅助负载均衡损失 (Auxiliary Load Balancing Loss)

- **目的:**这是解决负载不均衡最经典和常用的方法。其核心思想是在主任务损失(如交叉熵损失)之外,额外增加一项损失函数,用于惩罚专家负载的不均匀分配,鼓励所有专家被均匀利用 。

- **数学公式:**该损失函数有多种形式,一种常见的形式源自Switch Transformer,其定义如下 :

- 带噪声的Top-K门控 (Noisy Top-K Gating)

- 目的: 为了增加路由过程的随机性,避免门控网络在训练早期就“固化”其选择偏好,研究者们提出了在门控网络的logit上添加高斯噪声的方法 。

- 机制: 在计算最终的Top-K选择之前,向门控网络的输出添加一个小的随机噪声。这有助于在训练初期进行更广泛的探索,让更多的专家有机会被激活和训练,从而提升模型的稳定性和最终性能 。

- 专家容量因子 (ExpertCapacityFactor)

- 目的: 为了从硬件层面强制避免单个专家过载,MoE系统会为每个专家设置一个“容量”上限,即在一个批次中最多能处理的令牌数量 。

- 机制: 容量通常按批次中令牌总数和专家数量的平均值来设定,再乘以一个“容量因子”(Capacity Factor, C)。例如,

C=1.25意味着每个专家的容量是平均负载的125%。如果路由到某个专家的令牌数超过其容量,多余的令牌会被“丢弃”(dropped),其表示将直接通过残差连接传递到下一层,不经过专家计算 。这是一种在计算效率和模型性能之间的权衡。

- 新兴的无辅助损失均衡方法 (Auxiliary-Loss-Free Balancing Methods)

- **背景:**尽管辅助损失很有效,但它会引入额外的超参数,且可能对主任务的梯度产生干扰。因此,自2023年以来,无辅助损失的均衡方法成为研究热点。

- **机制:**这类方法不再依赖于一个独立的损失项,而是直接在路由机制本身进行调整。例如,DeepSeek-V2[7]模型采用了一种策略,通过动态调整每个专家的路由偏置(bias)来直接控制负载,如果一个专家过热,就降低其偏置,反之则提高,从而实现无需额外损失项的自适应负载均衡。

分布式训练与并行策略

由于MoE模型参数量巨大,单张GPU无法承载,必须进行分布式训练。除了常见的数据并行和张量并行,MoE引入了独特的专家并行(EP):将不同的专家分布到不同的GPU(或节点)上。

- 混合并行:现代MoE训练框架(如Megatron-LM、DeepSpeed)通常采用数据并行、张量并行和专家并行相结合的混合并行策略,以最大化利用集群资源 。

- 通信优化:专家并行会引入密集的All-to-All通信模式,即每个GPU都需要将令牌发送给其他GPU上的专家,并接收计算结果。这是训练的主要瓶颈。优化手段包括使用高性能网络互联(如NVLink、Infiniband)、优化通信库(如NCCL)以及设计网络拓扑感知的并行策略 。

面向边缘设备的部署与推理优化

将庞大的MoE模型部署到手机、智能汽车等边缘设备上是一个新兴且充满挑战的研究方向。核心挑战:边缘设备内存和算力极其有限,而MoE模型的总参数量巨大。其优化技术如下:

- 专家卸载 (Expert Offloading) :只在GPU/NPU上保留少量活跃专家或一个专家缓存,其余大量不常用的专家权重存储在相对较慢的CPU内存或闪存中,按需加载 。

- 缓存感知路由 (Cache-Aware Routing) :设计一种路由策略,使其在选择专家时,倾向于选择那些已经被加载到缓存中的专家,从而最大化缓存命中率,减少从慢速存储中加载专家所带来的延迟 。

- 模型蒸馏与压缩 (Model Distillation & Compression) :将一个大型MoE模型的知识蒸馏到一个更小的密集模型或更小规模的MoE模型中,使其适合边缘部署 。

EdgeMoE[8]和SiDA-MoE[9]等研究项目已经验证了这些技术的可行性,能够在移动设备上实现显著的推理延迟降低(高达2-3倍)和内存占用减少。

开源框架与推理引擎

一系列开源工具极大地推动了MoE的普及和发展:

- DeepSpeed-MoE[10] :微软推出的DeepSpeed[11]库提供了成熟的MoE实现,集成了高效的CUDA内核、负载均衡策略和内存优化技术,支持万亿级别模型的训练与推理 。

- Tutel[12] :同样来自微软,Tutel是一个专注于MoE层本身计算优化的库。它提供了高度优化的稀疏计算内核,可以作为插件集成到PyTorch等框架中,显著提升MoE层的计算效率 。

- FastMoE[13] :一个由学术界主导的轻量级、易于使用的MoE训练系统,也基于PyTorch构建 。

- Megablocks[14] :https://github.com/stanford-futuredata/megablocks

- Fairseq[15] :https://github.com/facebookresearch/fairseq/tree/main/examples/moe_lm

- OpenMoE[16] :https://github.com/XueFuzhao/OpenMoE

四、性能基准:MoE模型 vs. 稠密模型

MoE模型的核心价值是在相似甚至更低的计算成本下,达到或超越更大规模的密集模型的性能。

大量研究和实践表明,MoE模型在性能和计算成本之间取得了更优的平衡。在相同的计算预算(FLOPs)下,MoE模型通常能展现出更低的困惑度(Perplexity)和更高的下游任务准确率 。

- Switch****Transformer:Google的研究显示,一个与T5-Base(220M参数)计算量相当的Switch Transformer模型,其性能可以媲美T5-Large(770M参数) 。在TPUv3硬件上,其推理速度比计算量匹配的密集模型快了高达7倍 。

- GLaM:同样来自Google的GLaM模型,虽然总参数量高达1.2T,但其推理成本仅为GPT-3 (175B)的三分之一,却在多项零样本(Zero-shot)NLP任务上取得了更优异的成绩。

- Mixtral 8x7B :由Mistral AI发布的开源模型,其以约13B的激活参数,在众多基准测试中击败了拥有70B参数的Llama 2 70B模型,成为开源社区的标杆。

性能对比:MoE****vs. 稠密模型

| 评估维度 | 稠密模型 | MoE模型 | 分析 |

|---|---|---|---|

| 参数效率 | 低。所有参数在每次前向传播中都被激活。 | 高。 总参数量巨大,但每次仅激活一小部分。 | MoE以更高的参数量换取了更强的模型容量,但保持了计算成本的可控性。 |

| 训练成本 | 高。达到SOTA性能需要巨大的FLOPs。 | 相对更低。 在相同的性能水平下,MoE所需的训练FLOPs显著少于稠密模型。 | MoE的稀疏性使其成为“计算最优训练”的有效路径。 |

| 推理成本 | 高。与参数量成正比,延迟高,部署昂贵。 | 显著更低。 推理FLOPs和延迟取决于激活参数量,而非总参数量。 | 这是MoE在实际应用中最具吸引力的优势,使得更强大的模型能够被实际部署。 |

| 模型性能 | 遵循Scaling Law,性能随参数和数据增长。 | 在同等激活参数下 ,性能通常不如稠密模型;但在同等计算成本下,性能远超稠密模型。 | MoE通过增加总参数量,为模型提供了更广阔的“解空间”,从而在同等计算预算下获得更高智能。 |

挑战与权衡

尽管推理高效,但MoE模型也存在固有挑战:

- 巨大的内存占用:需要存储所有专家的参数,对GPU显存要求极高。

- 复杂的训练系统:需要专门的并行策略(如专家并行)和通信优化,训练基础设施复杂。

- 通信开销:专家并行中的All-to-All通信是主要瓶颈,尤其是在大规模集群中。

五、MoE的应用领域扩展:从NLP到视觉与多模态

MoE技术最初在自然语言处理(NLP)领域大放异彩,但其成功已迅速扩展到计算机视觉和多模态等更广泛的领域。

在视觉领域,研究者们将MoE层集成到Vision Transformer (ViT)中,用以替代标准MLP模块,诞生了如 V-MoE (Vision MoE) 等模型。**V-MoE能够根据图像块(patches)的内容,**将其路由到专门处理不同视觉模式(如纹理、边缘、对象部分)的专家。

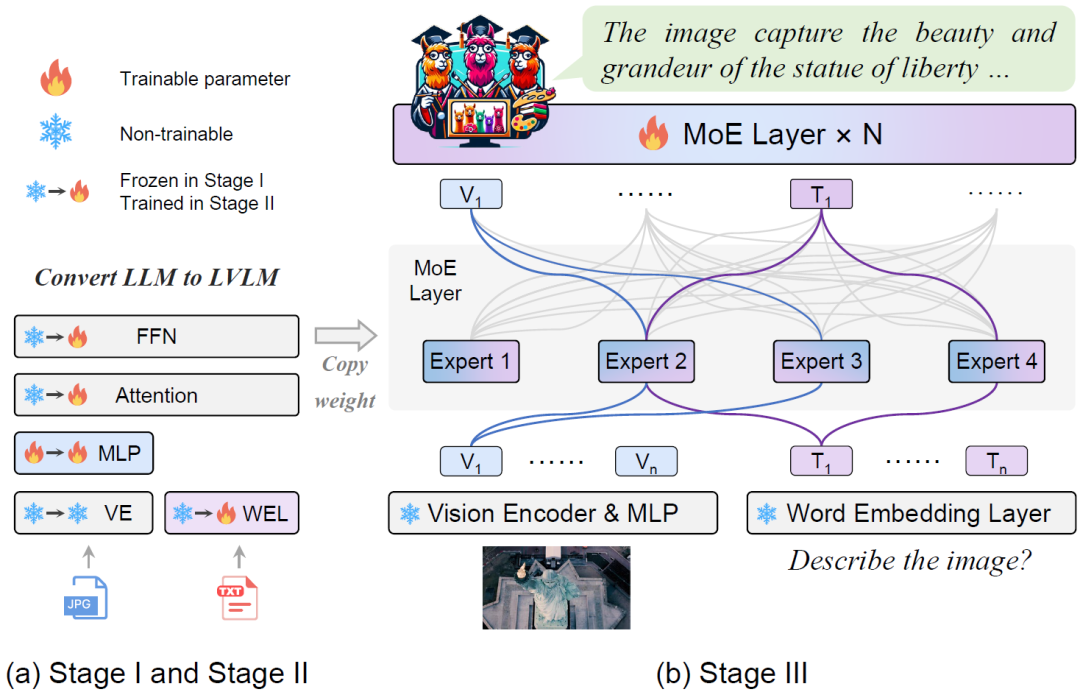

MoE在处理融合文本、图像、音频等多种数据类型的多模态任务中展现出巨大潜力。通过MoE,模型可以为不同模态或不同任务动态分配专家:一些专家可能专门处理文本信息,另一些专家处理视觉信息,还有一些专家则负责跨模态的对齐与融合 。

自2023年以来,涌现了大量多模态MoE模型,如 LIMoE[17]、MoE-LLaVA[18]、Ming-Lite-Omni[19]等。例如, MoE-LLaVA 在多个视觉问答(VQA)基准上,其性能显著优于其对应的非MoE密集模型基线 。

写在最后

MoE技术不仅是一项成熟且强大的技术,更是一个充满活力的研究领域。展望未来,它将驱动着更大、更强、更高效的AI模型的诞生。

最后

为什么要学AI大模型

当下,⼈⼯智能市场迎来了爆发期,并逐渐进⼊以⼈⼯通⽤智能(AGI)为主导的新时代。企业纷纷官宣“ AI+ ”战略,为新兴技术⼈才创造丰富的就业机会,⼈才缺⼝将达 400 万!

DeepSeek问世以来,生成式AI和大模型技术爆发式增长,让很多岗位重新成了炙手可热的新星,岗位薪资远超很多后端岗位,在程序员中稳居前列。

与此同时AI与各行各业深度融合,飞速发展,成为炙手可热的新风口,企业非常需要了解AI、懂AI、会用AI的员工,纷纷开出高薪招聘AI大模型相关岗位。

最近很多程序员朋友都已经学习或者准备学习 AI 大模型,后台也经常会有小伙伴咨询学习路线和学习资料,我特别拜托北京清华大学学士和美国加州理工学院博士学位的鲁为民老师给大家这里给大家准备了一份涵盖了AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频 全系列的学习资料,这些学习资料不仅深入浅出,而且非常实用,让大家系统而高效地掌握AI大模型的各个知识点。

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

AI大模型系统学习路线

在面对AI大模型开发领域的复杂与深入,精准学习显得尤为重要。一份系统的技术路线图,不仅能够帮助开发者清晰地了解从入门到精通所需掌握的知识点,还能提供一条高效、有序的学习路径。

但知道是一回事,做又是另一回事,初学者最常遇到的问题主要是理论知识缺乏、资源和工具的限制、模型理解和调试的复杂性,在这基础上,找到高质量的学习资源,不浪费时间、不走弯路,又是重中之重。

AI大模型入门到实战的视频教程+项目包

看视频学习是一种高效、直观、灵活且富有吸引力的学习方式,可以更直观地展示过程,能有效提升学习兴趣和理解力,是现在获取知识的重要途径

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

海量AI大模型必读的经典书籍(PDF)

阅读AI大模型经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验。对于想要深入学习AI大模型开发的读者来说,阅读经典书籍是非常有必要的。

600+AI大模型报告(实时更新)

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

AI大模型面试真题+答案解析

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

6510

6510

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?