接入Deepseek

一 获取开发参数

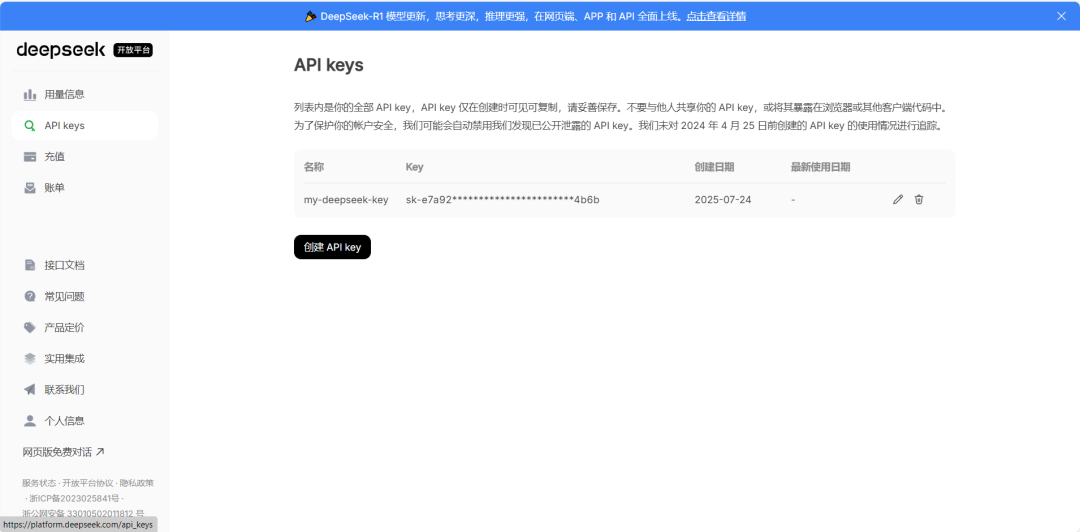

登录deepseek官网获取application.properties文件中所需要的开发参数

点击api开放平台

最少需要充一元

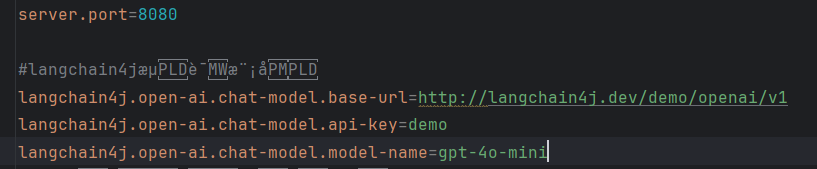

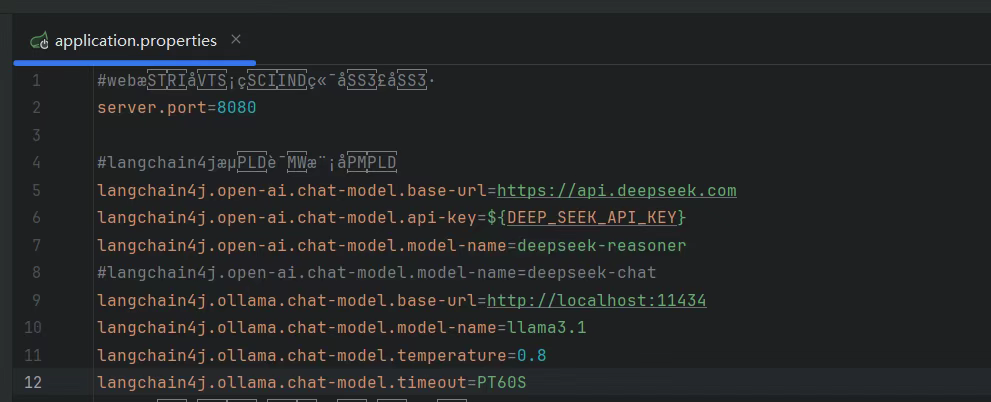

·server.port=8080 .open-ai.chat-model.base-url=http://langchain4j.dev/demo/openai/v1langchain4j.open-ai.chat-model.api-key=demolangchain4j.open-ai.chat-model.model-name=gpt-4o-minilangchain4j.open-ai.chat-model.log-requests=truelangchain4j.open-ai.chat-model.log-responses=truelogging.level.root=debug

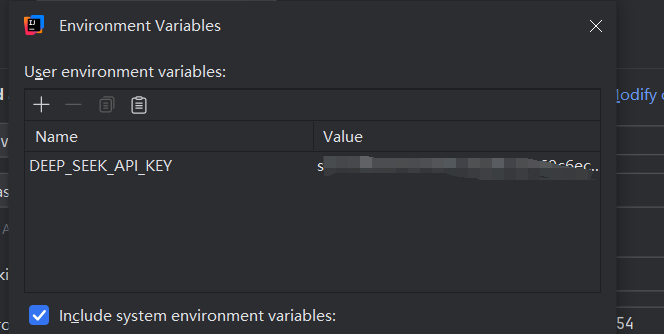

获取到的apikey值,可以写入到application.properties文件当中,但是敏感信息直接写入到源代码的配置文件当中不安全,选择配置在本地的环境变量当中

二 本地配置开发参数

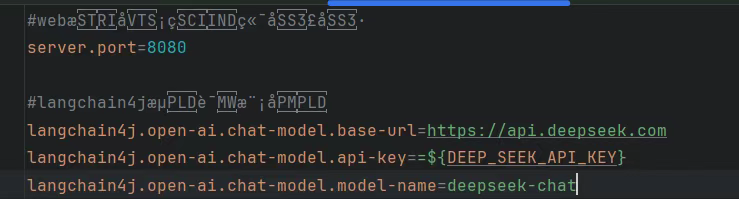

为了apikay的安全,选择将其配置在本地的环境变量中。变量名自定义即可,例如 DEEP_SEEK_API_KEY

此电脑->右键->属性->高级系统设置,添加系统变量之后重启idea,让idea继承环境变量。环境变量中的变量名是任意填写的,但是约定俗成是各部分内容加下划线分割。在配置文件中以=${DEEP_SEEK_API_KEY}的形式去访问刚才在环境变量中配置的变量

#DeepSeeklangchain4j.open-ai.chat-model.base-url=https://api.deepseek.comlangchain4j.open-ai.chat-model.api-key=${DEEP_SEEK_API_KEY}#DeepSeek-V3langchain4j.open-ai.chat-model.model-name=deepseek-chat#DeepSeek-R1 推理模型#langchain4j.open-ai.chat-model.model-name=deepseek-reasoner

参数写入将变量替换到apikey位置处

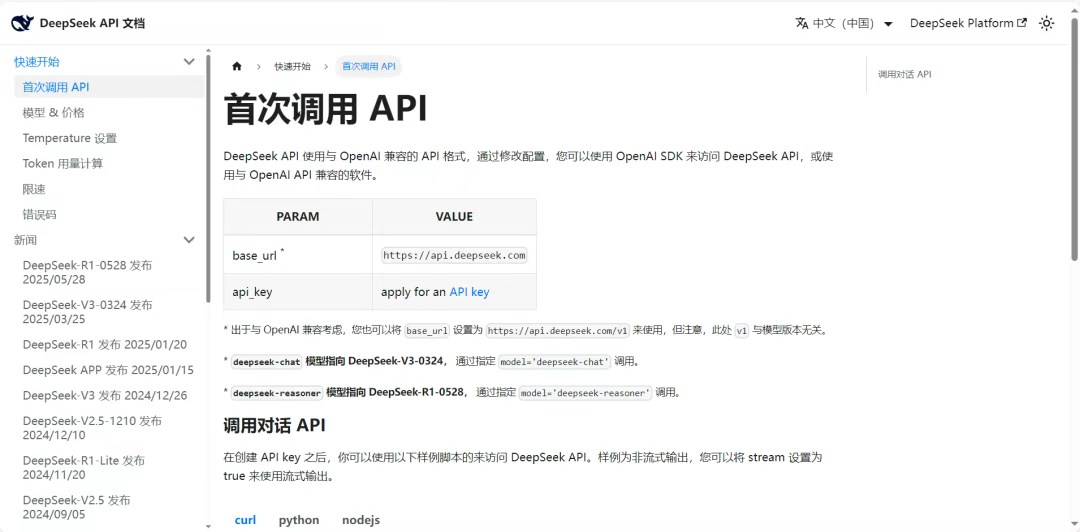

获取base-url进行配置(出于与 OpenAI 兼容考虑,您也可将base_url设置为https://api.deepseek.com/v1来使用,但注意,此处v1与模型版本无关)

获取model-name进行配置。deepseek-chat模型指向DeepSeek-V3-0324,通过指定model='deepseek-chat’调用。deepseek-reasoner模型指向DeepSeek-R1-0528,通过指定model='deepseek-reasoner’调用。

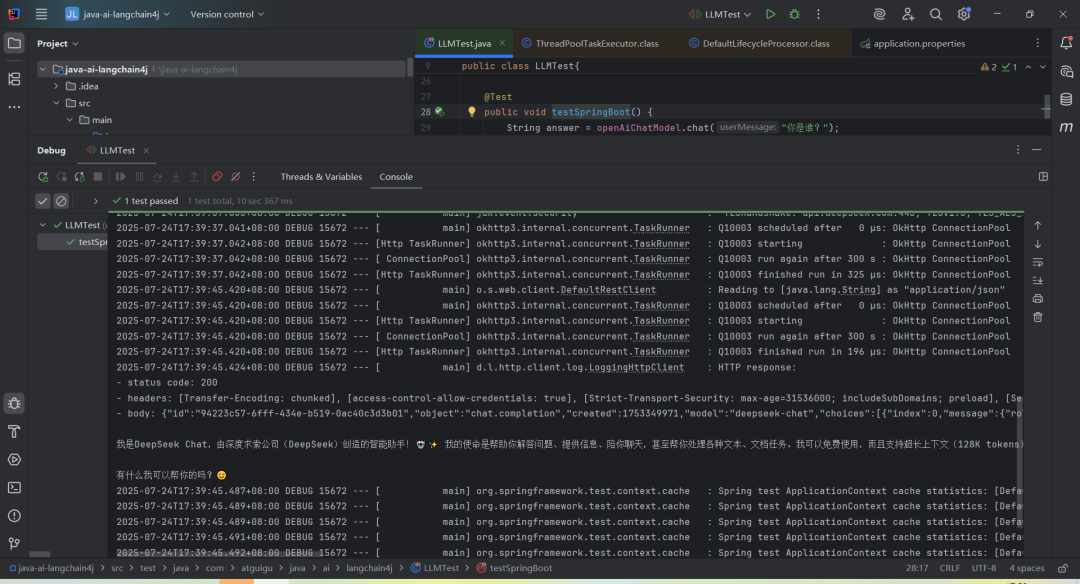

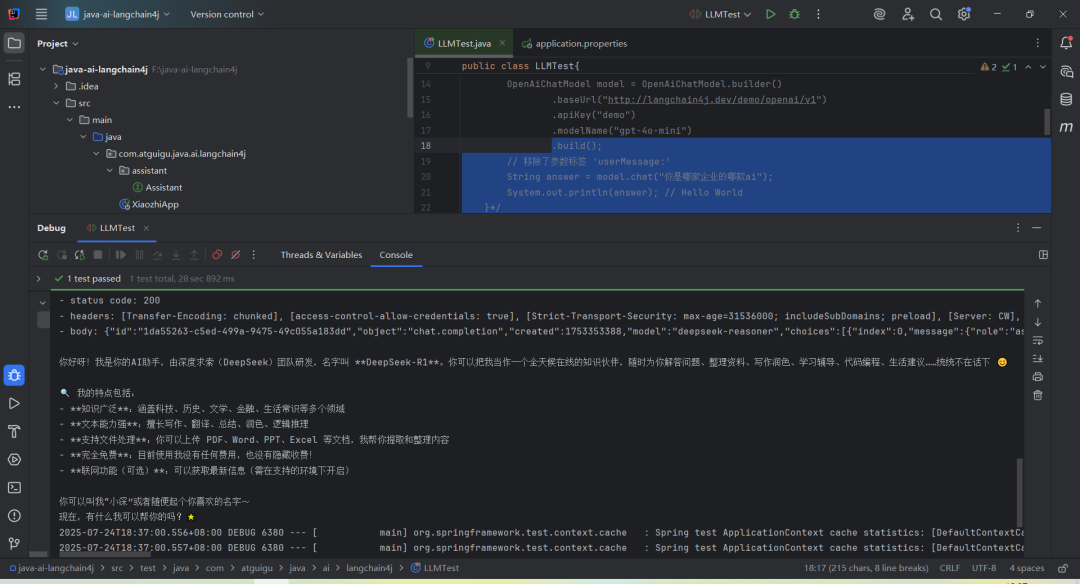

配置完之后使用测试用例进行测试,deepseek也是基于openai,所以测试用例代码不变,只是底层的配置参数需要进行变更

三 如果apikey值没有成功获取

1 尝试重启idea

点击菜单栏的File,选择Invalidate Caches,然后点击Just Restart,检查 IDEA是否单独配置了Environment Variables

2 对值进行添加

(1)打开运行配置点击顶部菜单栏:Run > Edit Configurations

(2)找到你的测试类配置在左侧列表中,展开JUnit或Spring Boot分类找到名为LLMTest的配置项(如果没有就创建一个)

(3)查看环境变量设置点击LLMTest配置项,在右侧配置面板中,找到Environment variables字段,点击右侧的**…**按钮(小齿轮图标)

(4)检查变量,弹出的窗口中会显示当前配置的变量,是否有设置DEEP_SEEK_API_KEY

(5)清理或添加,如果这里有值但不正确,点击**“-“删除它,如果这里为空**,但你想强制指定,点击**”+”**添加

(6)应用并关闭,点击OK保存配置点击Apply或OK关闭窗口

按照上述方式排除问题后进行测试

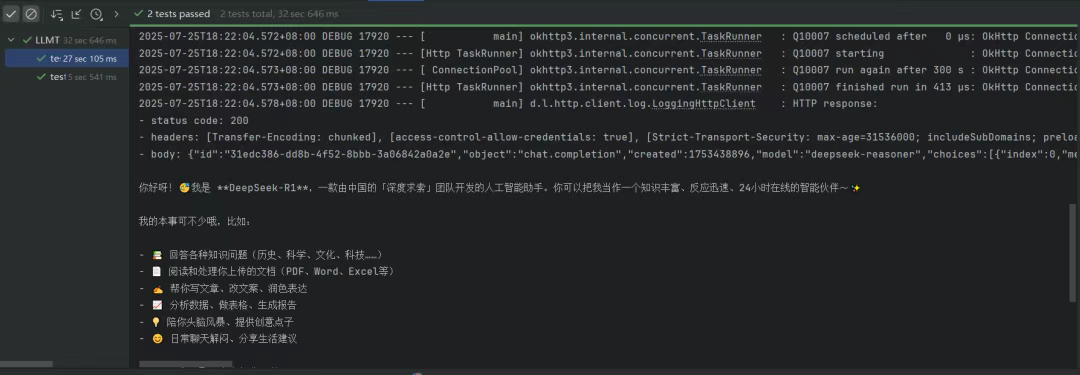

对底层输出的日志情况进行分析

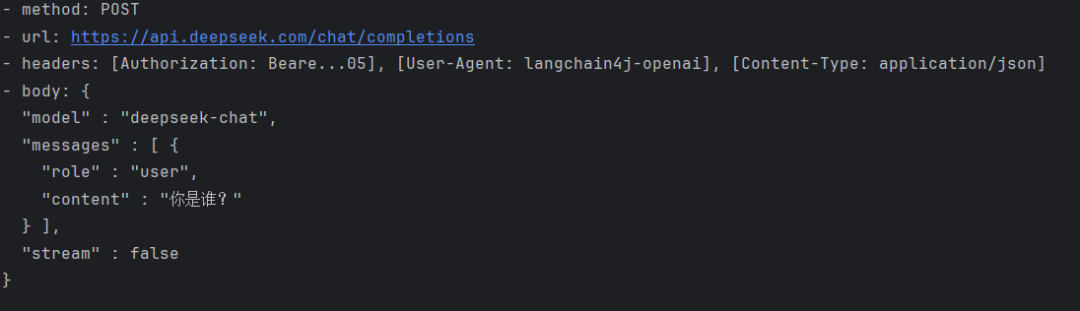

底层客户端给deepseek远程服务器发送请求https://api.deepseek.com/chat/completions实际上底层的请求地址被api封装起来了

大模型给的回复状态是200 代表回复成功,回复的内容为body,在响应体当中将调用大语言模型转换为推理模型

ollama本地部署

Ollama 是一个本地部署大模型的工具。使用 Ollama 进行本地部署有以下多方面的原因:

数据隐私与安全:对于金融、医疗、法律等涉及大量敏感数据的行业,数据安全至关重要。离线可用性:在网络不稳定或无法联网的环境中,本地部署的 Ollama 模型仍可正常运行。降低成本:云服务通常按使用量收费,长期使用下来费用较高。而 Ollama 本地部署,只需一次性投入硬件成本,对于需要频繁使用大语言模型且对成本敏感的用户或企业来说,能有效节约成本。部署流程简单:只需通过简单的命令 “ollama run < 模型名>”,就可以自动下载并运行所需的模型。灵活扩展与定制:可对模型微调,以适配垂直领域需求。

部署流程

一 下载并安装ollama

官网: https://ollama.com/

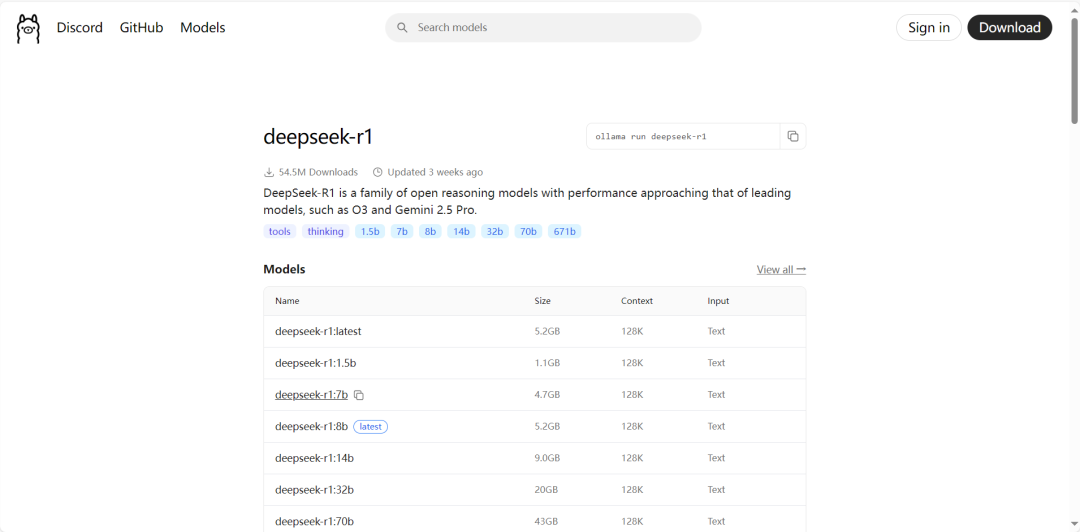

查看模型列表,选择要部署的模型,模型列表: https://ollama.com/search

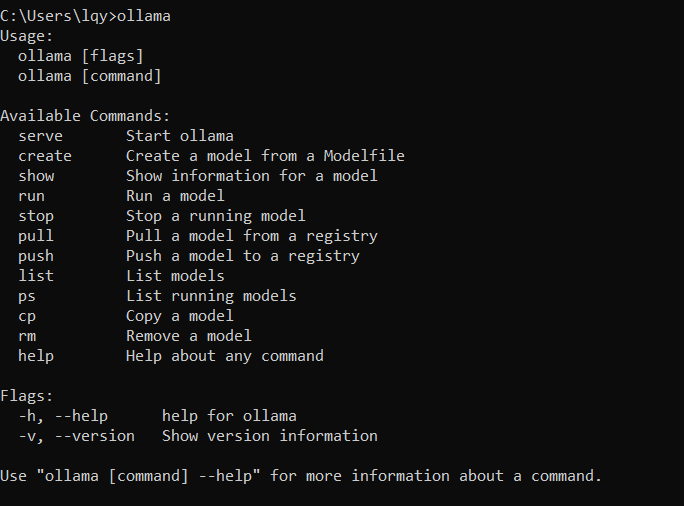

windows+r->cmd

显示安装成功

搜索对应的大语言模型

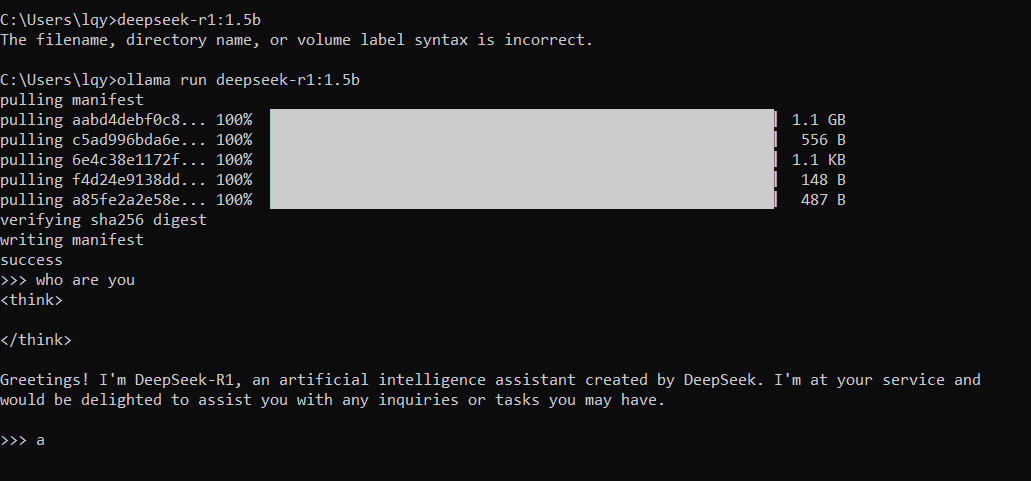

在ollama上部署大模型成功,除了deepseek-r1之外也可以选择部署其它的大模型,之后可以使用命令在本地调用大模型ollama run deepseek-r1:1.5b

二 引入spring-boot应用程序

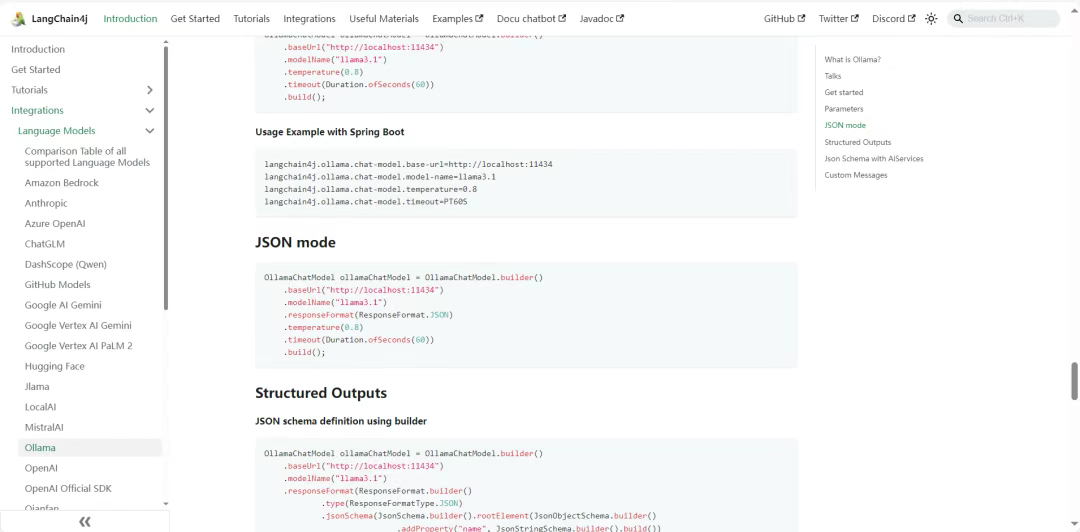

参考文档:https://docs.langchain4j.dev/integrations/language-models/ollama#get-started

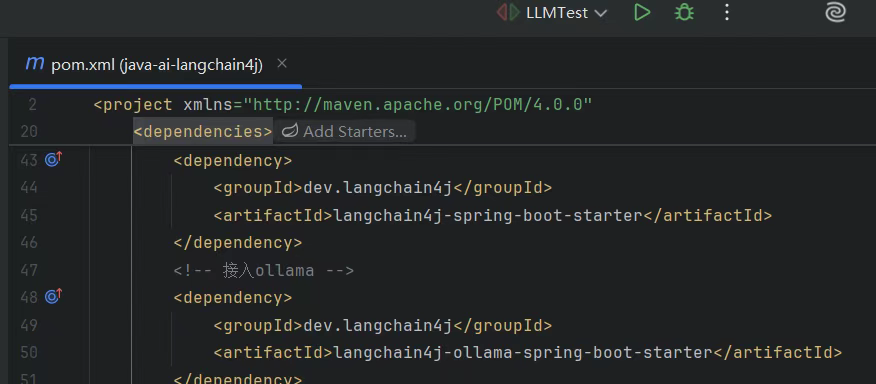

引入依赖

dev.langchain4jlangchain4j-ollama-spring-boot-starter

maven面板中检查langchain4j-ollama依赖是否成功导入

langchain4j.ollama.chat-model.base-url=http://localhost:11434langchain4j.ollama.chat-model.model-name=deepseek-r1:1.5b#替换为自己本地引入的模型名langchain4j.ollama.chat-model.temperature=0.8langchain4j.ollama.chat-model.timeout=PT60S

application.properties

使用测试用例进行测试

/*** ollama接入*/@Autowiredprivate OllamaChatModel ollamaChatModel;@Testpublic void testOllama() {//向模型提问String answer = ollamaChatModel.chat("你好");//输出结果System.out.println(answer);}

最后

为什么要学AI大模型

当下,⼈⼯智能市场迎来了爆发期,并逐渐进⼊以⼈⼯通⽤智能(AGI)为主导的新时代。企业纷纷官宣“ AI+ ”战略,为新兴技术⼈才创造丰富的就业机会,⼈才缺⼝将达 400 万!

DeepSeek问世以来,生成式AI和大模型技术爆发式增长,让很多岗位重新成了炙手可热的新星,岗位薪资远超很多后端岗位,在程序员中稳居前列。

与此同时AI与各行各业深度融合,飞速发展,成为炙手可热的新风口,企业非常需要了解AI、懂AI、会用AI的员工,纷纷开出高薪招聘AI大模型相关岗位。

最近很多程序员朋友都已经学习或者准备学习 AI 大模型,后台也经常会有小伙伴咨询学习路线和学习资料,我特别拜托北京清华大学学士和美国加州理工学院博士学位的鲁为民老师给大家这里给大家准备了一份涵盖了AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频 全系列的学习资料,这些学习资料不仅深入浅出,而且非常实用,让大家系统而高效地掌握AI大模型的各个知识点。

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

AI大模型系统学习路线

在面对AI大模型开发领域的复杂与深入,精准学习显得尤为重要。一份系统的技术路线图,不仅能够帮助开发者清晰地了解从入门到精通所需掌握的知识点,还能提供一条高效、有序的学习路径。

但知道是一回事,做又是另一回事,初学者最常遇到的问题主要是理论知识缺乏、资源和工具的限制、模型理解和调试的复杂性,在这基础上,找到高质量的学习资源,不浪费时间、不走弯路,又是重中之重。

AI大模型入门到实战的视频教程+项目包

看视频学习是一种高效、直观、灵活且富有吸引力的学习方式,可以更直观地展示过程,能有效提升学习兴趣和理解力,是现在获取知识的重要途径

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

海量AI大模型必读的经典书籍(PDF)

阅读AI大模型经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验。对于想要深入学习AI大模型开发的读者来说,阅读经典书籍是非常有必要的。

600+AI大模型报告(实时更新)

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

AI大模型面试真题+答案解析

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

2501

2501

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?