本文提出了一种参数空间对齐的多模态大模型范式,该范式将输入图像特征转换成 LoRA 权重并合并到 LLM 中,使 LLM 感知图像视觉信息。该范式避免了在 LLM 的输入序列中引入视觉标记,在训练和推理上都非常高效。论文已被 NeurIPS 2024 接收,论文链接和代码均已公开,欢迎交流。

前排提示,文末有大模型AGI-优快云独家资料包哦!

输入空间对齐范式

1.1 介绍

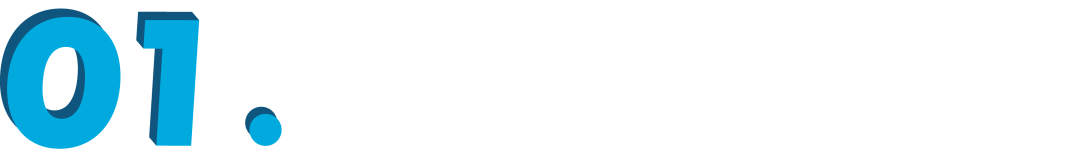

在进入正题之前,我们先简单回顾一下当前主流的 MLLM 范式。以最具代表性的 LLaVA [1] 为例:

▲ Figure 1. LLaVA的结构框图

对于输入的图像 ,通过视觉编码器(Vision Encoder)和映射模块(Projection)提取特征,得到一个由视觉标记(Visual Tokens)组成的视觉序列,然后将视觉序列和文本在序列维度上拼接,一同输入到 LLM 中进行训练。在训练过程中,视觉序列是在对齐 LLM 的输入空间以让 LLM 能够理解视觉信息,我们称这种范式为输入空间对齐范式。

输入空间对齐范式有 2 个特点:

1. 视觉信息序列化,和文本信息具有相同的表现形式 图像经过视觉编码器之后会变成视觉标记,然后通过映射模块映射到和文本标记(Text Tokens)相同的特征维度,最后形成了和文本信息相同的表现形式,即序列。

2. MLLM 中视觉和文本的模态交互通过注意力机制进行 视觉信息序列化之后,会将视觉序列与文本序列在序列维度上拼接,然后同时输入给 LLM。在前向传播的过程中,视觉与文本通过注意力机制产生模态交互。

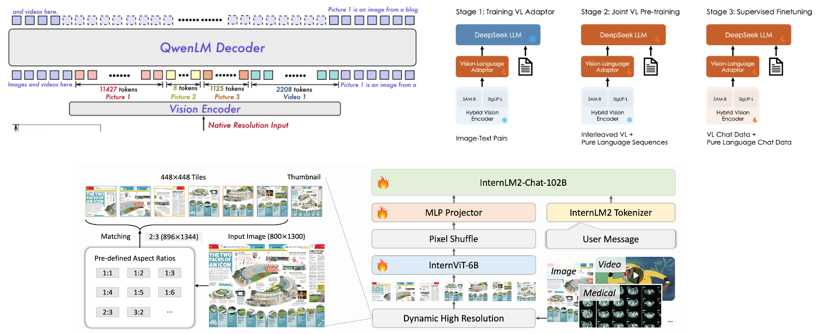

目前主流 MLLM 遵从输入空间对齐范式,比如 Qwen2-VL [2],DeepSeek-VL [3],和 InternVL2 [4],如 Figure 2 所示。

▲ Figure 2. 输入空间对齐范式:Qwen2-VL, DeepSeek-VL 和 InternVL2

1.2 问题

输入空间对齐范式使用 CLIP 可以很容易将视觉特征对齐到 LLM 输入空间,因为 CLIP 的视觉特征预先和文本对齐过,本身具备丰富的语义信息,但是在训练和推理时计算效率低。

在输入序列达到一定长度的

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?