前言

一句话概括,苹果researcher发现了个不是秘密的秘密:与其假装不知道考试内容来训练模型,不如直接对着考纲复习——这不就是我们从小到大的应试教育智慧吗? (

第一阶段:识别核心概念

论文的Motivation分析

在训练大型语言模型(LLM)时,人人都知道数据质量至关重要。目前业界筛选海量网络数据的方法,很大程度上依赖于研究者的“直觉”或者一些间接的指标。比如,研究者会凭经验挑选一些他们认为“高质量”的网站或文本作为正面样本,来训练一个分类器去筛选整个数据集。然而,这个过程中“质量好”的定义非常模糊和主观。

但如果我们深入思考,会发现这些方法其实有一个隐含的目标:那就是让最终训练出的模型在大家公认的**评测基准(Benchmarks)**上取得好成绩。研究者们不断调整数据筛选策略,然后用评测分数来验证好坏,这本质上是一个以评测为目标的迭代优化过程。

论文作者敏锐地抓住了这一点,提出了一个直截了当的问题:既然我们最终都是在围绕着评测基准进行优化,那为什么不直接、显式地把“与评测基准相似”作为筛选预训练数据的标准呢?这就是这篇论文最核心的出发点——化隐为显,将数据筛选的目标直接对准我们衡量模型能力的标准。

*论文主要贡献点分析*

-

列出论文声称的主要创新点

-

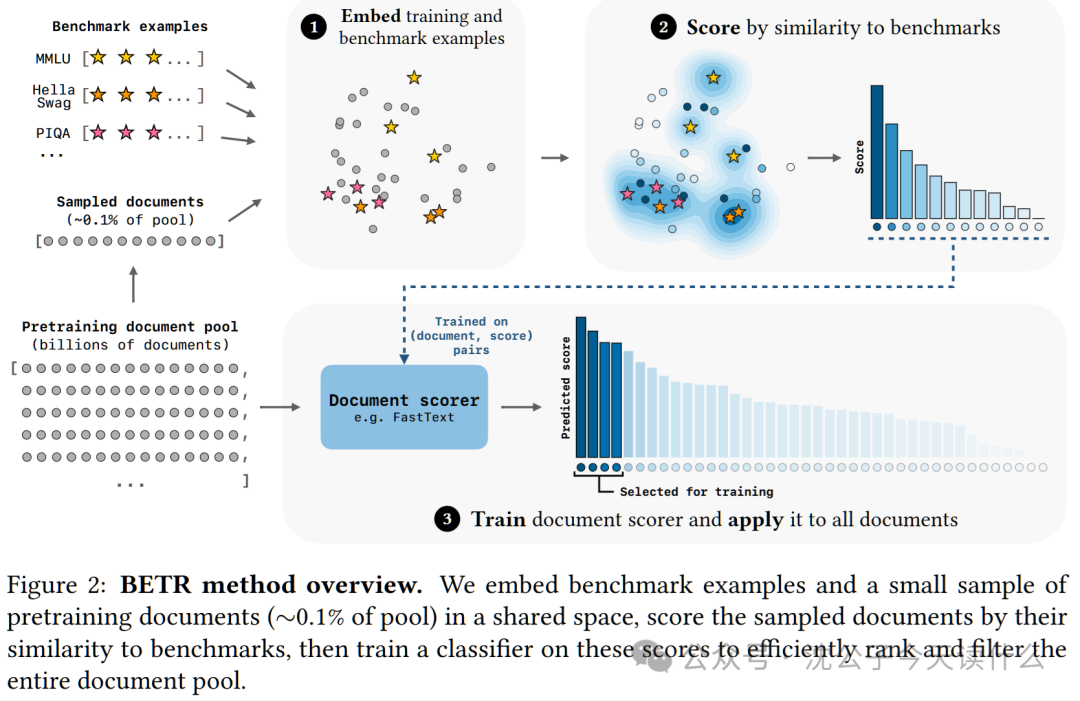

- 提出了BETR(Benchmark-Targeted Ranking)方法:这是一种新颖、简单且有效的数据筛选方法,其核心是根据预训练文档与评测基准(Benchmark)训练样本的相似度来进行排序和筛选。

- 揭示了数据筛选与模型规模的“标度率”(Scaling Law):论文通过海量实验发现,最佳的数据筛选强度(过滤掉多少比例的数据)并不是一成不变的,而是与模型的计算规模(FLOPs)存在明确的数学关系。具体来说,模型越大,所需的数据过滤就越“宽松”,应该保留更多样化的数据。

- 验证了“专业化”与“泛化”的可控性:通过BETR,可以精确地控制模型的能力倾向。如果目标是一组特定任务的评测集(如代码、数学),模型就会在这些任务上成为“专家”,但在其他任务上能力会下降。反之,如果目标是一组非常多样化的评测集,模型则会成为“通才”,在各项任务上表现均衡。

- 对“评测导向”的深刻反思(Goodhart’s Law):实验证明,当评测基准本身被用作优化目标时,它就不再是衡量模型通用能力的“好尺子”。专门为某套评测优化的模型,在未被评测的、更广泛的任务上表现会变差。这警示我们,过度优化少数几个评测集可能会导致模型能力的“窄化”。

-

找出支撑这些创新的关键技术或方法

-

-

三步走的筛选流程:这是实现BETR的核心技术,具体包含以下三个步骤:

嵌入与采样 (Embedding & Sampling):将所有目标评测基准的训练样本,以及一小部分(如0.1%)预训练数据池的文档,通过同一个模型(如BERT)转换成向量(Embedding)。

相似度打分 (Similarity Scoring):对于采样中的每一个文档,计算它与所有评测基准样本的相似度,并根据“与最相似的那个样本的匹配程度”给出一个分数。

训练代理分类器 (Proxy Classifier Training):因为对整个几十T的语料库进行向量相似度计算是不现实的,所以作者训练了一个轻量级的、速度极快的分类器(如FastText),让它学习去预测上一步得到的“相似度分数”。这个分类器就像一个高效的“代理”,能快速判断任何一个文档是否与评测基准相似。

-

大规模标度率实验 (Large-Scale Scaling Law Experiments):作者训练了超过500个不同大小、不同训练数据量的模型,通过拟合性能曲线,来系统性地比较不同数据筛选方法在不同计算规模下的优劣。这是支撑其“计算效率倍增”和“最佳过滤率随规模变化”等结论的关键。作者通过精心设计的消融实验,验证了BET-R方法中各个组件(如逐样本的对齐粒度、max聚合的打分函数、轻量级的FastText代理分类器)都是最优或最合适的选择。

-

-

论文有哪些显著性的结果

-

- 显著的计算效率提升:在相同的模型性能下,使用BETR方法筛选的数据进行训练,比之前最先进的基线方法(DCLM-Baseline)节省了近一半(1.8x-2.8x)的计算资源,比不过滤数据则节省了约80%(4.7x)的资源。这是一个在工业界极具吸引力的成果。

- 可量化的最佳过滤率公式:论文给出了一个类似 的公式,其中是最佳过滤数据百分比,是计算规模。这意味着,当你的算力预算增加时,你应该如何调整你的数据筛选策略,这从“炼丹玄学”变成了“工程科学”。

- 对AI评测的警示:通过对比模型在目标内(CORE)和目标外(NONCORE)评测集上的表现,实验结果清晰地展示了“评测污染”的后果,即过度优化评测集会导致模型在真实世界中的泛化能力下降。这对于整个大模型评测领域都有着重要的指导意义。

*理解难点识别*

-

分析哪些概念/方法是理解论文的关键

-

- BETR的核心机制:整个三步走的流程(嵌入->打分->训练代理分类器)是论文方法论的基石。理解这个流程,就理解了论文是怎么做的。

- 最大化聚合打分策略 (Max Aggregation):在打分阶段,为什么一个文档的分数取决于它与“某一个”评测样本的最佳匹配度,而不是与“所有”评测样本的平均匹配度?这个设计选择非常关键,直接影响了筛选出的数据特性。

- 代理分类器的作用:为什么不直接用Embedding模型算相似度,而要多此一举训练一个FastText分类器?这涉及到工程上的可扩展性问题,是方法能应用到海量数据上的核心。

- 标度率分析(Scaling Law Analysis):论文中大量的图表都基于标度率,理解其基本思想(模型性能如何随计算量、模型大小、数据量变化)是看懂论文大部分实验结论的前提。

-

找出这些概念中最具挑战性的部分

-

- BETR的三步流程,尤其是代理分类器的设计,对于初学者来说可能有些绕。它不是一个端到端的模型,而是一个巧妙的、分阶段的工程解决方案,核心是用一个高效的代理模型去模拟一个复杂但准确的打分过程。

-

确定需要重点解释的核心概念

-

- BETR方法本身。我们将重点解释这个三步流程,特别是它如何巧妙地解决了在海量数据上进行相似度筛选的效率问题。

*概念依赖关系*

- 切入点:数据筛选的“隐式目标”。首先我们要明白,传统方法虽然不说,但实际上就是在用评测分数指导数据筛选。

- 核心解释:BETR方法。然后引出本文的核心方案BETR,就是要把这个目标“显式化”。这里,将详细拆解其三步流程,并解释其设计背后的逻辑。

- 支撑证据:实验结果。在解释清楚BETR是什么之后,再来看它的效果如何。这里会介绍它带来的计算效率提升(显著性结果)。

- 深度洞察:标度率与评测反思。最后,拔高一层,探讨从这些实验中能学到的更深层次的规律,如最佳过滤率与模型规模的关系,以及对当前大模型评测文化的思考。

*第二阶段:深入解释核心概念——BETR方法*

*设计生活化比喻:招聘“精英学徒”*

想象一下,你是一位传奇工匠大师,比如是一位顶级的“高达模型制作大师”。你想从成千上万的申请者中,招募一批最有潜力的学徒来继承你的技艺。

- 海量申请者 (Pretraining Data Pool):你的邮箱里有数百万份学徒申请邮件,每封邮件都是一份自我介绍,说明了他们的背景和作品。这是个巨大的、未经筛选的人才库。

- 你的梦之队 (Benchmark Examples):你手下已经有100位非常出色的核心弟子,他们每个人都代表了你希望学徒具备的某一种或几种特质。比如,弟子A擅长精细打磨,弟子B擅长创意涂装,弟子C擅长结构改造等等。这100位弟子就是你的“黄金标准”或“评测基准”。

- 你的目标:从数百万申请者中,最高效地找出那些最像你“梦之队”成员的候选人,把他们筛选出来进行重点培养(训练LLM)。

直接让这100位弟子去面试数百万申请者,显然是不现实的,太耗时耗力了。于是,你设计了一个三步走的智能招聘流程。

*建立比喻与实际技术的对应关系*

| 比喻中的关键元素 | 对应的实际技术概念 | 为什么对应关系合理 |

|---|---|---|

| 海量申请者邮件 | 预训练文档库 (Pretraining Document Pool),如CommonCrawl | 两者都是规模巨大、内容混杂、需要被筛选的原始信息来源。 |

| 100位“梦之队”核心弟子 | 评测基准的训练样本 (Benchmark Training Examples),如MMLU、HellaSwag的题目 | 两者都是我们期望模型最终能掌握的“理想能力”的具象化体现,是筛选的“靶子”。 |

| 对弟子和申请者进行“深度能力评估” | 使用Embedding模型(如BERT)进行向量化 | 这个“深度能力评估”会把每个人的特长、风格、知识背景等抽象特质,转化成一个多维度的能力图谱(向量)。向量空间中的“距离”就代表了两个人能力上的“相似度”。 |

| 从百万申请者中随机抽取1万份进行试审 | 对预训练文档库进行随机采样 (Sampling) | 由于无法评估所有人,我们先从一个有代表性的小样本入手,来摸清规律。 |

| “潜力分数”的计算方法 | 相似度打分函数 (Similarity Scoring Function),特别是max聚合 | 你认为,一个申请者只要在某一个方面极致地像你梦之队中的某一位弟子,他就潜力巨大。这对应了max聚合:文档只要与某一个评测样本高度相似,就能获得高分。 |

| 训练一位“AI招聘助理” | 训练一个轻量级分类器 (Training a Lightweight Classifier),如FastText | 你让这位AI助理学习那1万份试审过的申请材料和对应的“潜力分数”,学会仅通过快速扫一眼邮件文本,就能大致判断出这个申请者的潜力高低。这对应了用(文档,分数)对来训练FastText。 |

| AI助理快速筛选所有申请者 | 代理分类器对整个文档库进行打分和排序 | AI助理非常高效,可以在短时间内处理数百万封邮件,给出排序。这对应了FastText可以极快地处理TB级别的文本数据。 |

| 最终筛选出的“精英学徒”名单 | 最终用于训练LLM的高质量数据集 | 这就是我们费尽心思想要得到的结果——一个规模可控、质量上乘、与目标任务高度相关的预训练数据集。 |

*深入技术细节*

从比喻回到现实,看看技术和公式是如何实现的。

第一步:嵌入与采样 (Embedding & Sampling) 就像对弟子和申请者进行“深度能力评估”一样,BETR首先需要将文本转化为计算机能理解的数学形式——向量。

-

技术实现:选择一个强大的文本嵌入模型(如论文中使用的

Arctic-Embed L 2.0)。 -

- 拿来所有的评测基准的训练样本 。

- 从巨大的预训练文档库 中,随机采样一小部分,比如1000万个文档,构成一个样本集 。

- 将 和 中的每一个文本都输入到嵌入模型中,得到它们各自的向量表示。

第二步:为采样文档打分 (Scoring the Sampled Documents) 这是最核心的一步,决定了“什么样的数据是好的”。

-

技术原理:论文发现,奖励那些与任何一个评测样本“极致”相似的文档,效果最好。这通过一个基于“秩次”(rank)的打分函数和“最大化聚合”(max aggregation)来实现。

-

相关数学公式:

-

-

首先,对于样本集中的任何一个文档 和任何一个评测基准样本 ,我们可以计算它们的相似度(通常是向量的余弦相似度)。基于这个相似度,我们可以将 中的所有文档进行排序,得到 相对于 的秩次。(比如, 意味着 是所有采样文档中与 最相似的那个)。

-

接着,定义一个价值函数 ,它给秩次赋予一个分数。一个简单的例子是 ,这意味着秩次越高(r越小),价值越大。

-

最后,一个文档 的最终分数 是它从所有评测样本那里得到的最高价值分。

-

原始数学形式:

-

符号替换版本:

文档j的最终潜力分=在所有评测样本i中取最大值{由(文档j相对于评测样本i的相似度排名)决定的价值分}这里的 在论文的实践中被设定为 ,这使得公式更具体:

文档j的最终潜力分=在所有评测样本i中取最大值{1 / (文档j相对于评测样本i的相似度排名)}

-

第三步:训练并应用代理分类器 (Training and Applying the Proxy Classifier)

-

技术原理:直接对上万亿的文本数据进行第二步操作是无法想象的。因此,我们利用在采样数据上得到的

(文档, 分数)对,训练一个“学生”模型来模仿这个打分过程。这个“学生”模型必须非常快,FastText 就是一个完美的选择。 -

技术实现:

-

- 制作训练标签:将第二步得到的带有分数的采样文档集 ,根据分数高低划分为“高潜力”(如分数排名前10%)和“普通潜力”(后90%)两类。这就构成了一个二分类任务的训练集。

- 训练分类器:以文档原文为输入,以“高/普通潜力”为标签,训练一个FastText分类器。

- 大规模预测:将这个训练好的FastText分类器,应用到整个巨大的预训练文档库 上。由于FastText极快的推理速度,这一步在工程上是可行的。

- 最终筛选:根据FastText给出的分数(属于“高潜力”类的概率),对所有文档进行排序,并筛选出排名最靠前的 的文档,形成最终的预训练数据集。

*将技术细节与比喻相互映射*

-

公式与比喻: 这条公式在我们的比喻中体现得淋漓尽-致。

-

- :核心弟子

i审阅完所有1万份申请后,给申请者j打的排名。 - :这个排名的含金量。排名第1()的含金量远高于排名第100()的。

- :招聘官不关心一个申请者是不是“各方面都还行”,而是关心他/她有没有任何一个“闪光点”能得到某位核心弟子的极度认可(排名第一)。只要申请者

j被任何一位弟子i排在首位,他的最终潜力分就最高。这正是论文中“奖励与任何单个基准示例高度相关的文档”的思想。

- :核心弟子

-

比喻的帮助:

-

- “AI招聘助理”的比喻很好地解释了为什么需要第三步。它直观地展现了用一个轻量模型去近似一个复杂评估过程的思想,解决了可扩展性的核心矛盾。

- “梦之队”和“海量申请者”的比喻,清晰地区分了Benchmark和Pretraining Pool这两个关键角色,以及它们在整个流程中的作用。

-

比喻的局限性:

-

- 这个比喻简化了“能力评估”的复杂性。在现实中,文本嵌入捕捉的是语义、风格、知识等多方面的综合信息,比喻中的“打磨”、“涂装”等技能点要简单得多。

- 比喻没有很好地体现“不同评测基-准(弟子)贡献度不同”的现象(论文Table 10),但在解释核心机制上已足够。

*总结*

- 核心联系重申:BETR方法就像一个智能化的精英学徒招聘系统。它通过深度分析一小批成功样本(“梦之队”弟子)和申请者样本,定义了什么是“潜力”,然后训练一个高效的AI助理,让它去快速筛选海量的申请者,最终找到最有价值的候选人。

- 关键数学原理总结:其核心数学原理 告诉我们,在筛选数据时,我们应该寻找那些在**某些特定方面表现“极致”**的“偏科生”,而不是门门功课都80分的“平均生”。这种策略被证明是极其有效的。

*第三阶段:详细说明流程步骤*

假设我们的输入是:

- 原始数据池

D:一个包含数十亿文档的庞大语料库(例如,论文中使用的DCLM-RefinedWeb,含有24T tokens)。 - 目标评测集 B:一个或多个我们希望模型表现优异的评测基准的训练集部分(例如,MMLU, HellaSwag等10个

COREbenchmarks的训练样本)。

我们的目标是得到一个输出:

- 筛选后的数据子集

D_filtered:这是从D中筛选出的一个子集(例如,保留原始数据中token数量排名前10%的文档),用于从头开始训练一个新的语言模型。

以下是完整的处理流程:

流程第一步:数据准备与向量化(Embedding)

这一步的目标是将文本数据转换成机器可以进行相似度计算的数学表示——向量。

-

采样预训练文档:由于原始数据池

D过于庞大,无法直接处理。我们首先从中随机抽取一个具有代表性的小规模样本集,记为D_sample。在论文中,作者从万亿级别的D中采样了1000万(10M)个文档。这个数量既要足够大以捕捉原始数据的多样性,又要足够小以保证后续计算的可行性。 -

准备评测样本:收集所有目标评测集

B的训练样本。如果一个样本包含问题、上下文、答案等多个部分,需要将它们拼接成一个单一的文本文档。 -

统一向量化:选择一个预训练好的文本嵌入模型(Embedding Model),例如论文中使用的

Arctic-Embed L 2.0。然后,将D_sample中的每一个文档和B中的每一个评测样本,都独立地输入到这个嵌入模型中。 -

- 处理

D_sample后,我们得到一个文档向量集合,记为E_D = {e_d1, e_d2, ..., e_d10M}。 - 处理

B后,我们得到一个评测样本向量集合,记为E_B = {e_b1, e_b2, ..., e_bm}(m是评测样本总数,论文中CORE评测集约有14000个样本)。

- 处理

流程第二步:为采样文档计算“潜力分数”

这是BETR方法的核心,它定义了什么样的文档是“好”的。

-

计算相似度矩阵(逻辑上的):对于

D_sample中的每一个文档向量e_dj,计算它与E_B中每一个评测样本向量e_bi的余弦相似度。这会形成一个10M x m的巨大相似度矩阵。 -

计算秩次(Ranking):对于每一个评测样本

b_i,我们可以根据它与D_sample中所有文档的相似度,对这1000万个文档进行降序排序。这样,每个文档d_j都会得到一个相对于b_i的秩次r_ij。例如,如果d_j是与b_i最相似的文档,则。 -

计算价值(Valuing):将秩次

r_ij通过一个价值函数v(r)转换成分数。论文的实验表明,使用陡峭的函数如效果很好,它极大地奖励排名靠前的文档。 -

聚合得到最终分数(Aggregation):对于每个文档

d_j,它现在有m个来自不同评测样本的价值分数。BETR采用最大化聚合策略来计算其最终的“潜力分数”S_j。这意味着,文档

d_j的最终分数,等于它在所有m个评测样本的“偏爱榜”上所获得的最高分。只要有一个评测样本b_i认为d_j是“天选之子”(即r_ij非常小),d_j的最终分数S_j就会非常高。

此步骤处理完成后,我们的D_sample中的每个文档d_j都有了一个对应的潜力分数S_j。我们得到了一个包含1000万个 (文档文本, 分数) 对的数据集,这是下一步的输入。

流程第三步:训练并应用代理评分器(Proxy Scorer)

这一步的目的是训练一个“廉价且高效”的模型,来模拟昂贵的第二步,并将其推广到整个原始数据池D。

- 创建分类任务标签:将刚刚得到的

10M个带分数的文档,根据分数进行排序。然后设定一个阈值,例如前10%,将这些文档标记为“正样本”(label=1),其余90%标记为“负样本”(label=0)。这样,我们就把一个回归问题(预测分数)转化成了一个二分类问题。 - 平衡数据集并训练:由于正负样本极不均衡(1:9),在训练前需要对负样本进行降采样(downsampling),使得正负样本比例大致均衡。然后,使用这个平衡后的数据集,以文档的原始文本为特征,以0/1的标签为目标,训练一个FastText分类器。FastText模型简单、速度快,非常适合处理海量文本。

- 对全量数据进行评分:将这个训练好的FastText分类器应用到**整个原始数据池

D**中的每一个文档上。对于每个文档,分类器会输出一个它属于“正样本”的概率。这个概率值就作为该文档的最终排序分数。 - 过滤并生成最终数据集:根据FastText输出的分数,对原始数据池

D中的所有文档进行降序排序。然后,从头开始遍历这个排序列表,不断将文档加入到最终的数据集D_filtered中,直到D_filtered中所有文档的累计token数量达到预设的比例(例如,原始数据池D总token数的10%)。

至此,整个流程结束。我们从一个庞大混杂的原始数据池D和一个目标评测集B出发,通过采样向量化 -> 相似度打分 -> 训练代理分类器 -> 全量打分过滤这四个环环相扣的步骤,最终得到了一个高质量、与目标任务高度相关的预训练数据集D_filtered。这个数据集可以被用来训练一个全新的、性能更强、计算效率更高的语言模型。

最后

为什么要学AI大模型

当下,⼈⼯智能市场迎来了爆发期,并逐渐进⼊以⼈⼯通⽤智能(AGI)为主导的新时代。企业纷纷官宣“ AI+ ”战略,为新兴技术⼈才创造丰富的就业机会,⼈才缺⼝将达 400 万!

DeepSeek问世以来,生成式AI和大模型技术爆发式增长,让很多岗位重新成了炙手可热的新星,岗位薪资远超很多后端岗位,在程序员中稳居前列。

与此同时AI与各行各业深度融合,飞速发展,成为炙手可热的新风口,企业非常需要了解AI、懂AI、会用AI的员工,纷纷开出高薪招聘AI大模型相关岗位。

最近很多程序员朋友都已经学习或者准备学习 AI 大模型,后台也经常会有小伙伴咨询学习路线和学习资料,我特别拜托北京清华大学学士和美国加州理工学院博士学位的鲁为民老师给大家这里给大家准备了一份涵盖了AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频 全系列的学习资料,这些学习资料不仅深入浅出,而且非常实用,让大家系统而高效地掌握AI大模型的各个知识点。

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

AI大模型系统学习路线

在面对AI大模型开发领域的复杂与深入,精准学习显得尤为重要。一份系统的技术路线图,不仅能够帮助开发者清晰地了解从入门到精通所需掌握的知识点,还能提供一条高效、有序的学习路径。

但知道是一回事,做又是另一回事,初学者最常遇到的问题主要是理论知识缺乏、资源和工具的限制、模型理解和调试的复杂性,在这基础上,找到高质量的学习资源,不浪费时间、不走弯路,又是重中之重。

AI大模型入门到实战的视频教程+项目包

看视频学习是一种高效、直观、灵活且富有吸引力的学习方式,可以更直观地展示过程,能有效提升学习兴趣和理解力,是现在获取知识的重要途径

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

海量AI大模型必读的经典书籍(PDF)

阅读AI大模型经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验。对于想要深入学习AI大模型开发的读者来说,阅读经典书籍是非常有必要的。

600+AI大模型报告(实时更新)

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

AI大模型面试真题+答案解析

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?