你是否遇到过这些痛点?

- 想微调大模型,却被高昂的GPU成本和复杂的部署流程劝退?

- 数据准备繁琐,训练参数调优像“玄学”,结果难以复现?

- 缺乏一站式工具,从模型选择到训练监控全靠手动拼凑?

SuperTi算力平台 ,一款专为研发人员、程序员和AI从业者设计的算力租赁平台,用“开箱即用”的体验,彻底解决这些难题!

实战案例:用SuperTi微调DeepSeek-R1-Distill-Qwen-7B(附完整教程)

以开发者关注的中文化偏好模型优化为例,SuperTi如何实现高效微调?

1. 模型选择与实例创建

- Step 1:进入SuperTi平台“AI模型”界面,选择预装的DeepSeek-R1-Distill-Qwen-7B模型,

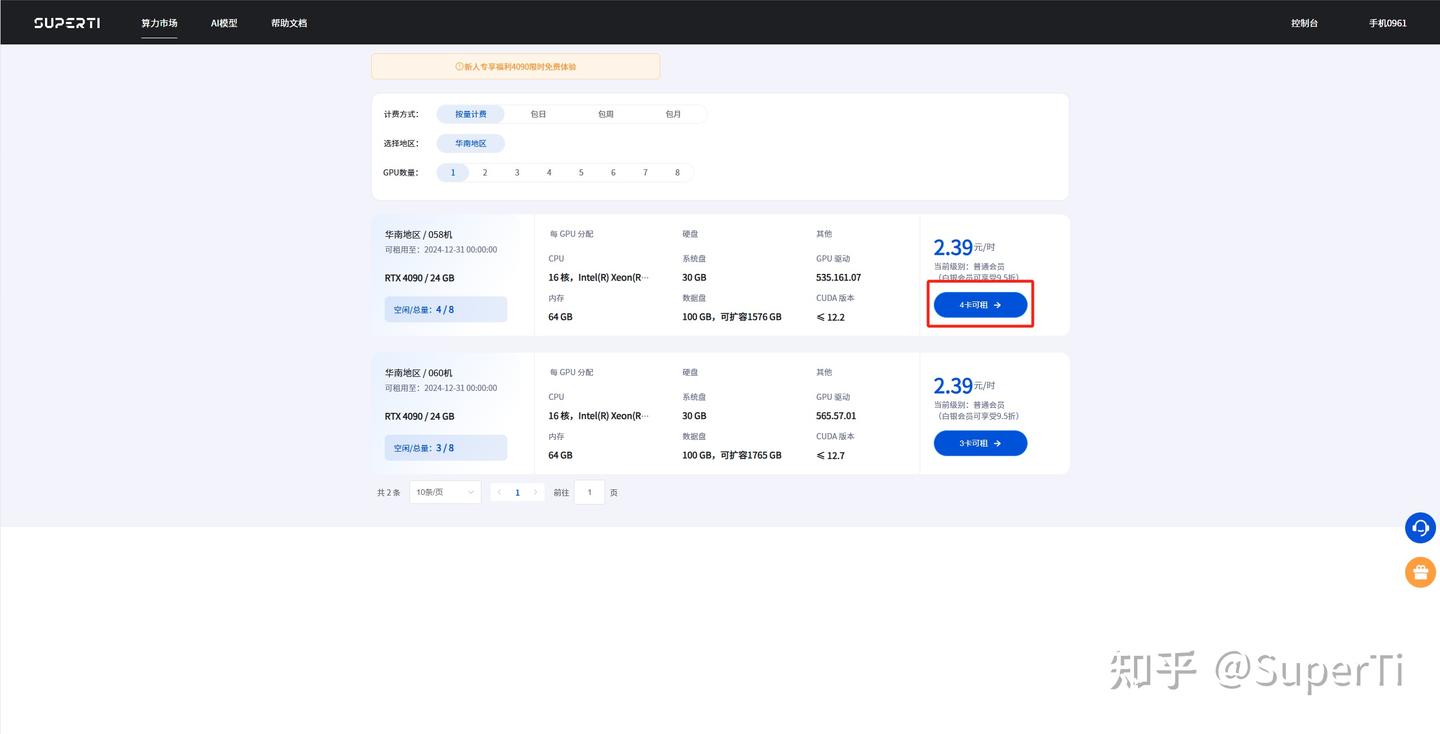

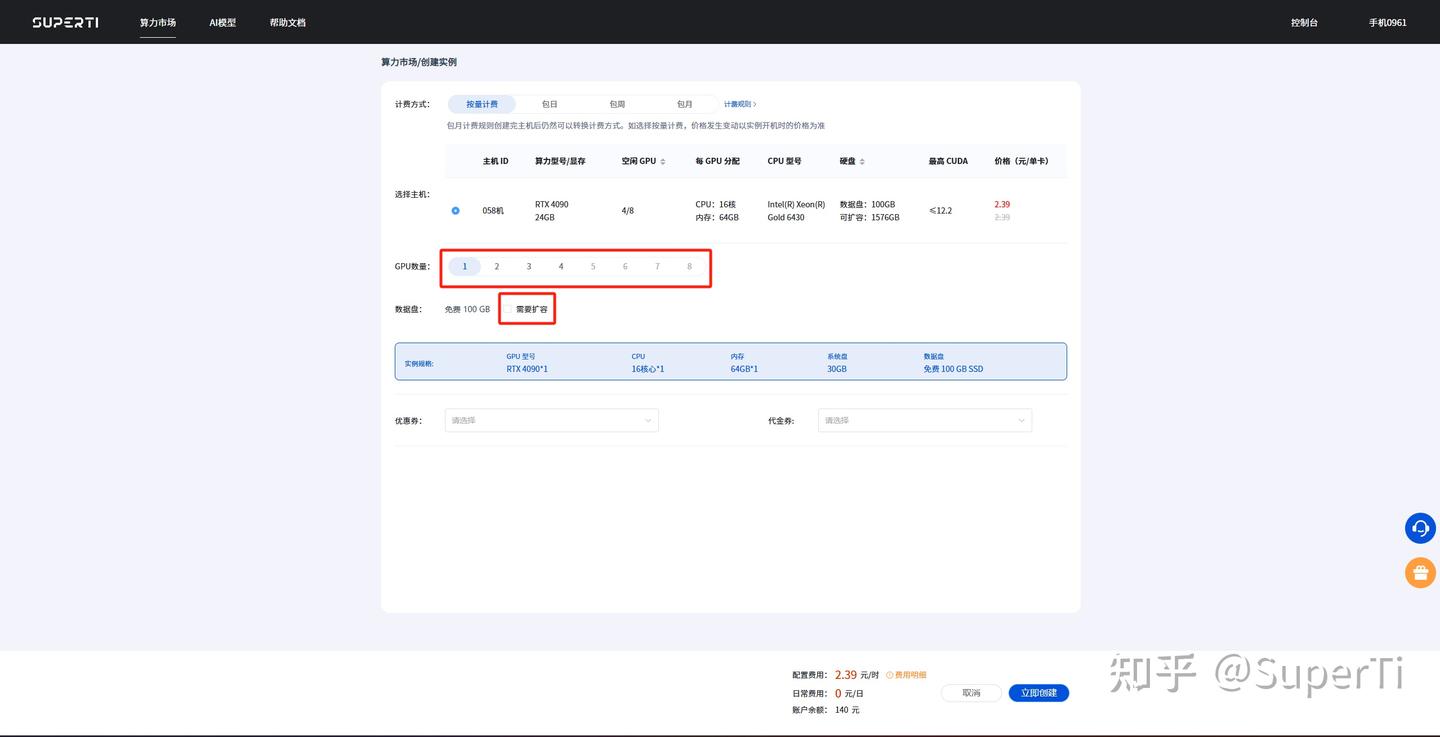

Step 2:在算力市场按需选择GPU机型(如4090),配置数据盘容量,快速完成实例创建。

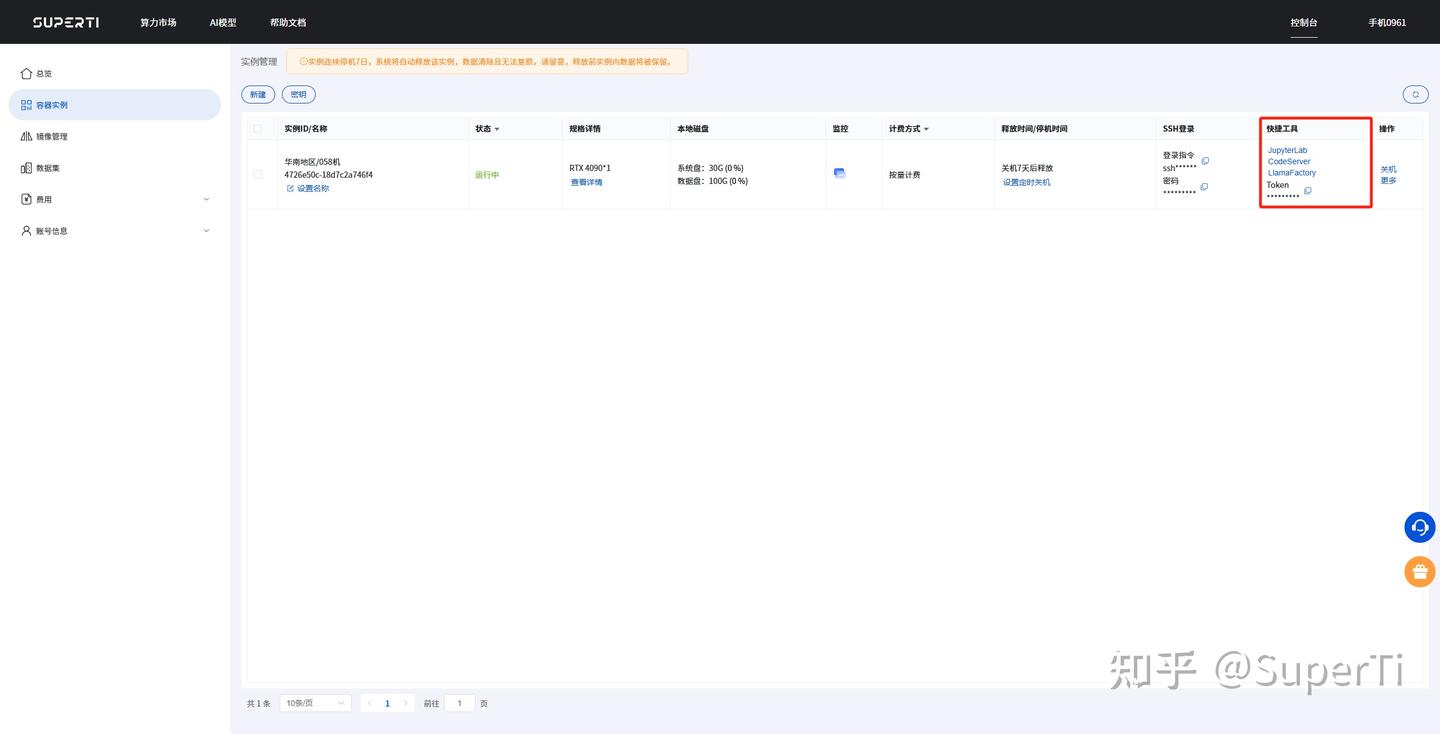

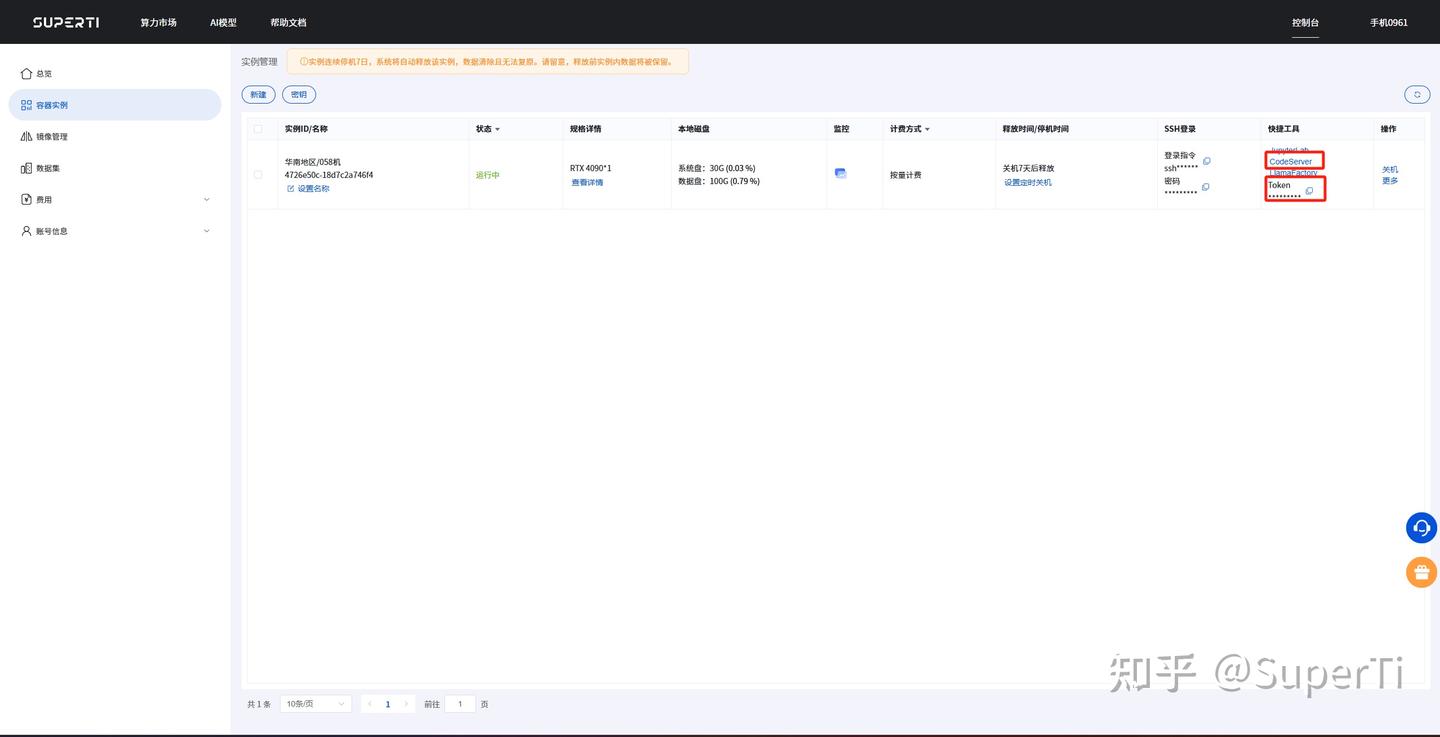

Step 3:在控制台实例快捷工具栏中,您可以找到JupyterLab、CodeServer和LlamaFactory的快捷入口。

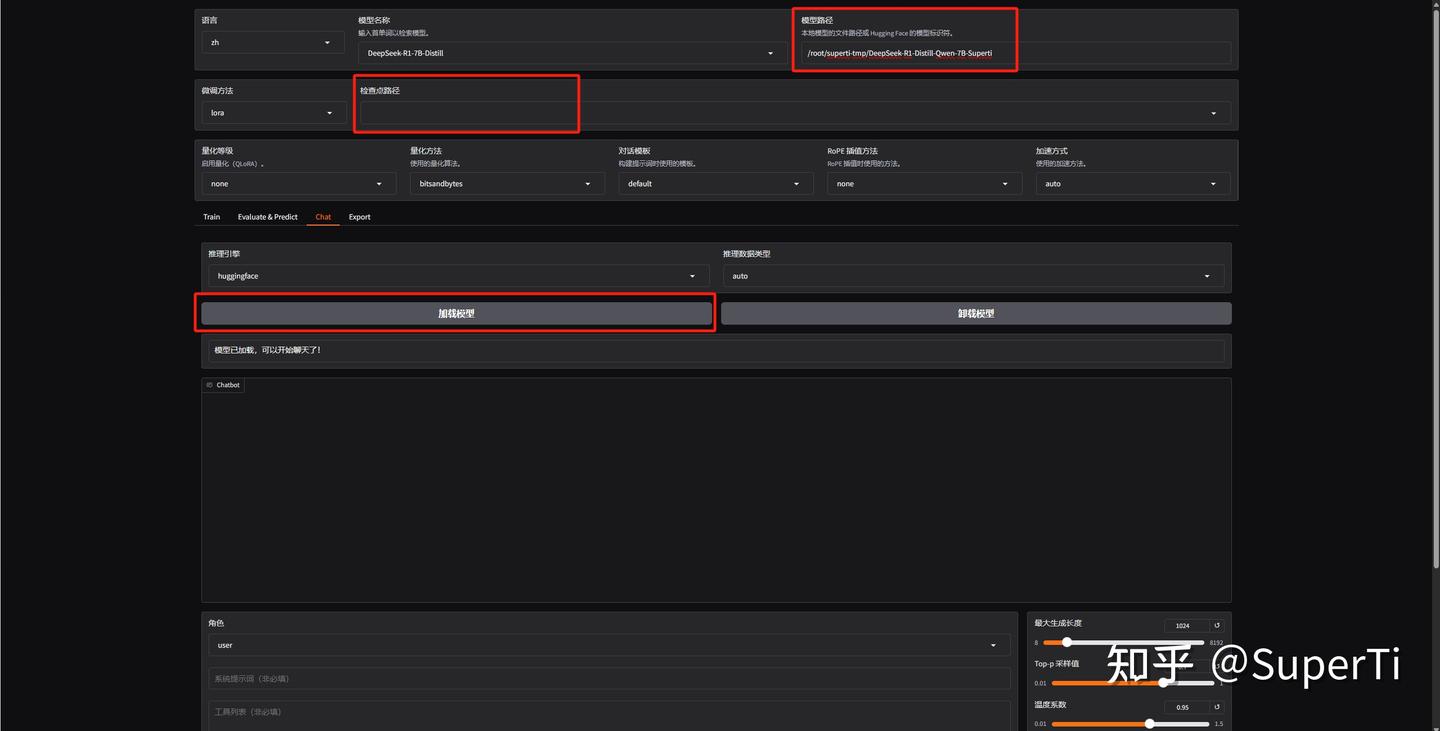

2. 进入 LlamaFactory开始微调

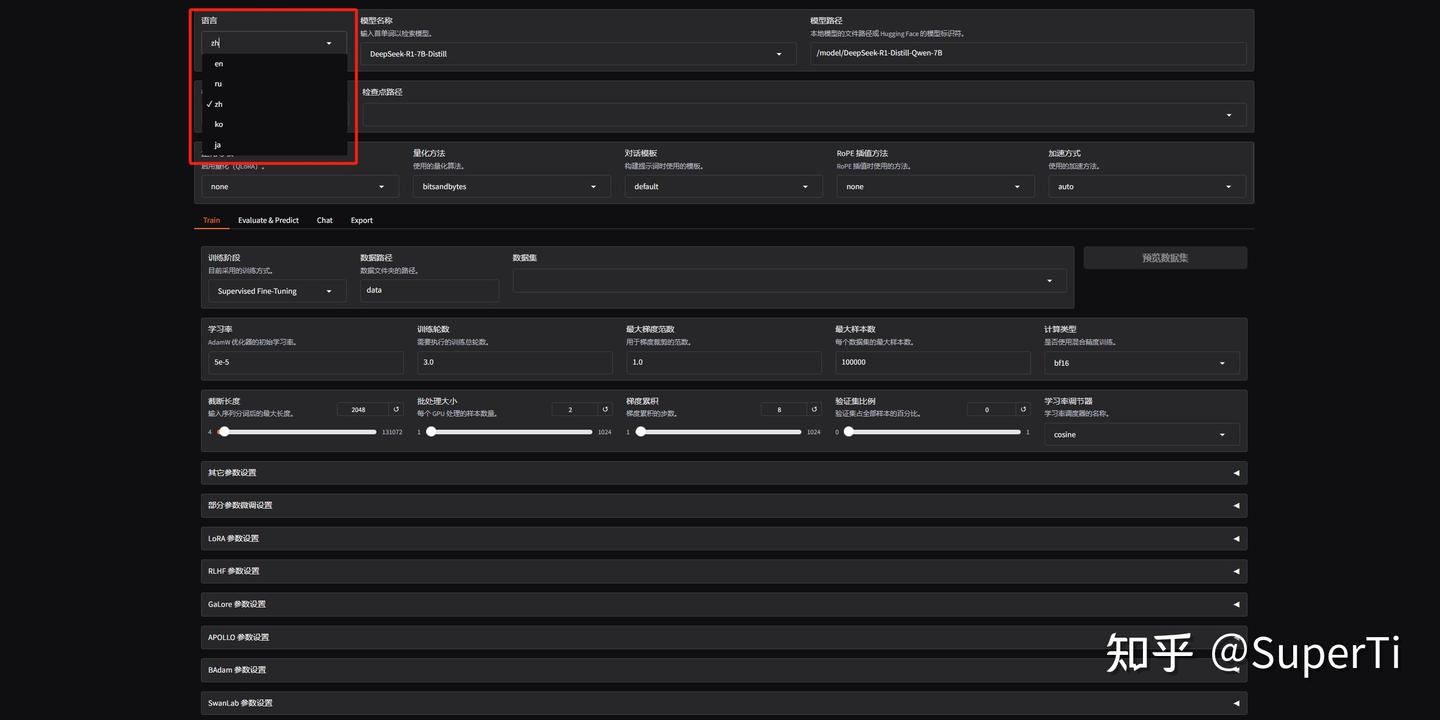

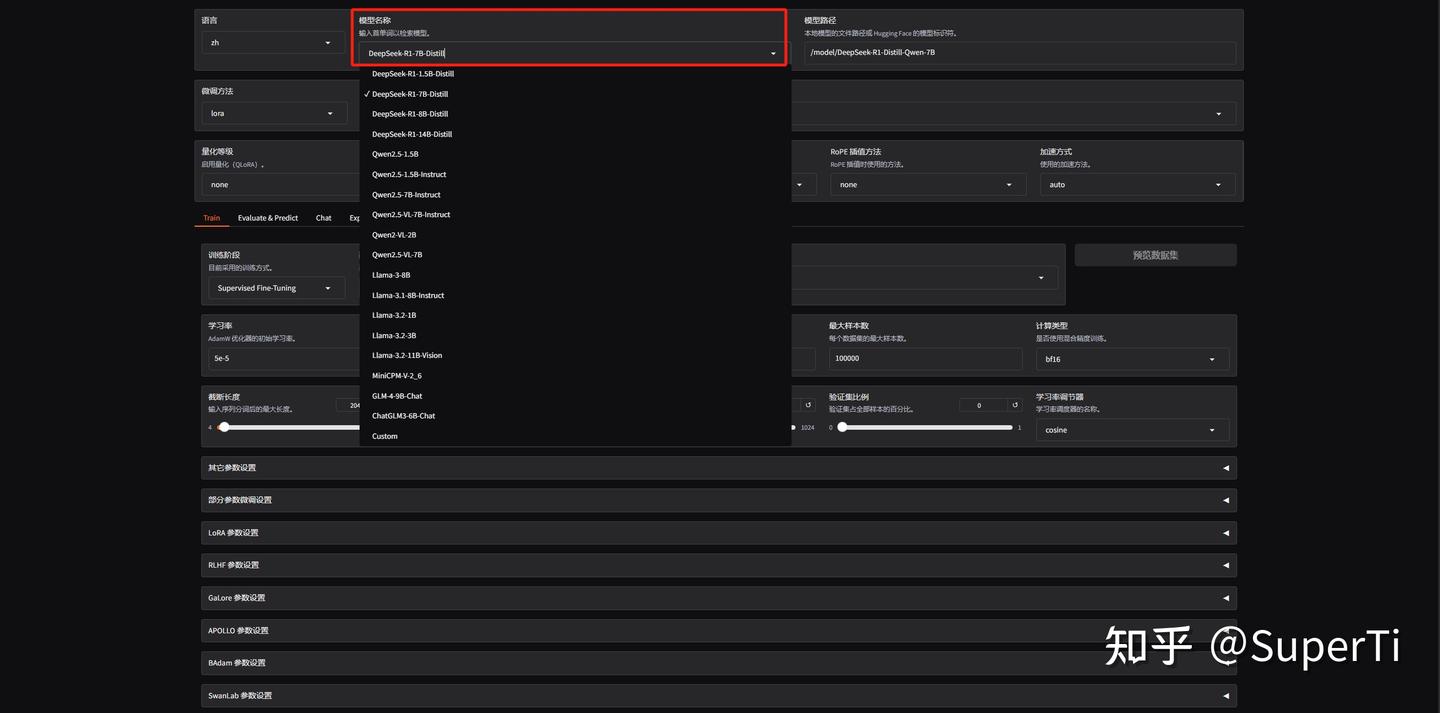

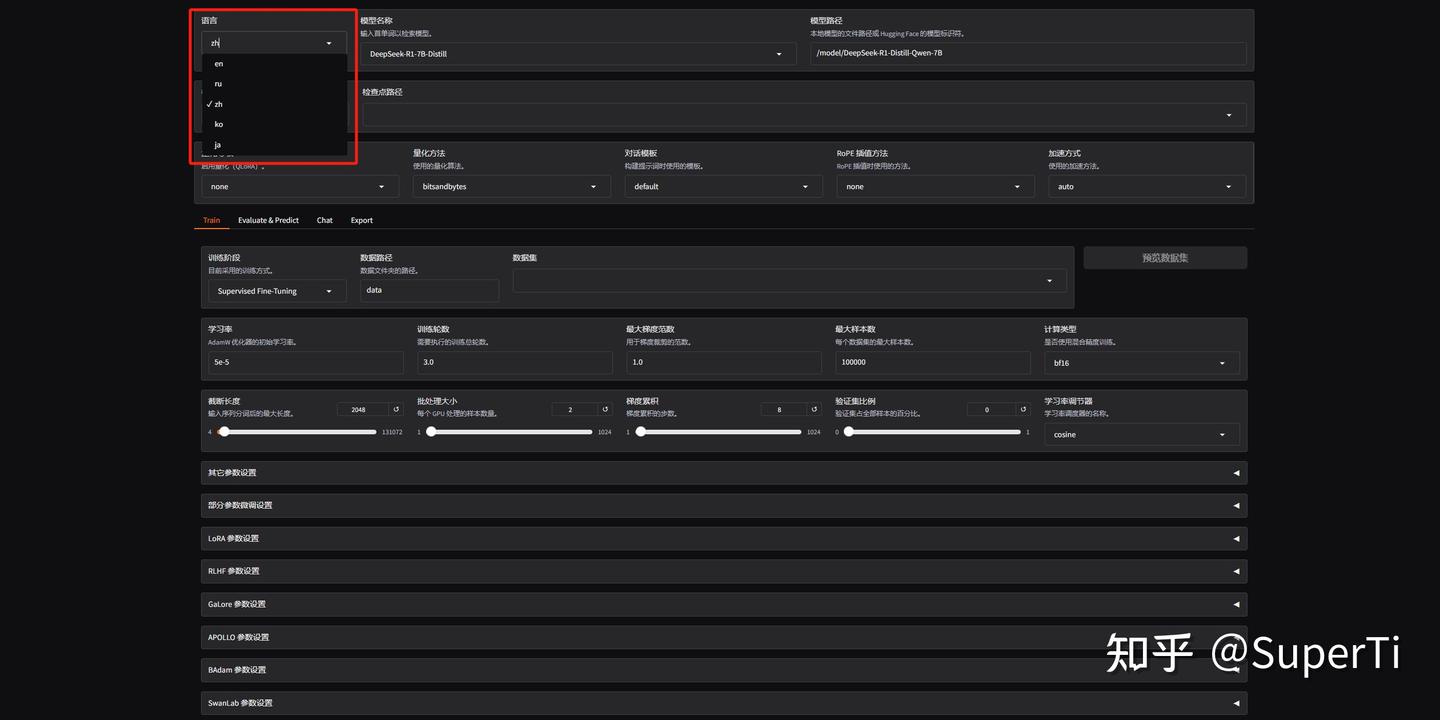

- Step 1:通过浏览器访问LlamaFactory平台界面,顶部导航栏提供中英文语言切换功能,支持多语言操作环境。

- Step 2:模型配置 • 默认模型:系统已预加载用户指定的DeepSeek-R1-Distill-Qwen-7B模型 • 模型切换:支持通过下拉菜单从预置模型库中灵活选择其他可用模型

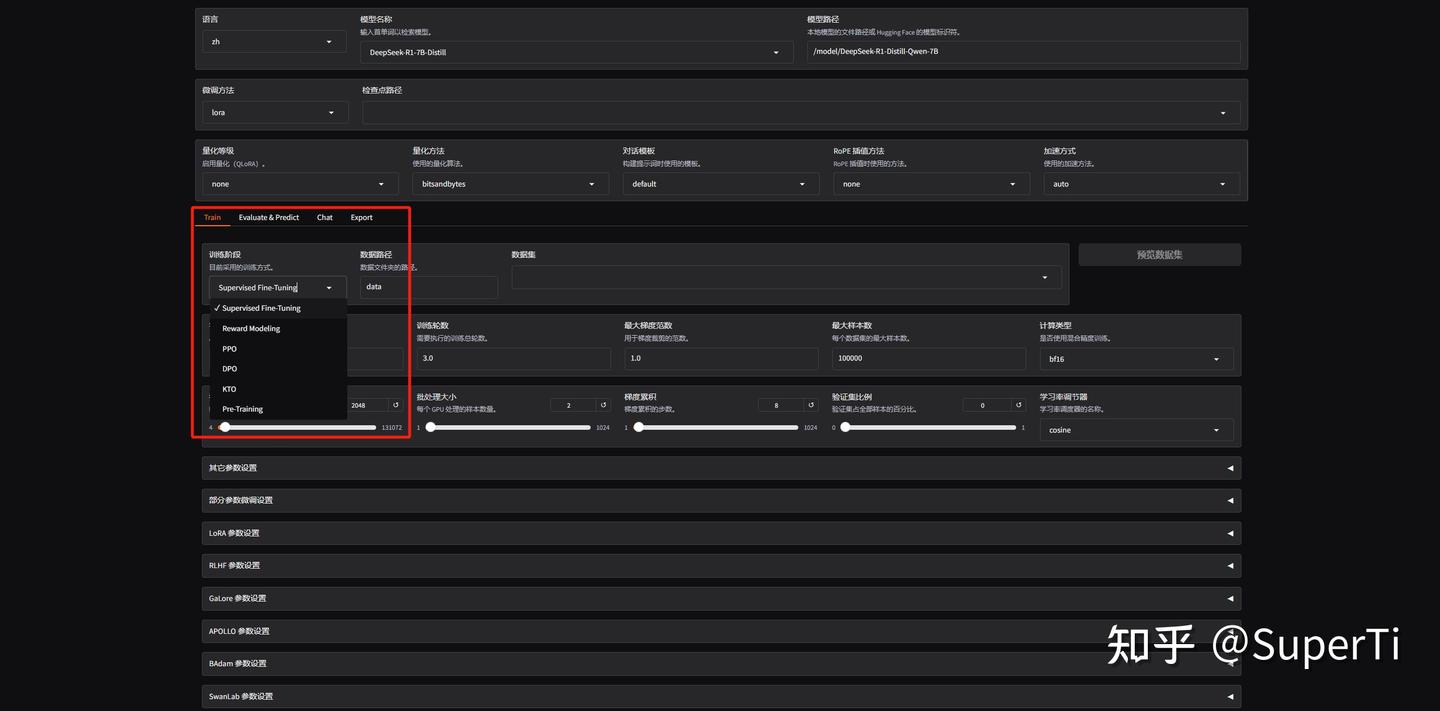

- Step 3:推荐采用高效的LoRA(Low-Rank Adaptation)微调方法 • Full Parameter Fine-tuning:全参数微调模式,需消耗大量计算资源(建议慎用) • LoRA:基于低秩适配的轻量化微调方案,显存占用降低约75%(推荐选项)

- Step 4:训练类型支持PreTraining预训练、STF监督微调、RLHF强化学习训练以及模型优化训练,训练方法选择SFT。

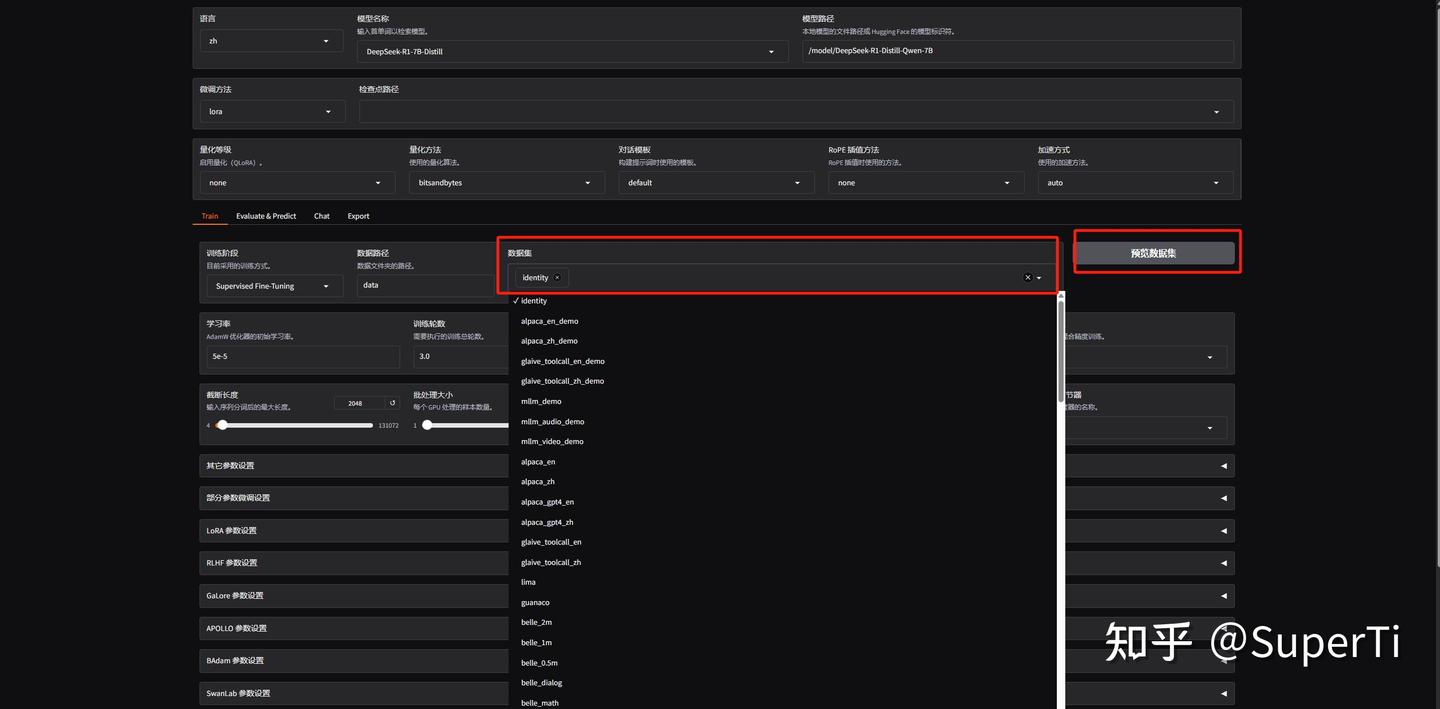

- Step 5:其他默认训练参数均由行业大佬经过多次试验优化得出的经验值,您可以在后续根据需求进行调整,本次我们保持默认设置。LlamaFactory自带了一部分数据集,选择数据集后,旁边可以进行数据集预览。

3. 数据准备与配置

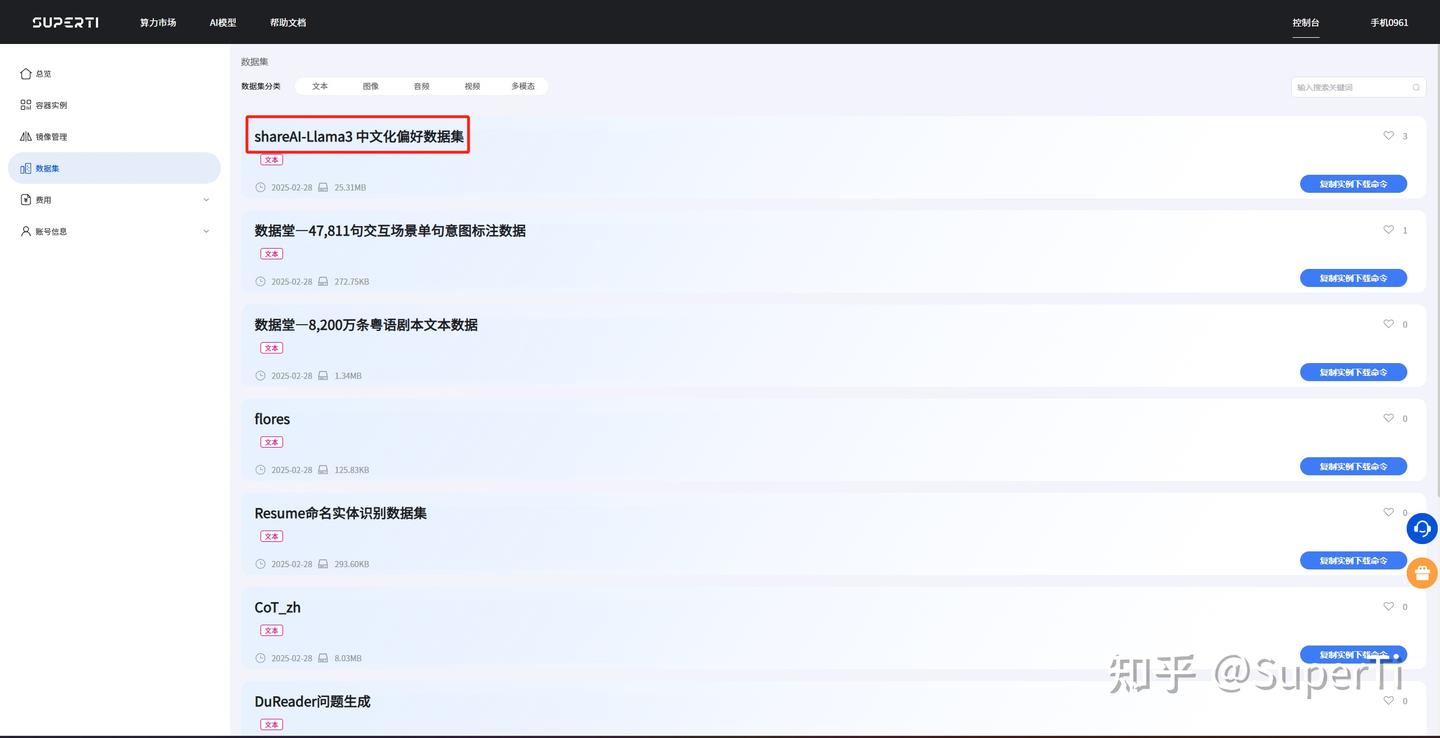

- Step 1:基于SuperTi算力平台内置的社区数据集库,通过ModelScope平台查看数据集元信息 • 本次选用

shareAI-Llama3中文化偏好数据集,复制其官方下载指令备用

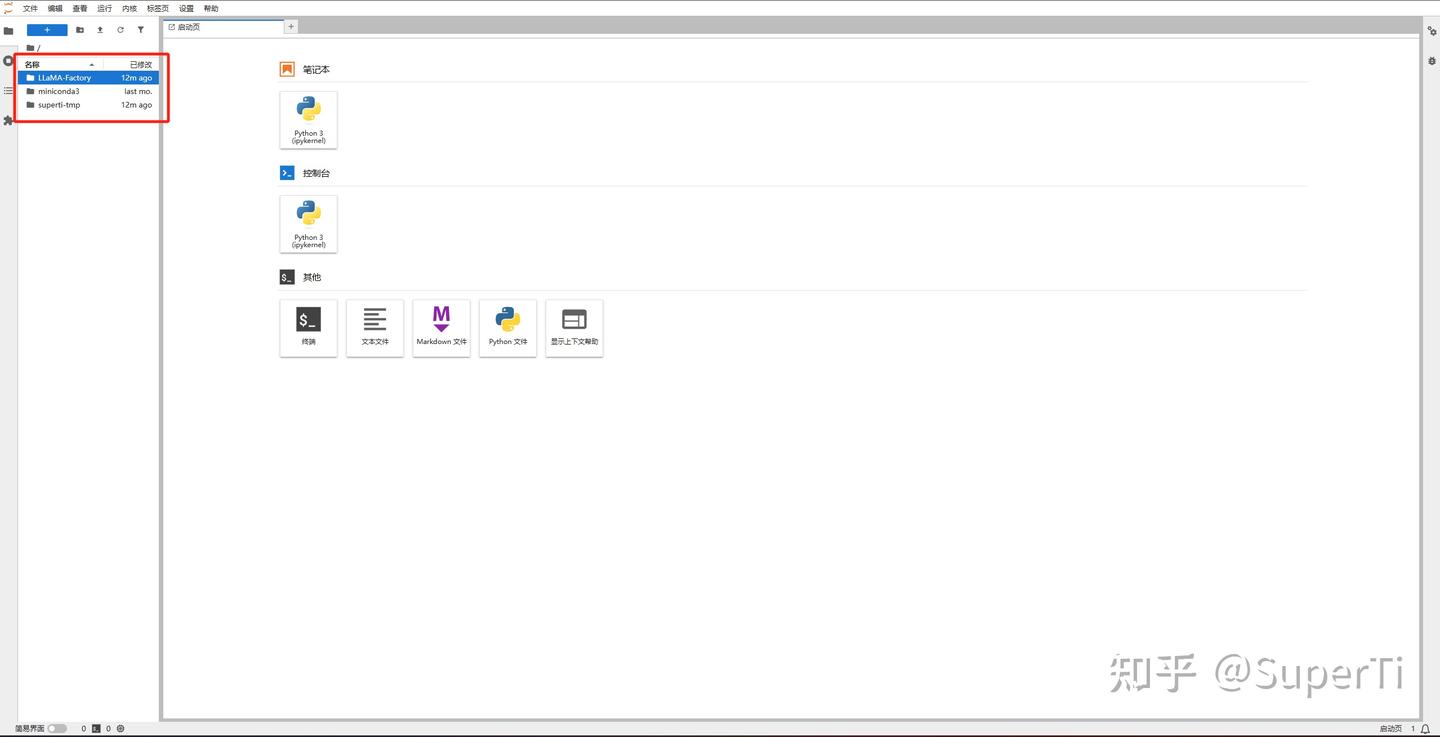

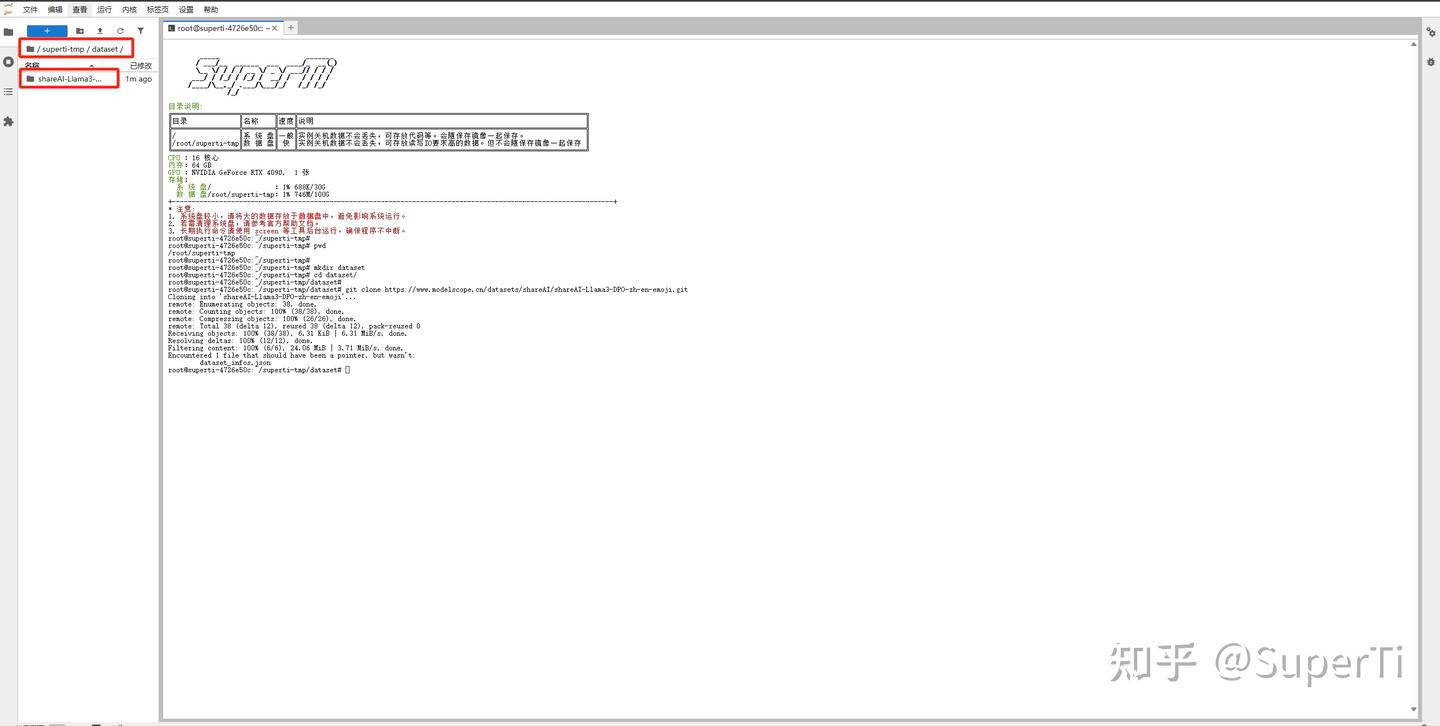

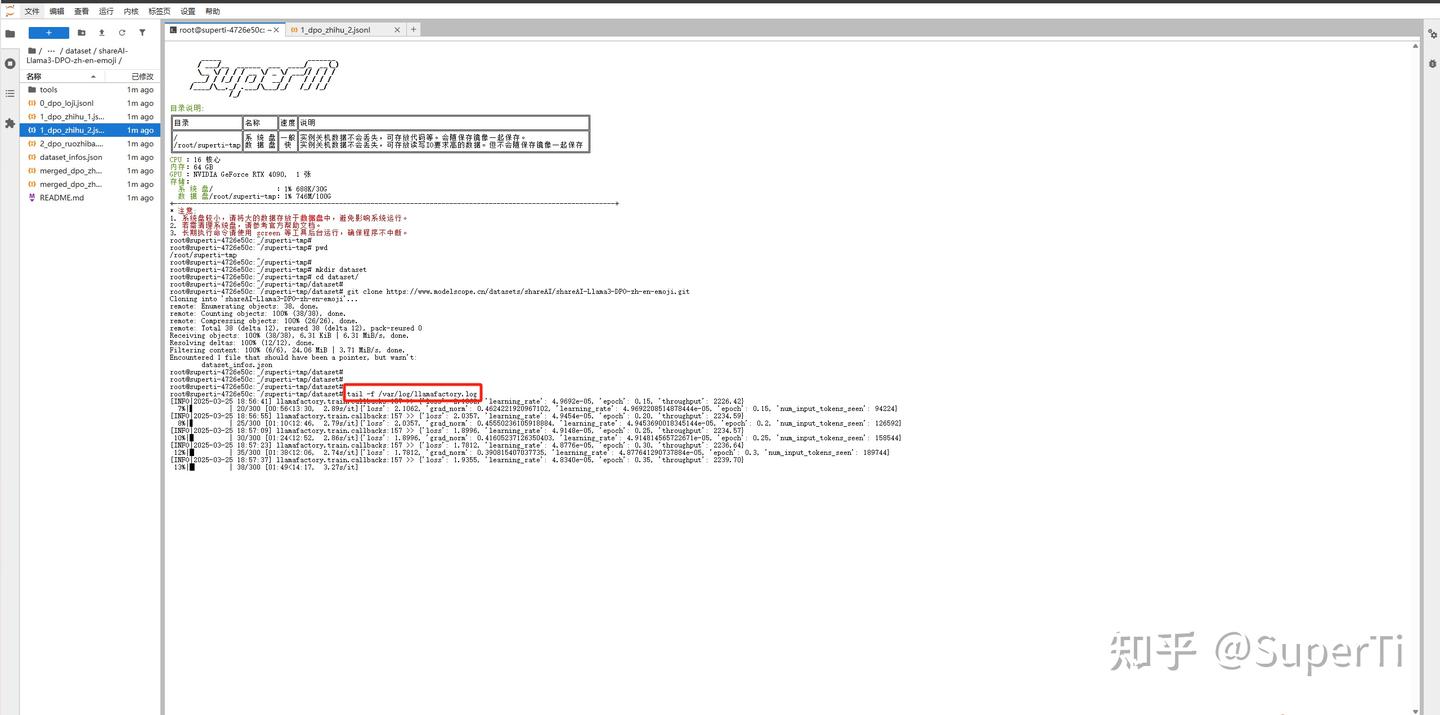

- Step 2:进入SuperTi实例管理界面,通过快捷工具栏启动

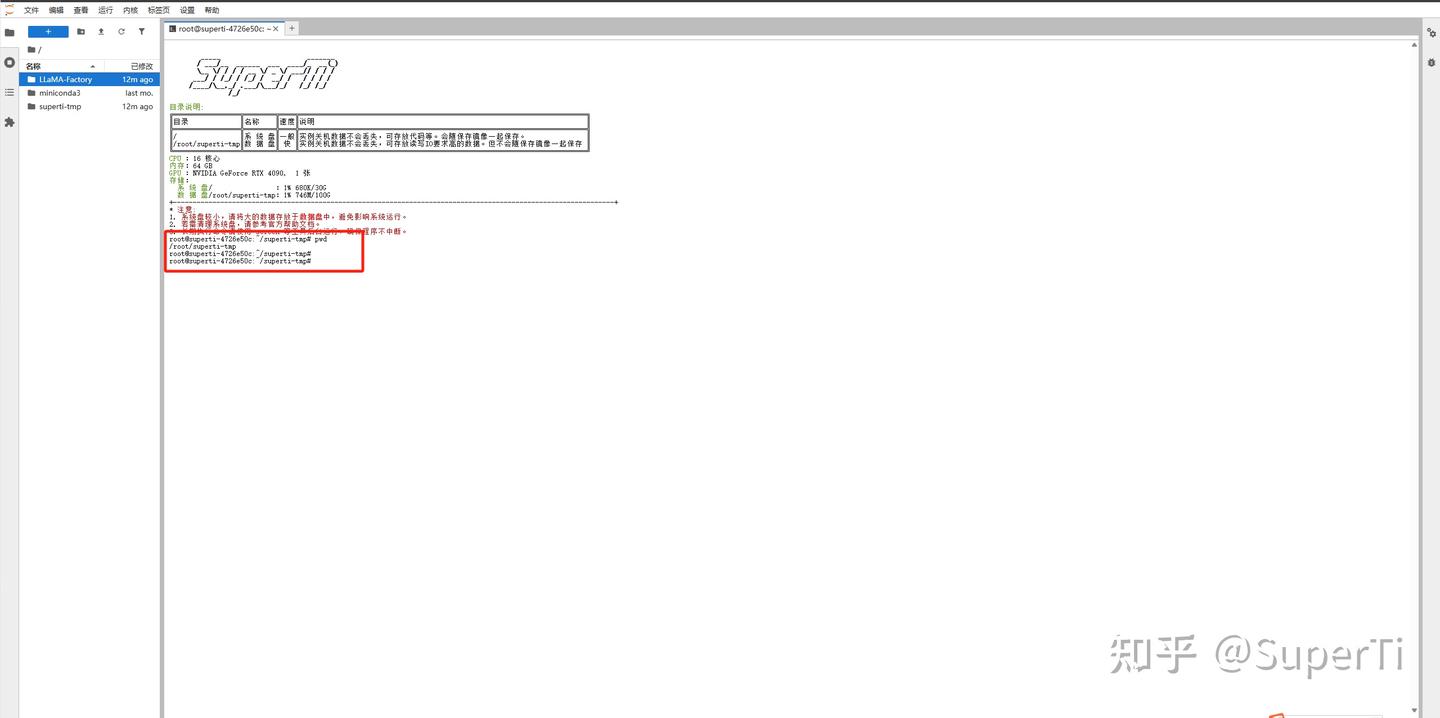

JupyterLab远程访问 •/root/LlamaFactory:存储框架源码、默认数据集及配置文件 •/root/SuperTi-tmp:实例主数据目录(建议统一存储用户数据)

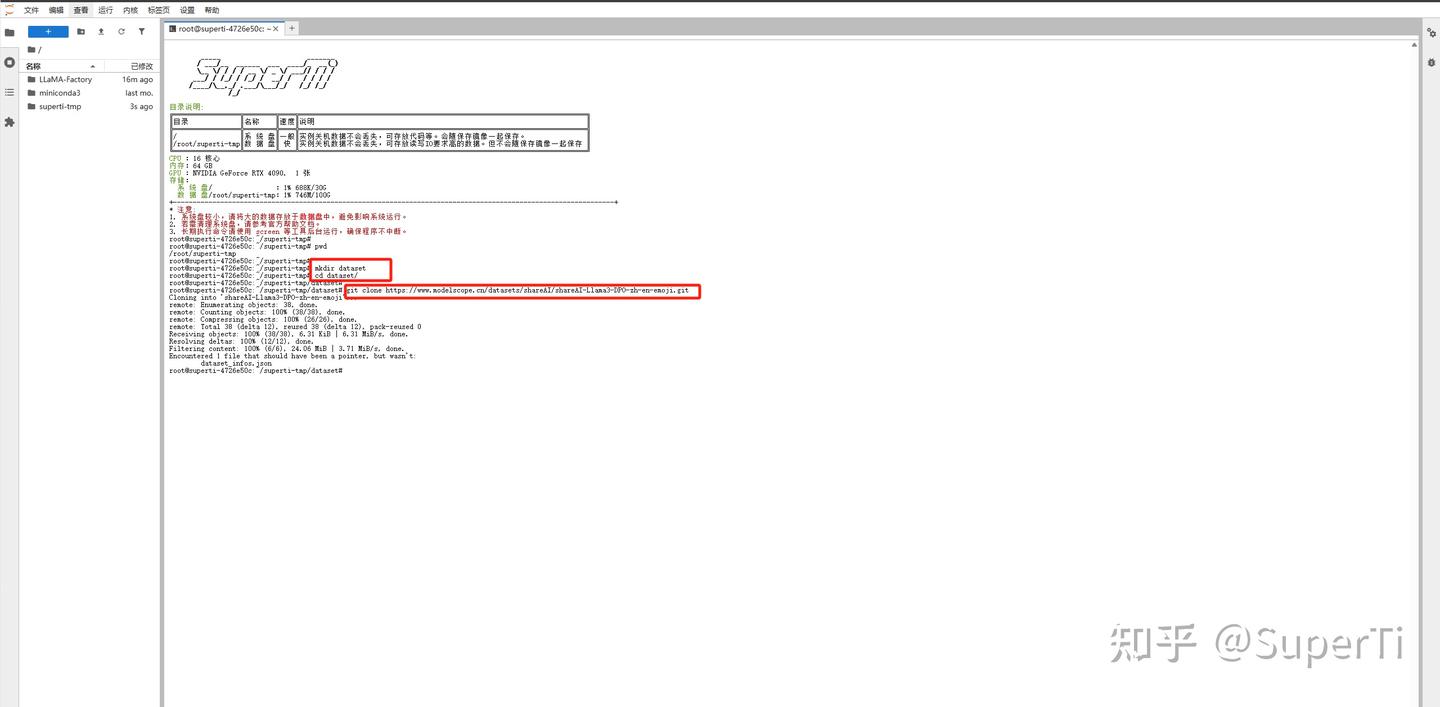

- Step 3:在JupyterLab中打开终端进行数据下载与验证 • 新建dataset文件夹,进入dataset目录复制刚刚的数据集下载命令并执行 • 下载完成后,通过左侧导航栏检查数据文件:

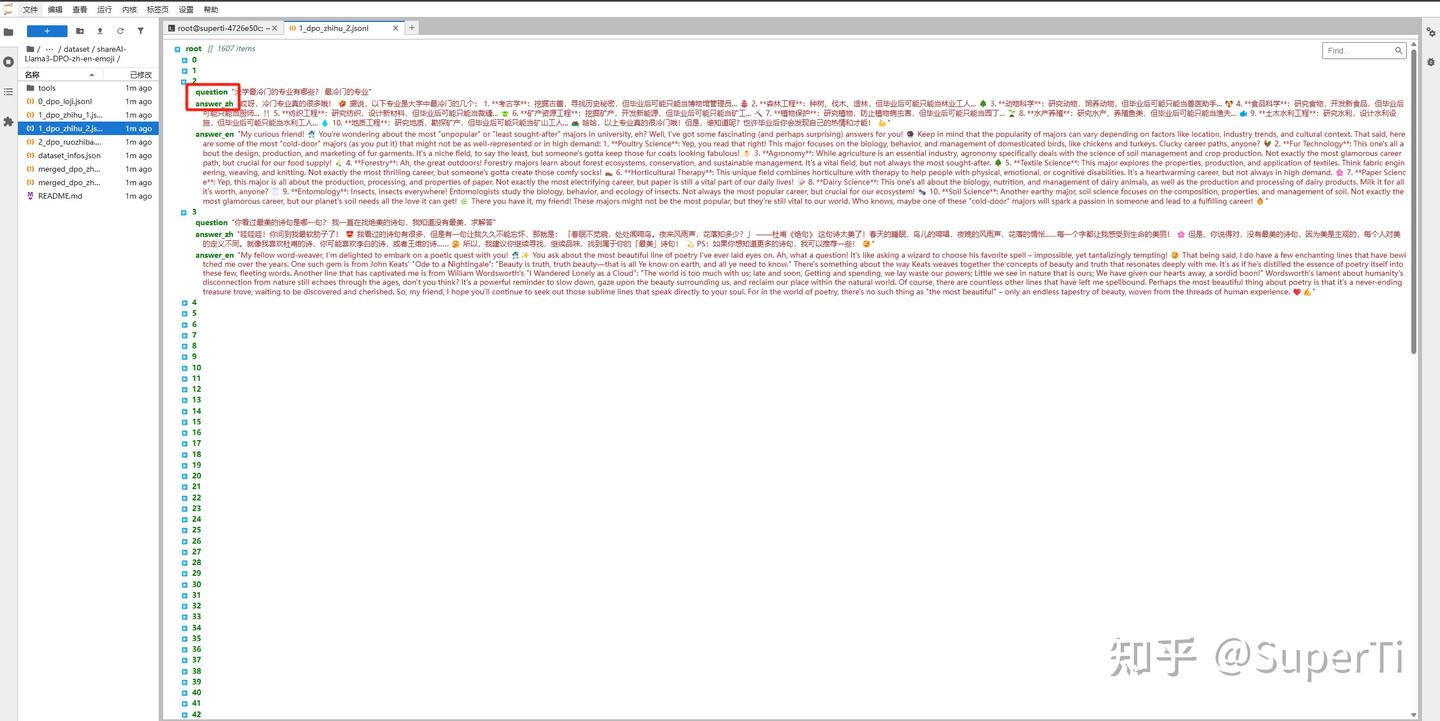

- 确认文件为JSON格式

- 验证数据结构:

question为输入字段,answer_en/answer_zh为输出字段

-

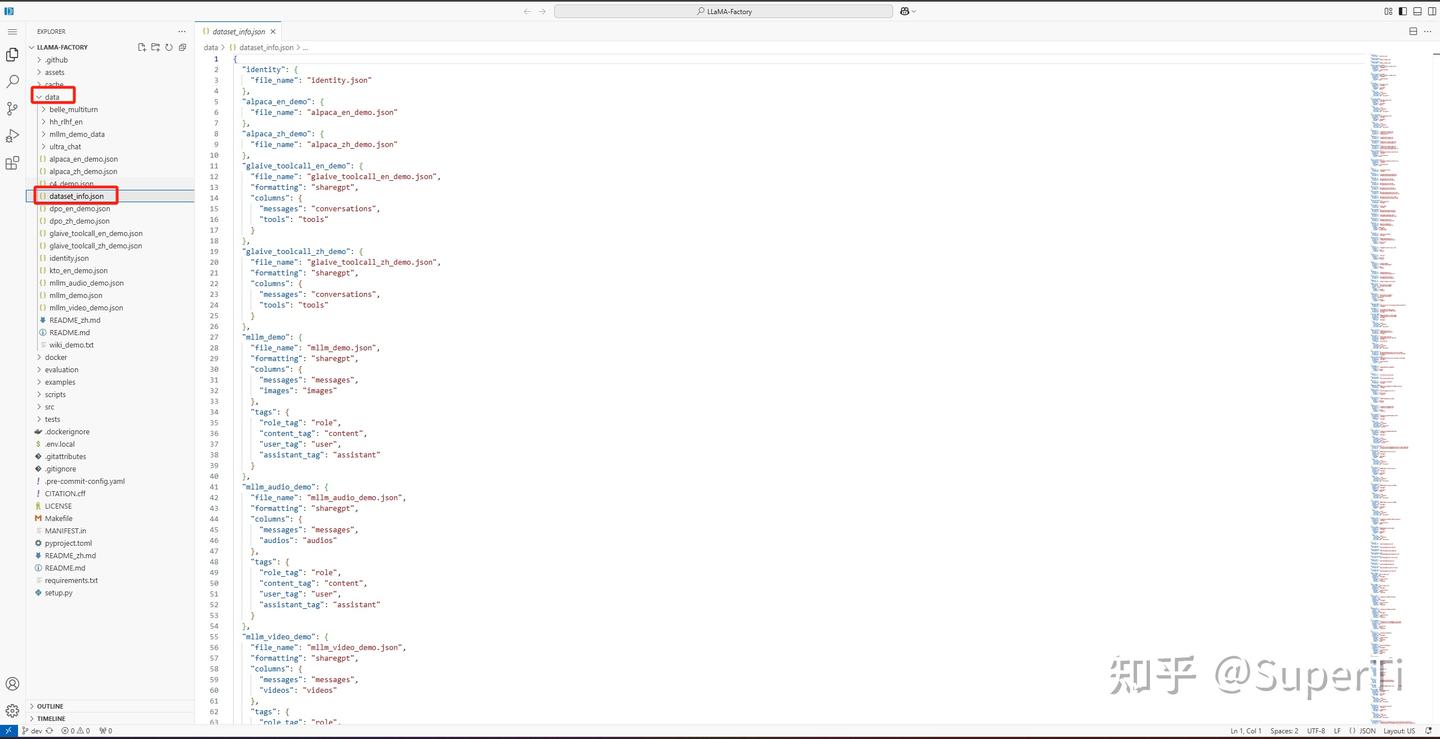

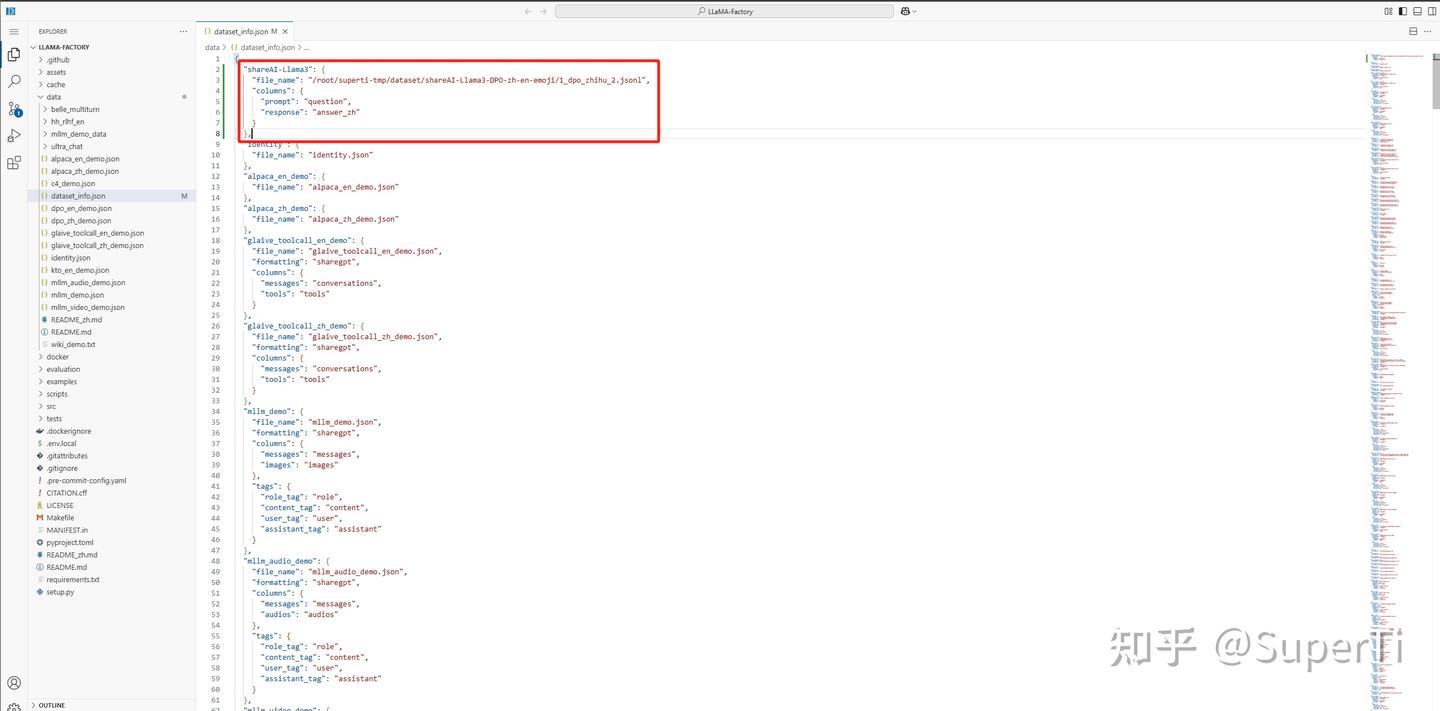

- Step 4:配置数据集索引 • 编辑索引文件:从SuperTi控制台复制Token用户CodeServer登陆认证 • 登录后,打开

LlamaFactory/data/dataset_info.json文件,添加新数据集配置项:

- Step 4:配置数据集索引 • 编辑索引文件:从SuperTi控制台复制Token用户CodeServer登陆认证 • 登录后,打开

-

- Step 5:关键要求 •

file_name需与数据文件实际路径一致 •columns字段名必须与JSON文件中的标签严格匹配

- Step 5:关键要求 •

-

- Step 6:数据集加载验证,返回LlamaFactory页面,选择新增的

zhihu_2数据集,预览数据内容,确认输入输出字段与预期一致

- Step 6:数据集加载验证,返回LlamaFactory页面,选择新增的

-

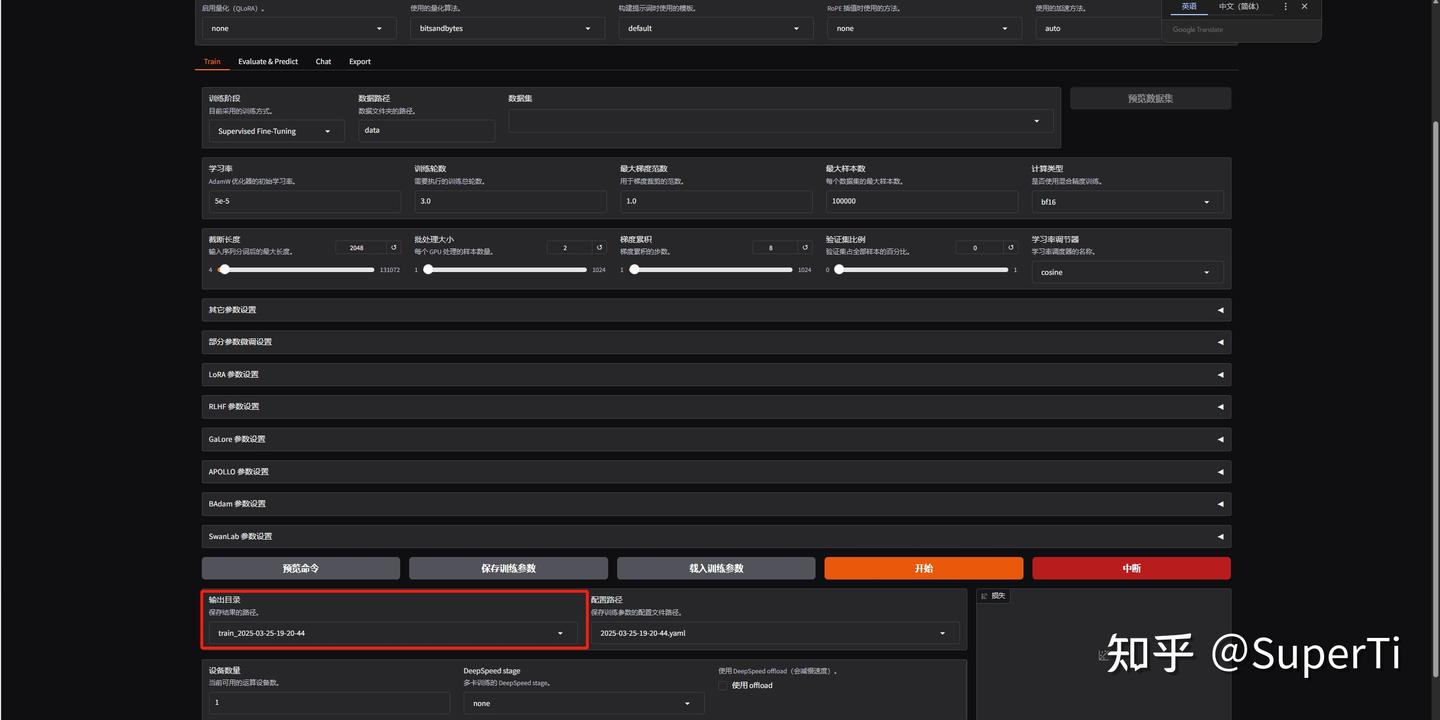

- Step 5:训练输出设置 • 输出目录说明:

- 默认路径:

LlamaFactory/save目录下自动生成子目录,命名规则为[微调方法]_[模型名称]_[时间戳] - 示例:

LoRA_DeepSeek-R1-Distill-Qwen-7B_20240601

- 默认路径:

- Step 5:训练输出设置 • 输出目录说明:

• 保留默认路径原因:

-

-

- 系统自动识别该目录下的检查点(checkpoint)文件

- 便于后续加载基础模型或选择检查点进行结果测试

-

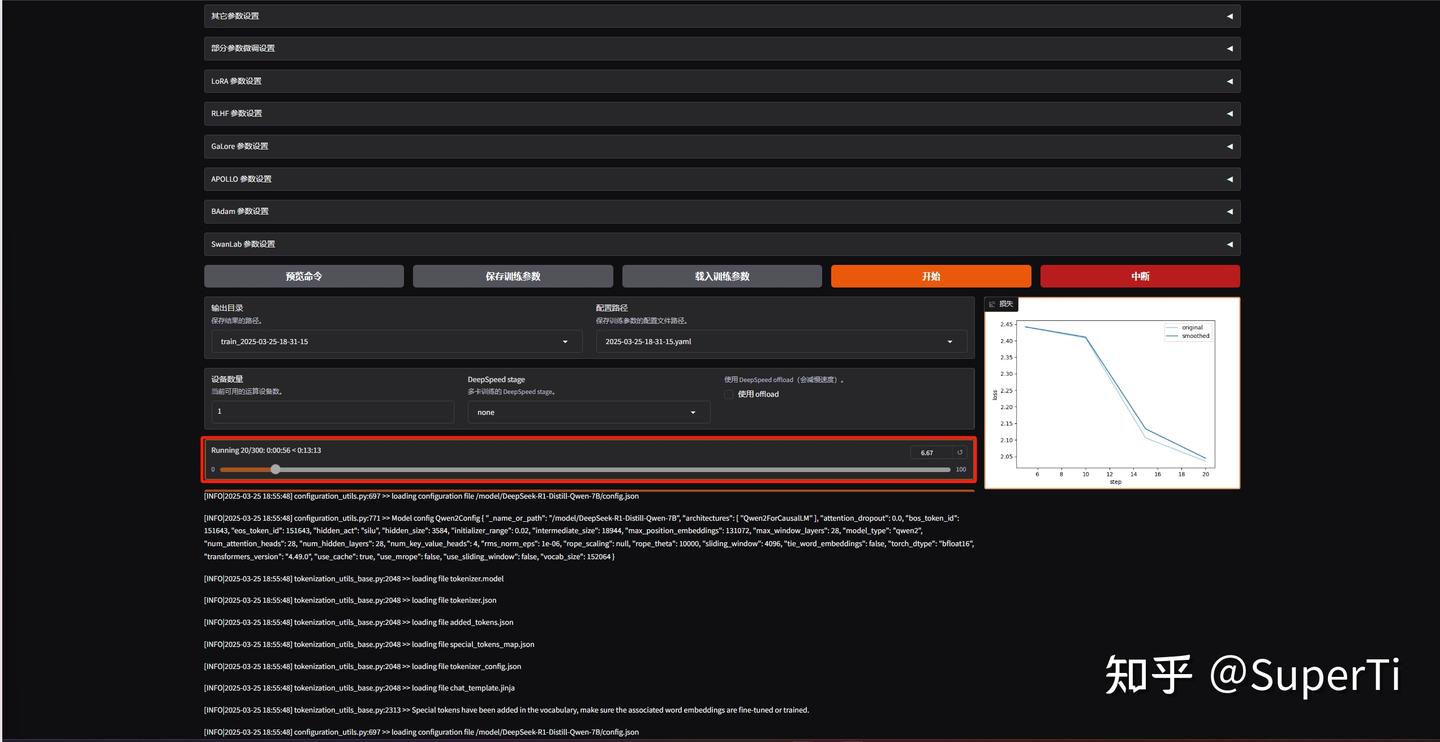

4. 开始训练

-

-

- Step 1:启动训练任务,完成参数配置后,点击操作界面“开始”钮启动微调流程 • 训练监控方式:

- 界面监控:实时查看训练日志输出流;通过顶部进度条观察预计剩余时间

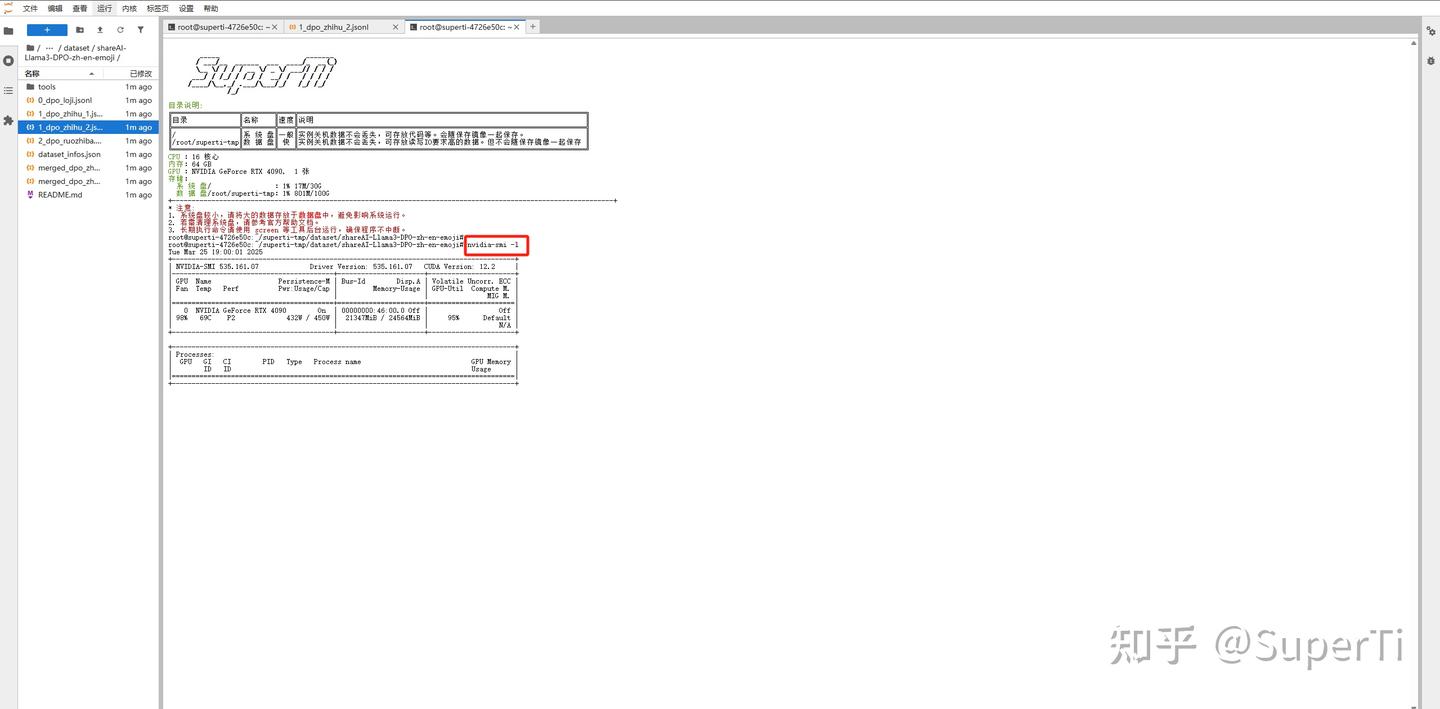

- 终端监控:在JupyterLab的终端窗口通过命令tail -f /var/log/llama-factory.log实时查看训练日志。使用nvidia-smi -l动态监测GPU的使用情况。

- Step 1:启动训练任务,完成参数配置后,点击操作界面“开始”钮启动微调流程 • 训练监控方式:

-

5. 模型验证与部署

-

-

-

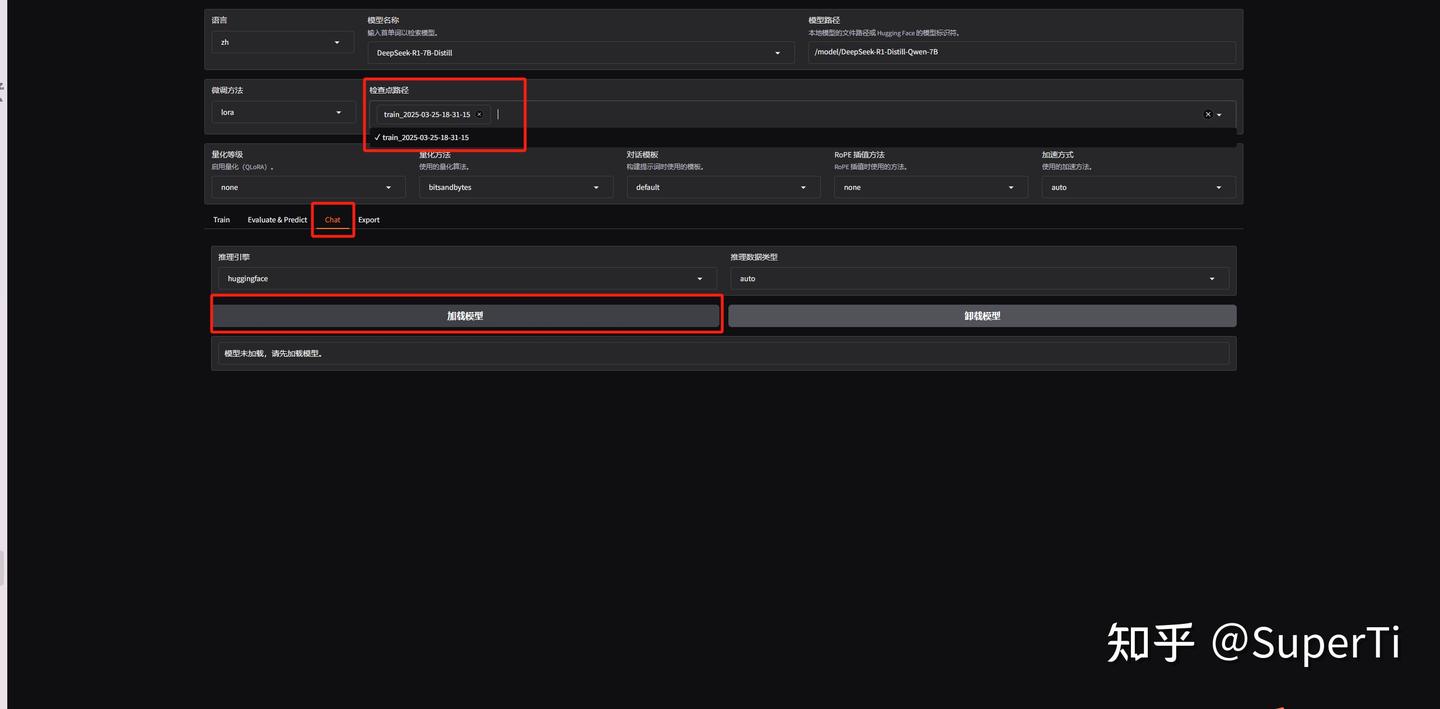

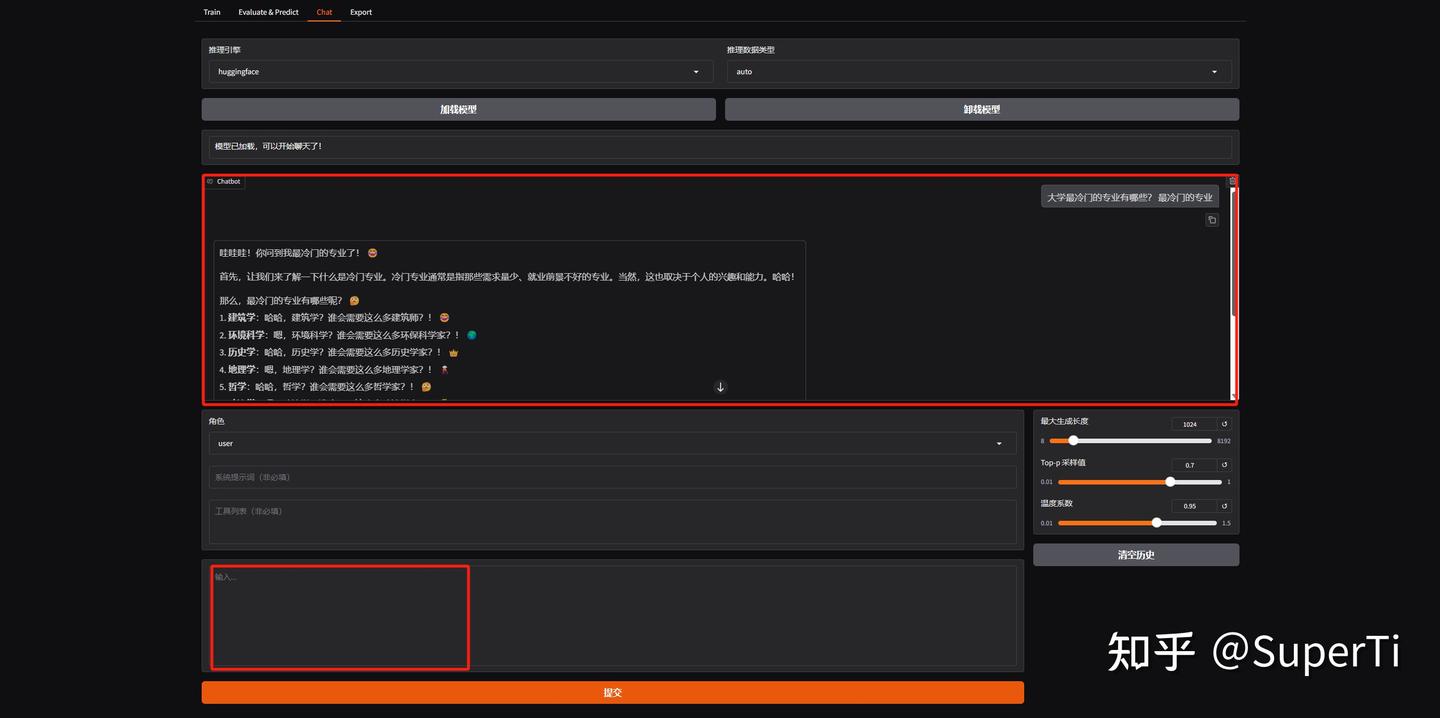

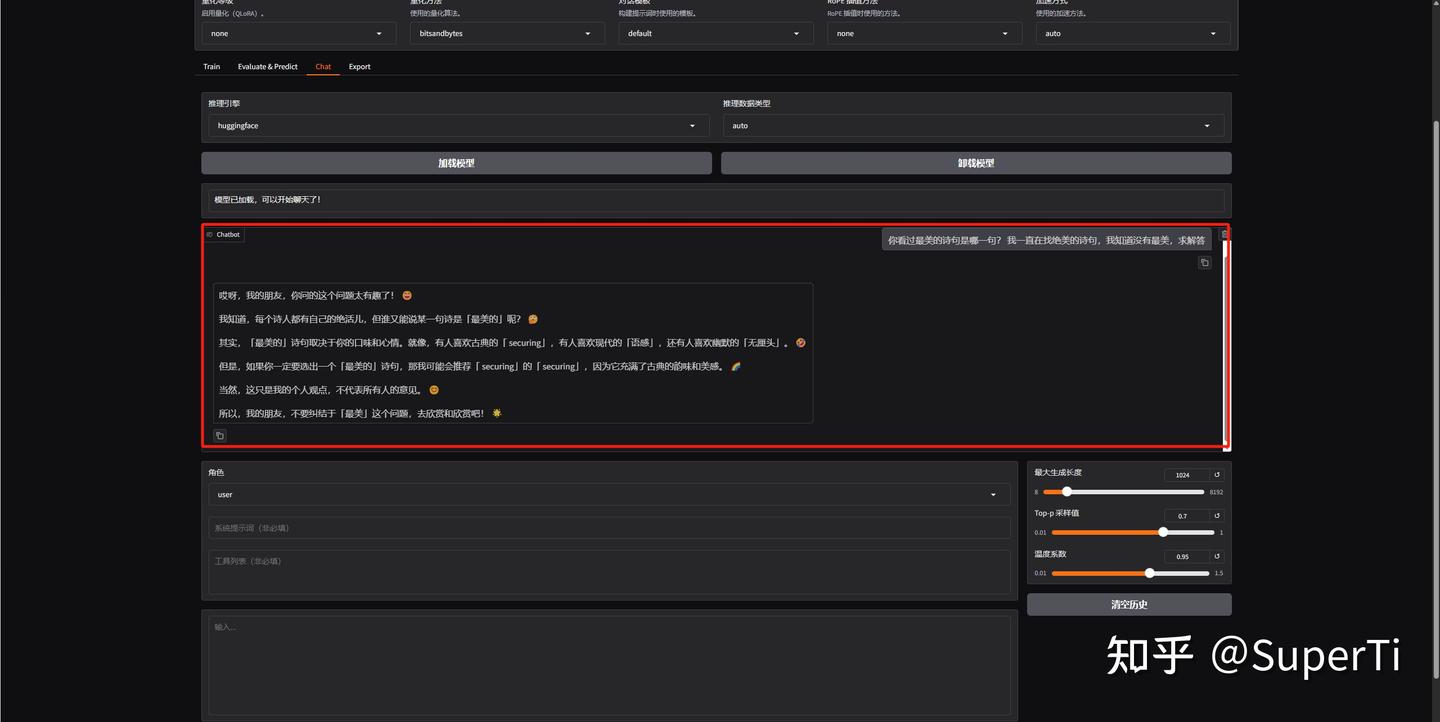

- Step 1:检查点测试,切换到“Chat”页面。在检查点选项中选择刚刚训练完成的增量文件并加载模型,您可以使用数据集中的问题进行对话测试,体验训练结果。这里我们随机选择两个问题进行测试,测试结果符合我们的预期。

-

-

-

-

-

- Step 2:卸载模型,清除检查点文件,重新加载模型进行测试。可以发现模型输出结果不受数据集影响,不符合我们的预期。

-

-

-

-

-

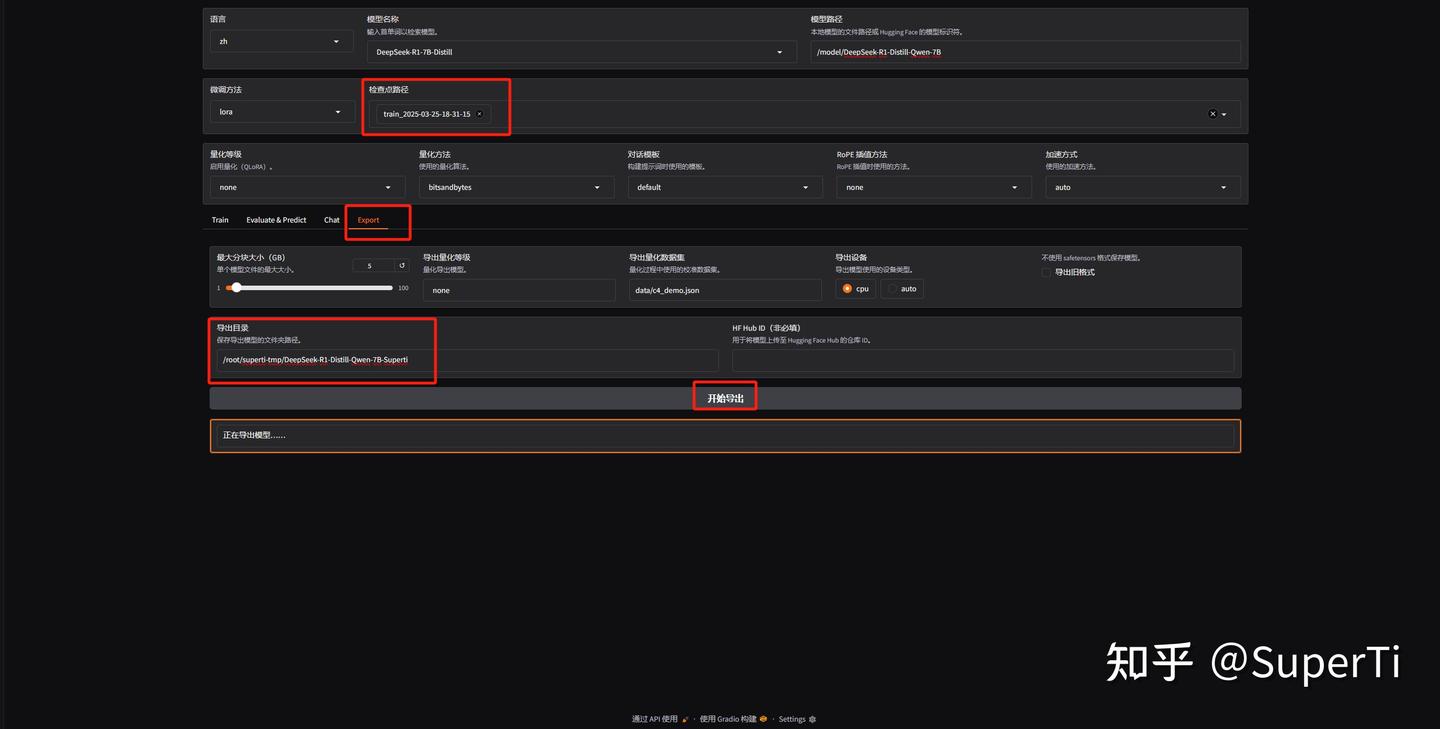

- Step 3:切换到“Export”页面,导出训练后的模型。由于模型文件较大,建议导出到SuperTi-tmp数据目录中,根据需要更改导出路径,这里输入想到导出的模型名字 /root/superti-tmp/DeepSeek-R1-Distill-Qwen-7B-Superti,检查点选择刚刚训练的输出文件,开始导出。

-

-

-

-

-

- Step 4:在模型选择处重新选择训练之前的原始模型,清除检查点内容并加载模型。

-

-

-

-

-

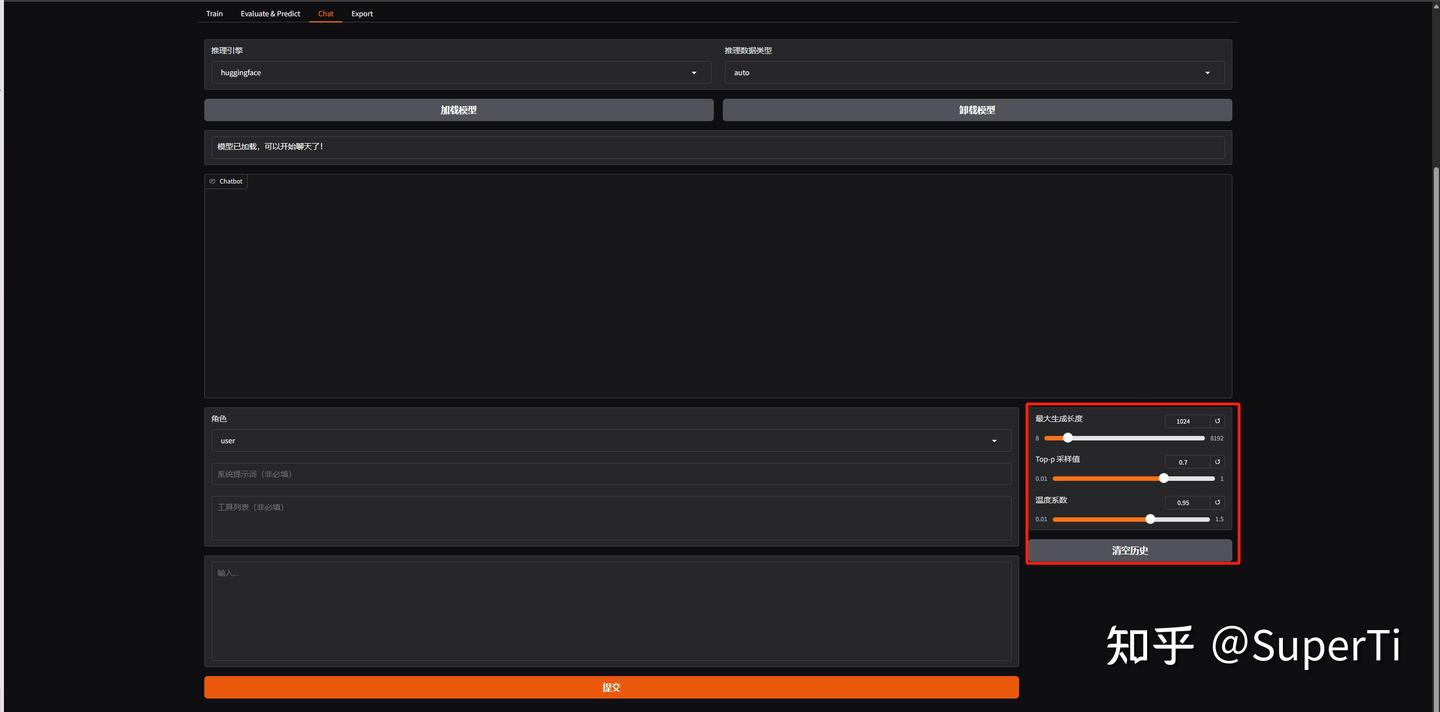

- Step 5:导出完成后,在模型选择处重新选择训练之前的原始模型,清除检查点内容并加载模型,使用刚刚的测试问题进行对话测试,可以发现模型输出结果不符合我们的预期。随后卸载原始模型,加载刚刚导出的微调模型,确认模型路径,加载模型,再次进行对话测试。通过对比,您可以直观地看到微调后的模型与原模型之间的差异。

-

-

-

-

-

- Step 6:如果输出不符合我们的预期,可能需要调整参数值。温度系数用于控制模型生成随机性的参数,通过对模型输出的概率分布进行缩放,调节生成结果的“保守”或“大胆”程度。核采样概率阈值(Top-p)控制模型生成文本的多样性。通过设置一个概率阈值,模型只从累积概率达到该阈值的token中采样。不同系列的模型有不同的默认值。

-

-

好了,以上就是用SuperTi微调DeepSeek-7B的完整教程了。

大模型&AI产品经理如何学习

求大家的点赞和收藏,我花2万买的大模型学习资料免费共享给你们,来看看有哪些东西。

1.学习路线图

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

2.视频教程

网上虽然也有很多的学习资源,但基本上都残缺不全的,这是我自己整理的大模型视频教程,上面路线图的每一个知识点,我都有配套的视频讲解。

(都打包成一块的了,不能一一展开,总共300多集)

因篇幅有限,仅展示部分资料,需要点击下方图片前往获取

3.技术文档和电子书

这里主要整理了大模型相关PDF书籍、行业报告、文档,有几百本,都是目前行业最新的。

4.LLM面试题和面经合集

这里主要整理了行业目前最新的大模型面试题和各种大厂offer面经合集。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集***

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

677

677

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?