一、准备工作

1、打开VMware Workstation里的Hadoop1、Hadoop2、Hadoop3这三台虚拟机;

2、需要hive的压缩包,apache-hive-3.1.1-bin.tar.gz;

3、需要以下有关MySQL的压缩包,

mysql-community-common-5.7.36-1.el7.x86_64.rpm、

mysql-community-libs-5.7.36-1.el7.x86_64.rpm、

mysql-community-client-5.7.36-1.el7.x86_64.rpm 、

mysql-community-server-5.7.36-1.el7.x86_64.rpm

mysql-connector-java-5.1.46;

4、远程连接工具Xftp8,Xftp-8.0.0057p.exe;

5、保证主机网络通畅。

二、实验步骤

1、环境为Hadoop

如果有搭建HA-Hadoop,那么请回到刚搭建完Hadoop的快照那里。因为HA-Hadoop环境并不稳定,我们并不需要这个环境。

(以下为例子:)

2、安装Hive

(1)上传hive安装包

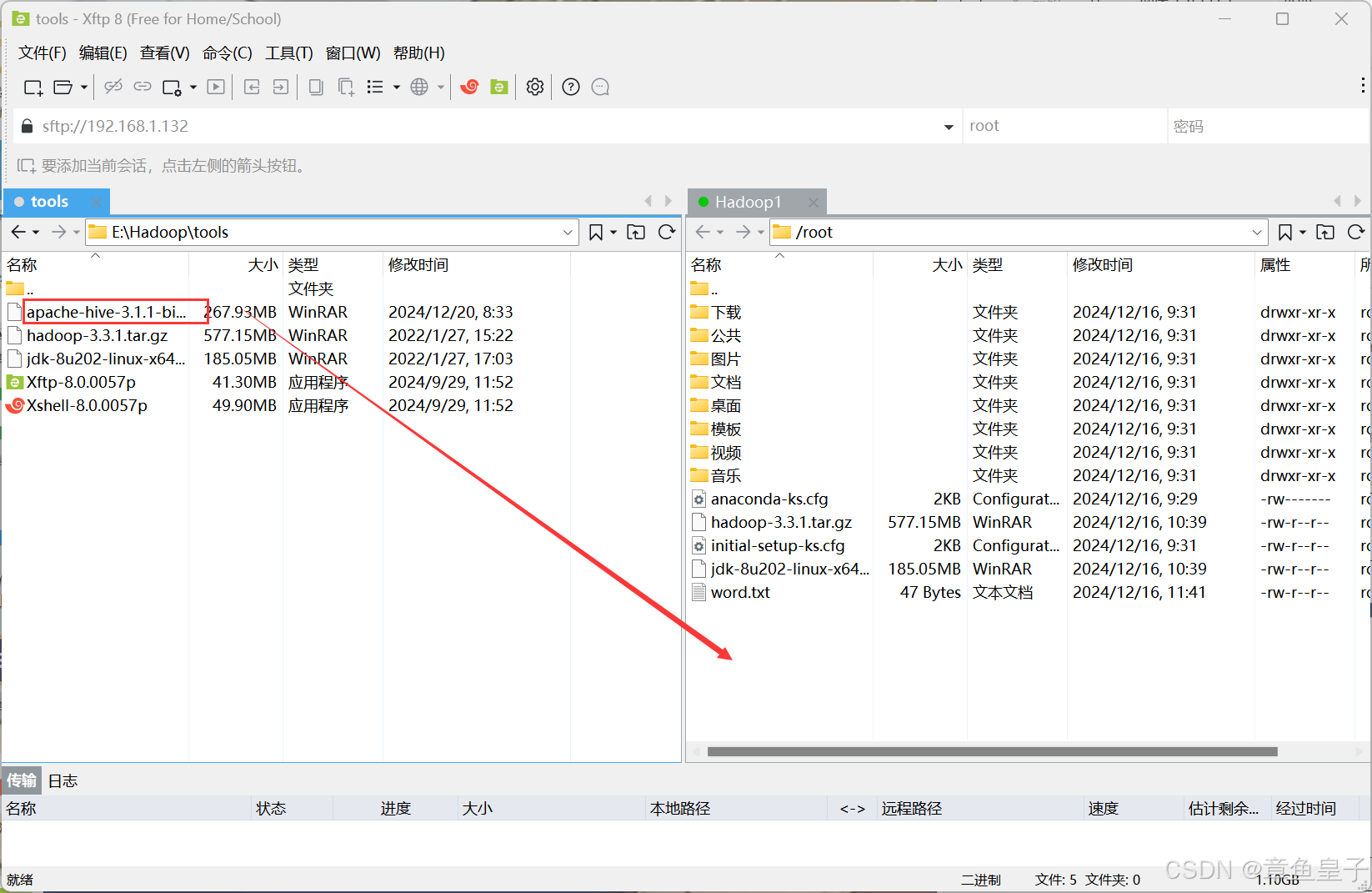

首先打开xftp8,其次将xftp8与Hadoop1相连接,然后将hive的安装包拖动到Hadoop1中。

(2)解压hive安装包

解压命令如下:

tar -zxvf /root/apache-hive-3.1.1-bin.tar.gz -C /export/servers/重命名hive解压后的文件,命令如下:

cd /export/servers/

mv apache-hive-3.1.1-bin hive-3.1.1(3)同步jar包

将 Hive 中的 guava-19.0.jar 替换为 Hadoop 中的 guava-27.0-jre.jar

A.切换到Hadoop 中的 guava-27.0-jre.jar所在的文件目录

cd /export/servers/hadoop-3.3.1/share/hadoop

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1156

1156

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?