【精选优质专栏推荐】

- 《AI 技术前沿》 —— 紧跟 AI 最新趋势与应用

- 《网络安全新手快速入门(附漏洞挖掘案例)》 —— 零基础安全入门必看

- 《BurpSuite 入门教程(附实战图文)》 —— 渗透测试必备工具详解

- 《网安渗透工具使用教程(全)》 —— 一站式工具手册

- 《CTF 新手入门实战教程》 —— 从题目讲解到实战技巧

- 《前后端项目开发(新手必知必会)》 —— 实战驱动快速上手

每个专栏均配有案例与图文讲解,循序渐进,适合新手与进阶学习者,欢迎订阅。

文章目录

前言

在大模型应用开发的浪潮中,开发者们常常陷入这样的困境:为满足不同场景需求接入了OpenAI、Anthropic、Google等多家厂商的模型,却被各异的API接口格式搞得焦头烂额;想切换模型优化成本或提升效果,却要修改大量业务代码;生产环境中模型调用的监控、日志和权限管理更是无从下手。而Litellm的出现,恰好为这些痛点提供了一站式解决方案。作为一款轻量且强大的大模型代理工具,它正在重新定义大模型应用的开发范式。

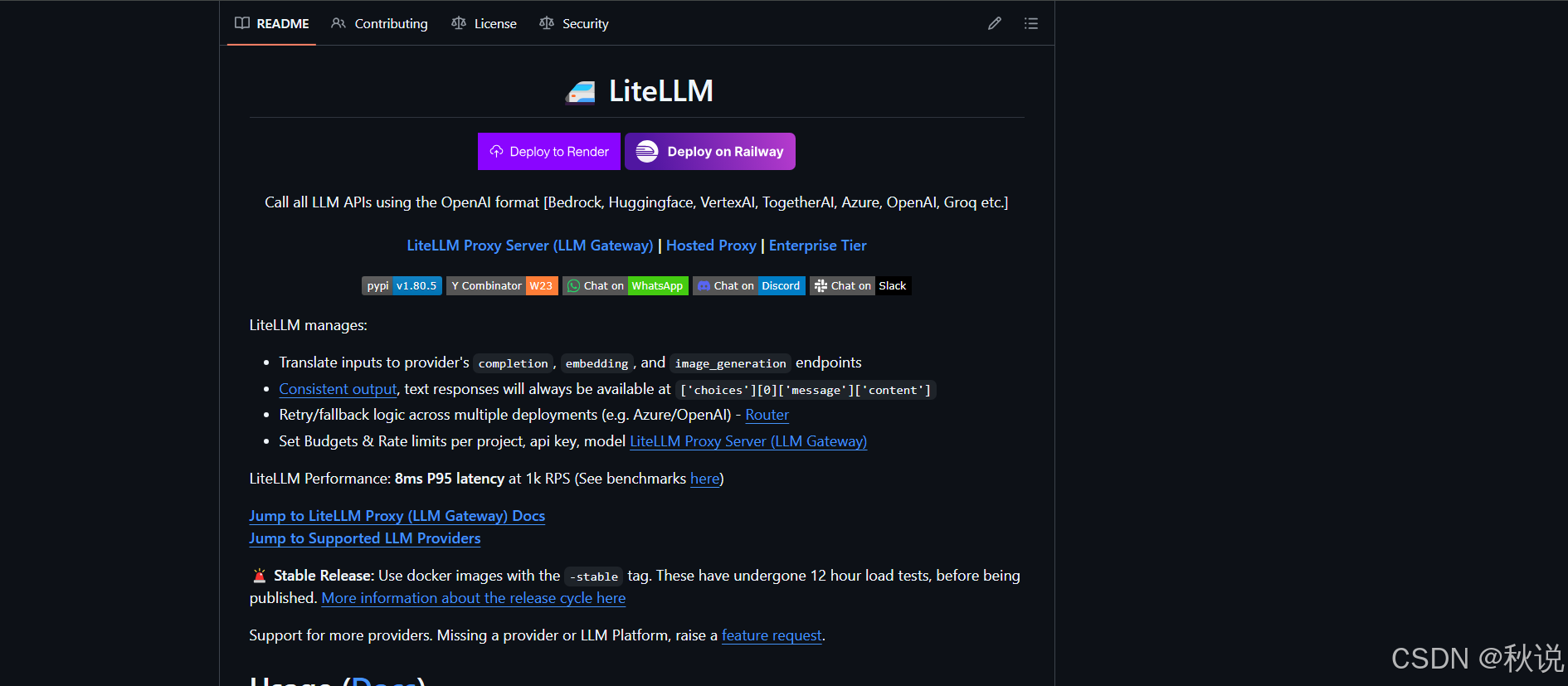

一、什么是Litellm?核心价值何在?

Litellm是一个开源的大模型统一代理工具,核心定位是“大模型调用的翻译官与管家”。它通过封装不同厂商大模型的API,提供了一套标准化的调用接口,让开发者无需关注各模型的接口差异,只需使用类OpenAI的格式就能调用几乎所有主流大模型。

项目地址:

https://github.com/BerriAI/litellm

其核心价值主要体现在三个维度:

1.接口统一化:

将OpenAI、Claude、Gemini、文心一言、通义千问等数十种大模型的接口“翻译”为统一格式,调用不同模型时无需修改核心代码。

2.开发高效化:

内置负载均衡、故障转移、缓存等能力,降低大模型应用的稳定性保障成本;支持批量调用、流式响应等主流需求,开箱即用。

3.运维可视化:

提供完整的日志记录、性能监控、权限控制功能,解决大模型调用的可观测性难题,适配生产环境需求。

二、Litellm的核心特性

Litellm之所以能成为开发者的新宠,与其全面且实用的特性密不可分。除了基础的接口统一功能外,这些特性更是提升开发效率的关键:

1. 全场景模型支持,覆盖主流与垂类

Litellm的模型支持库一直在快速更新,目前已兼容超过50种大模型,涵盖通用大模型、垂类模型和开源模型。无论是需要GPT-4o的多模态能力、Claude 3的长文本处理能力,还是Gemini的跨模态理解能力,都能通过统一接口调用。对于Llama 3、Mistral等开源模型,也能通过代理实现标准化调用,极大拓宽了开发选择。

2. 零侵入式集成,现有代码无缝迁移

如果你之前基于OpenAI的API开发了应用,迁移到Litellm几乎无需修改代码——只需将API请求地址指向Litellm的代理服务,替换API密钥为Litellm的配置密钥即可。这种零侵入性意味着开发者可以低成本试用不同模型,无需担心技术债务。

举个简单例子,原本调用OpenAI的代码:

import openai

openai.api_key = "sk-openai"

response = openai.ChatCompletion.create(

model="gpt-3.5-turbo",

messages=[{"role": "user", "content": "Hello World"}]

)

接入Litellm后只需修改两行:

import openai

openai.api_base = "http://localhost:8000" # Litellm代理地址

openai.api_key = "sk-litellm" # Litellm密钥

# 后续代码完全不变,可直接切换为claude-3-sonnet-20240229

response = openai.ChatCompletion.create(

model="claude-3-sonnet-20240229",

messages=[{"role": "user", "content": "Hello World"}]

)

3. 生产级保障,负载均衡与故障转移

在高并发场景下,单一模型接口可能出现响应延迟或服务中断问题。Litellm支持多模型实例配置,通过负载均衡算法将请求分发到不同实例,提升并发处理能力。同时,它具备智能故障转移机制,当某一模型服务不可用时,会自动将请求切换到备用模型,保障应用稳定性。

4. 精细化管控,日志、监控与权限

生产环境中,大模型调用的可观测性至关重要。Litellm内置了详细的日志记录功能,可记录每一次调用的模型类型、请求参数、响应耗时、token使用量等信息。结合Prometheus等监控工具,还能实现调用量、错误率、响应时间等指标的可视化监控。

此外,Litellm支持API密钥的权限管理,可针对不同密钥配置允许调用的模型列表、请求频率限制等,有效避免密钥滥用和成本失控。

5. 低成本优化,缓存与token控制

大模型调用成本是企业关注的重点,Litellm提供了请求缓存功能,对于重复的用户请求,可直接返回缓存结果,减少无效调用。同时,它支持设置最大token使用量、响应超时时间等参数,避免因超长文本或服务延迟导致的成本浪费。

三、快速上手Litellm的部署与基础使用

Litellm的部署和使用极为简便,无论是本地开发调试还是生产环境部署,都能快速完成。以下是基于Python环境的基础操作指南:

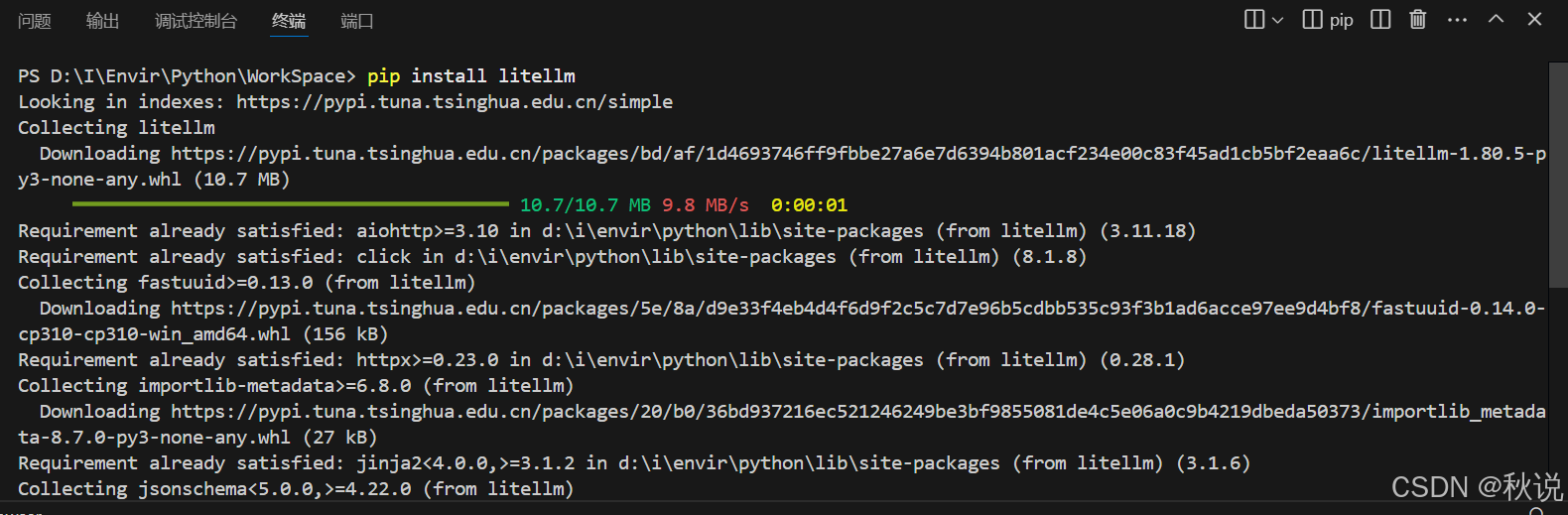

1. 环境准备与安装

首先确保本地Python版本在3.8及以上,然后通过pip命令安装Litellm:

# 基础安装

pip install litellm

# 如需支持所有模型(含开源模型),安装完整版本

pip install litellm[full]

2. 启动本地代理服务

安装完成后,通过命令行即可启动Litellm代理服务。基础启动命令如下,默认端口为8000:

# 基础启动(无认证,仅本地访问)

litellm --model gpt-3.5-turbo --api_base http://localhost:8000

# 带API密钥认证(生产环境必开)

litellm --model gpt-3.5-turbo --api_key sk-litellm-xxx --port 8080

# 多模型配置启动(同时支持GPT-3.5和Claude 3)

litellm --model gpt-3.5-turbo,claude-3-sonnet-20240229 --api_key sk-litellm-xxx

启动成功后,终端会提示“Uvicorn running on http://0.0.0.0:8080”,此时代理服务已正常运行。

3. 发送测试请求

可以通过curl命令或Python代码发送测试请求,验证服务可用性。以curl为例:

# curl:命令行HTTP请求工具,用于模拟客户端向服务端发送HTTP请求

# http://localhost:8080/v1/chat/completions:Litellm代理服务的对话接口地址

# - localhost:8080:代理服务运行的本地IP+端口(对应启动时--port 8080配置)

# - /v1/chat/completions:Litellm兼容的OpenAI风格对话接口路径(统一接口格式)

curl http://localhost:8080/v1/chat/completions \

-H "Content-Type: application/json" \

# Authorization: Bearer 认证:Litellm代理的访问权限验证

# sk-litellm-xxx:启动代理时设置的密钥(对应--api_key参数),防止未授权访问

-H "Authorization: Bearer sk-litellm-xxx" \

# -d:指定HTTP请求体(Data),包含核心请求参数(模型、对话内容等)

-d '{

# model:指定要调用的目标模型(这里是Anthropic的Claude 3 Sonnet版本)

# 注:模型名需与Litellm配置中一致,由代理转发到对应厂商API

"model": "claude-3-sonnet-20240229",

# messages:对话历史列表,按角色组织内容(OpenAI标准格式)

"messages": [

{

"role": "user", # 角色:user=用户(提问方),还支持system(系统提示)、assistant(助手回复)

"content": "请介绍Litellm的核心功能" # 用户的具体提问内容

}

]

}'

如果返回正常的模型响应,说明代理服务已成功对接模型。

4. 配置文件进阶使用

对于复杂的生产环境,推荐使用配置文件管理模型和服务参数。创建litellm_config.yaml文件,内容如下:

model_list:

- model_name: gpt-3.5-turbo

litellm_params:

model: openai/gpt-3.5-turbo

api_key: sk-openai-xxx

- model_name: claude-3

litellm_params:

model: anthropic/claude-3-sonnet-20240229

api_key: sk-anthropic-xxx

server_config:

port: 8080

api_key: sk-litellm-xxx # 代理服务的统一认证密钥

log_level: INFO # 日志级别

timeout: 30 # 响应超时时间(秒)

通过配置文件启动服务:

litellm --config litellm_config.yaml

四、生产环境最佳实践-从部署到监控

本地调试完成后,需要将Litellm部署到生产环境并配置完善的监控体系。以下是关键实践要点:

1. 容器化部署提升可扩展性

使用Docker将Litellm打包为容器,便于在Kubernetes等容器编排平台中部署,实现服务的弹性扩缩容。创建Dockerfile:

FROM python:3.10-slim

WORKDIR /app

COPY requirements.txt .

RUN pip install --no-cache-dir -r requirements.txt

COPY litellm_config.yaml .

EXPOSE 8080

CMD ["litellm", "--config", "litellm_config.yaml"]

requirements.txt中仅需包含“litellm”即可。构建并运行容器后,Litellm服务将以更稳定的方式运行。

2. 配置监控与告警

Litellm支持输出Prometheus格式的监控指标,只需在启动时开启metrics端口:

litellm --config litellm_config.yaml --metrics_port 9090

然后在Prometheus中配置指标采集地址,结合Grafana创建监控面板,重点监控以下指标:

-

litellm_requests_total:总调用次数

-

litellm_requests_failed_total:失败调用次数

-

litellm_request_latency_seconds:请求响应延迟

-

litellm_token_usage_total:总token使用量

当失败率超过阈值或延迟过高时,通过AlertManager配置告警通知,及时处理问题。

3. 高可用架构设计

为避免单节点故障导致服务中断,可采用“多实例+负载均衡”的架构:

-

部署多个Litellm实例,共享同一配置文件

-

使用Nginx或云服务提供商的负载均衡服务,将请求分发到多个实例

-

配置健康检查机制,自动剔除故障实例,保障服务可用性

五、总结

Litellm作为一款开源的大模型代理工具,以“统一接口、降低成本、提升效率”为核心优势,解决了大模型应用开发中的诸多痛点。它不仅简化了多模型接入的流程,还通过完善的运维能力,让大模型应用从开发调试平滑过渡到生产部署。

随着大模型生态的不断丰富,Litellm的功能也在快速迭代,未来有望支持更多垂类模型、提供更精细化的成本优化策略和更强大的可观测性工具。对于开发者而言,掌握Litellm不仅能提升大模型应用的开发效率,更能在模型选型、成本控制等方面掌握主动权,是大模型时代值得深入学习的实用工具。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?