基本概念

多模态大型语言模型(MLLMs)是人工智能领域的一项前沿技术,旨在设计能够理解和生成跨越多种形式数据输入(如文本和图像)内容的模型。

-

链接文本和视觉模态:MLLMs能够整合文本和视觉数据源的信息。MLLM可以处理并理解结合了书面语言和视觉元素(如图片、视频或图表)的内容。

-

提供基于对话的界面:MLLMs可以进行交互,对文本输入(如问题或提示)做出响应,并提供结合文本和图像的相关回复。这使得模型能以自然直观的方式与用户进行沟通。

-

提供指令遵循的能力:MLLMs有潜力理解并遵循通过文本提供的复杂指令,并可能通过视觉上下文进行增强。这使得它们能够执行需要理解一系列步骤或程序的任务。

对最新基于视觉的MLLMs进行全面分析:

1、Architectural choices(架构选择):这包括处理多模态数据的神经网络架构的设计。现代的架构可能涉及调整以适应文本和视觉信息独特方面的基于transformer的模型。

2、Multimodal alignment strategies(多模态对齐策略):有效MLLMs的核心组成部分是它们能够准确地对齐文本数据和视觉数据,确保模型理解两种模态中元素之间的关系。

3、Training techniques(训练技术):训练MLLMs的技术可能非常复杂,可能包括带有标记的多模态数据集的有监督学习、无监督学习,或是如对比学习等方法,以区分多模态输入之间的细微差别。

4、Visual grounding(视觉定位):这是模型将抽象文本概念与具体视觉表示联系起来的能力。定位确保模型在谈论一个对象时理解定义该对象的视觉特征。

5、Image generation and editing(图像生成和编辑):模型不仅能理解和讨论图像,还能生成或修改图像。这可以包括根据文本描述创建新图像或根据文本指令更改现有图像。

6、Visual understanding(视觉理解):对视觉方面的全面理解涉及识别对象、其属性、关系以及整个上下文。这种能力模仿人类的视觉理解能力,使模型能够解释图像或视频中的复杂场景。

7、Domain-specific applications(特定领域应用):应用于特定领域或行业的MLLMs从接受域特定数据的训练中受益。应用可以包括医学图像分析,模型通过结合医学专业的文本形式和来自扫描或X射线的视觉数据来帮助诊断。

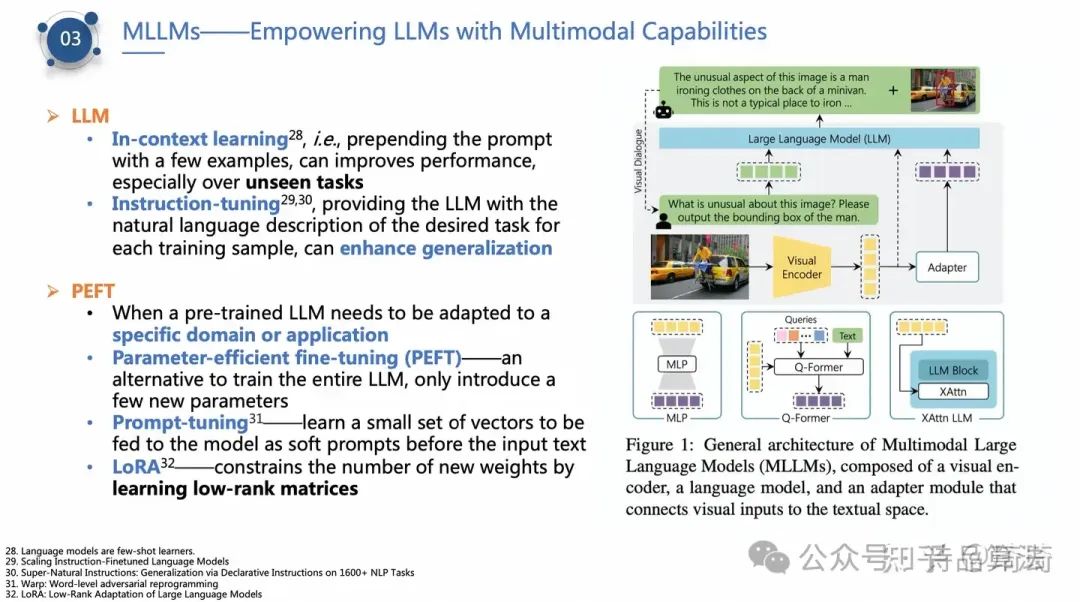

如何赋予LLM多模态能力

大型语言模型(LLM)通过对海量的文本数据进行学习,已经在多种任务上展现出了显著的能力。下面介绍几种相关的技术和方法:

LLM

-

上下文学习:Brown等人(2020年)的研究发现,可以在提示(prompt)前增加一些示例来进行学习,即所谓的“上下文学习”。这种方法可以提高模型的性能,尤其是在遇到未见过的任务时。上下文学习让模型能够理解提问的语境,因此在处理新类型的问题时,模型能够更好地推断和适应。

-

指令调整:为每个训练样本提供所需任务的自然语言描述,可以增强模型的泛化能力。这种方法让模型在学习时不仅仅关注于输入和输出的匹配关系,还能理解整个任务的背景和目的,从而对未见过的任务有更好的处理能力。

PEFT

当预训练的大型语言模型(LLM)需要适应特定领域或应用时,可采用如下几种方法:

-

参数高效微调(PEFT):与训练整个LLM相比,这是一种重要替代方案,只引入少部分新参数。这种方法可以在不大幅增加计算负担的情况下,调整模型以更好地适应特定的任务或领域。

-

提示调整:学习一小组向量,作为软提示在输入文本之前送入模型。这些“软提示”能够引导模型在处理输入文本时考虑到特定的任务或领域要求,从而改善模型的输出。

-

LoRA:通过学习低秩(low-rank)矩阵来限制新权重的数量。这是一种有效管理模型复杂度的技术,可以在增强模型能力的同时,控制模型规模的膨胀。

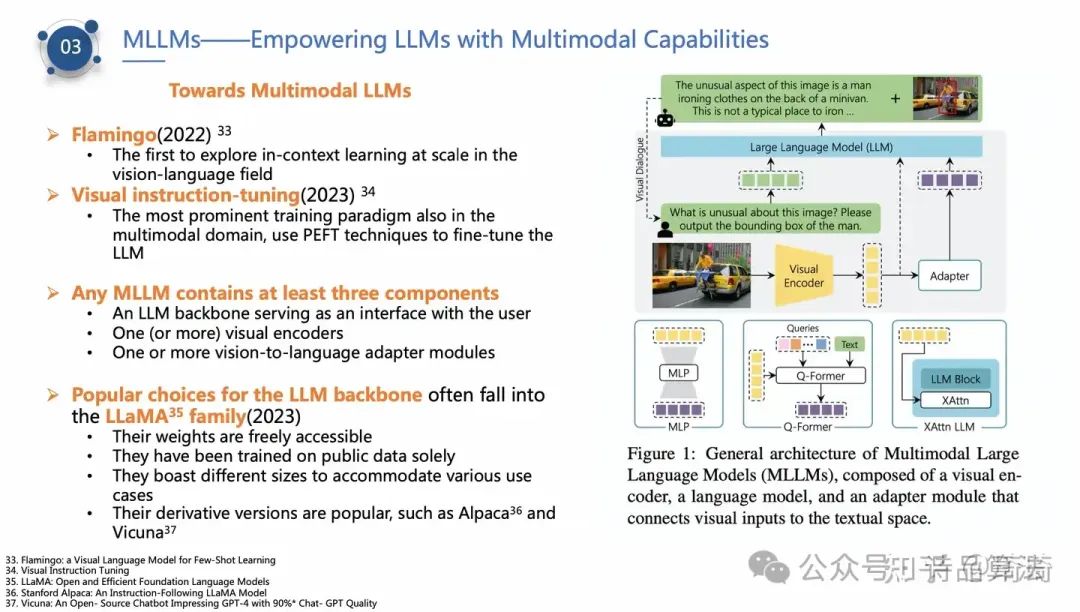

多模态大型语言模型(MLLMs)的发展代表了人工智能领域中的一个前沿方向,其结合了视觉与语言的处理能力,使模型不仅能理解文字信息,也能解析和理解图像数据。以下是对上述内容的中文解释:

-

Flamingo (2022):Flamingo是首个在视觉-语言领域大规模探索上下文学习(In-context learning)的模型。上下文学习指的是模型能够通过阅读前面的示例(上下文)来改善对随后信息的理解和预测,Flamingo通过这种方式有效地结合了视觉信息和语言信息,为多模态学习开辟了新道路。

-

视觉指令调整 (2023):在多模态领域,最突出的训练范式也开始利用参数高效微调(PEFT)技术对大型语言模型(LLM)进行微调。这种方法允许模型在处理含视觉和文本信息的复杂任务时,更好地理解和执行用户提供的自然语言指令。

任何多模态大型语言模型(MLLM)至少包含三个组成部分:

1、作为与用户交互界面的LLM基座。

2、一个(或多个)视觉编码器,负责将图像数据转换为模型可处理的形式。

3、一个或多个视觉到语言的适配器模块,用于将视觉信息转换或融合入语言处理流程中。

LLM基座通常选择LLaMA家族作为基座:

1、这些模型的权重可以自由访问,意味着研究者和开发者可以更容易地使用和修改这些模型。

2、它们完全基于公开数据进行训练,这有助于确保模型训练的透明性和可重现性。

3、LLaMA家族包含不同大小的模型版本,以适应不同的使用场景,从而为研究者和开发者提供了丰富的选择。

4、他们的衍生版本,如Alpaca和Vicuna,也很受欢迎,这些版本在特定任务或应用场景中可能提供了额外的优化或特性。

总体来看,多模态大型语言模型的发展不仅扩展了模型处理语言的能力,还使其能够理解和生成与视觉内容相关的信息,大大增强了模型在现实世界应用中的实用性和灵活性。

Reference

1、Language models are few-shot learners.

2、Scaling Instruction-Finetuned Language Models

3、Super-Natural Instructions: Generalization via Declarative Instructions on 1600+ NLP Tasks

4、Warp: Word-level adversarial reprogramming

5、LoRA: Low-Rank Adaptation of Large Language Models

6、Flamingo: a Visual Language Model for Few-Shot Learning

7、Visual Instruction Tuning

8、LLaMA: Open and Efficient Foundation Language Models

9、Stanford Alpaca: An Instruction-Following LLaMA Model

10、Vicuna: An Open- Source Chatbot Impressing GPT-4 with 90%* Chat- GPT Quality

如何学习大模型 AGI ?

由于新岗位的生产效率,要优于被取代岗位的生产效率,所以实际上整个社会的生产效率是提升的。

但是具体到个人,只能说是:

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

-END-

👉AGI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉AGI大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉AGI大模型视频和PDF合集👈

观看零基础学习书籍和视频,看书籍和视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

6414

6414

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?