一、环境部署

1.创建虚拟环境

打开 Anaconda Prompt 或 win+r→cmd 命令窗口,输入以下命令并回车

conda create –n py3.12-torch2.5.1 python==3.12

会得到名称为“py3.12-torch2.5.1”的虚拟环境,它将用来搭建搭建 Pytorch2.5.1 深度学习平台。

conda env remove -n py3.12-torch2.5.1来删除虚拟环境及环境中所有的包。

2.配置pytorch

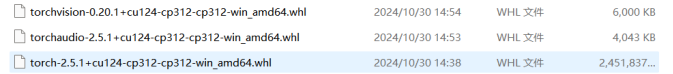

将压缩包内以下3个文件:

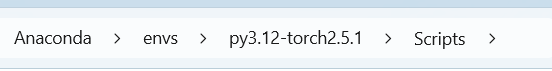

拷贝到以下路径:

然后在在Anaconda \envs\py3.12-torch2.5.1\Scripts”目录栏下输入“cmd”回车激活命令窗口,并在该窗口输入“conda activate py3.12-torch2.5.1”回车激活 py3.12-torch2.5.1环境。

在环境下输入:

pip install torchvision-0.20.1+cu124-cp312-cp312-win_amd64.whl

安装完后,接着输入 :

pip install torchaudio-2.5.1+cu124-cp312-cp312-win_amd64.whl

完成后继续输入:

pip install torch-2.5.1+cu124-cp312-cp312-win_amd64.whl

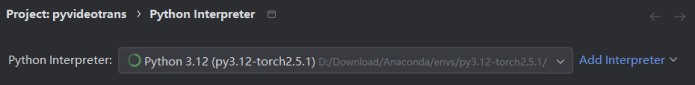

3.PyCharm 切换编译器

如下图,将编译器切换为创建的虚拟环境:

4.text-generation-webui源码项目文件

(1)从github仓库克隆源码

地址:https://github.com/oobabooga/text-generation-webui

(2)直接从text-generation-webui.zip 解压, 这是预先从仓库克隆下来的代码

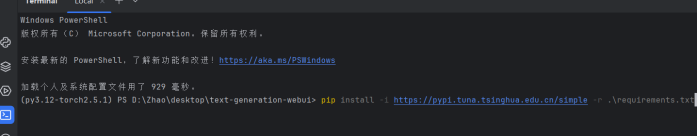

然后利用pycharm打开该工程文件到终端输入以下代码安装其他依赖库:

pip install -i Simple Index -r .\requirements.txt

5.Qwen2.5模型下载

下载地址:魔搭社区

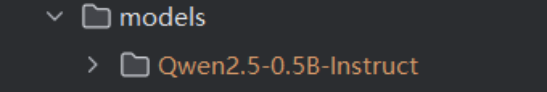

将下载好的模型解压到text-generation-webui下的models目录中, 解压后,目录中会存在一个名为 Qwen2.5-0.5B-Instruct 的文件。

二、实验步骤

1.打开server.py文件并运行,启动后, 点击http://127.0.0.1:7860打开webUI

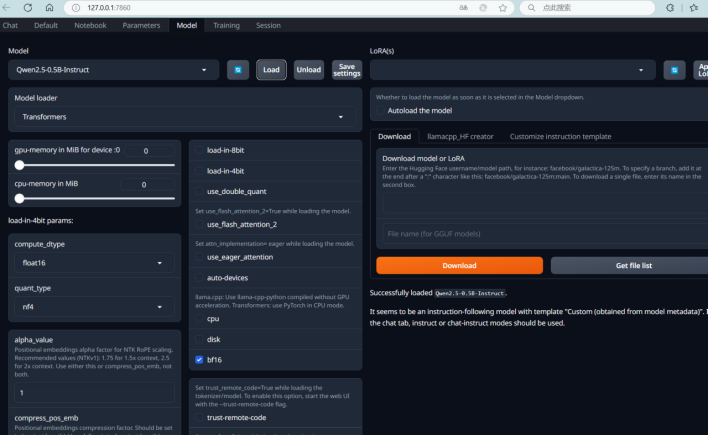

2.首先点击 Model 选项卡进入Model界面, 选择要载入的模型,这里预先安装了Qwen2.5-0.5B-Instruct,选择这个模型,Model Loader选择Transformers,然后点Load载入模型。

注意: 这个模型大概占用6G+显存,算上系统的显存占用, 实际显存可能需要8G以上, 如果显存大小不足8G的, 可以在Model界面下拖动"gpu-memory in MiB"滚动条,来设置显存使用的上限。

然后点击 Chat, 在右侧的Mode框中选择"instruct"就可以在Chat界面与模型进行对话了。

三、实验结果

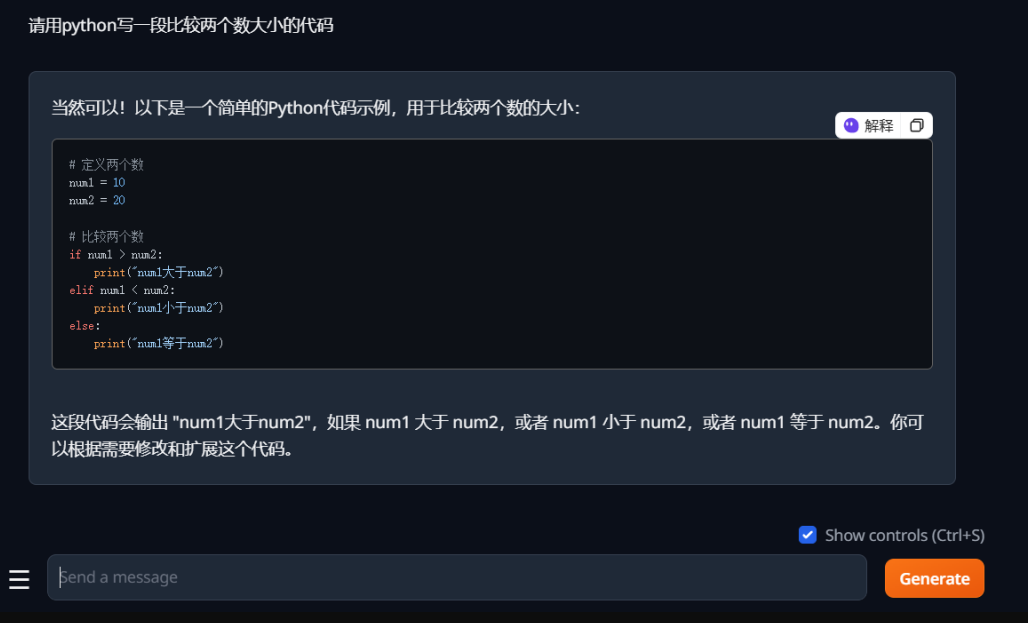

请用python写一段比较两个数大小的代码:

15万+

15万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?