名词解释

- 泛化能力:指模型在新的数据样本上的表现能力

- 过拟合:指学习器将数据的一些非普遍性的特性学到了。

- 欠拟合:模型学习能力太差了,训练样本的数据的一些普遍性特征都未学到

- 误差:

- 训练误差(经验误差):在训练集上的误差

- 测试误差:在测试集上的误差

- 泛化误差:学习器在所有新样本上的误差称为泛化误差

- 总结:我们希望得到的是泛化误差较小的学习器(即在新样本上表现较好的学习器)。(划出测试集,将测试误差近似看为泛化误差)

模型评估选择

- 主要针对不同的训练集与算法设定不同的评价指标

一种训练集一种算法

经验误差与过拟合

- 简述: 概念

评估方法

- 简介:划分训练集与测试集,近似用测试误差近似泛化误差,泛化能力指模型对没有见过的数据的预测能力,测试集尽量不出现在训练集中。

- 测试集的保留方法:

- 三七分,二八分(划分两个互斥的集合)(训练集测试集的划分要尽可能保持数据的一致性,采用分层抽样的方法获得子集,分层抽样)

- 交叉验证法:采用分层抽样的方法,将数据集划分为k个大小相同的子集。(又称k折交叉验证 思想:每次选用一个子集作为测试集,剩余k-1个作为训练集,这样就有k种分法,返回k次结果的均值,k常取10)(缺点:数据量大的时候,所需的算力较大)

- 自助法:给定包含m个样本的数据集D,每次随机从D 中挑选一个样本,将其拷贝放入D’,然后再将该样本放回初始数据集D 中,使得该样本在下次采样时仍有可能被采到。重复执行m 次,就可以得到了包含m个样本的数据集D’。可以得知在m次采样中,样本始终不被采到的概率取极限为:

通过自助采样,初始样本集D中大约有36.8%的样本没有出现在D’中,于是可以将D’作为训练集,D-D’作为测试集。自助法引入了估计偏差,所以 一般在数据够用时,留出法和交叉验证法更为常用。

通过自助采样,初始样本集D中大约有36.8%的样本没有出现在D’中,于是可以将D’作为训练集,D-D’作为测试集。自助法引入了估计偏差,所以 一般在数据够用时,留出法和交叉验证法更为常用。

- 验证集:为了模型调参,增加验证集(流程:先在训练集上训练模型,然后在验证集上调参,参数调完,最后在测试集上评价模型)

- 总结:因为训练模型要有训练集,因为泛化能力,要有测试集;因为调参,要有验证集。

性能度量(perfomance management)具体公式

-

任务描述:假设真实实例试 x,学习器f,要评估学习器性能,就是把预测结果f(x)与真实标记y进行比较。

-

均方误差:(MSE :回归任务,最常用)

-

在分类任务中,即预测离散值的问题,最常用的是错误率和精度,错误率是分类错误的样本数占样本总数的比例,精度则是分类正确的样本数占样本总数的比例,易知:错误率+精度=1。

-

查准率与查全率:

-

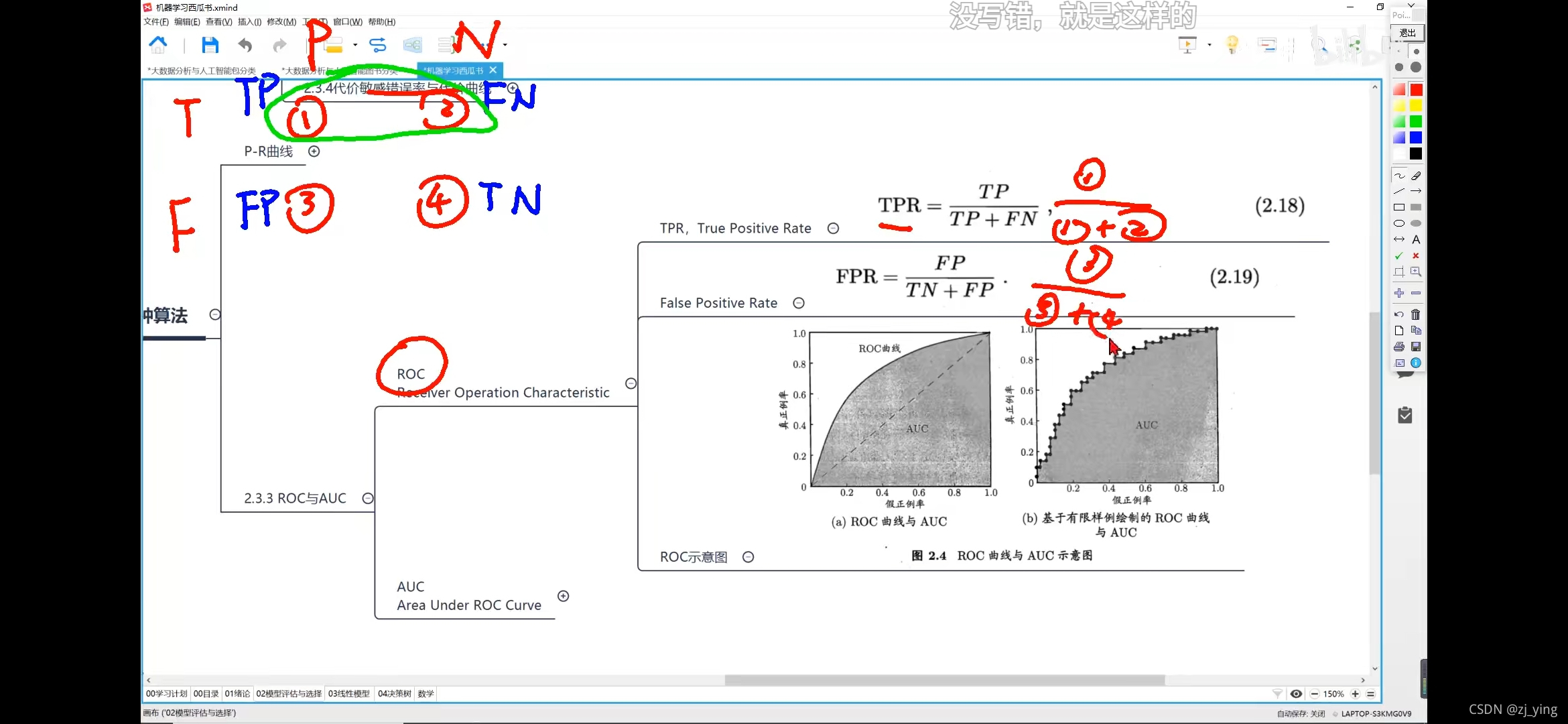

二分类混淆矩阵

-

查准率:就是预测的结果为1 的里面,有多少是正确的(看预测准不准);

-

查全率:就是值为1的结果,预测出来了多少(看预测全不全);

-

通俗理解,就是放在推荐案例中,查准率就是推荐的准;查全率就是推荐的全;

-

二者是一种矛盾的量,查准率想高,就需要提升标准,那么就有可能损失掉一些正确值,查全率就会低;查全率要想高,标准就会低,就会有很多错的值混入,查准率就会低;(在医学上,就是确诊 与 未漏诊情况)

-

-

P-R曲线:查准率(precision)为纵轴/查全率(Recall)为横轴;

- 最优阈值的确定

- 方法1:使用平衡点(交叉点,二者相等时)

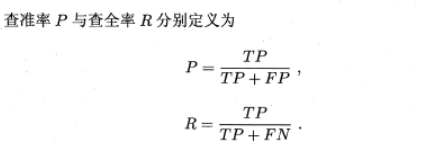

- 方法2 :F1度量,(F1 分数可以看作查准率与查全率的调和平均数,)

F1:公式推导

(从几何背景看出为什么F1 兼顾二者,更适合作为参数)

- 方法3 :Fbeta(上面公式)(加权调和平均)

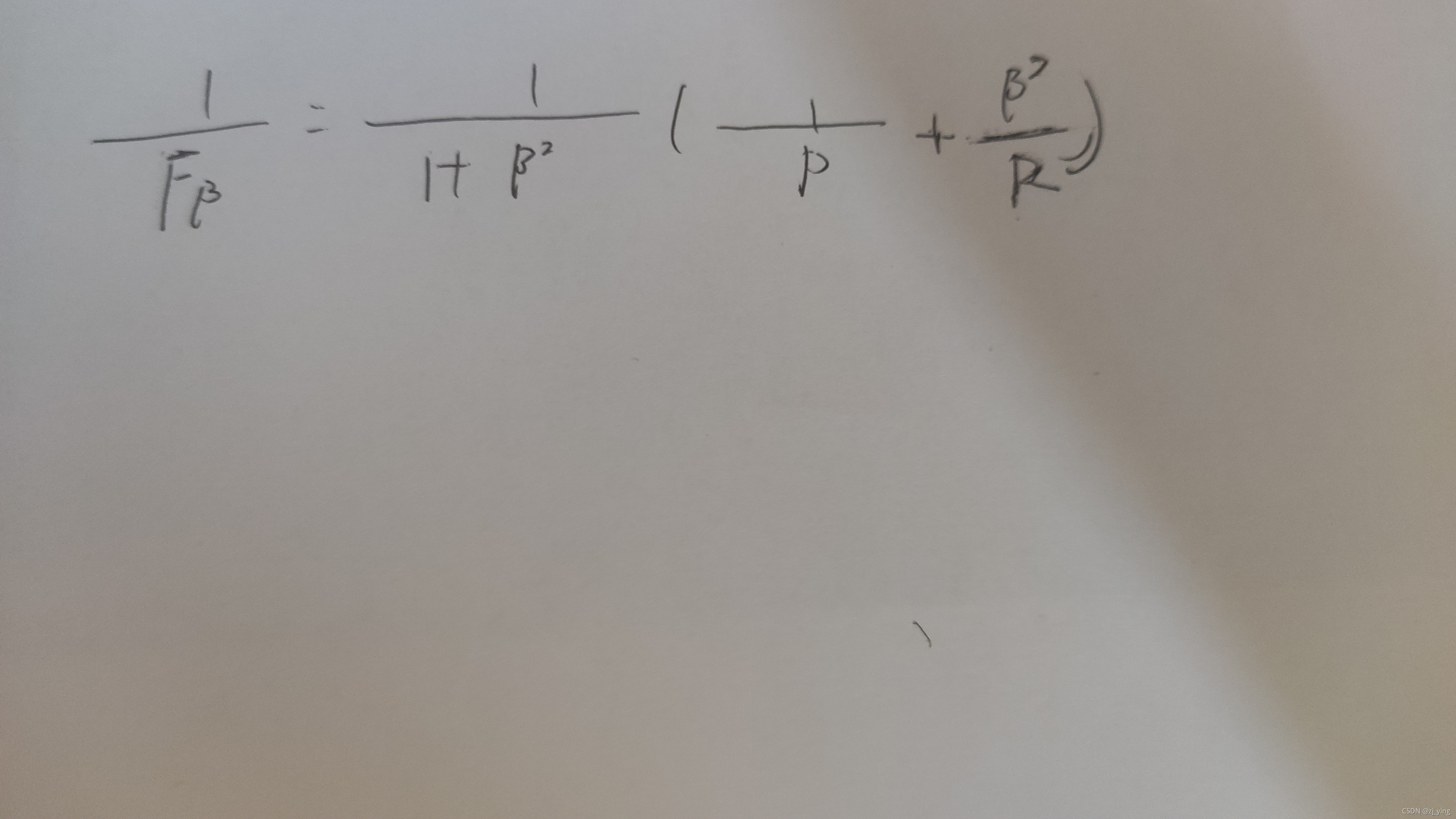

- 上述讨论都是在二分类的问题下,若是多分类情况,如下:

- 方法1:两两做二分类问题

- 方法2:one vs rest (比如10个数,先是不是1,再是不是2,…)

- (P1,R1)…(Pn ,Rn)

- 先分别计算,再求平均值

- 先求平均,再计算

一种训练集多种算法

P-R曲线

此图中,可以看出有三个模型ABC比较模型好坏

- 明显,BA优于C,判断A/B

- 对于A、B

- 方法1:比较A,B面积(但是不易于计算)

- 方法二:F1

- 方法三:Fbeta

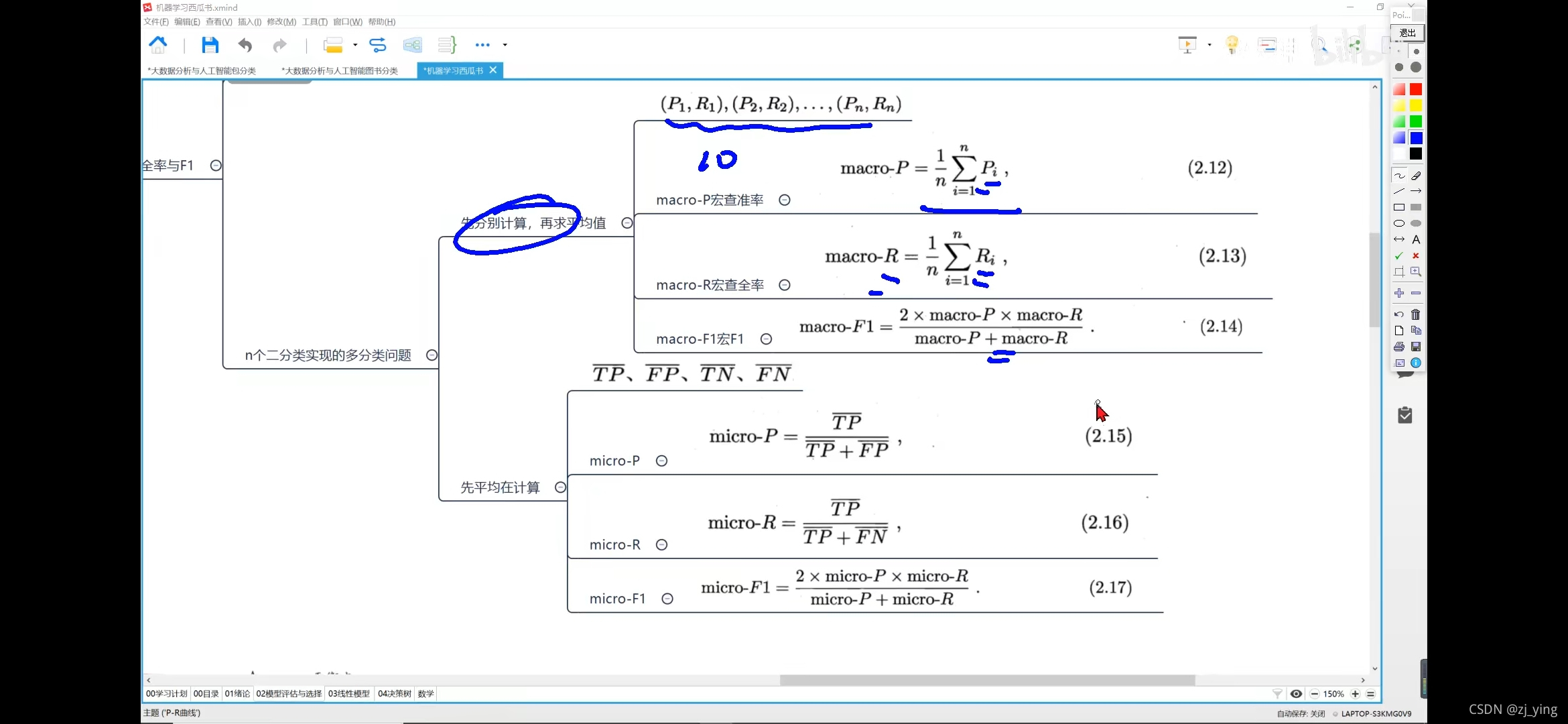

ROC与AUC曲线

- ROC

- TPR: 1/1+2 (TP/TP+FN)

- FPR:3/3+4(FP/FP+TN)

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?