引言:

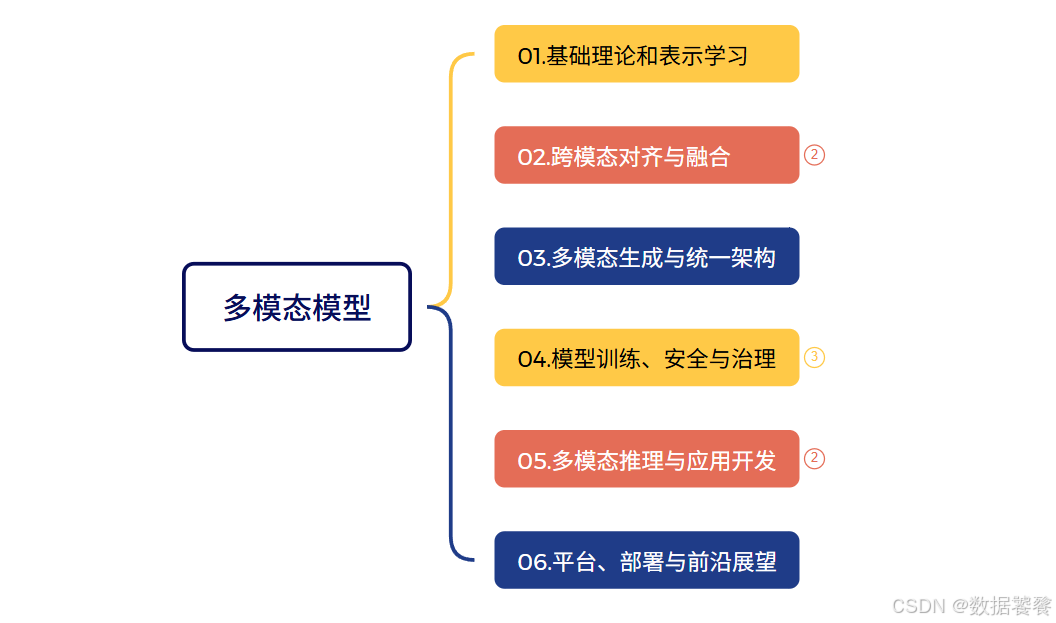

《多模态大模型全栈实训01:表示、对齐、生成、训练、应用和部署》- 总纲

《多模态大模型全栈实训02:表示、对齐、生成、训练、应用和部署》- 详纲

模块一:基础理论与表示学习

本模块是多模态学习的基石,重点解决如何将文本、图像、声音等不同数据统一“理解”的问题。

-

核心概念:多模态表示学习的目标是为不同形态的数据(如图像的像素、文本的词符、音频的声波)构建一个统一的、机器可理解的数学表示(通常是向量)。其核心挑战在于弥合不同数据形态在统计分布和信息密度上的巨大差异。

-

关键技术实现原理:

-

模态特定编码器:模型会为每种数据配备专门的“翻译器”。例如,使用视觉Transformer(ViT)将图像分割为图块并编码为向量序列;使用BERT等语言模型将文本转化为上下文相关的词向量。

-

统一表示空间构建:编码后的向量会被投影到一个共享的语义空间。这通常通过一个投影层(如多层感知机MLP)实现,其目标是让描述同一概念的向量(如“狗”的文本和狗的图像向量)在这个空间里位置接近。

-

自监督学习:为了在没有海量标注数据的情况下学习通用表示,模型会使用创造性的“自习”任务,例如掩码模态预测(遮住图像的一部分,让模型根据上下文和文本预测缺失内容)和跨模态对比学习。对比学习通过拉近匹配的图文对向量、推远不匹配的向量,来驱动模型学习语义关联。

-

模块二:跨模态对齐与融合

表示学习将数据映射到统一空间,而本模块则专注于建立不同模态数据间的精细关联,并实现信息的深度整合。

-

核心概念:跨模态对齐旨在建立像素与词语、声音与动作等之间的细粒度语义对应关系。多模态融合则是在对齐的基础上,将多源信息整合为更鲁棒、全面的统一表示,以支持下游决策。

-

关键技术实现原理:

-

跨模态对齐方法:

-

基于注意力机制的对齐:模型(如Transformer)可以动态计算图像区域与文本单词之间的注意力权重,自动找出“猫”这个词对应图片中的哪个区域。

-

基于对比学习的对齐:如CLIP模型,通过在海量图文对上训练,使匹配的图文在向量空间中靠近。

-

基于图神经网络的对齐:将不同模态的实体(如图像中的物体、文本中的名词)作为节点,构建跨模态图,通过消息传递来建模复杂的多模态关系。

-

-

多模态融合策略:

-

早期融合:在原始数据或特征层面直接拼接,计算效率高,但对未对齐数据敏感。

-

晚期融合:各模态先独立完成高级判断(如分类),再整合结果,容错性好但可能忽略底层交互。

-

混合融合/深度融合:利用跨模态注意力机制,让不同模态的特征在模型的多个层级进行交互,实现更灵活、深度的信息整合,这是当前主流方法。

-

-

模块三:多模态生成与架构设计

从“理解”走向“创造”,本模块探讨多模态内容的生成,以及支持理解与生成的统一模型架构。

-

核心概念:多模态生成是指根据一种模态的输入(如文本)生成另一种模态的内容(如图像、视频),或进行跨模态编辑。架构设计则关注如何构建能同时处理多种任务的统一模型框架。

-

关键技术实现原理:

-

生成模型范式:

-

自回归生成:像造句一样,将图像也视为一种序列(如图片块),逐块预测生成。其优势是与大语言模型范式统一,但生成速度较慢。

-

扩散模型生成:从纯噪声开始,逐步去噪,最终生成清晰图像或音频。它在生成高质量、多样化内容方面表现突出,是当前图像生成的主流。

-

-

统一多模态架构:

-

原生统一模型:如 Tuna 模型,其核心是设计一个统一的视觉表示。它通过连接一个负责细节的VAE编码器和一个负责语义的理解编码器(如SigLIP),形成既能用于理解又能用于生成的视觉特征,最后交给一个大语言模型进行统一调度。

-

混合专家模型:如 Qwen2.5-Omni,采用MoE架构。模型包含多个“专家”子网络,每份输入会动态路由给最相关的少数几个专家(如处理“文本+图像”的专家)进行处理,从而在保持巨大模型容量的同时大幅降低计算成本。

-

-

模块四:模型训练、安全与治理

本模块关注如何高效、安全地训练和管控大模型,涉及工程实践与伦理层面。

-

核心概念与关键技术:

-

预训练与对齐策略:

-

多阶段训练:例如Tuna采用三阶段训练策略:先固定大语言模型,训练视觉编码器与生成头的适配;然后解冻整个模型进行多任务联合训练;最后在高质量指令数据上进行微调,以对齐人类意图。

-

人类反馈强化学习:让模型生成多个答案,人类标注员选择偏好答案,训练一个“奖励模型”来指导模型优化,是使模型输出更符合人类价值观的关键技术。

-

-

安全架构与治理:

-

安全层设计:在模型输入输出端部署内容过滤器,实时拦截过滤有害、偏见或不合规的请求与生成内容。

-

可追溯性与水印:为AI生成的内容添加难以察觉的数字水印,以便进行版权确认和虚假信息溯源。

-

数据隐私保护:在训练中采用差分隐私技术,或在联邦学习框架下进行分布式训练,防止原始数据泄露。

-

-

模块五:多模态推理与应用开发

本模块旨在赋予模型“思考”能力,并将其转化为实际应用。

-

核心概念与关键技术:

-

多模态推理与理解能力:

-

核心是突破简单的模式匹配,进行深度语义理解和逻辑推理。例如GThinker模型提出的 “线索引导式反思” 机制。模型先进行自由推理,然后被引导回头校验关键的视觉线索,检查推理中是否存在矛盾或误判,并进行修正,形成“思考-反思-修正”的闭环,显著提升了复杂场景下的推理准确性。

-

-

大模型应用开发:

-

智能体框架:将多模态大模型作为“大脑”,结合工具调用(如搜索API、计算器)、记忆模块和规划器,构建能自主完成复杂任务的智能体。

-

应用范式:典型的应用包括跨模态检索系统(如以图搜文)、多模态对话系统(如支持图片的聊天机器人)和内容生成与编辑平台。

-

-

模块六:平台、部署与前沿展望

最后一站,我们将关注如何将模型转化为可服务的产品,并展望未来。

-

核心概念:

-

智能分析平台:这不是单一模型,而是一个集成了多模态数据接入、大模型分析、任务编排、可视化输出于一体的企业级系统。例如在数字孪生中,它能实时融合传感器数据、视频流和文本报告,进行综合态势分析与预测。

-

应用与部署能力:

-

部署优化:涉及模型量化(将FP32精度转换为INT4以提升速度)、模型剪枝(移除不重要的神经元)和使用高效推理引擎(如TensorRT)。

-

边缘部署:通过模型蒸馏等技术,将大模型压缩后部署到手机、物联网设备等终端,实现低延迟、隐私保护的本地推理。

-

-

-

未来趋势:领域正朝着 “全模态”实时交互(无缝融合文本、语音、视觉、乃至3D和触觉信号)、具身智能(模型驱动机器人理解并与物理世界互动)以及追求更高因果推理能力的方向演进。

1584

1584

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?