如果用户与 ChatGPT 的对话超出了上下文窗口,其性能将急剧下降。目前,增加上下文长度已成为科技公司改进模型并获得竞争优势的主要努力方向之一。

最近,谷歌发布了新的一篇论文介绍了一项新技术,使大语言模型能够处理无限长度的上下文。新论文声称可赋予大型语言模型(LLM)处理无限长度文本的能力。该论文介绍了无限注意力(Infini-attention),这是一种以扩展“上下文窗口”的方式配置语言模型的技术,同时保持内存和计算需求不变。

谷歌研究团队报告的实验表明,使用无限注意力的模型可以在超过一百万个tokens的情况下保持其质量,而无需额外的内存。理论上,同样的趋势可以持续到更大的长度。

无限注意力

Transformer 是LLM中使用的深度学习架构,其内存占用和计算时间具有“二次复杂度”。这意味着变压器处理数据所需的内存量和时间随着输入数据的大小呈指数增长。例如,如果将输入大小从 1,000 个tokens扩展到 2,000 个tokens,则处理输入所需的内存和计算时间不仅会增加一倍,还会增加四倍。

这种二次关系是由于 Transformer 中的自注意力机制造成的,它将输入序列中的每个元素与其他每个元素进行比较。

在过去几年中,研究人员开发了不同的技术来降低延长LLM上下文长度的成本。该论文将无限注意力描述为“长期压缩记忆和局部因果注意力,用于有效地建模长期和短期上下文依赖关系”。

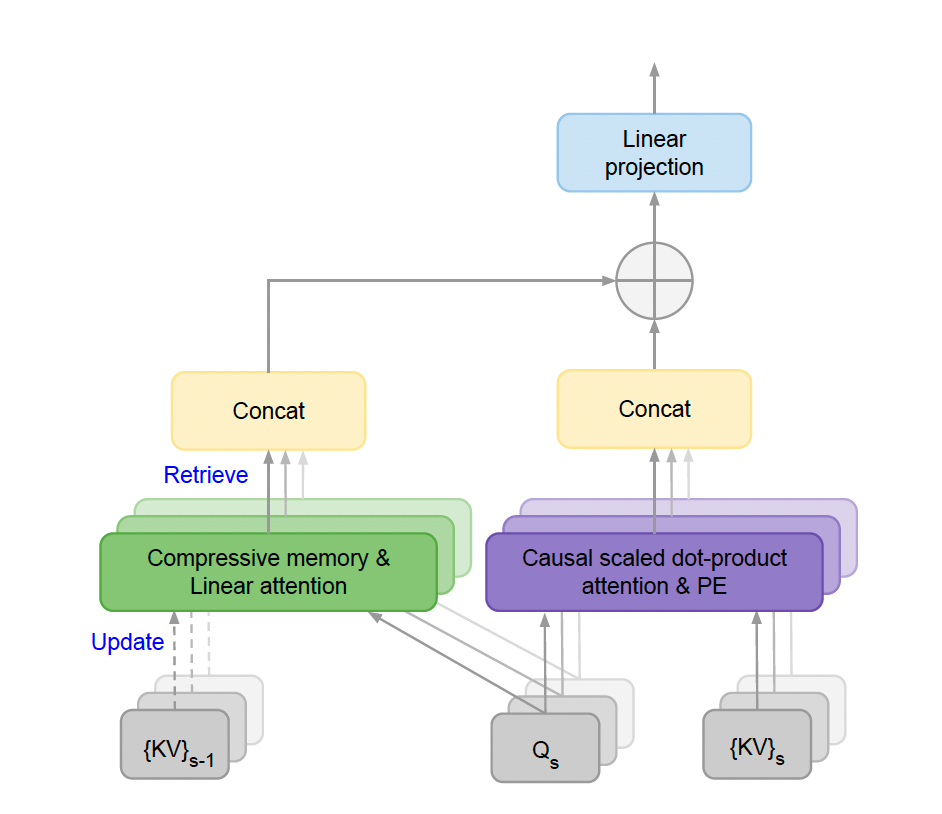

无限注意力架构

这意味着Infini-attention在变压器块中保留了经典的注意力机制,并添加了“压缩内存”模块来处理扩展输入。一旦输入超出其上下文长度,模型就会将旧的注意力状态存储在压缩记忆组件中,该组件会维护恒定数量的记忆参数以提高计算效率。为了计算最终输出,Infini-attention 聚合了压缩内存和本地注意力上下文。

研究人员表示:“对 Transformer 注意力层进行如此微妙但关键的修改,可以通过持续的预训练和微调,将现有的LLM自然扩展到无限长度的上下文。”

无限注意力架构的实际表现

研究人员在非常长的输入序列上测试 LLM 的基准测试中测试了 Infini-attention Transformer。在长上下文语言建模中,Infini-attention 保持较低的困惑度分数(模型一致性的衡量标准),同时需要 114 倍的内存,从而优于其他长上下文 Transformer 模型。

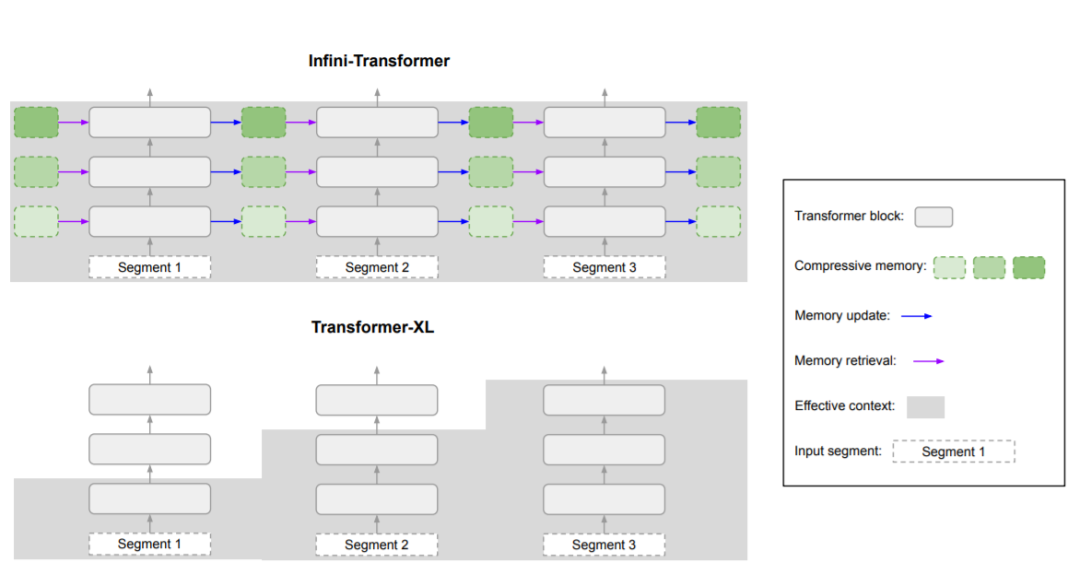

Infini-Transformer(上方)具有完整的上下文历史记录,而 Transformer-XL(下方)丢弃旧上下文,因为它仅缓存最后一段的 KV 状态

在“密钥检索”测试中,Infini-attention 能够返回插入最多一百万个tokens的长文本中的随机数。它在总结最多 500,000 个标记的文本任务方面优于其他长上下文技术。

论文称,测试是在具有 10 亿和 80 亿参数的 LLM 上进行的。谷歌没有发布模型或代码,因此其他研究人员无法验证结果。然而,报告的结果与Gemini报告的性能相似,Gemini 的上下文长度为数百万个tokens。

长上下文大语言模型的应用

长上下文大语言模型已成为前沿人工智能实验室之间研究和竞争的重要领域。Anthropic 的Claude 3支持多达 200,000 个tokens,而 OpenAI 的GPT-4具有 128,000 个tokens的上下文窗口。

具有无限上下文的大语言模型的突出优势之一是创建自定义应用程序。目前,为特定应用定制LLM需要微调或检索增强生成(RAG)等技术。虽然这些技术非常有用,但它们需要具有挑战性的工程工作。

理论上,具有无限上下文的LLM可以让用户将所有文档插入提示中,并让模型为每个查询选择最相关的部分。它还可以让用户通过提供一长串示例来自定义模型,以提高其在特定任务上的性能,而无需对其进行微调。

然而,这并不意味着无限上下文将取代其他技术。它将降低应用程序的进入门槛,使开发人员和企业能够快速为其应用程序创建工作原型,而无需进行大量的工程工作。企业需优化其LLM的研发生产系统,以降低成本并提高速度和准确性。

谷歌发布论文介绍了一种新技术Infini-attention,允许大语言模型处理无限长度文本,降低内存需求。实验显示即使在长输入下,模型性能稳定。这项技术可能降低定制LLM的工程难度,推动AI应用的发展。

谷歌发布论文介绍了一种新技术Infini-attention,允许大语言模型处理无限长度文本,降低内存需求。实验显示即使在长输入下,模型性能稳定。这项技术可能降低定制LLM的工程难度,推动AI应用的发展。

891

891

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?