在anaconda prompt中使用

./ labelme2voc.py ddata data_voc --labels labels.txt

将标注结果进行转换,报错如下:

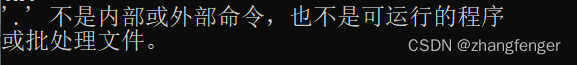

'.' 不是内部或外部命令,也不是可运行的程序

或批处理文件。

换成命令:

python ./labelme2voc.py ddata data_voc --labels labels.txt

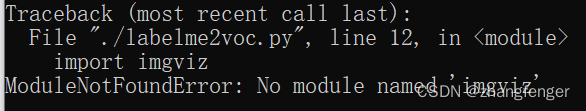

报错如下:

Traceback (most recent call last):

File "./labelme2voc.py", line 12, in <module>

import imgviz

ModuleNotFoundError: No module named 'imgviz'

使用如下命令安装imgviz:

pip install imgviz -i https://pypi.tuna.tsinghua.edu.cn/simple

安装成功后再执行转换命令:

python ./labelme2voc.py ddata data_voc --labels labels.txt

运行结果如下:

Creating dataset: data_voc

class_names: ('_background_', 'PEOPLE')

Saved class_names: data_voc\class_names.txt

能够生成data_voc文件夹,但是这个文件夹里面是空的。

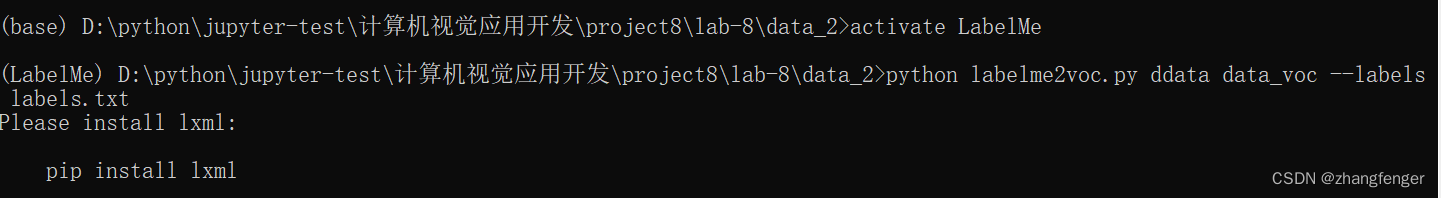

输入

activate LabelMe

激活labelme,运行环境从base转换到labelme,如下图所示,

使用

pip install lxml -i https://pypi.tuna.tsinghua.edu.cn/simple

安装lxml.

经检查发现 我的文件夹是data,但是我命令中使用的是ddata,所以改成就运行成功了,生成的文件夹中有内容。

python labelme2voc.py data data_voc --labels labels.txt

解决在Anaconda环境中运行labelme2voc.py时遇到的模块导入错误

解决在Anaconda环境中运行labelme2voc.py时遇到的模块导入错误

在尝试使用labelme2voc.py脚本将标注结果转换为VOC格式时,用户首先遇到了.不是内部或外部命令的错误。然后,他们通过使用Python调用脚本并安装缺失的imgviz模块解决了该问题。然而,之后的转换虽然创建了data_voc文件夹,但里面是空的。最后,用户发现文件路径错误并修正,成功生成了包含内容的data_voc文件夹,还安装了lxml以确保所有依赖项完整。

在尝试使用labelme2voc.py脚本将标注结果转换为VOC格式时,用户首先遇到了.不是内部或外部命令的错误。然后,他们通过使用Python调用脚本并安装缺失的imgviz模块解决了该问题。然而,之后的转换虽然创建了data_voc文件夹,但里面是空的。最后,用户发现文件路径错误并修正,成功生成了包含内容的data_voc文件夹,还安装了lxml以确保所有依赖项完整。

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?