1 简介

本文根据2014年Yoon Kim 《Convolutional Neural Networks for Sentence Classification》翻译总结的。

Text CNN 模型采用预训练的word vector加CNN(Convolutional Neural Networks)。也证明了预训练的word vectoc 在NLP任务中起重要的作用。

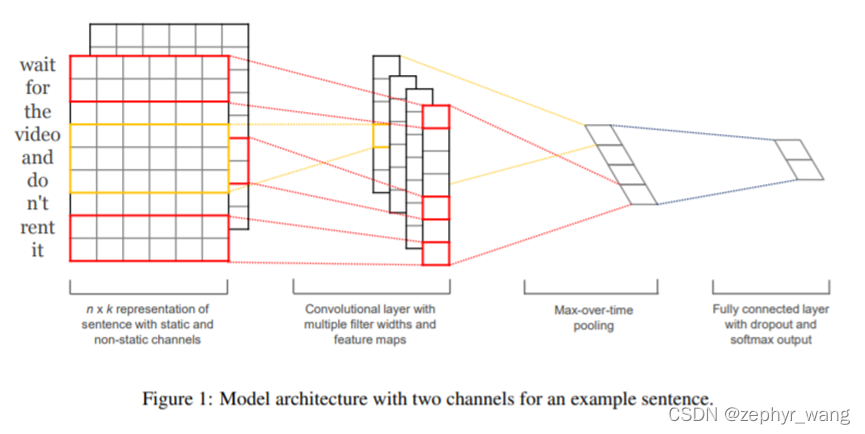

2 模型

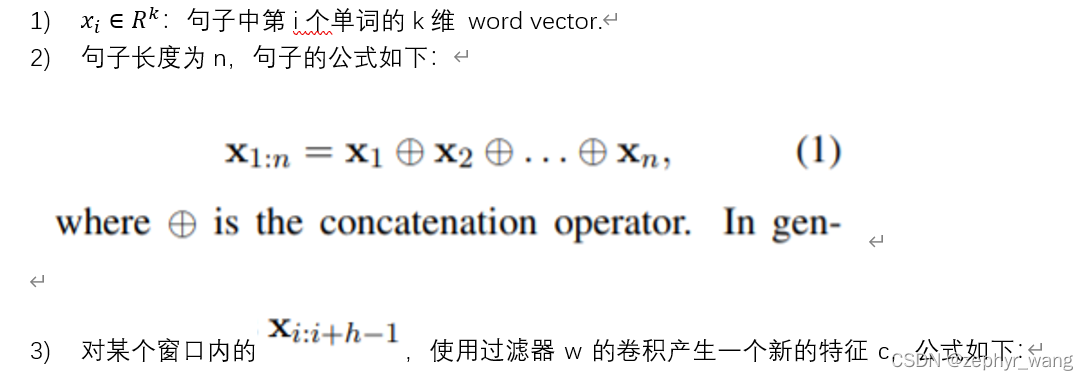

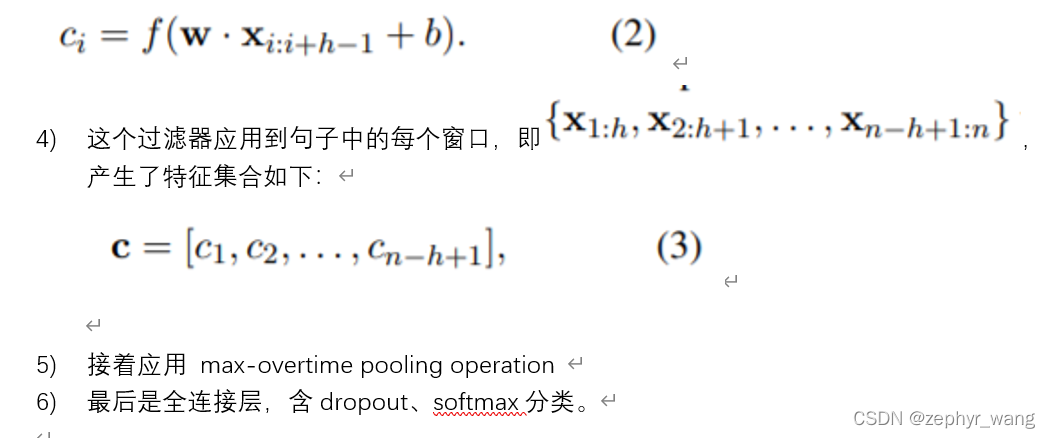

上图是两个channel(模型输入两组word vector,一组不进行backpropagated,一组进行backpropagated)的示例,下面文字主要描述了一个channel的情况。

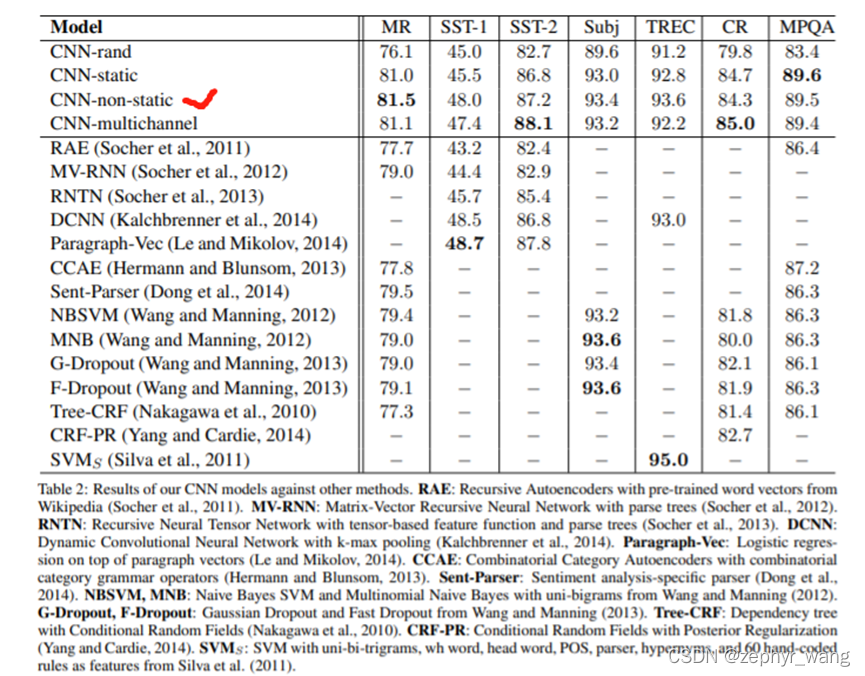

3 实验结果

1)CNN-rand:word vector是随机初始化的。

2)CNN-static: 采用预训练的word2vec初始化,保存静态不参与训练。

3)CNN-non-static:采用预训练的word2vec初始化,训练时进行fine-tuned。下表可以看出来,这个模型表现整体好些。

4) CNN-multichannel:包含两组word vector,每一组作为一个channel,如图1. 一组不进行backpropagated,一组进行backpropagated。两组都通过预训练的word2vec初始化。

本文介绍了如何在句子分类任务中应用TextCNN模型,结合预训练的Word2Vec向量。模型通过两种channel接收输入,一种静态不更新,一种动态fine-tuned。实验结果显示,预训练的Word2Vec对于提升模型性能至关重要,尤其是当模型进行fine-tuned时,性能表现更优。

本文介绍了如何在句子分类任务中应用TextCNN模型,结合预训练的Word2Vec向量。模型通过两种channel接收输入,一种静态不更新,一种动态fine-tuned。实验结果显示,预训练的Word2Vec对于提升模型性能至关重要,尤其是当模型进行fine-tuned时,性能表现更优。

985

985

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?