1 简介

BART: Bidirectional and Auto-Regressive Transformers.

本文根据2019年《BART: Denoising Sequence-to-Sequence Pre-training for Natural

Language Generation, Translation, and Comprehension》翻译总结。

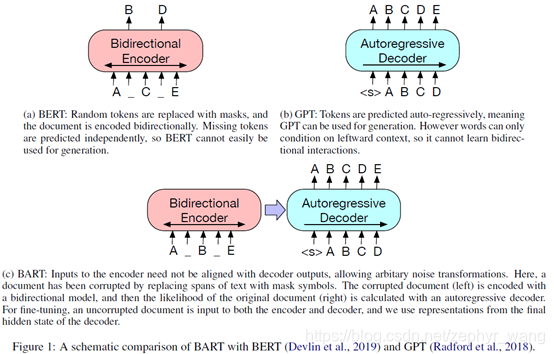

BERT是双向encoder,GPT是left-to-right decoder。BART可以说是既有encoder,又有decoder,即BERT和GPT结合体。如下图:

BART输入的损坏文本可以使用任意噪声函数,然后模型来学习回复原始文本。所以BART是一个去噪autoencoder。

BART是一个sequence-to-sequence model,包括双向encoder(接受损坏的文本)和left-to-right 自回归(autoregressive)decoder。

BART和BERT的差异是:(1)decoder的每一层会额外的对encoder的最后隐藏层进行cross-attention;(2)BERT在word预测前使用了feed-forward network,而BART没有使用。总体来说,BART比BERT多10%左右的参数。

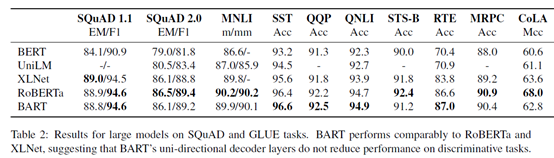

BART在Discriminative Tasks上,达到了RoBERTa类似的表现;在text generation tasks.取得了new state-of-the-art结果。

2 预训练BART

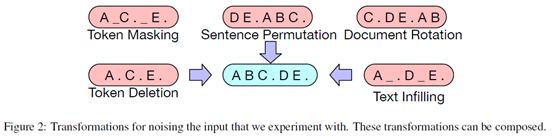

各种不同的输入情况:

Text Infilling:文本片段的一部分是被一个单独的[mask]替换,片段的长度从0到3等。

Sentence Permutation:根据句号分割句子,重新排列组合。

Document Rotation:随机找到一个token作为开始位置。

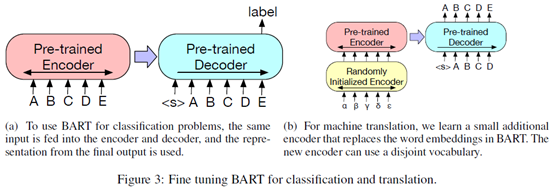

3 Fine-tuning BART

下面是分类和翻译的模型示例。翻译任务增加了一个随机初始化的encoder。

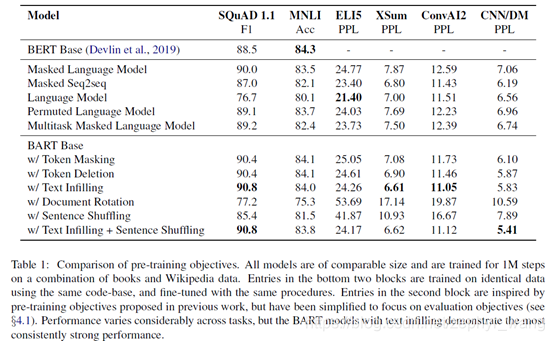

4 实验结果

可以看到test infilling的效果不错。其中Language Model(类似GPT),Permuted Language Model(基于XLNet)

4.1 Discriminative Tasks

BART可以达到RoBERTa的效果。

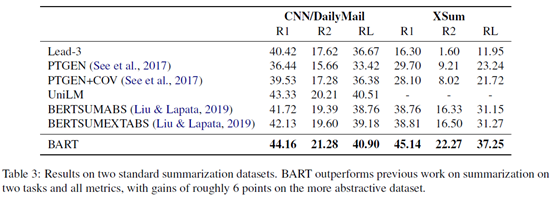

4.2 Generation Tasks

BART表现很好。

BART是结合BERT和GPT特性的双向序列到序列模型,用于自然语言生成、翻译和理解。它通过学习修复破坏文本来训练,包含双向encoder和自回归decoder。相比BERT,BART的decoder有额外的交叉注意力层,并且在预训练中采用多种文本噪声方式。在多项任务上,BART展现出优秀性能,特别是在生成任务上达到新的最佳状态。

BART是结合BERT和GPT特性的双向序列到序列模型,用于自然语言生成、翻译和理解。它通过学习修复破坏文本来训练,包含双向encoder和自回归decoder。相比BERT,BART的decoder有额外的交叉注意力层,并且在预训练中采用多种文本噪声方式。在多项任务上,BART展现出优秀性能,特别是在生成任务上达到新的最佳状态。

1196

1196

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?