EAST: An Efficient and Accurate Scene Text Detector

EAST:高效准确的场景文本检测器

【Abstract】

先前的场景文本检测方法已经在各种基准测试中取得了很好的成果。然而,在处理具有挑战性的情况时,即使配备了深度神经网络模型,它们通常也会达不到,因为整体性能取决于管道中多个阶段和组件的相互作用。在这项工作中,我们提出了一个简单而强大的管道,可以在自然场景中快速准确地进行文本检测。管道直接预测完整图像中任意方向和四边形形状的单词或文本行,消除了使用单个神经网络的不必要的中间步骤(例如,候选聚合和字分区)。我们的管道简单,可以集中精力设计损耗函数和神经网络架构。对标准数据集(包括ICDAR 2015,COCO-Text和MSRA-TD500)的实验表明,所提出的算法在准确性和效率方面明显优于最先进的方法。在ICDAR 2015数据集上,所提出的算法在720p分辨率下以13.2fps达到0.7820的F分数

【Introduction】

最近,提取和理解自然场景中包含的文本信息变得越来越重要和受欢迎,ICDAR系列竞赛的前所未有的大量参与者[30,16,15]以及NIST对TRAIT 2016评估的启动证明了这一点。[1]。

文本检测作为后续过程的先决条件,在文本信息提取和理解的整个过程中起着至关重要的作用。 先前的文本检测方法[2,33,12,7,48]已经在该领域的各种基准上获得了有希望的表现。 文本检测的核心是区分文本和背景的功能设计。 传统上,功能是手动设计[5,25,40,10,26,45]来捕捉场景文本的属性,而基于深度学习的方法[3,13,11,12,7,48]有效的功能直接 从培训数据中学习。

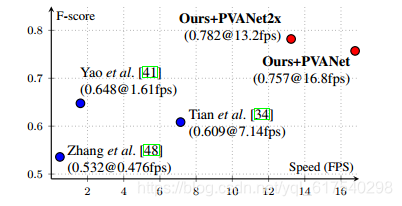

图1. ICDAR 2015 [15]文本本地化挑战的性能与速度。 可以看出,我们的算法在准确性方面明显优于竞争对手,同时运行速度非常快。 使用的硬件规格列于表格6。

然而,现有的方法,无论是传统的还是基于深度神经网络的,主要由几个阶段和组件组成,这些阶段和组件可能是次优的和耗时的。 因此,这些方法的准确性和效率仍远远不能令人满意。

在本文中,我们提出了一个快速准确的场景文本检测管道,它只有两个阶段。 该管道使用完全卷积网络(FCN)模型,该模型直接生成单词或文本行级别预测,不包括冗余和慢速中间步骤。 生成的文本预测(可以是旋转的矩形或四边形)被发送到非最大抑制以产生最终结果。 根据标准基准的定性和定量实验,与现有方法相比,该算法实现了显着提高的性能,同时运行速度更快。

具体而言,所提出的算法在ICDAR 2015 [15](在多尺度下测试时为0.8072),在MSRA-TD500 [40]上为0.7608,在COCO-Text [36]上为0.3945时达到了0.7820的F分数,优于以前的状态 - 性能最先进的算法,平均花费的时间少得多(在Titan-X GPU上,我们最佳性能模型的分辨率为720p,分辨率为13.2fps,最快模型为16.8fps)。

这项工作的贡献是三倍:

(1)我们提出了一种场景文本检测方法,包括两个阶段:完全卷积网络和NMS合并阶段。 FCN直接生成文本区域,不包括冗余和耗时的中间步骤。

(2)管道可以灵活地生成字级或线级预测,其几何形状可以是旋转框或四边形,具体取决于具体应用。

(3)所提出的算法在精度和速度方面明显优于最先进的方法。

【Related Work】

场景文本的检测和识别已经成为计算机视觉领域长期积极的研究课题。众多鼓舞人心的思想和有效的方法[5,25,26,24,27,37,11,12,7,41,42,31] 已经进行过调查。综合评论和详细分析可以在调查论文中找到[50,35,43]。 本节将重点介绍与所提算法最相关的工作。

传统方法依赖于手动设计的特征。 基于中风宽度变换(SWT)[5]和最大稳定极值区域(MSER)[25,26]的方法通常通过边缘检测或极值区域提取来寻找候选字符。 张等人。 [47]利用文本的局部对称性,并为文本区域检测设计了各种特征。 FASText [2]是一个快速文本检测系统,适应和修改了众所周知的用于中风提取的快速关键点检测器。 然而,就精度和适应性而言,这些方法落后于基于深度神经网络的方法,尤其是在处理具有挑战性的场景时,例如低分辨率和几何失真。

最近,场景文本检测领域进入了一个新的时代,基于深度神经网络的算法[11,1348,7]逐渐成为主流。黄等人。 [11]首先找到使用MSER的候选人,然后使用深度卷积网络作为强分类器来修剪误报。 Jaderberg等人的方法。 [13]以滑动窗口的方式扫描图像,并使用卷积神经网络模型为每个尺度生成密集的热图。后来,Jaderberg等人。 [12]同时使用CNN和ACF来搜索候选词,并使用回归进一步细化它们。田等人。 [34]开发了垂直锚,并构建了CNN-RNN联合模型来检测水平文本行。与这些方法不同,张等人。 [48]建议利用FCN [23]进行热图生成,并使用分量投影进行方位估计。这些方法在标准基准测试中获得了优异的性能然而,如图2(a-d)所示,它们主要由多个阶段和组件组成,例如通过后置滤波的假阳性去除,候选聚合,线形成和字分区。多个阶段和组件可能需要进行详尽的调整,从而导致次优性能,并增加整个流水线的处理时间。

EAST是一种快速准确的场景文本检测方法,通过全卷积网络直接预测文本区域,无需多余的中间步骤。在ICDAR 2015、COCO-Text和MSRA-TD500数据集上,该算法在准确性和速度上均优于现有技术,特别是在ICDAR 2015上实现了0.7820的F分数,运行速度为13.2fps。

EAST是一种快速准确的场景文本检测方法,通过全卷积网络直接预测文本区域,无需多余的中间步骤。在ICDAR 2015、COCO-Text和MSRA-TD500数据集上,该算法在准确性和速度上均优于现有技术,特别是在ICDAR 2015上实现了0.7820的F分数,运行速度为13.2fps。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

102

102

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?