论文地址:https://arxiv.org/abs/1704.03155v2

算法实现:https://github.com/argman/EAST

已有方法局限:

文本检测的关键是设计特征用来从背景图片中找到文本,利用的是图片分割的原理,把需要识别的文本从图片中分割出来。

传统的方法是手工设计特征,深度学习方法是从训练集上学习提取特征。无论是传统的方法还是深度学习方法,都包含了几个组件和步骤,这会导致消耗大量的时间生成的确不是最优的结果。

EAST方法的优势:

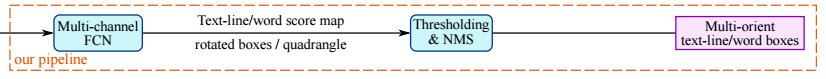

论文提出的方法只使用两步,第一步使用全卷积网络生成单词或文本行的预测(生成的预测可以是旋转的矩形或文本行的预测),第二把前一步的预测送到NMS(非极大值抑制)返回最终结果,相对已存在的方法这种方法消耗的时间更短,且性能有一定的提高。

FCN(全卷积):https://zhuanlan.zhihu.com/p/20872103?refer=dlclass

测试结果: F-score 数据集

0.7820 ICDAR 2015 [15] (0.8072 when tested in multi-scale),

0.7608 MSRA-TD500 [40]

0.3945 COCO-Text [36]

论文贡献:

- 提出了一种使用FCN+NMS的方法,减少了中间步骤。

- 预测输出是灵活的,可以预测单词或文本行,可以产生旋转矩阵和四边形的预测结果。

- 提出的方法相对以前的方法在时间和精确度上有了一定的提高。

NMS(非极大值抑制):http://blog.youkuaiyun.com/shuzfan/article/details/52711706

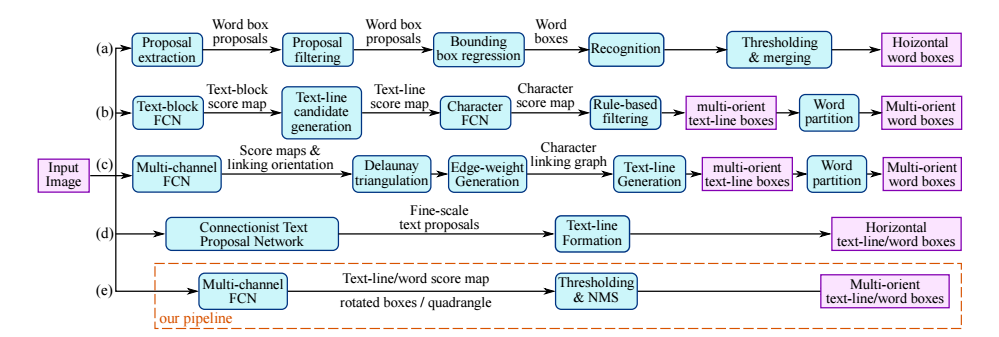

各种文本检测方法的设计结构:

论文提出的方法第一步使用FCN用来为单词或文本行的每一个像素做出预测判断,判断每个文本和形状的预测,消除了生成候选区域,生成文字区域,分开文字等中间步骤,第二步仅包含一个阈值来使用NMS用来预测几何形状。

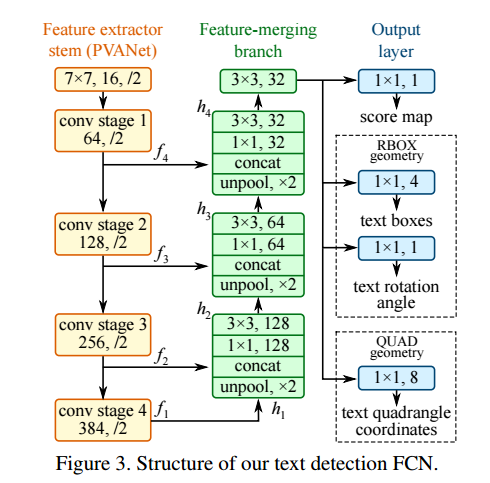

网络结构:

PVANet:https://www.cnblogs.com/fariver/p/7449563.html

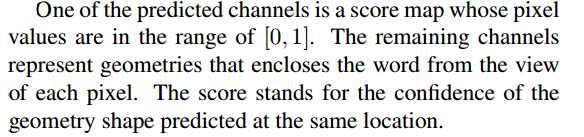

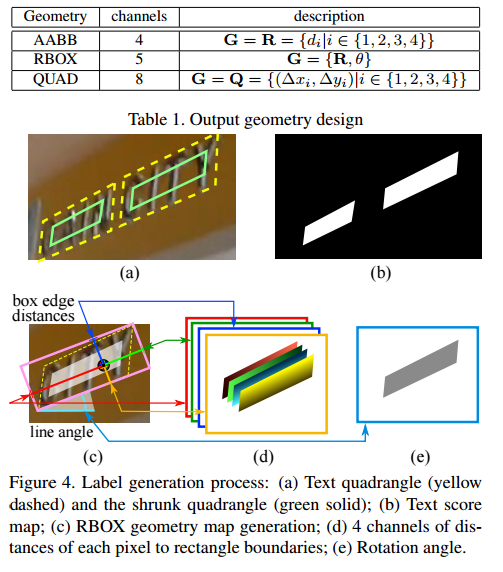

图片被送到FCN中,输出了多通道的每个像素级文本的分数和几何图形。通道预测的包含一个映射每个像素的像素图,每个像素的分值范围在[0,1]中,其余通道表示从视图中包围单词的几何的每个像素。 得分代表了信心在相同位置预测的几何形状。

为旋转的矩阵和四边形设计不同的损失函数,然后将阈值应用到每个预测区域,当预测集合图形的分数超过阈值时,被认为有效,保存下来送给NMS处理。

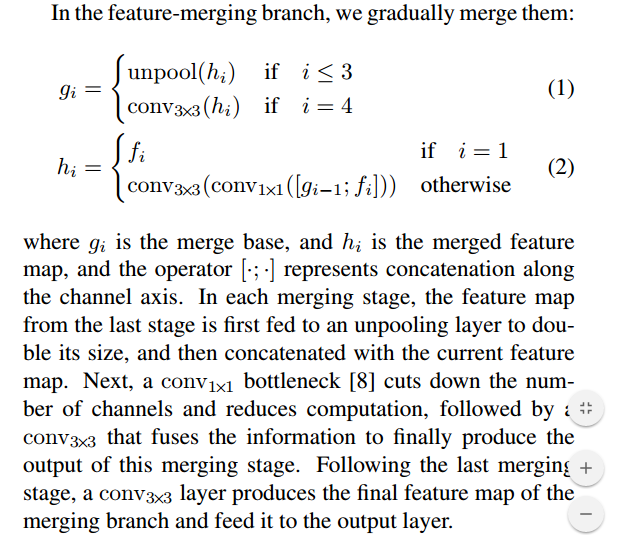

网络设计: 设计网络时必须考虑到一些因素,由于字体区域大小多种多样,确定大字需要从神经区域网络后面提取特征,而预测小字的所需信息需要在神经网络的前面步骤提取。

fi are extracted from the stem, whose sizes are 1/32 ,1/16 ,1/8 and 1/4 of the input image.

标签生成:

本文介绍了一种高效的文本检测方法EAST,该方法通过使用全卷积网络(FCN)进行文字区域预测,并结合非极大值抑制(NMS)算法优化结果。相比传统方法,EAST减少了中间步骤,提高了检测速度和准确性。

本文介绍了一种高效的文本检测方法EAST,该方法通过使用全卷积网络(FCN)进行文字区域预测,并结合非极大值抑制(NMS)算法优化结果。相比传统方法,EAST减少了中间步骤,提高了检测速度和准确性。

85

85

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?