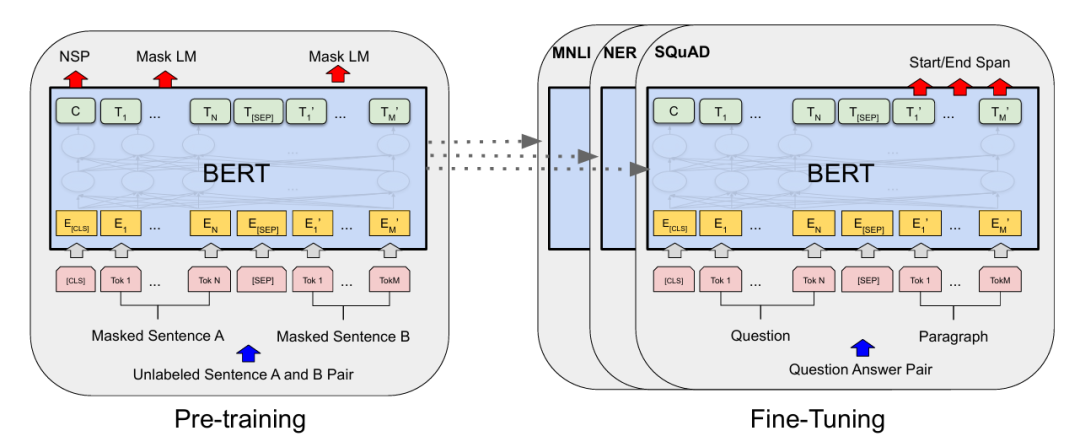

本文详细解析了BERT中Masked Language Model(MLM)的工作机制。MLM通过随机遮住部分词,让模型根据上下文预测被遮词。数据流程包括:输入准备阶段(生成token ids和标签)、Embedding层(包括[MASK]的embedding)、Transformer Encoder层(自注意力机制,被遮词作为Query读取上下文Key/Value)、输出层(预测被遮词)。关键点是被遮词仍生成Query,通过自注意力聚合上下文信息,最终预测原词。

一、MLM 的目标

Masked Language Modeling (MLM) 的目标是在输入句子中随机 Mask 一部分 token,然后让模型根据上下文(前后)预测它们。

例如输入:

The cat sat on [MASK] mat.

目标是让模型输出:

The cat sat on [MASK] mat. ↑ 预测 "the"

二、数据是怎么流的

我们以 Transformer Encoder(BERT)为例:

1.输入准备阶段

- 原始句子 → Tokenizer 编码 → token ids

例如:

[101, 1996, 4937, 1012, 103, 102]

其中 [MASK] 的 ID 是 103。

- 同时保留一份 原始词标签(label):

[-100, -100, -100, -100, 103, -100]

只有被 Mask 的位置保留真实词 id,其它位置是 -100, 这里 -100 的作用是告诉 CrossEntropyLoss这些位置忽略掉,不计算损失。

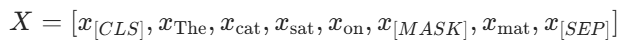

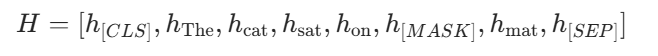

2.经过 Embedding 层

每个 token id(包括 [MASK])都会被映射成一个向量:

其中:

[MASK]也有自己的 embedding(是一个可训练向量)- 它只是一个占位符,不含原词语义。

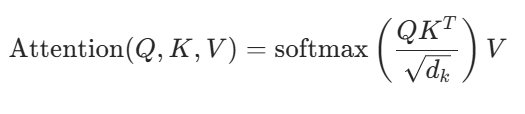

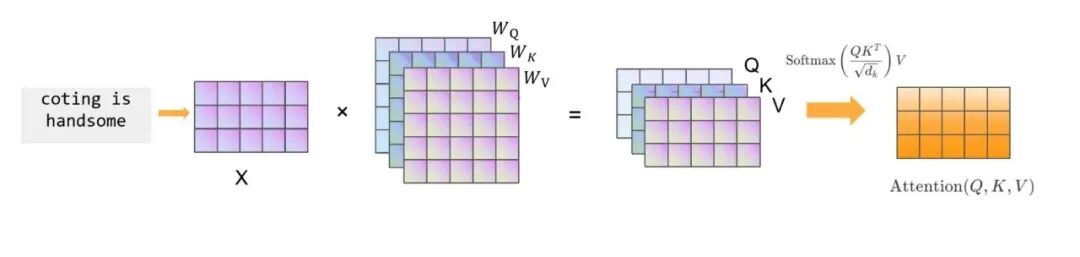

3.进入 Transformer Encoder 层(Self-Attention)

现在,注意力机制登场:

在这里:

- 所有 token(包括

[MASK])都会生成自己的 Query、Key、Value; - 每个位置都能看到整个句子(因为 BERT 是双向的);

- 所以

[MASK]位置的 Query 会去关注左右两边的 token; - 它无法知道自己是什么词,但能从上下文聚合信息。

也就是说被 Mask 的位置充当 Query,利用上下文 Key/Value 预测原词。

4.经过多层 Transformer 编码后

每个位置都会输出一个向量:

此时:

- 对于

[MASK]位置,已经包含了来自前后文的语义信息; - 它不包含原词 embedding(因为那被替换成了

[MASK]); - 但通过 self-attention,它捕获了上下文的关联特征。

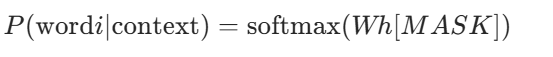

5.最后一层预测(输出层)

BERT 的输出层结构是:

其中 (W) 的大小是 V*d_model(与词表大小相同)。

- 对于每个 token 位置都会计算一份 logits;

- 但只在 被 Mask 的位置 计算 loss。

即:

loss=CrossEntropy(logits[mask_positions],true_tokens[mask_positions])

softmax 后得到每个词的概率分布:

选择概率最大的那个词作为预测输出。

总结一下就是在 BERT 的 MLM 训练中,被 Mask 的位置仍会生成 Query,它通过自注意力机制读取其他未 Mask 的 Key/Value,聚合成上下文表示,最后通过线性层 + softmax 预测出原词。

如何学习大模型 AI ?

由于新岗位的生产效率,要优于被取代岗位的生产效率,所以实际上整个社会的生产效率是提升的。

但是具体到个人,只能说是:

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线科技企业深耕十二载,见证过太多因技术卡位而跃迁的案例。那些率先拥抱 AI 的同事,早已在效率与薪资上形成代际优势,我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在大模型的学习中的很多困惑。我们整理出这套 AI 大模型突围资料包:

- ✅ 从零到一的 AI 学习路径图

- ✅ 大模型调优实战手册(附医疗/金融等大厂真实案例)

- ✅ 百度/阿里专家闭门录播课

- ✅ 大模型当下最新行业报告

- ✅ 真实大厂面试真题

- ✅ 2025 最新岗位需求图谱

所有资料 ⚡️ ,朋友们如果有需要 《AI大模型入门+进阶学习资源包》,下方扫码获取~

① 全套AI大模型应用开发视频教程

(包含提示工程、RAG、LangChain、Agent、模型微调与部署、DeepSeek等技术点)

② 大模型系统化学习路线

作为学习AI大模型技术的新手,方向至关重要。 正确的学习路线可以为你节省时间,少走弯路;方向不对,努力白费。这里我给大家准备了一份最科学最系统的学习成长路线图和学习规划,带你从零基础入门到精通!

③ 大模型学习书籍&文档

学习AI大模型离不开书籍文档,我精选了一系列大模型技术的书籍和学习文档(电子版),它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。

④ AI大模型最新行业报告

2025最新行业报告,针对不同行业的现状、趋势、问题、机会等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

⑤ 大模型项目实战&配套源码

学以致用,在项目实战中检验和巩固你所学到的知识,同时为你找工作就业和职业发展打下坚实的基础。

⑥ 大模型大厂面试真题

面试不仅是技术的较量,更需要充分的准备。在你已经掌握了大模型技术之后,就需要开始准备面试,我精心整理了一份大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

以上资料如何领取?

为什么大家都在学大模型?

最近科技巨头英特尔宣布裁员2万人,传统岗位不断缩减,但AI相关技术岗疯狂扩招,有3-5年经验,大厂薪资就能给到50K*20薪!

不出1年,“有AI项目经验”将成为投递简历的门槛。

风口之下,与其像“温水煮青蛙”一样坐等被行业淘汰,不如先人一步,掌握AI大模型原理+应用技术+项目实操经验,“顺风”翻盘!

这些资料真的有用吗?

这份资料由我和鲁为民博士(北京清华大学学士和美国加州理工学院博士)共同整理,现任上海殷泊信息科技CEO,其创立的MoPaaS云平台获Forrester全球’强劲表现者’认证,服务航天科工、国家电网等1000+企业,以第一作者在IEEE Transactions发表论文50+篇,获NASA JPL火星探测系统强化学习专利等35项中美专利。本套AI大模型课程由清华大学-加州理工双料博士、吴文俊人工智能奖得主鲁为民教授领衔研发。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的技术人员,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

以上全套大模型资料如何领取?

1215

1215

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?