1、LangChain究竟是什么?

在大模型应用开发领域,LangChain是一款极具影响力的开发框架。它以大型语言模型(LLMs)出色的少样本(few-shot)与零样本(zero-shot)泛化能力为根基,将提示词工程(Prompt Engineering)作为核心控制手段,为开发者搭建了一条高效的“桥梁”——无需从零构建复杂模型,就能根据实际业务需求快速叠加功能模块,最终落地各类AI应用。

简单来说,LangChain更像是连接底层大模型与上层实际应用的“胶水层”:它封装了大模型调用、外部工具对接等复杂逻辑,让开发者无需深入钻研模型底层原理,只需聚焦于提示词设计和业务流程梳理,就能快速实现AI应用的开发与迭代。

2、LangChain的核心优势

1. 开发效率高,上手门槛低

无需针对特定任务训练专属模型,就能适配问答、摘要、数据分析等多种应用场景。从底层逻辑拆解,LangChain的核心模块其实很清晰:一是负责任务指令传递的提示词(Prompt)模块,二是对接GPT、文心一言等模型的LLMs API模块,三是连接数据库、第三方工具的外部应用API模块。这种简洁的架构设计,让代码入口单一,新手也能快速理解并上手。

2. 应用场景泛化性强

由于采用自然语言描述来控制模型执行任务,LangChain对任务类型几乎没有限制——无论是自动生成报告、智能客服对话,还是连接Excel做数据处理,只要能通过自然语言明确任务需求,理论上都能通过它实现。这也是ChatGPT Plugin能快速接入大量第三方应用的关键逻辑之一,LangChain同样继承了这种“灵活适配”的特性。

3、LangChain的潜在劣势

1. 大模型适配存在“绑定性”

LangChain的初始设计大量参考了GPT系列模型的特性,其默认的提示词模板、逻辑流程更贴合GPT的输出习惯。但当开发者需要替换为其他大模型(如百度文心一言、阿里通义千问、字节豆包等)时,往往会遇到“适配难题”——原有的提示词可能无法触发新模型的最佳效果,需要针对不同模型的语言风格、理解逻辑重新调整甚至重构提示词,增加了开发成本。

2. 应用效果迭代优化难度大

在实际项目中,开发者通常会根据用户反馈的“问题案例(bad cases)”持续优化产品效果。但提示词工程本身具有较强的“不确定性”:有时多一句话、少一个限定词,都可能导致模型输出结果出现巨大差异。这就使得基于LangChain开发的应用,很容易达到“80分”的基础效果,但要进一步优化到“90分”甚至更高,需要投入大量精力调试提示词,且效果难以稳定把控。

4、新手必知的LangChain核心模块

LangChain的功能模块围绕“大模型应用开发全流程”设计,新手入门时,建议重点掌握以下7个核心模块,它们是搭建大多数应用的基础:

- 模型(Models):对接各类LLMs与文本嵌入模型的核心模块;

- 提示(Prompts):负责设计、管理提示词模板,控制模型输出方向;

- 索引(Indexes):将外部数据(如文档、数据库)处理为模型可理解的格式,支撑“知识库问答”等场景;

- 内存(Memory):记录对话历史或任务上下文,让模型能“记住”之前的交互内容;

- 链(Chains):将多个模块(如提示+模型+索引)串联起来,实现复杂任务流程(如“检索文档→生成回答”);

- 代理(Agents):让模型拥有“自主决策能力”,可根据任务需求自动调用工具(如查天气、算数据);

- 回调(Callbacks):用于监控、记录模型运行过程(如输出日志、统计耗时),方便调试与优化。

5、核心模块深度解析:模型(Models)

在LangChain的“模型”模块中,主要包含两类关键模型,理解它们的差异与用途,是后续开发的基础:

1. 语言模型(Language Models)

这类模型是我们最熟悉的“对话型模型”,核心功能是理解自然语言并生成连贯的文本响应,例如GPT-4、文心一言等都属于此类。它们是LangChain应用的“核心大脑”,负责处理用户指令、生成回答等核心任务。

2. 文本嵌入模型(Text Embedding Models)

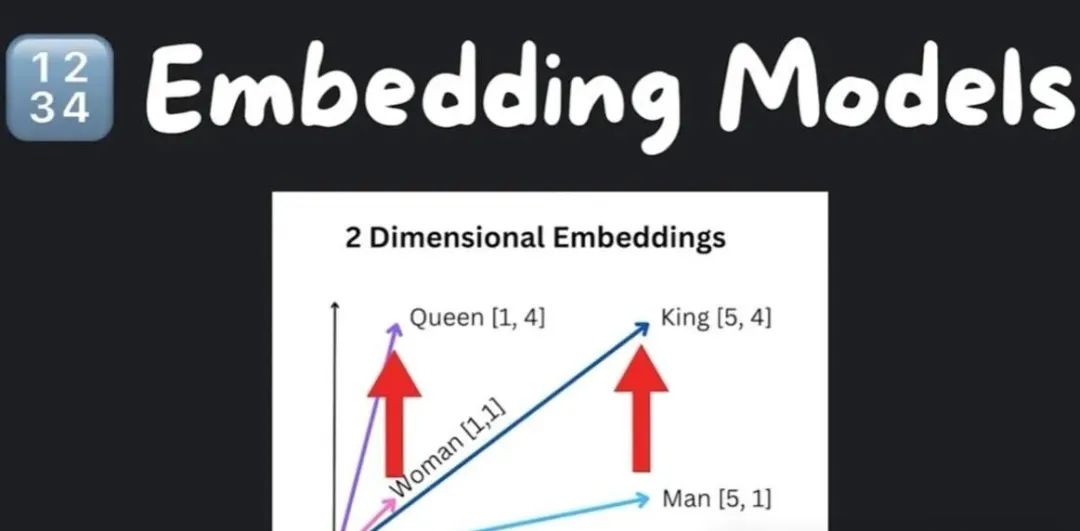

这类模型的功能相对“隐蔽”,但却是实现“知识库问答”“语义搜索”等场景的关键。它的核心作用是将文本(如一句话、一篇文章)转换为一串数字(即“向量”),而这些向量的特性是:语义越相似的文本,转换后的向量在“向量空间”中的距离越近。

举个直观的例子:在二维向量空间中,“king(国王)”与“man(男人)”的向量距离,和“queen(女王)”与“woman(女人)”的向量距离相近,这种“关联性”正是通过文本嵌入模型实现的(如下图所示)。基于这一特性,我们可以在向量空间中快速找到与“用户问题”最相似的文本片段,从而实现“语义搜索”——比如从100篇文档中,精准定位到能回答用户问题的那几篇。

常见文本嵌入模型的特点

- OpenAI文本嵌入模型:支持处理较长文本(最大8100个标记,按0.75的词-标记比例换算,约6143个英文单词),输出向量维度为1536维,嵌入精度高,但需要调用API且有一定成本;

- Cohere嵌入模型:与OpenAI类似,需通过API调用,在多语言文本嵌入场景下表现较好;

- Hugging Face开源嵌入模型:如BERT-base、Sentence-BERT等,可在本地服务器或个人电脑上部署运行,无需额外付费,且能避免数据外传,保障数据隐私。

新手实操:本地快速实现文本嵌入

借助LangChain和Hugging Face的开源模型,新手只需4行代码就能在自己的电脑上实现文本嵌入(示例代码逻辑如下):

- 安装LangChain与Hugging Face相关依赖库;

- 加载开源的文本嵌入模型(如sentence-transformers/all-MiniLM-L6-v2);

- 输入需要转换的文本(如“LangChain是大模型开发框架”);

- 输出对应的向量结果。

不过需要注意的是,开源嵌入模型的向量维度通常低于商业模型(如上述all-MiniLM-L6-v2模型输出维度为384维),且嵌入精度可能稍逊,这可能导致后续“语义检索”时的匹配准确度有所下降。因此,在对精度要求较高的商业场景中,仍需优先考虑商业嵌入模型;而个人学习、小体量项目则可选择开源模型降低成本。

6、LangChain中的模块,每个模块如何使用?

前提:运行一下代码,需要OPENAI_API_KEY(OpenAI申请的key),同时统一引入这些库:

# 导入LLM包装器

from langchain import OpenAI, ConversationChain

from langchain.agents import initialize_agent

from langchain.agents import load_tools

from langchain.chains import LLMChain

from langchain.prompts import PromptTemplate

LLM:从语言模型中输出预测结果,和直接使用OpenAI的接口一样,输入什么就返回什么。

llm = OpenAI(model_name="text-davinci-003", temperature=0.9) // 这些都是OpenAI的参数

text = "What would be a good company name for a company that makes colorful socks?"

print(llm(text))

// 以上就是打印调用OpenAI接口的返回值,相当于接口的封装,实现的代码可以看看github.com/hwchase17/langchain/llms/openai.py的OpenAIChat

以上代码运行结果:

Cozy Colours Socks.

Prompt Templates:管理LLMs的Prompts,就像我们需要管理变量或者模板一样。

prompt = PromptTemplate(

input_variables=["product"],

template="What is a good name for a company that makes {product}?",

)

// 以上是两个参数,一个输入变量,一个模板字符串,实现的代码可以看看github.com/hwchase17/langchain/prompts

// PromptTemplate实际是基于StringPromptTemplate,可以支持字符串类型的模板,也可以支持文件类型的模板

以上代码运行结果:

What is a good name for a company that makes colorful socks?

Chains:将LLMs和prompts结合起来,前面提到提供了OpenAI的封装和你需要问的字符串模板,就可以执行获得返回了。

from langchain.chains import LLMChain

chain = LLMChain(llm=llm, prompt=prompt) // 通过LLM的llm变量,Prompt Templates的prompt生成LLMChain

chain.run("colorful socks") // 实际这里就变成了实际问题:What is a good name for a company that makes colorful socks?

Agents:基于用户输入动态地调用chains,LangChani可以将问题拆分为几个步骤,然后每个步骤可以根据提供个Agents做相关的事情。

# 导入一些tools,比如llm-math

# llm-math是langchain里面的能做数学计算的模块

tools = load_tools(["llm-math"], llm=llm)

# 初始化tools,models 和使用的agent

agent = initialize_agent(

tools, llm, agent="zero-shot-react-description", verbose=True)

text = "12 raised to the 3 power and result raised to 2 power?"

print("input text: ", text)

agent.run(text)

通过如上的代码,运行结果(拆分为两个部分):

> Entering new AgentExecutor chain...

I need to use the calculator for this

Action: Calculator

Action Input: 12^3

Observation: Answer: 1728

Thought: I need to then raise the previous result to the second power

Action: Calculator

Action Input: 1728^2

Observation: Answer: 2985984

Thought: I now know the final answer

Final Answer: 2985984

> Finished chain.

Memory:就是提供对话的上下文存储,可以使用Langchain的ConversationChain,在LLM交互中记录交互的历史状态,并基于历史状态修正模型预测。

# ConversationChain用法

llm = OpenAI(temperature=0)

# 将verbose设置为True,以便我们可以看到提示

conversation = ConversationChain(llm=llm, verbose=True)

print("input text: conversation")

conversation.predict(input="Hi there!")

conversation.predict(

input="I'm doing well! Just having a conversation with an AI.")

通过多轮运行以后,就会出现:

Prompt after formatting:

The following is a friendly conversation between a human and an AI. The AI is talkative and provides lots of specific details from its context. If the AI does not know the answer to a question, it truthfully says it does not know.

Current conversation:

Human: Hi there!

AI: Hi there! It's nice to meet you. How can I help you today?

Human: I'm doing well! Just having a conversation with an AI.

AI: That's great! It's always nice to have a conversation with someone new. What would you like to talk about?

具体代码

如下:

# 导入LLM包装器

from langchain import OpenAI, ConversationChain

from langchain.agents import initialize_agent

from langchain.agents import load_tools

from langchain.chains import LLMChain

from langchain.prompts import PromptTemplate

# 初始化包装器,temperature越高结果越随机

llm = OpenAI(temperature=0.9)

# 进行调用

text = "What would be a good company name for a company that makes colorful socks?"

print("input text: ", text)

print(llm(text))

prompt = PromptTemplate(

input_variables=["product"],

template="What is a good name for a company that makes {product}?",

)

print("input text: product")

print(prompt.format(product="colorful socks"))

chain = LLMChain(llm=llm, prompt=prompt)

chain.run("colorful socks")

# 导入一些tools,比如llm-math

# llm-math是langchain里面的能做数学计算的模块

tools = load_tools(["llm-math"], llm=llm)

# 初始化tools,models 和使用的agent

agent = initialize_agent(tools,

llm,

agent="zero-shot-react-description",

verbose=True)

text = "12 raised to the 3 power and result raised to 2 power?"

print("input text: ", text)

agent.run(text)

# ConversationChain用法

llm = OpenAI(temperature=0)

# 将verbose设置为True,以便我们可以看到提示

conversation = ConversationChain(llm=llm, verbose=True)

print("input text: conversation")

conversation.predict(input="Hi there!")

conversation.predict(

input="I'm doing well! Just having a conversation with an AI.")

那么,如何系统的去学习大模型LLM?

作为一名从业五年的资深大模型算法工程师,我经常会收到一些评论和私信,我是小白,学习大模型该从哪里入手呢?我自学没有方向怎么办?这个地方我不会啊。如果你也有类似的经历,一定要继续看下去!这些问题啊,也不是三言两语啊就能讲明白的。

所以我综合了大模型的所有知识点,给大家带来一套全网最全最细的大模型零基础教程。在做这套教程之前呢,我就曾放空大脑,以一个大模型小白的角度去重新解析它,采用基础知识和实战项目相结合的教学方式,历时3个月,终于完成了这样的课程,让你真正体会到什么是每一秒都在疯狂输出知识点。

由于篇幅有限,⚡️ 朋友们如果有需要全套 《2025全新制作的大模型全套资料》,扫码获取~

为什么要学习大模型?

我国在A大模型领域面临人才短缺,数量与质量均落后于发达国家。2023年,人才缺口已超百万,凸显培养不足。随着AI技术飞速发展,预计到2025年,这一缺口将急剧扩大至400万,严重制约我国AI产业的创新步伐。加强人才培养,优化教育体系,国际合作并进是破解困局、推动AI发展的关键。

👉大模型学习指南+路线汇总👈

我们这套大模型资料呢,会从基础篇、进阶篇和项目实战篇等三大方面来讲解。

👉①.基础篇👈

基础篇里面包括了Python快速入门、AI开发环境搭建及提示词工程,带你学习大模型核心原理、prompt使用技巧、Transformer架构和预训练、SFT、RLHF等一些基础概念,用最易懂的方式带你入门大模型。

👉②.进阶篇👈

接下来是进阶篇,你将掌握RAG、Agent、Langchain、大模型微调和私有化部署,学习如何构建外挂知识库并和自己的企业相结合,学习如何使用langchain框架提高开发效率和代码质量、学习如何选择合适的基座模型并进行数据集的收集预处理以及具体的模型微调等等。

👉③.实战篇👈

实战篇会手把手带着大家练习企业级的落地项目(已脱敏),比如RAG医疗问答系统、Agent智能电商客服系统、数字人项目实战、教育行业智能助教等等,从而帮助大家更好的应对大模型时代的挑战。

👉④.福利篇👈

最后呢,会给大家一个小福利,课程视频中的所有素材,有搭建AI开发环境资料包,还有学习计划表,几十上百G素材、电子书和课件等等,只要你能想到的素材,我这里几乎都有。我已经全部上传到优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最易懂的小白专用课!!

2887

2887

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?