1简介

随着人工智能技术的飞速发展,大语言模型(Large Language Models, LLMs)逐渐从云端走向本地,为开发者、研究者和技术爱好者提供了更灵活、更私密的应用可能。国产DeepSeek 作为一款高效且功能强大的开源大模型,凭借其毫不逊色于Chatgpt的推理能力和对中文场景的深度适配,成为许多用户探索本地智能化的首选工具。

然而,对于非专业开发者或刚接触本地部署的用户而言,复杂的配置流程、环境依赖和资源管理往往令人望而却步。本文旨在通过极简的步骤、清晰的说明和实用的技巧,帮助小白用户在最短时间内完成从零部署的流程。

2环境介绍

windows:win11

3安装ollama

Ollama 是一个提供开源、简便且高效的工具平台,旨在使开发者能够在本地环境中运行和部署大型语言模型(LLMs)。Ollama 可以让用户轻松地运行一些主流的、开源的 LLM 模型,而无需依赖云服务,支持在本地服务器或个人计算机上进行推理任务。因此我们deepseek的载体就是ollama。

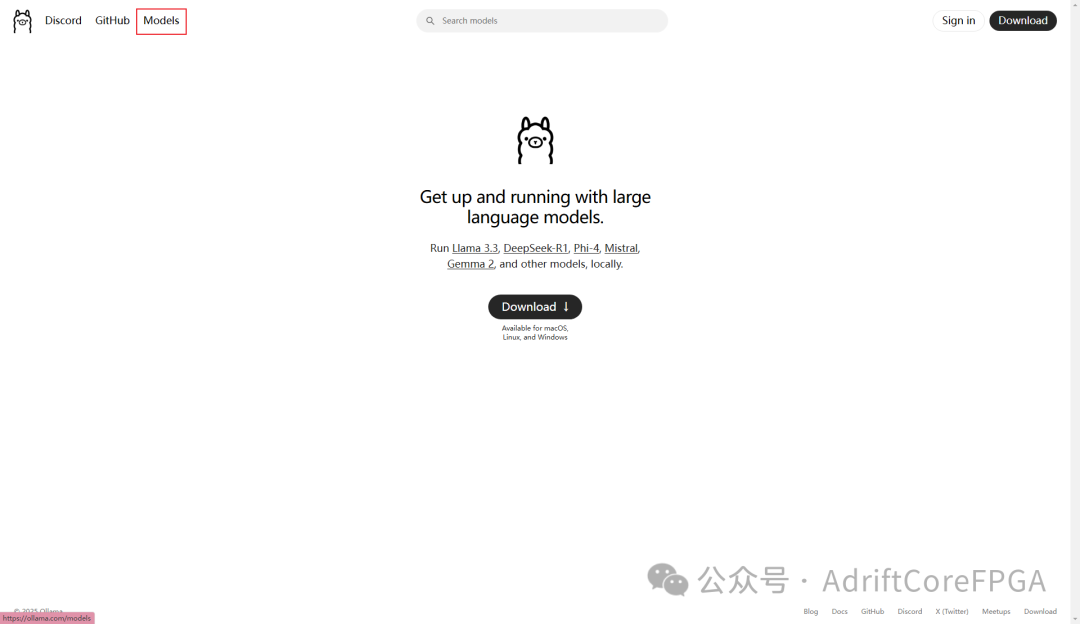

在官网下载ollama(安装包也可在本文附录A获取)

https://ollama.com/

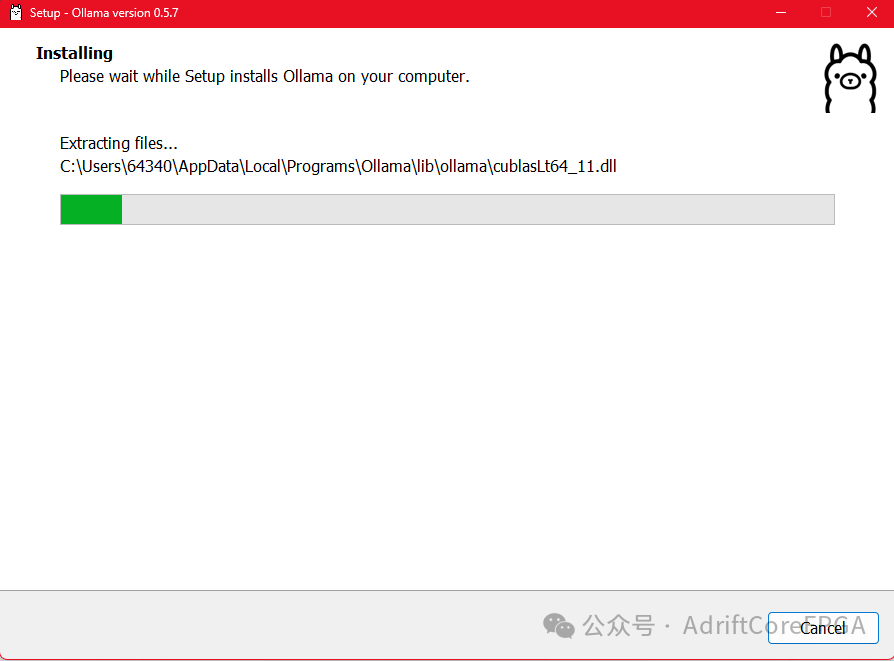

安装ollama

4安装deepseek模型

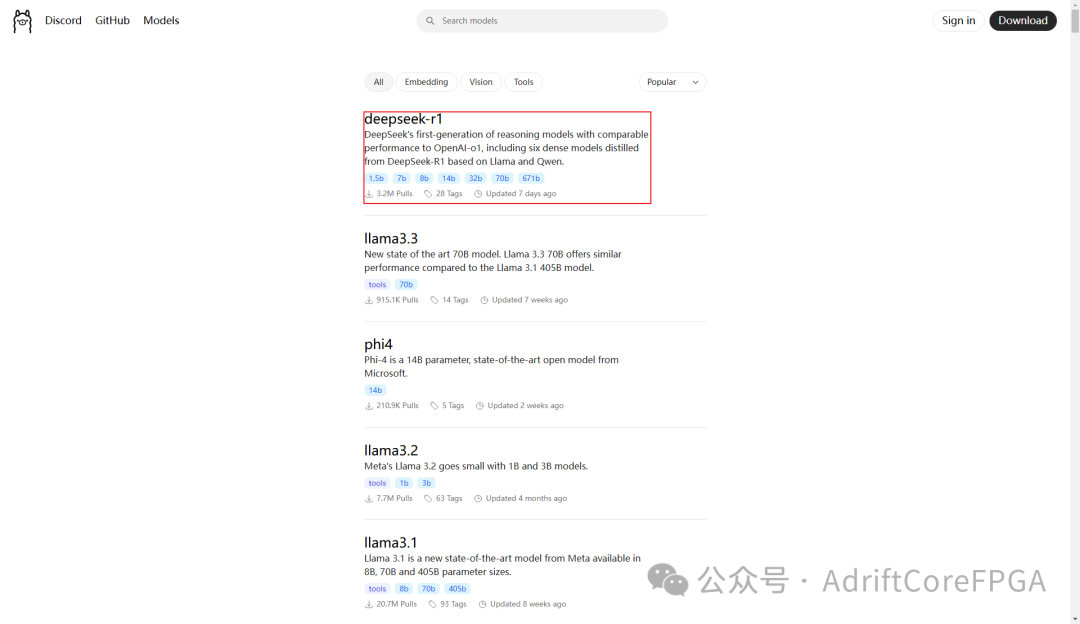

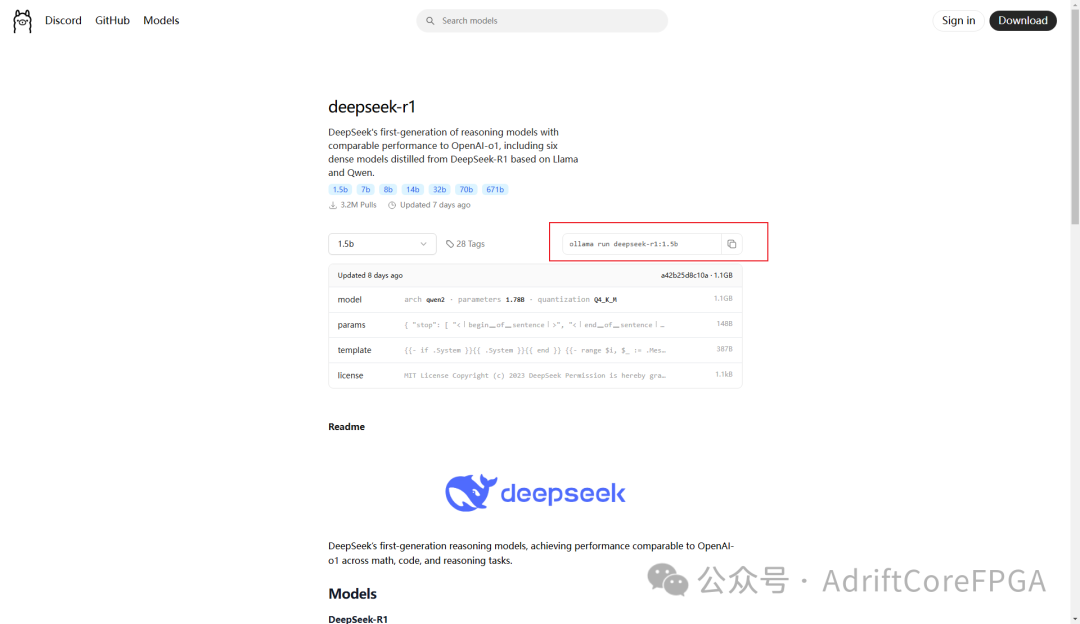

打开ollama官网,右上角models找到deepseek模型

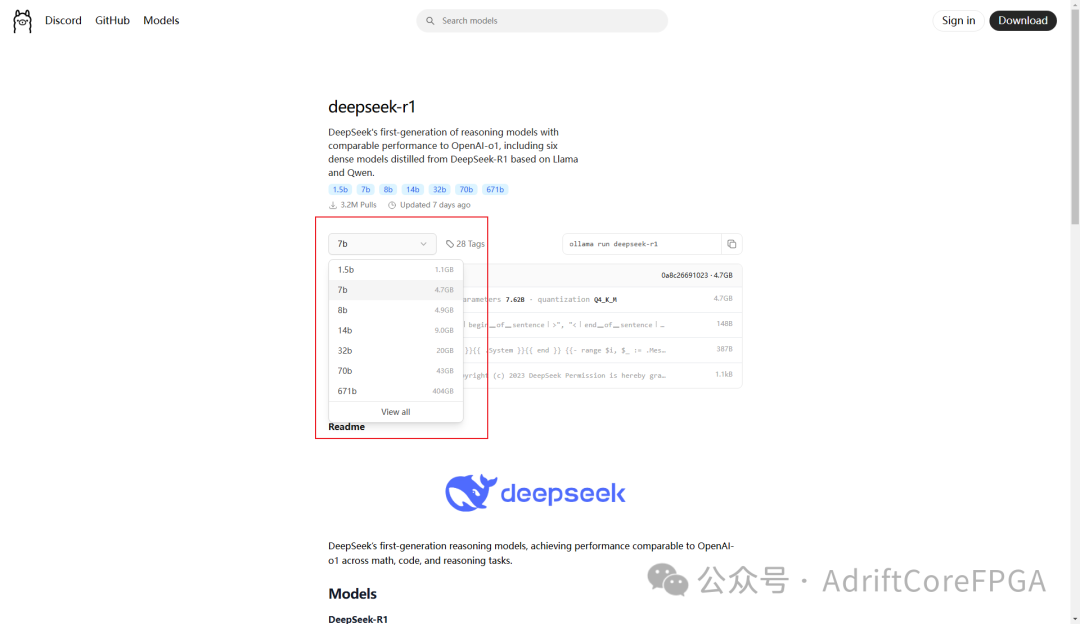

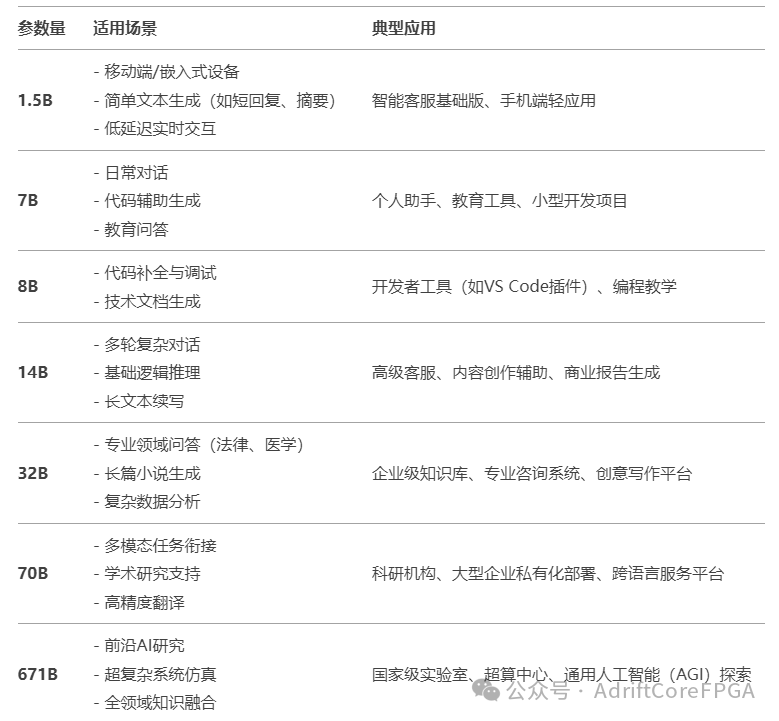

选择模型版本,在人工智能领域,模型名称中的 1.5B、7B、8B 等数字代表模型的参数量(Parameters),其中 B 是英文 Billion(十亿) 的缩写。参数越多,模型通常更“聪明”(能处理更复杂的任务),但对硬件资源(显存、内存)的要求也更高。个人用户可优先 7B(通用性最佳),若设备较弱则选 1.5B,开发者可选 8B。

以下是各版本的介绍

找到对应的命令,复制

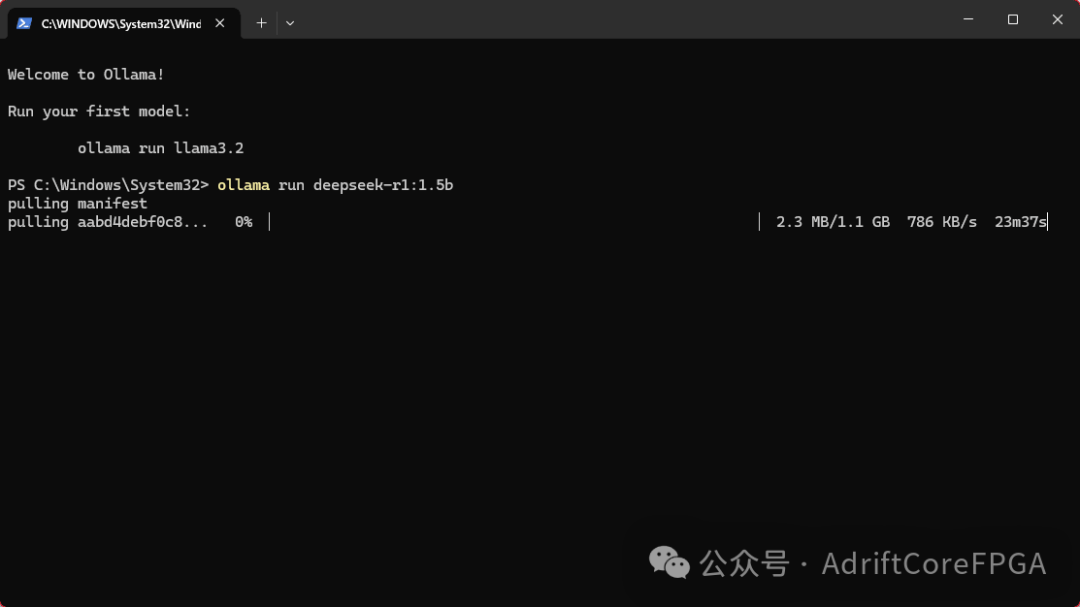

然后输入到cmd中:

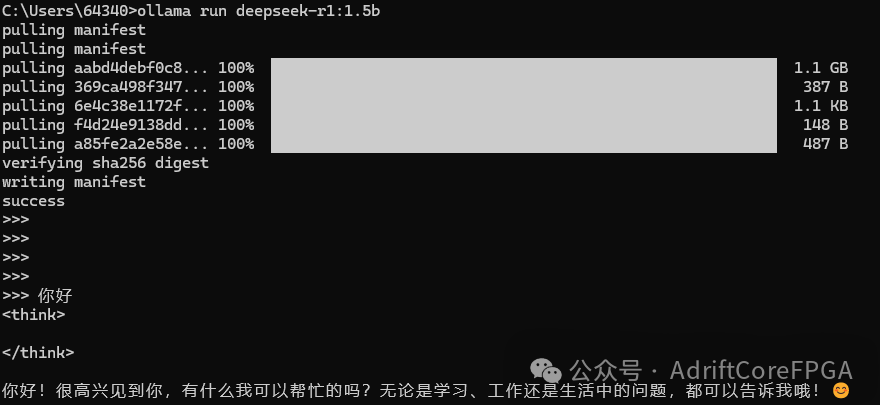

ollama run deepseek-r1:1.5b

如果是7b,以此类推:

ollama run deepseek-r1:7b

需要等待一段时间下载

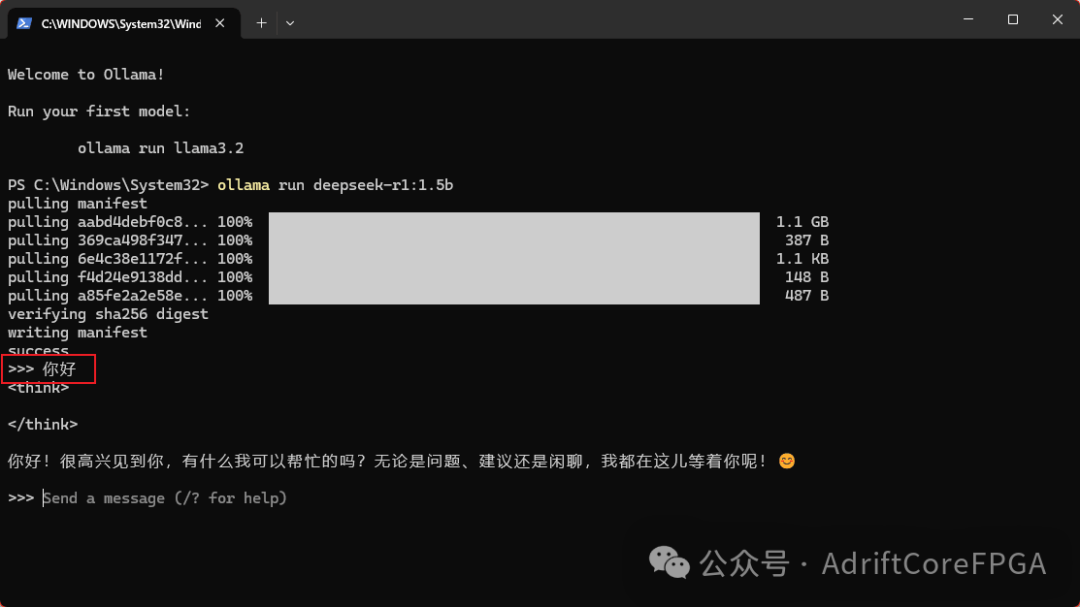

5使用deepseek

打开cmd,输入所下版本同样的命令,则可以使用deepseek:

ollama run deepseek-r1:1.5b

6ollama大模型安装路径更改

如果我们使用windows系统安装,ollama默认安装在系统盘,而往往系统盘的容量不够大,我们可以将deepseek安装到其他盘中,但目前,ollama 本身并没有提供直接的、官方的选项来修改模型存储路径。我们可以使用符号链接的方式将对应文件夹链接到D盘文件夹,这样ollama读写文件只会读写对应D盘的链接文件夹。

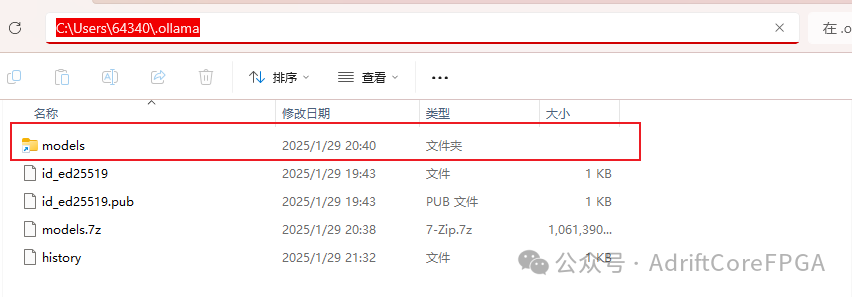

首先,我们找到ollama模型的安装位置:

Linux/macOS:` `~/.ollama/``Windows:` `C:\Users\<YourUser>\.ollama\

删除models文件夹:

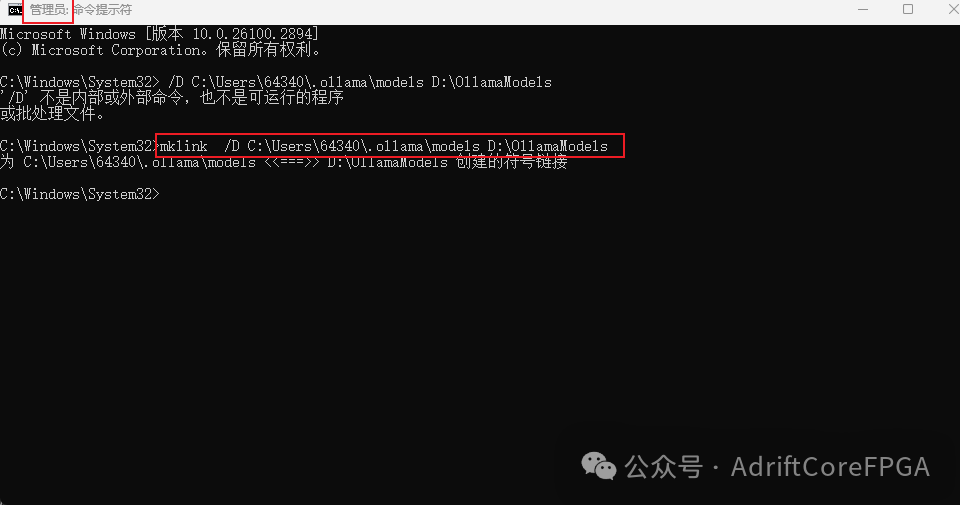

在D盘创建一个新文件夹,如

D:\OllamaModels\

用管理员打开cmd,进行符号链接,然后再下载deepseek文件夹:

mklink /D C:\Users\<YourUser>\.ollama D:\OllamaModels

7写在最后

本文主要介绍了 DeepSeek 的最简安装方法,后续将继续更新,介绍如何将 DeepSeek 集成到图形化界面中。

👉👉【DeepSeek本地部署文档】

https://pan.quark.cn/s/7e0fa45596e4

最近,我的DeepSeek本地部署视频在B站播放量意外小爆,评论区被两类留言淹没:一类是技术爱好者追问“如何用消费级显卡跑通大模型”,另一类是职场人焦虑“我的工作会被AI取代吗?”这两个问题的背后,折射出一个残酷的真相:大模型技术正在重构所有行业的生存法则,而掌握这项技术的人将获得通往未来的船票。

DeepSeek的火爆对普通人意味着什么?

DeepSeek的火爆并非偶然。它代表了一种技术趋势:大模型技术正在从实验室走向大众。过去,大模型技术似乎只属于科技巨头和学术机构,普通人很难接触到。而现在,随着开源社区的活跃和技术的普及,像DeepSeek这样的工具已经可以让普通用户在自己的设备上部署和使用大模型。

对于普通人来说,DeepSeek的火爆意味着:

- 技术门槛降低:大模型技术不再遥不可及。通过本地部署,普通人也可以体验到强大的AI能力,无论是文本生成、对话系统还是其他AI应用。

- 个性化需求得到满足:大模型可以根据用户的需求进行定制化调整,满足个性化的应用场景。比如,你可以训练一个专门用于写作、编程或翻译的模型。

- 未来职业机会:大模型技术的普及将催生大量新的职业机会。无论是AI工程师、数据科学家,还是AI产品经理,掌握大模型技术将成为未来职场的重要竞争力。

DeepSeek的底层逻辑:大模型技术的核心

DeepSeek的底层逻辑正是基于大模型技术。大模型,顾名思义,是指参数量巨大、训练数据丰富的深度学习模型。这类模型通过海量数据的训练,能够捕捉到复杂的语言模式和知识结构,从而在各种任务中表现出色。

一、大模型岗位薪资揭密:应届生年薪40万起,跨界人才溢价300%

根据智联招聘《2024人工智能人才发展报告》,大模型相关岗位薪资较传统IT岗位平均高出67%,且呈现三大特征:

1.应届生起薪碾压传统行业

大模型算法工程师:本科28-40万/年,硕士40-60万/年

AI产品经理(无经验):25-35万/年

(数据来源:猎聘2024校招季统计)

2.跨界人才溢价惊人

医疗+大模型复合人才:薪资较纯医疗背景提升200-300%

金融风控+大模型工程师:年薪可达80-150万

(案例:某三甲医院影像科医生转型AI医疗,薪资从25万跃升至75万)

3.中小企业重金抢人

二线城市AI初创公司开出“北上广深同薪”政策

某成都电商企业为AI推荐算法工程师开出百万年薪

二、行业大地震:这些岗位正在消失,这些岗位正在爆发

▍消失中的岗位(3年内高危职业)

- 基础数据标注员(已被AutoML取代90%工作量)

- 初级代码工程师(GPT-4可完成60%基础代码)

▍爆发中的黄金岗位

1.大模型训练师

- 某直播公司开出82万年薪招聘“带货大模型调教师”

- 核心技能:Prompt工程+垂直领域知识(如美妆/3C)

2.AI业务流程重构师

- 制造业龙头企业50万年薪招聘“生产流程AI化专家”

- 典型案例:富士康通过大模型优化生产线,减少30%人力成本

3.AI伦理合规官

- 金融机构新增岗位“大模型风控总监”,年薪超百万

- 职责:防止AI在信贷审核、投资建议中出现歧视性输出

三、普通人破局指南:无需代码基础,三步抢占AI红利

我整理了全网稀缺的**《大模型落地应用实战资料包》**,包含:

1.LLM大模型学习大纲+路线图

2.152个大模型各行业结合的落地案例集

3.大模型必读书籍PDF电子版

4.大模型全套系统学习视频

5.真实大厂岗位面试题库

6.640套AI大模型行业白皮书

👉👉获取方式:

结语:你正在经历人类史上最大规模的生产力革命

当东莞工厂用大模型替代500个质检员,当律所AI助理处理80%合同审查,当小红书博主用AI生成90%的图文内容——这场变革不再关乎“是否会发生”,而是“你站在哪一边”。

记住两个数字:

- 2023年全球大模型应用市场规模:270亿美元

- 2027年预测市场规模:4070亿美元

这中间3700亿美元的增量市场,就是普通人改写命运的机会。4年后你会感谢今天的决定。

19万+

19万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?