在监督问题中,混淆矩阵可用作模型评估,一般常见于分类问题。

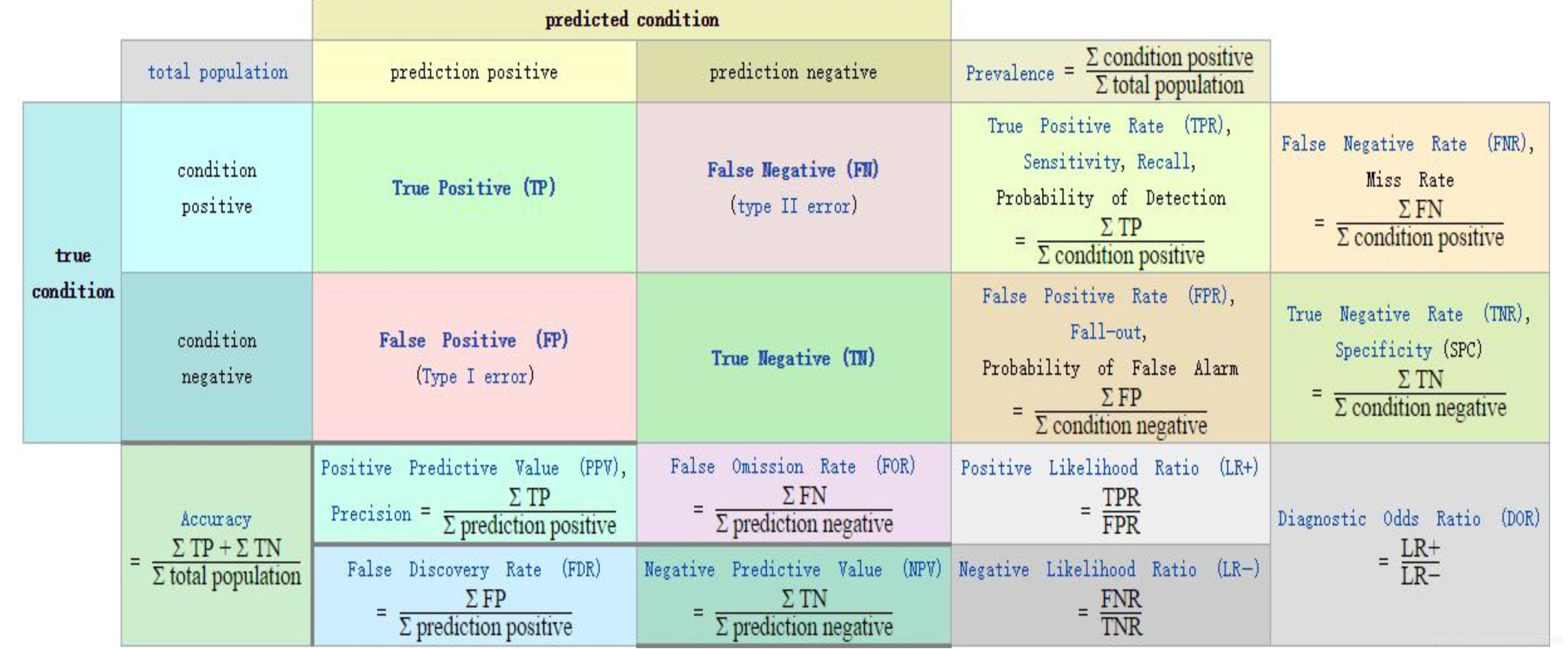

基本模型如图

横向代表真实值,纵向代表预测值。真正例指预测为正实际也为正的值,假负例是预测为负实际为正的值,假正例是预测为正实际为负的值,真负例指预测为负实际为负的值。

由此引出了模型效果评估的评价指标

准确率(Accuracy)=提取出的正确样本数/总样本数

召回率(Recall)=正确的正例样本数/样本中的正例样本数——覆盖率

精准率(Precision)=正确的正例样本数/预测为正例的样本数

F值=Precision*Recall*2 / (Precision+Recall) (即F值为正确率和召回率的调和平均值)

即

用的比较多的是准确率和召回率

ROC和AUC

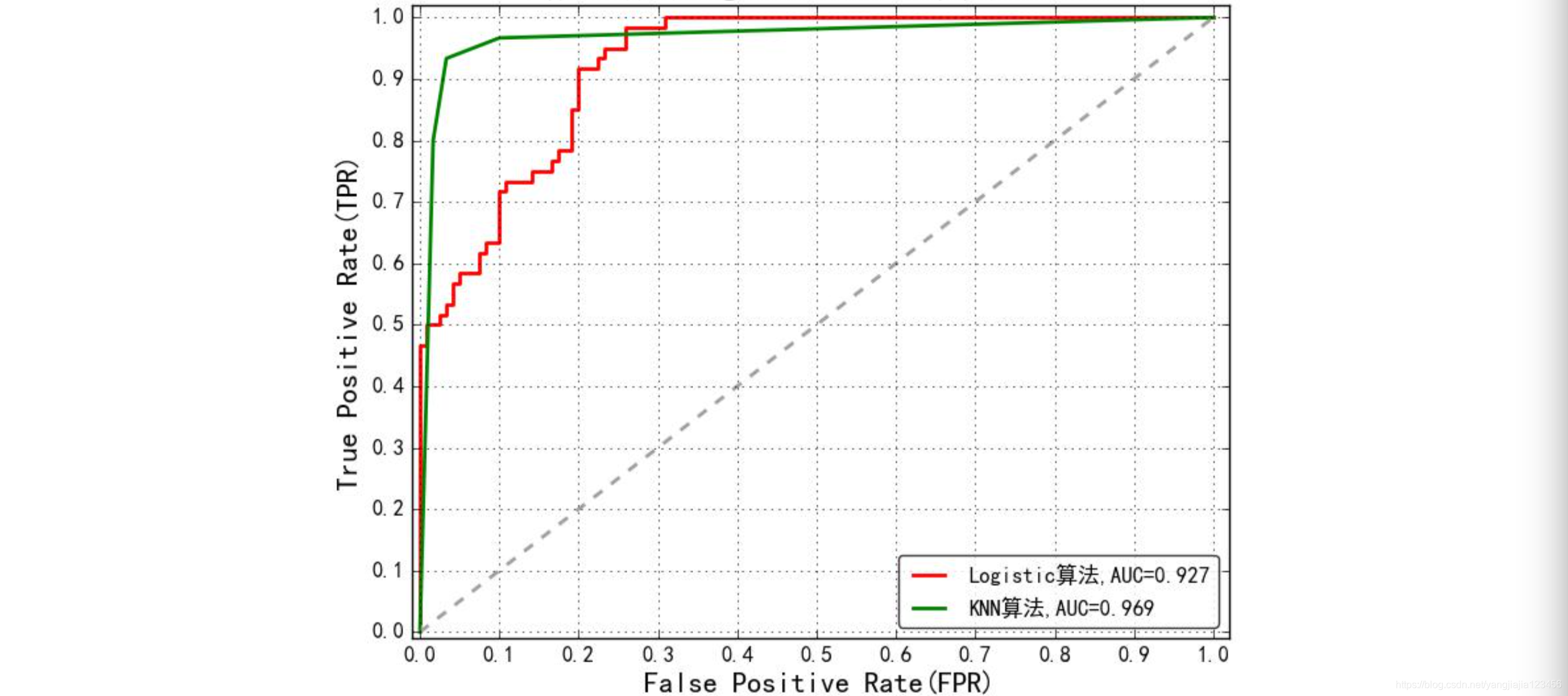

ROC(Receiver Operating Characteristic)最初源于20世纪70年代的信号检测理论,描述的是分类混淆矩阵中FPR-TPR两个量之间的相对变化情况,其纵轴是“真正例率”(TPR),横轴是“假正例率”(FPR)。

由图可知,当FPR越小,TPR越大时,模型效果越好,随着FPR的增加,TPR增加的越快,模型越好,反映了其在二分类问题描述的优势。

AUC(Area Under Curve)被定义为ROC曲线下的面积,由图知,该面积不会超过1.

简述下其计算方法:

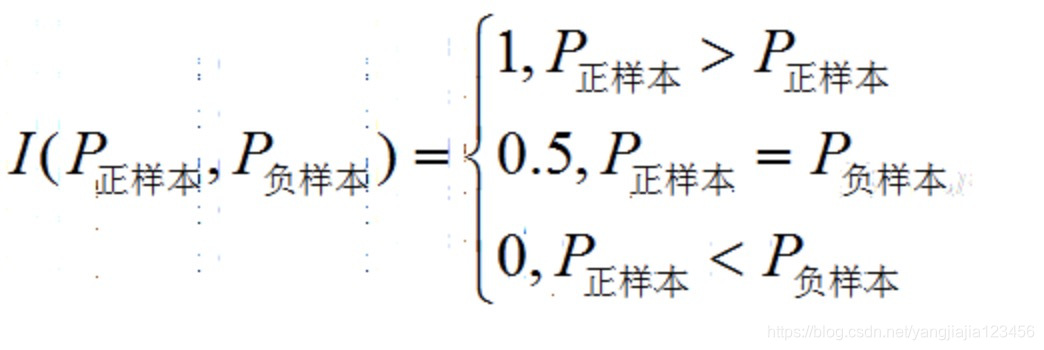

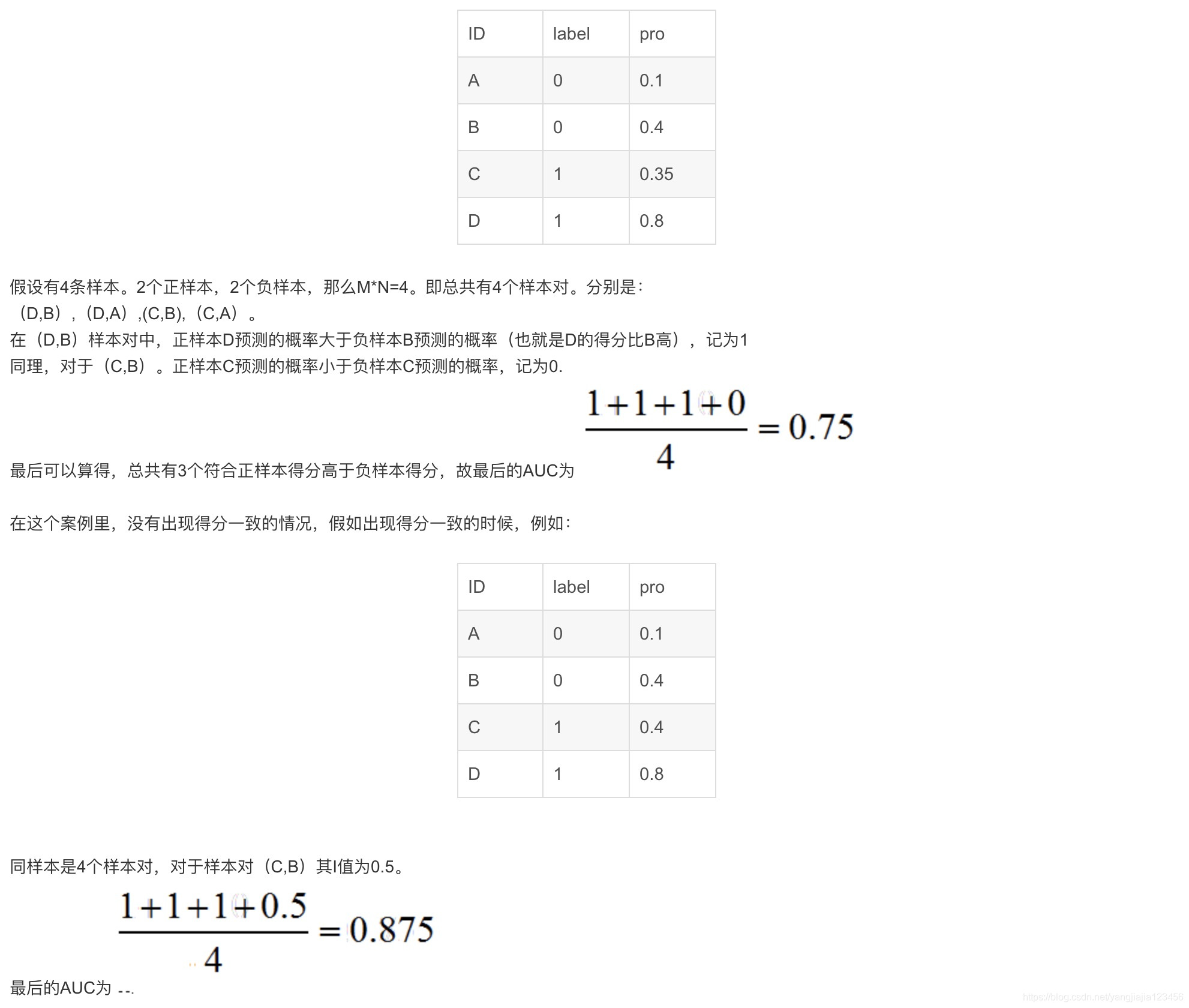

即在有M个正样本,N个负样本的数据集里。一共有M*N对样本(一对样本即,一个正样本与一个负样本)。统计这M*N对样本里,正样本的预测概率大于负样本的预测概率的个数。

例子如下

当AUC的值为1时,即为完美分类器;当0.5<AUC<1,即为优于随机猜想;当AUC<0.5,比随机猜想还差,需反其道而行之。

本文深入探讨了监督学习中模型评估的重要概念,包括混淆矩阵、准确率、召回率、精准率、F值等评价指标,以及ROC曲线和AUC值在二分类问题中的应用与解读。

本文深入探讨了监督学习中模型评估的重要概念,包括混淆矩阵、准确率、召回率、精准率、F值等评价指标,以及ROC曲线和AUC值在二分类问题中的应用与解读。

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?