分享一种非常简单的本地部署LLM的方法,免费,一台电脑,联网就行。

工具:deepseek + Ollama + Cherry Studio,开源大模型源代码+本地部署构建工具+个人助理构建

1、Download Ollama on Windows 下载ollma部署工具(我用的windows)

下载到本机,然后按照安装提示完成安装,安装完成后,在WIN+R打开命令行输入ollma命令,如果不报错,表示安装成功。

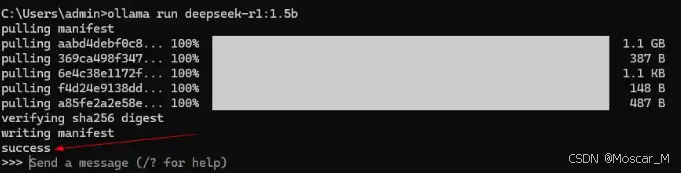

Ollama常用的指令就图中这几个,比如启动运行某个模型,就用:ollama run XXX(模型名称)即可。下载deepseek命令行如下,这些都在ollama官网可以直接复制过来到命令行。

比如:

如何退出deepseek命令行对话窗口呢

当我们run进入deepseek之后,在会话中命令提示符显示的是“Send a message”,如果要退出deepseek,可以直接输入 “/bye” 回车即可退出会话。

上图表示1.5b模型模型已经安装成功。在命令行就可以直接使用自然语言对话,但是,这样使用很难受,我们便可以使用一些本地模型使用管理软件,比如硅基流动的Cherry Studio。

Cherry Studio - 全能的AI助手 官网,直接下载即可

根据自己的需要简单设置,如下:

就完成了本地大模型的部署使用和管理。

卸载大模型的方法就比较简单

1、在文件夹直接卸载、2、在CMD命令行窗口使用ollama的rm命令卸载。

3848

3848

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?