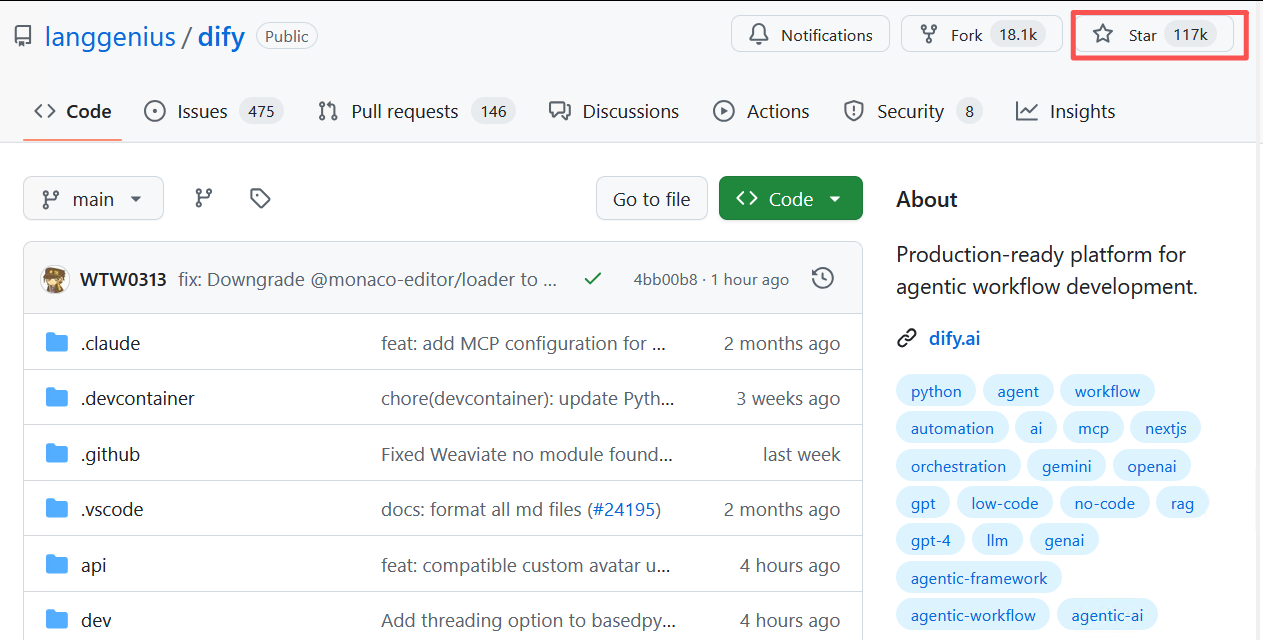

在大模型技术日益成熟的今天,如何将强大的语言模型能力转化为稳定、可维护、可扩展的生产级应用,已成为开发者和企业面临的核心挑战。正是在这一背景下,Dify 作为一款开源的 LLMOps(Large Language Model Operations)平台,迅速崛起并成为全球开发者社区的焦点。其GitHub仓库星标数已突破 117,000,不仅印证了其技术影响力,更标志着它正在重塑AI应用开发的范式。

一、技术架构解析:三层解耦,灵活可扩展

Dify采用模块化设计,整体架构分为三层,实现了清晰的职责分离:

1. 模型层(Model Abstraction Layer)

Dify支持多模型接入,包括:

- 商业API:OpenAI、Anthropic、Azure OpenAI、Google Gemini

- 开源模型:通过本地部署的vLLM、TGI(Text Generation Inference)或Ollama运行Llama 3、Qwen、ChatGLM等

- 国产模型:通义千问、百川、讯飞星火等

平台通过统一的模型适配器(Model Adapter) 抽象不同后端的接口差异,实现“一次配置,自由切换”,有效避免厂商锁定(Vendor Lock-in)。

2. 应用层(Application Orchestration Engine)

这是Dify的核心引擎,支持三种主要应用模式:

-

文本生成应用(Completion App)

提供可视化Prompt编辑器,支持变量注入(如{{input}})、上下文记忆(Conversation History)、输出格式定义(JSON Schema),适用于内容生成、翻译、摘要等场景。 -

聊天助手(Chatbot)

内置多轮对话管理机制,支持自定义开场白、语气设定、敏感词过滤,并可结合知识库实现精准问答。 -

智能体应用(Agent App)

基于ReAct框架,允许开发者定义工具集(Tools),如天气查询、数据库检索、代码执行等。Dify的Agent具备自主规划(Planning)与反思(Reflection)能力,能根据环境反馈调整策略。

3. 数据层(Knowledge & Storage Layer)

- 向量数据库集成:支持Weaviate、Milvus、PGVector等主流向量数据库,自动完成文档分块、嵌入(Embedding)与索引。

- RAG流程自动化:用户上传PDF、Word、TXT等文件后,Dify可自动构建知识库,并在推理时动态检索相关信息,显著提升回答准确性。

- 结构化数据支持:可通过插件连接MySQL、PostgreSQL等关系型数据库,实现自然语言到SQL的转换(Text-to-SQL)。

二、关键技术亮点

1. Workflow 编排引擎

Dify引入类似Airflow的DAG(有向无环图)工作流系统,允许将复杂逻辑分解为多个节点:

- LLM调用

- 条件判断(If/Else)

- 工具调用(Function Call)

- 数据处理

这种设计使得构建复杂的Agent或自动化流程变得直观且可维护。

2. 完整的可观测性(Observability)

Dify内置强大的调试与监控系统:

- 调用链追踪(Tracing):可查看每个节点的输入输出、Token消耗、延迟。

- 性能分析:统计每轮对话的prompt token与completion token,帮助优化成本。

- 日志审计:记录所有用户交互,满足合规需求。

3. OpenAPI 导出与SDK支持

所有应用均可一键导出为标准RESTful API,支持cURL、Python、JavaScript等多种调用方式。同时提供SDK,便于集成到现有系统中。

4. 私有化部署与安全性

Dify支持Docker、Kubernetes部署,可完全运行在企业内网环境中,保障数据隐私。支持OAuth 2.0、RBAC权限控制,适合企业级应用场景。

三、安装部署

环境准备:服务器先安装好docker

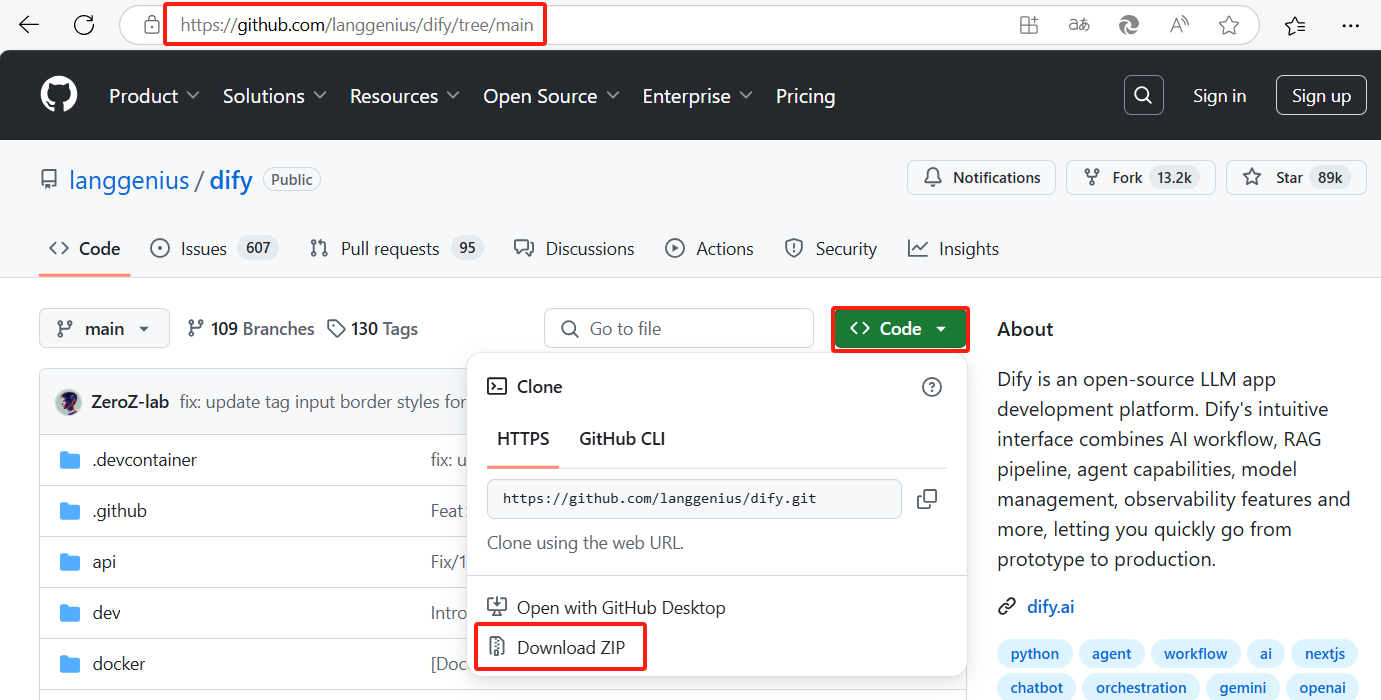

1、克隆 Dify 源代码至本地

# git clone https://github.com/langgenius/dify.git

或者直接下载后导入并解压

下载地址:https://github.com/langgenius/dify/tree/main

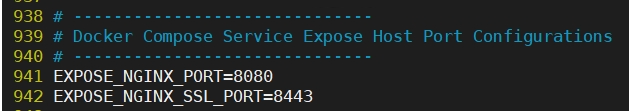

2、修改环境变量

# cd dify-main/docker

# cp .env.example .env

# vim .env (防止默认的80端口与已有服务冲突)

将EXPOSE_NGINX_PORT=80改成8080

将EXPOSE_NGINX_SSL_PORT=443改成8443

3、拉取并启动容器

# docker compose up -d

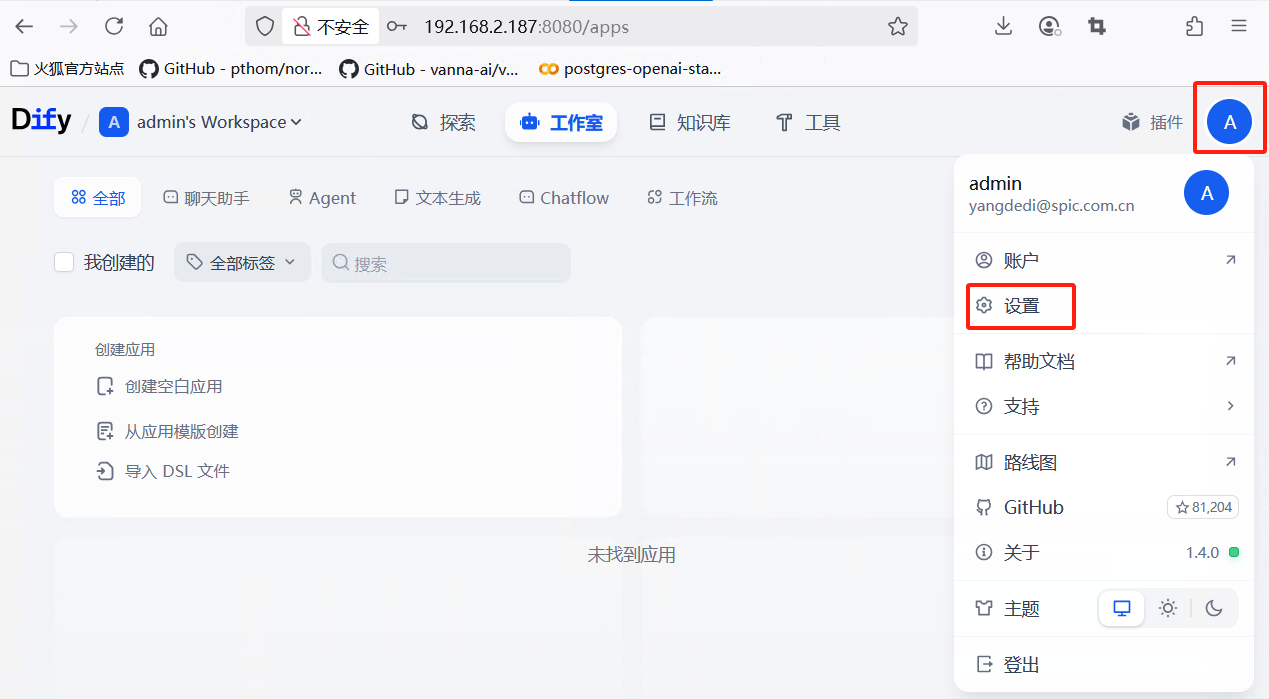

4、浏览器登陆服务器IP地址+端口访问:http://192.168.2.187:8080

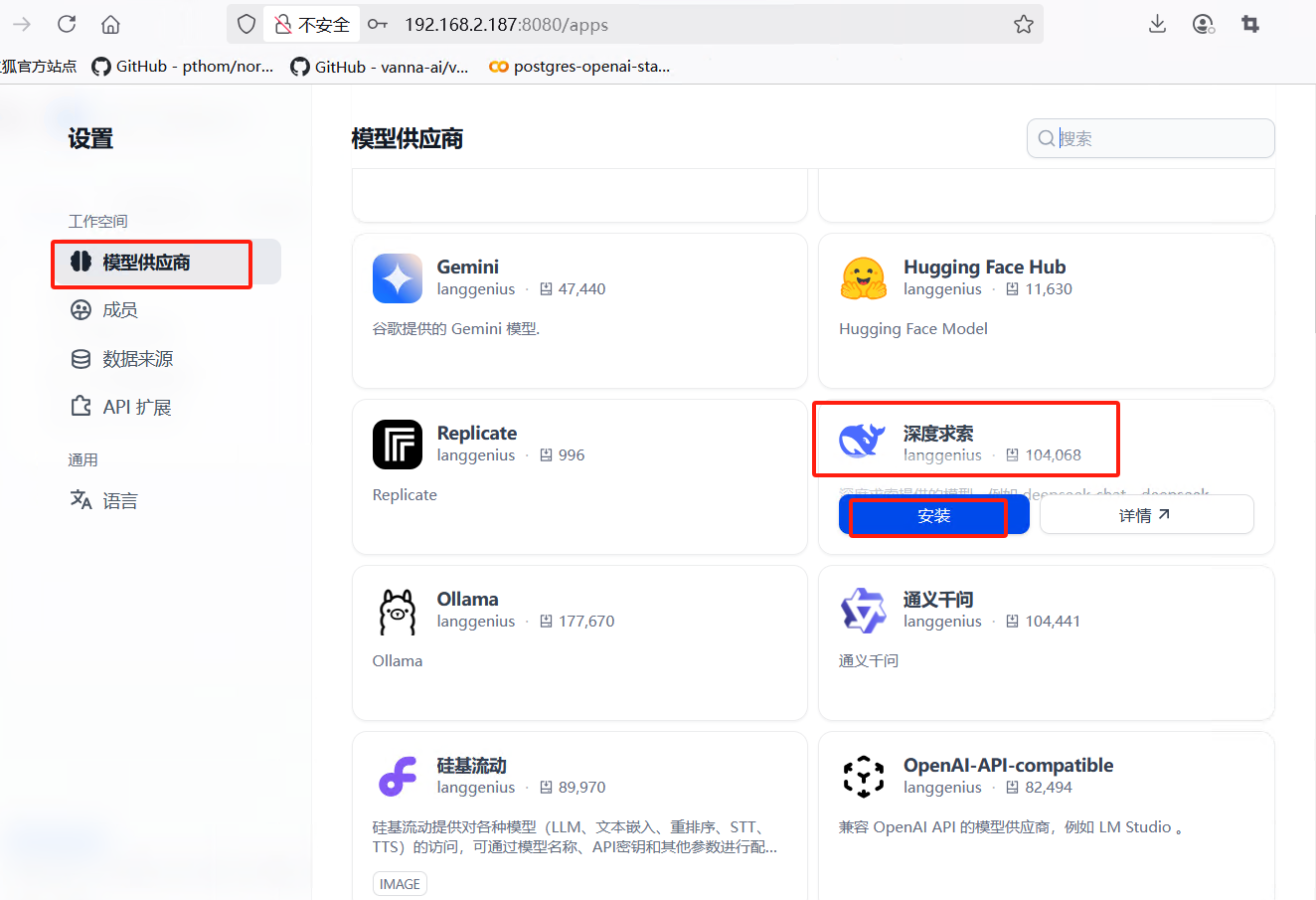

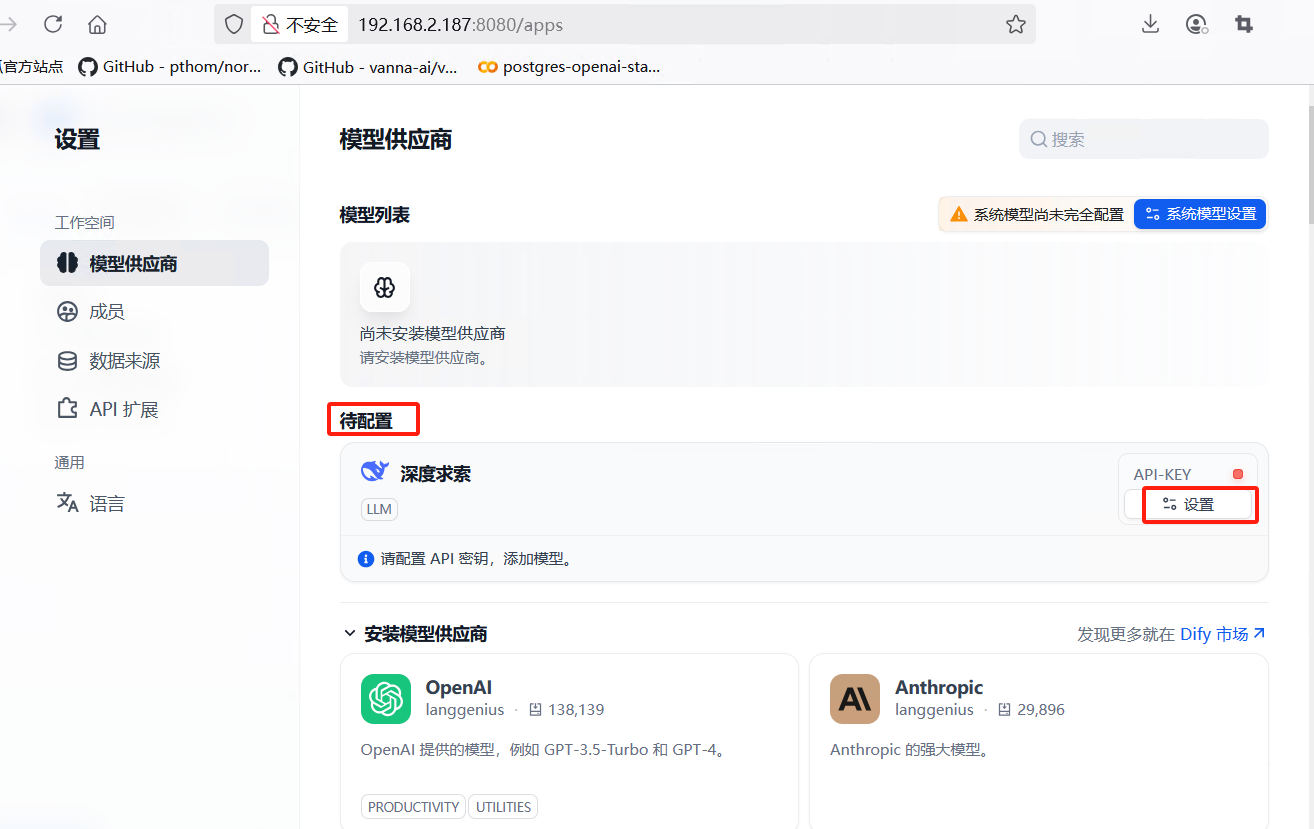

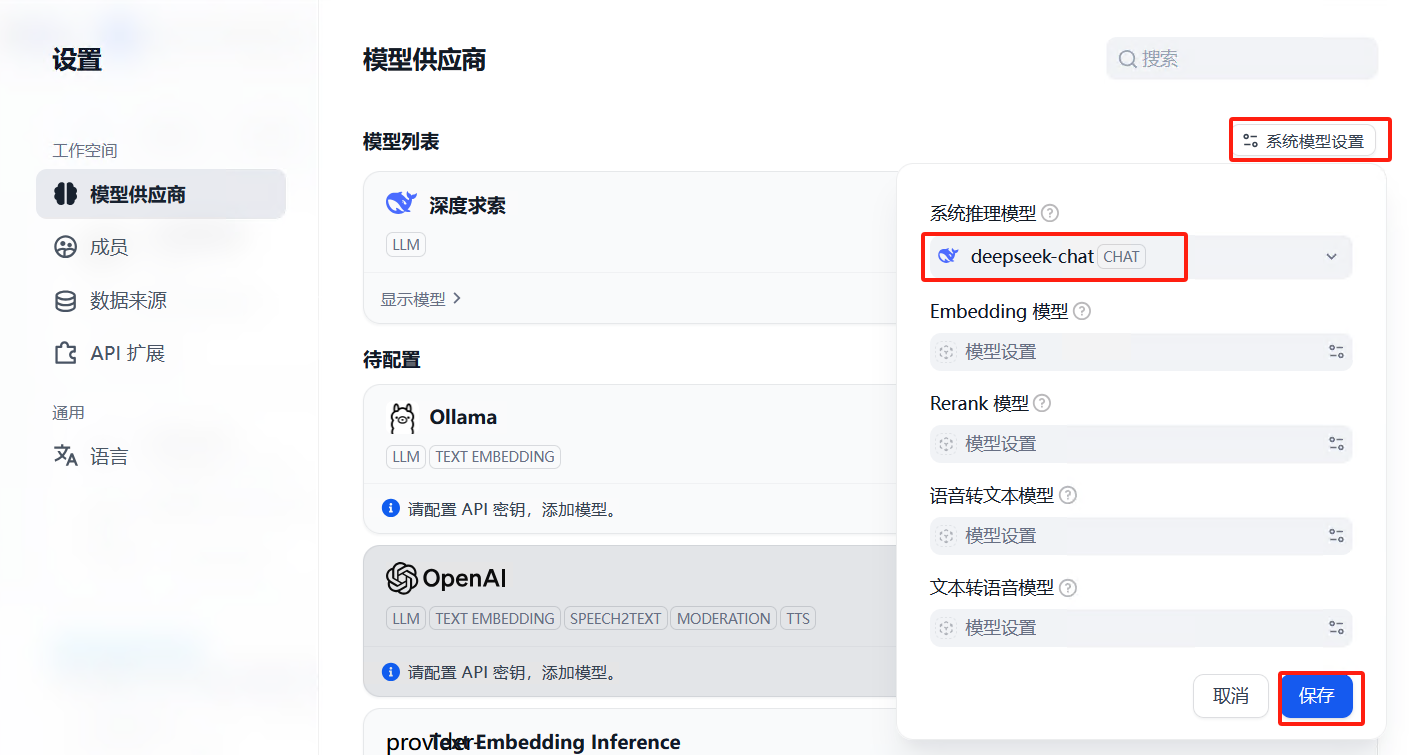

5、接入大模型

安装完模型供应商后,使用deepseek的api配置模型

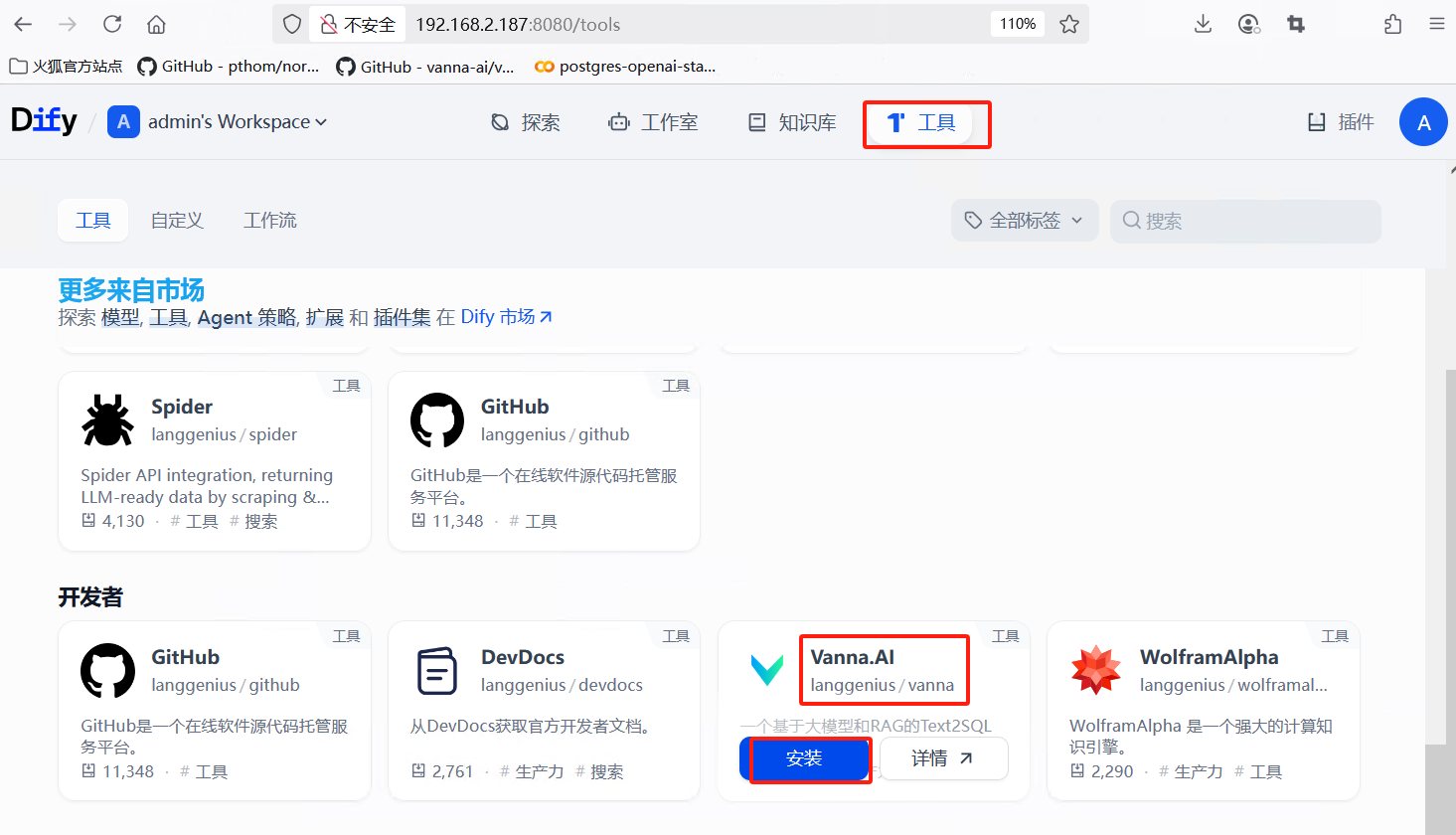

7、安装所需工具,如vanna

6458

6458

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?