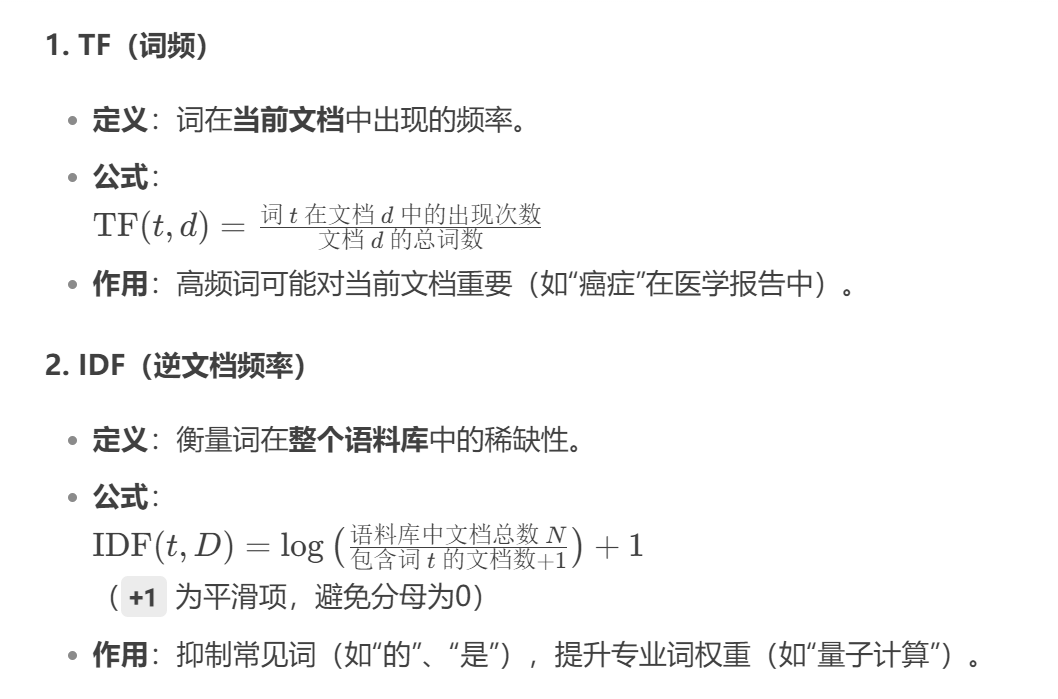

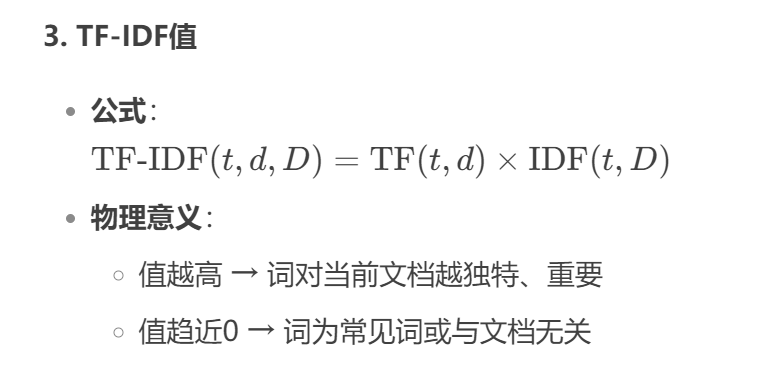

一、核心概念详解

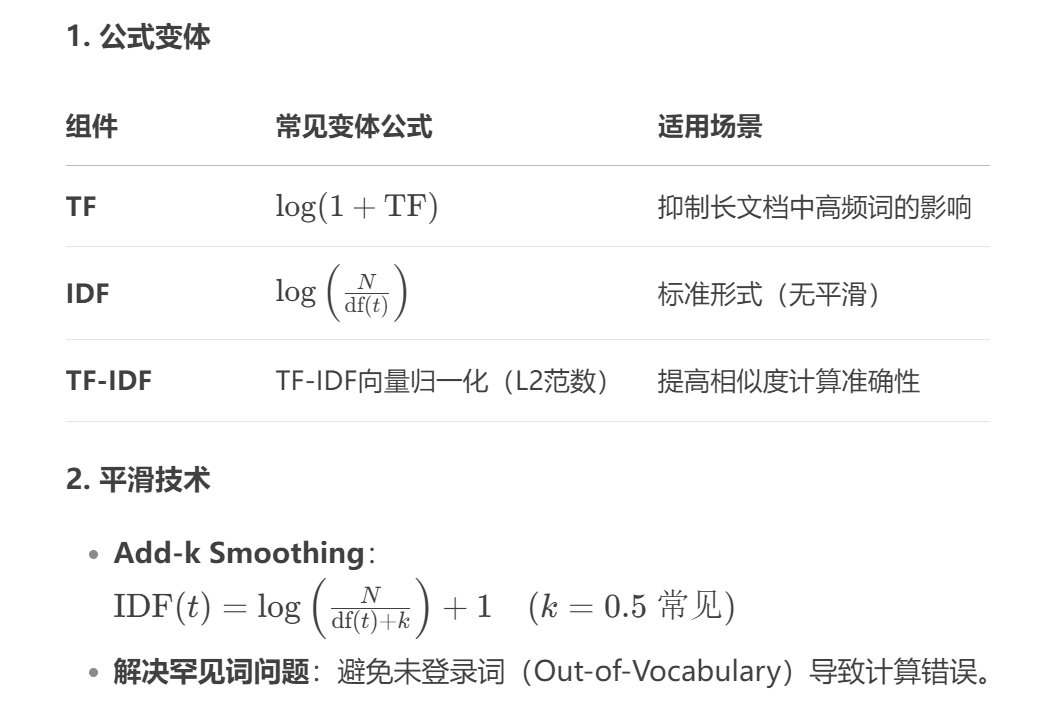

二、数学原理与优化

三、应用场景扩展

1. 搜索引擎排序

-

早期Google算法:对网页中与查询词匹配的TF-IDF值求和,作为相关性得分。

-

示例:

查询词 = “新冠疫苗副作用”

网页A:TF-IDF(“副作用”)=0.2, TF-IDF(“疫苗”)=0.15 → 总分=0.35

网页B:TF-IDF(“副作用”)=0.1, TF-IDF(“疫苗”)=0.1 → 总分=0.20

→ 网页A排名更高

2. 关键词提取

-

步骤:

-

对文档分词并计算每个词的TF-IDF值

-

取Top-N词作为关键词

-

-

工具:Python

jieba.analyse.extract_tags()内置TF-IDF算法

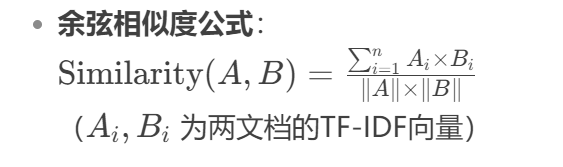

3. 文本相似度计算

四、实战代码详解(Python)

from sklearn.feature_extraction.text import TfidfVectorizer

# 语料库示例

documents = [

"人工智能应用系统设计",

"人工智能在医疗领域的应用",

"深度学习驱动医疗影像分析"

]

# 步骤1:初始化向量化器(重要参数说明)

vectorizer = TfidfVectorizer(

tokenizer=jieba.cut, # 中文需分词(需安装jieba)

stop_words=["的", "在"], # 自定义停用词

max_features=1000, # 仅保留最高频的1000个词

norm='l2' # 向量L2归一化

)

# 步骤2:计算TF-IDF矩阵

tfidf_matrix = vectorizer.fit_transform(documents)

# 输出结果

print("特征词列表:", vectorizer.get_feature_names_out())

print("TF-IDF矩阵:\n", tfidf_matrix.toarray())

# 应用示例:计算文档相似度

from sklearn.metrics.pairwise import cosine_similarity

similarity = cosine_similarity(tfidf_matrix[0], tfidf_matrix[1])

print("文档1与文档2的余弦相似度:", similarity[0][0])五、优缺点深度分析

| 优点 | 缺点 | 解决方案 |

|---|---|---|

| ✅ 计算高效,适合大规模文本 | ❌ 忽略词序(“猫吃鱼” vs “鱼吃猫” 权重相同) | 搭配n-gram特征使用 |

| ✅ 无需标注数据 | ❌ 无法捕捉语义(“电脑” vs “计算机”) | 结合词嵌入(Word2Vec) |

| ✅ 可解释性强(权重即重要性) | ❌ 对短文本敏感(TF统计不稳定) | 引入外部语料库计算IDF |

六、进阶学习资源

-

经典论文:

-

工具库:

-

Python:

sklearn.feature_extraction.text.TfidfVectorizer -

Java: Apache Lucene

TFIDFSimilarity -

中文处理:

jieba.analyse(集成TF-IDF关键词提取)

-

-

替代方案:

-

BM25:针对TF-IDF在长文档中的改进(Elasticsearch默认算法)

-

TF-ICF:用信息量(Information Content)替代IDF,提升专业术语权重

-

-

实战项目建议:

-

用TF-IDF + 朴素贝叶斯实现新闻分类(Kaggle示例

-

基于TF-IDF和余弦相似度构建简易搜索引擎

-

七、总结

TF-IDF作为文本表示基石,其价值在于:

-

高效过滤噪声:通过IDF抑制通用词

-

量化词重要性:直接提取关键信息

-

兼容性强:与机器学习模型(SVM、神经网络)无缝结合

尽管存在语义捕捉不足的局限,TF-IDF在预处理、快速原型开发中仍是首选。建议后续学习:

-

文本嵌入:Word2Vec → BERT

-

权重优化:BM25 → TF-ICF

-

混合模型:TF-IDF + 词嵌入特征融合

1260

1260

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?