DeepSeek使用利器Cherry Studio,即刻注册赠送2000万Token

一、说明

目前DeepSeek的热度不必多说, 接下来只说干货, 无废话

硅基流动注册邀请码: https://cloud.siliconflow.cn/i/fp7Wo5WM

- 下载软件

- Cherry Studio下载地址https://cherry-ai.com/download, 如图

- 安装好后如下图

二、注册

- 硅基流动地址: https://cloud.siliconflow.cn

硅基流动注册邀请码 https://cloud.siliconflow.cn/i/fp7Wo5WM

注意!!! 注册过程中, 务必填写邀请码, 否则没有任何东西赠送

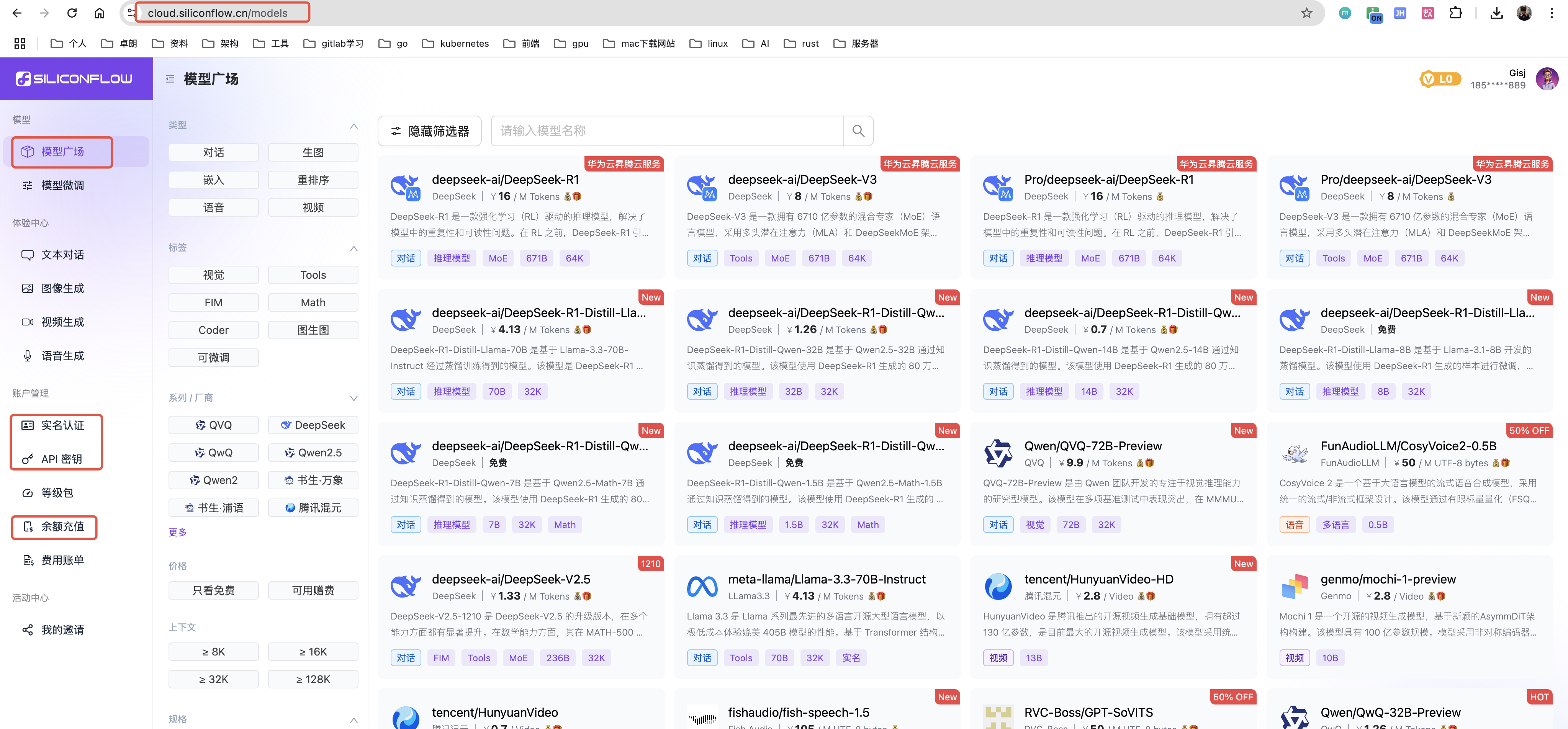

- 注册后进入模型广场, 可以看到有许多的模型

- 实名认证

- 采用个人认证即可, 需要手机扫描二维码, 跟着提示的步骤走即可, 中间会弹出登录页面, 此处务必再次填写邀请码

- 手机登录后, 在电脑的网页端点击已实名认证按钮即可

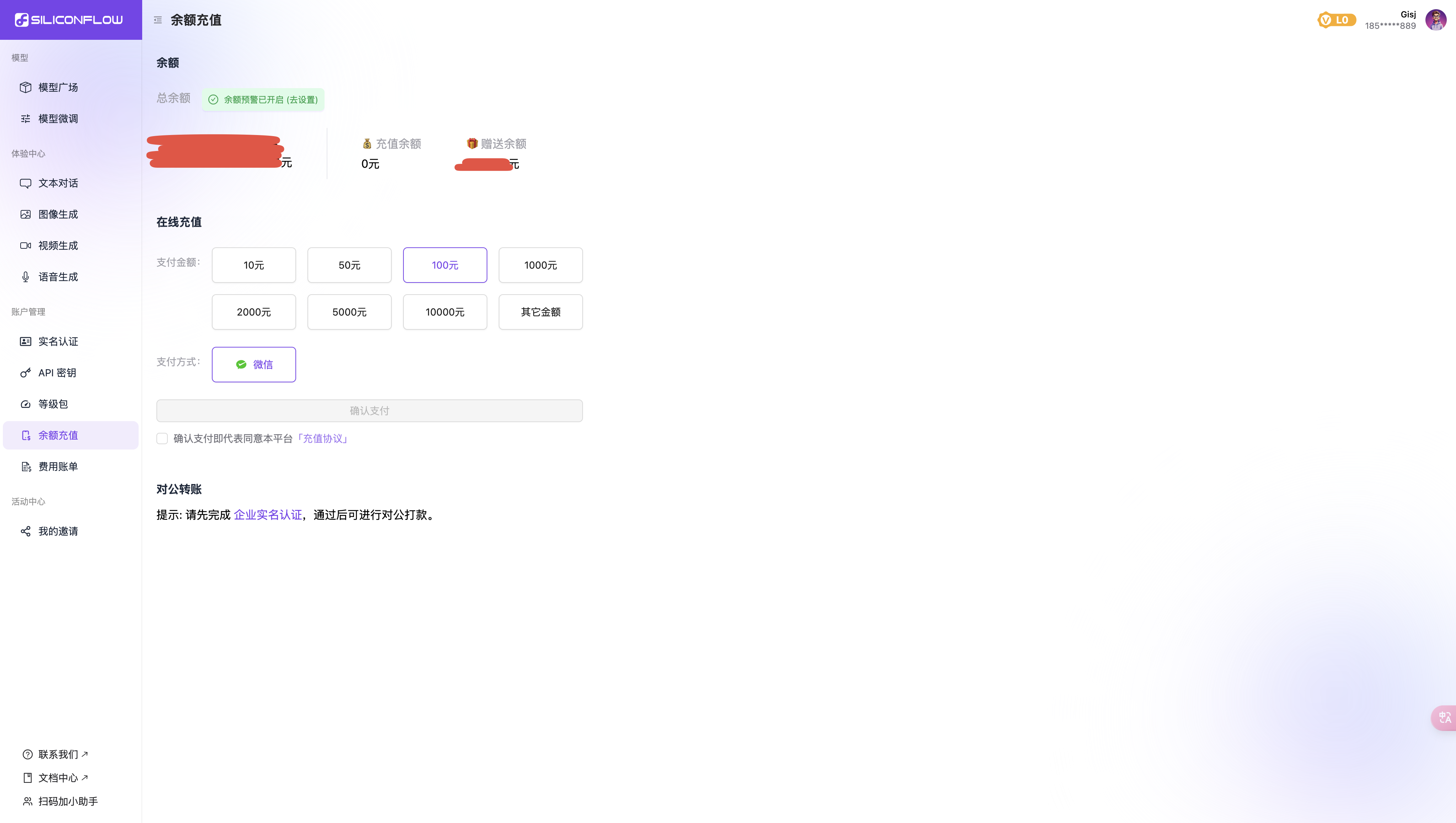

- 查看余额, 如图

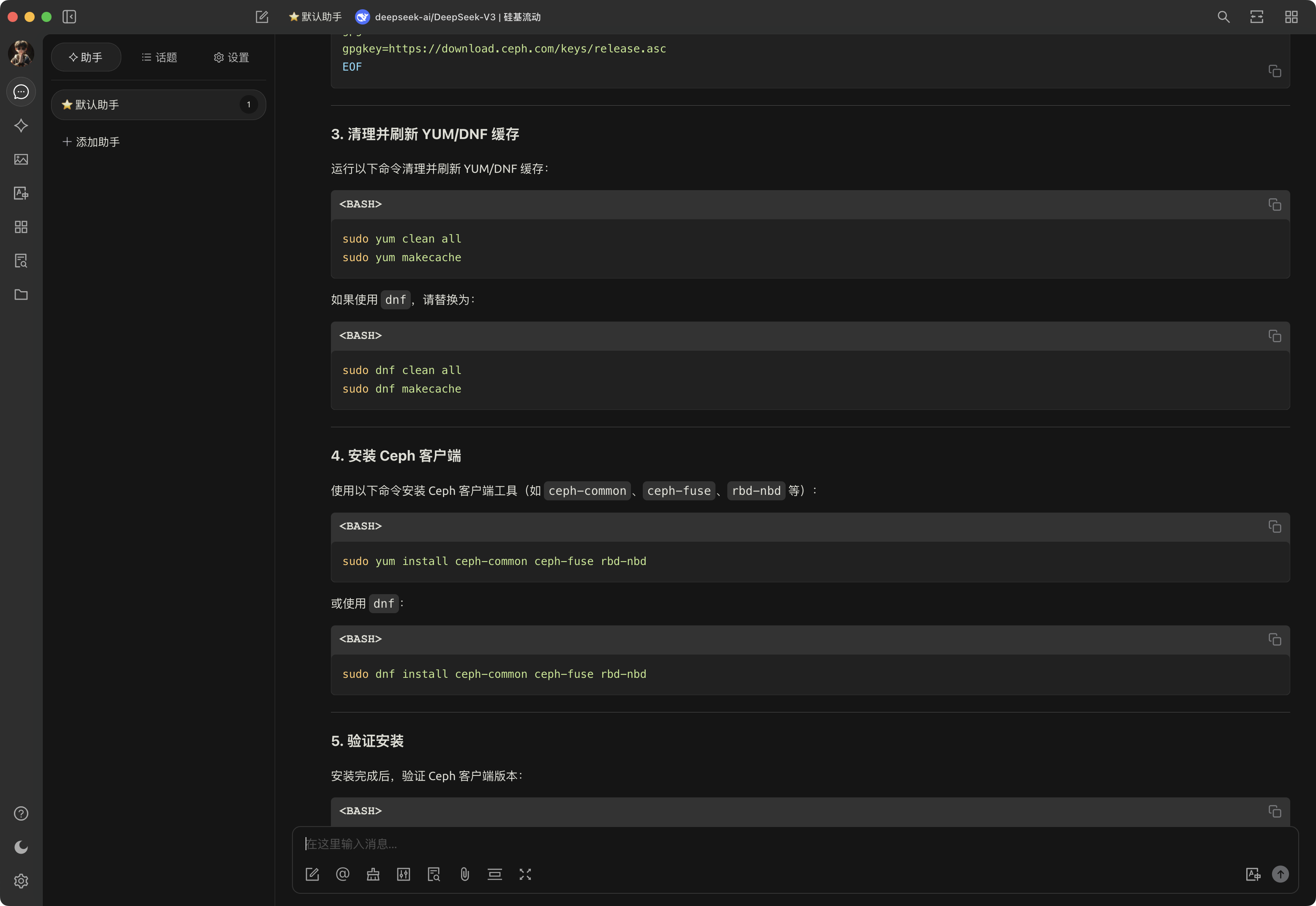

三、配置

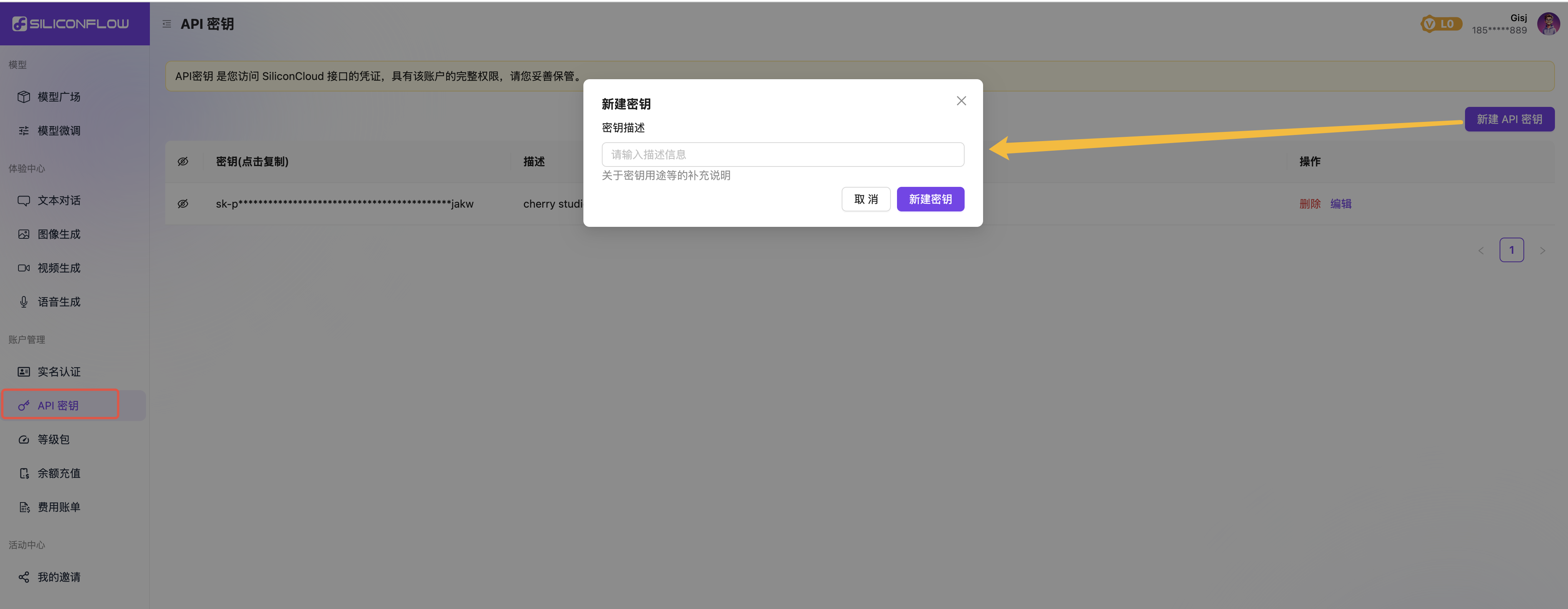

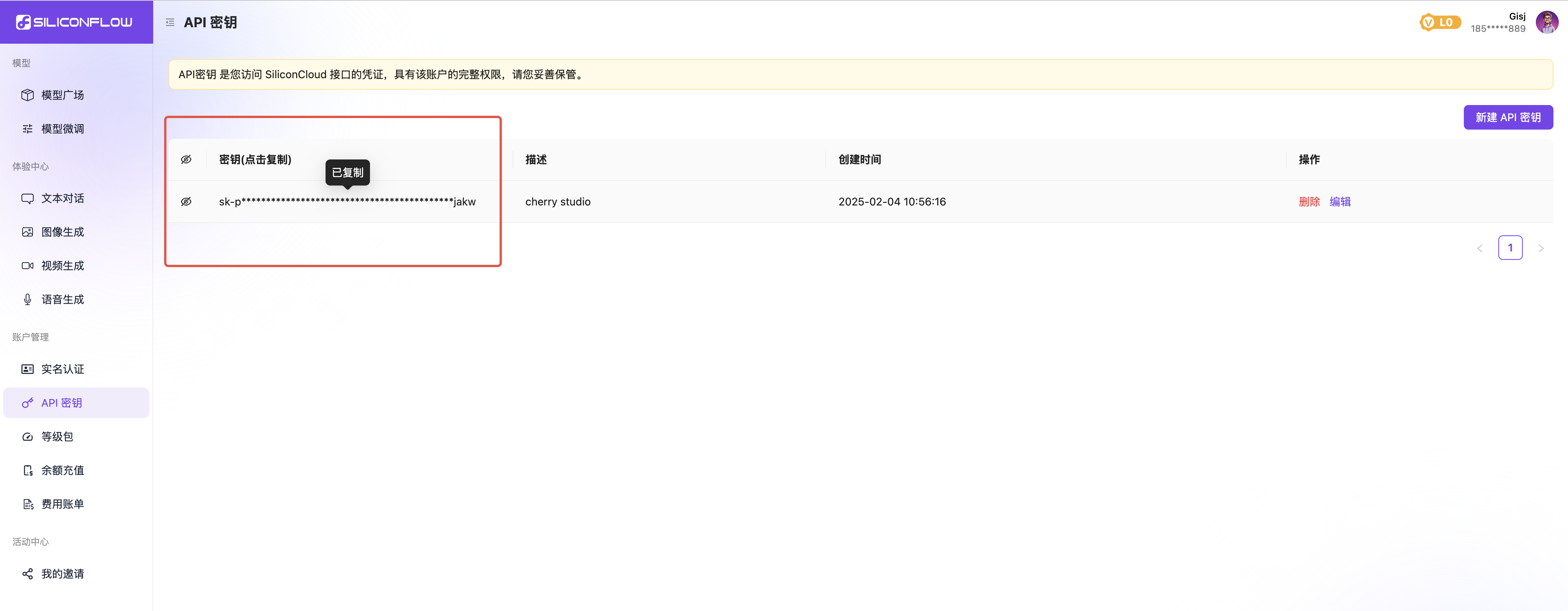

- 自定义密钥, 如图, 随便输入即可, 最好要有意义

- 点击复制

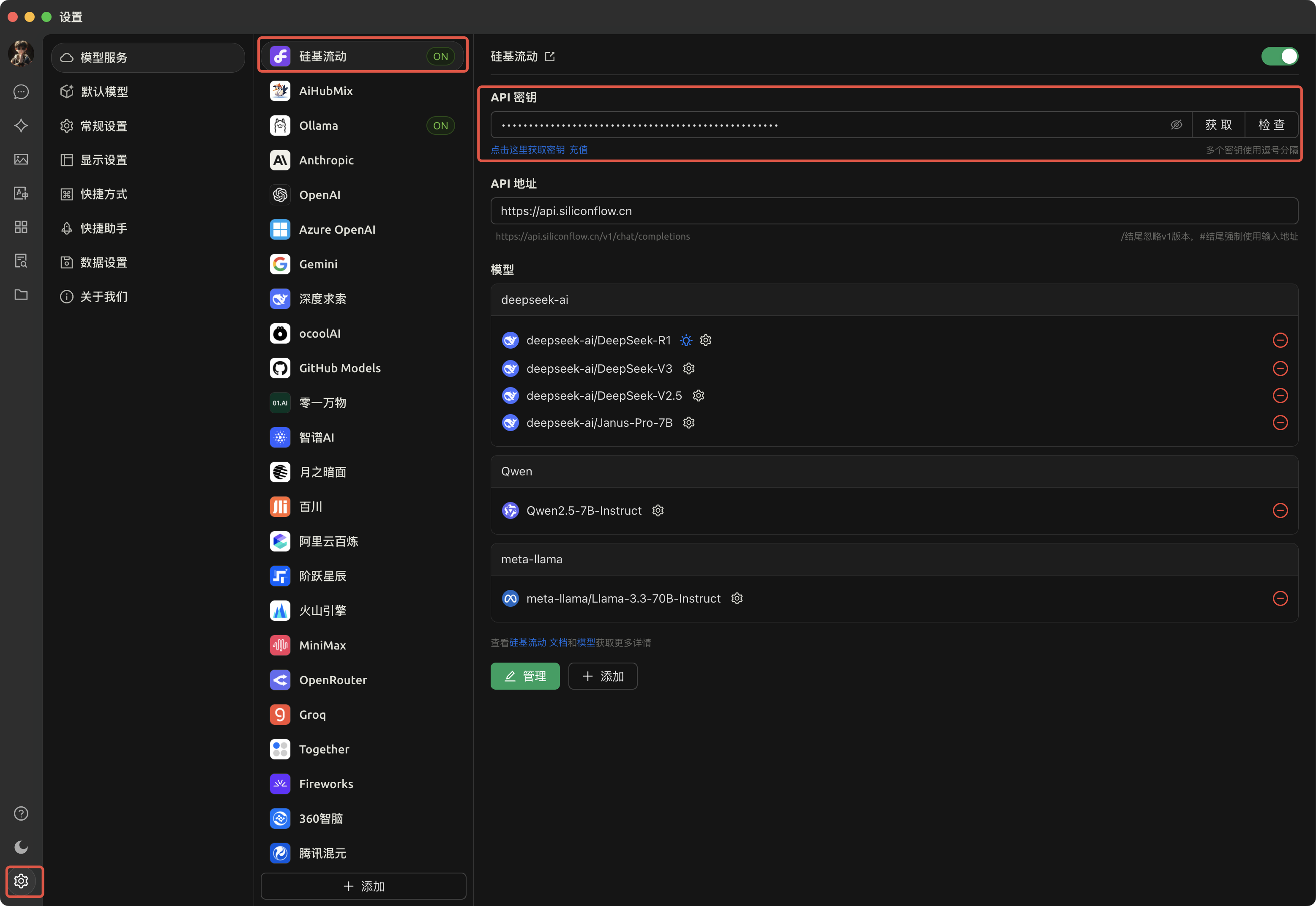

- 打开 Cherry Studio, 如图

- 点击左下角的设置

- 找到硅基流动

- 将刚才上述复制的key的密钥复制到API密钥中

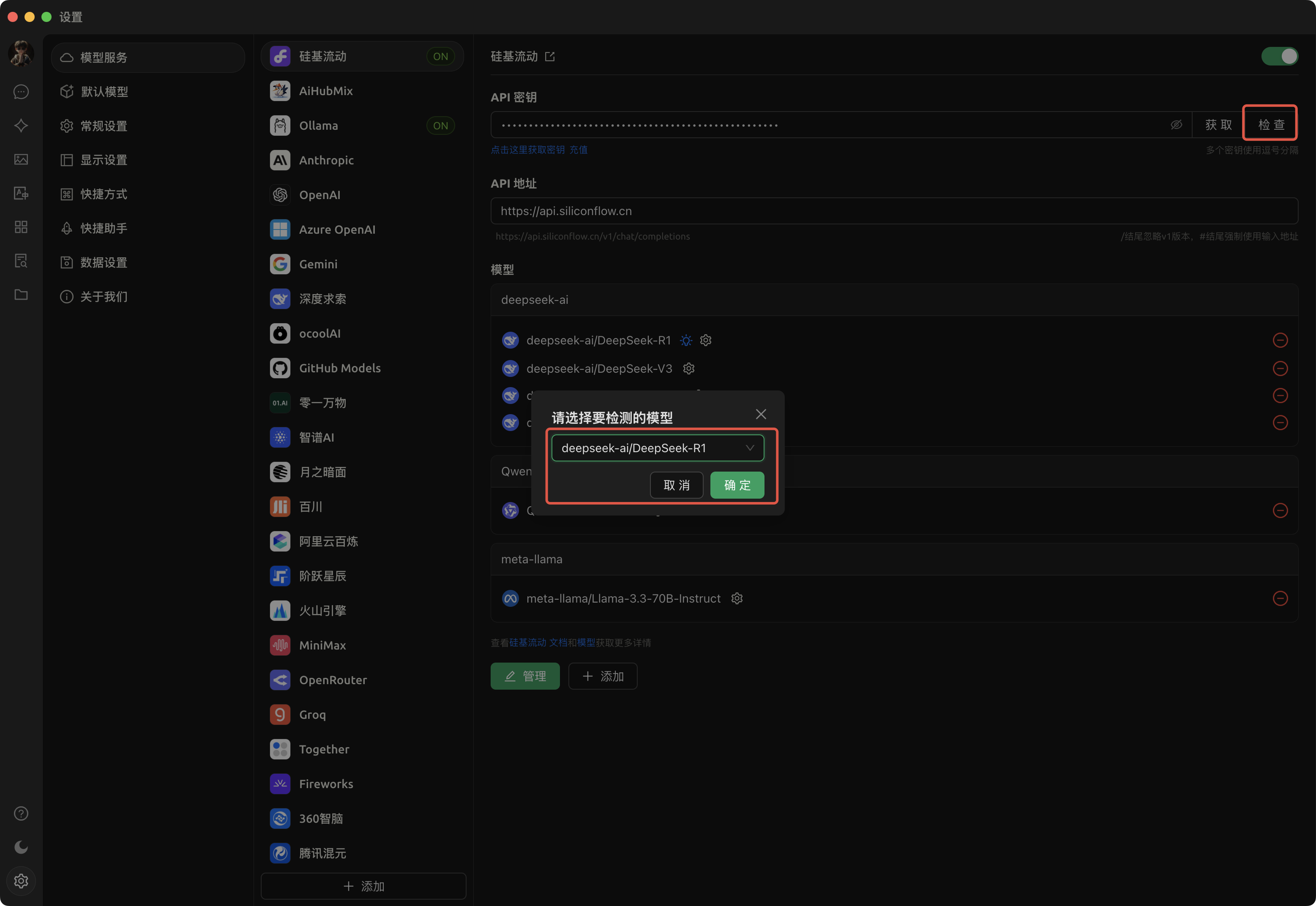

- 检查

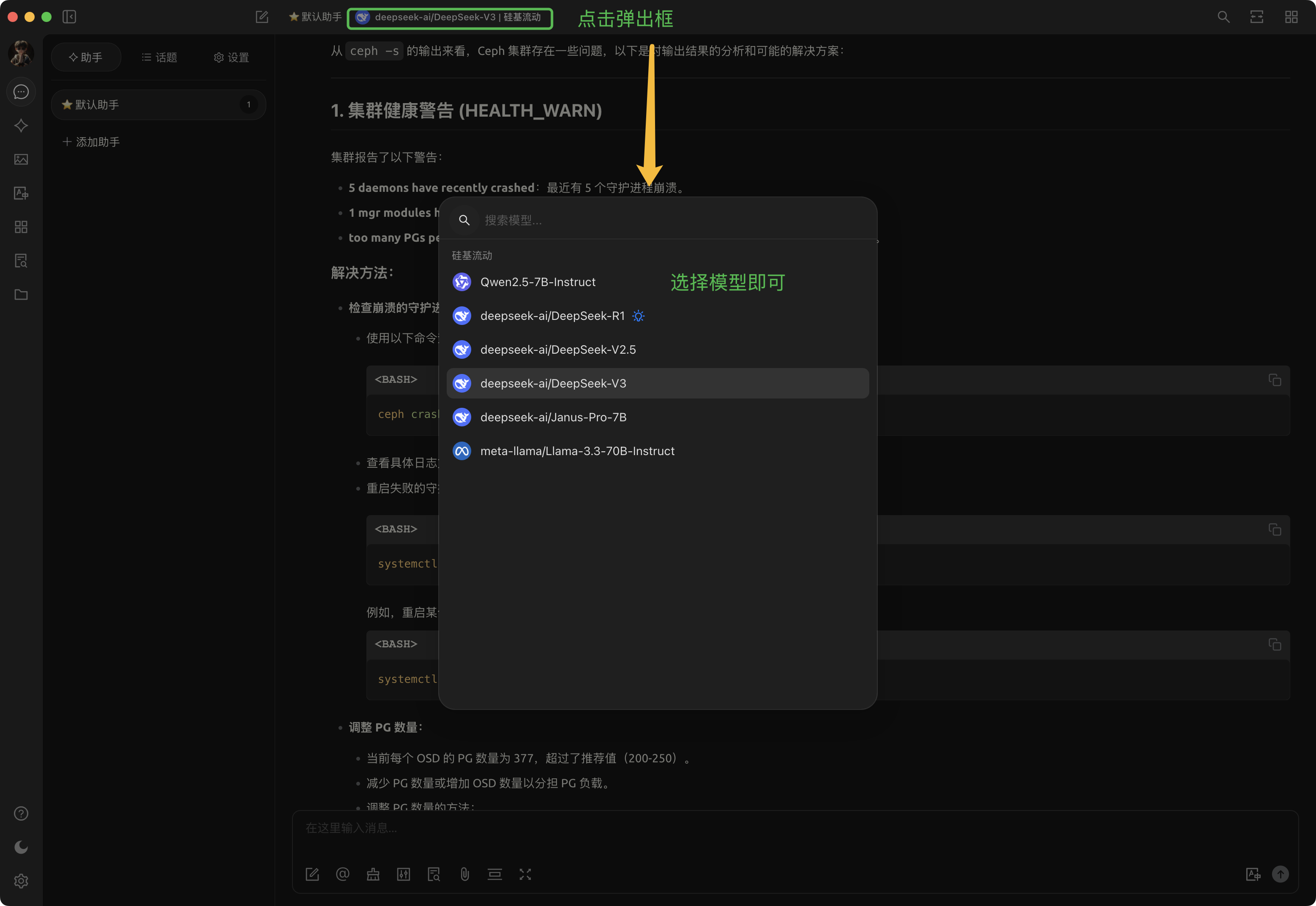

- 点击检查, 弹出框选择deepseek-ai/DeepSeek-R1模型进行确定验证

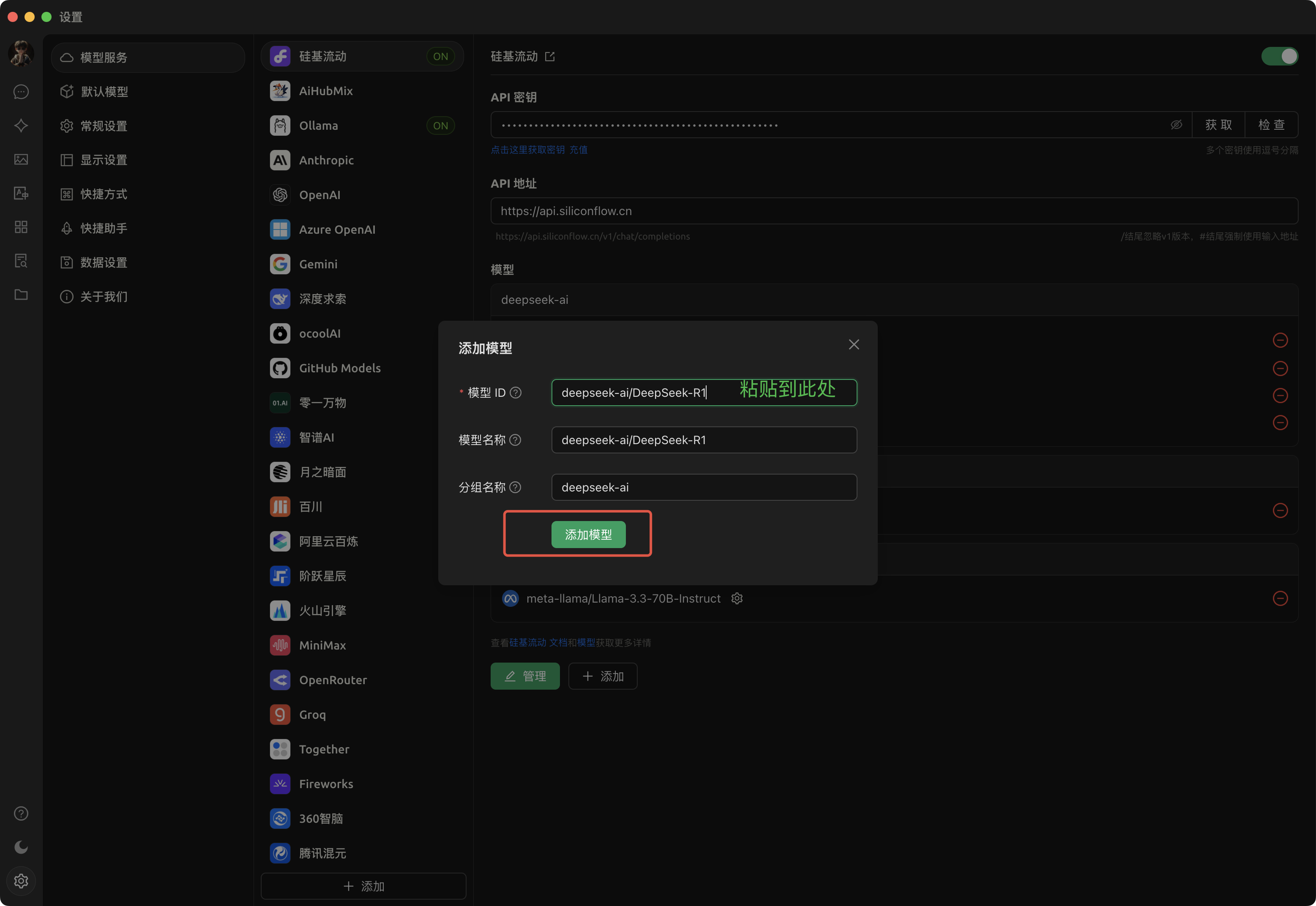

- 添加模型

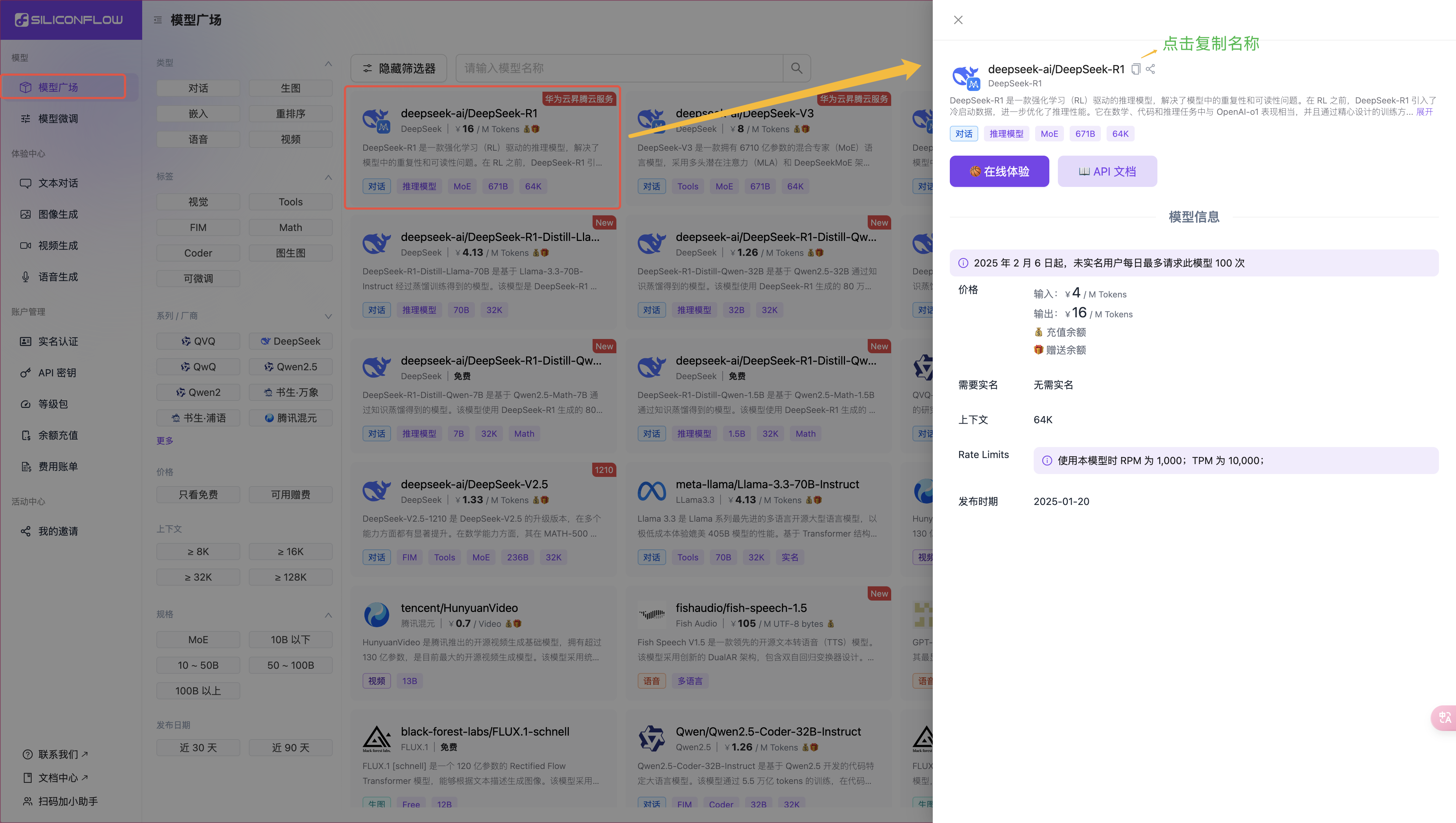

- 回到硅基流动的web页面,如图

- 打开模型广场, 选择deepseek全量模型, 671B的

- 回到刚刚安装的app中,如图

- 将刚才copy的模型id放到如图的文本框里, 名称, 分组自动回填

- 点击确定即可

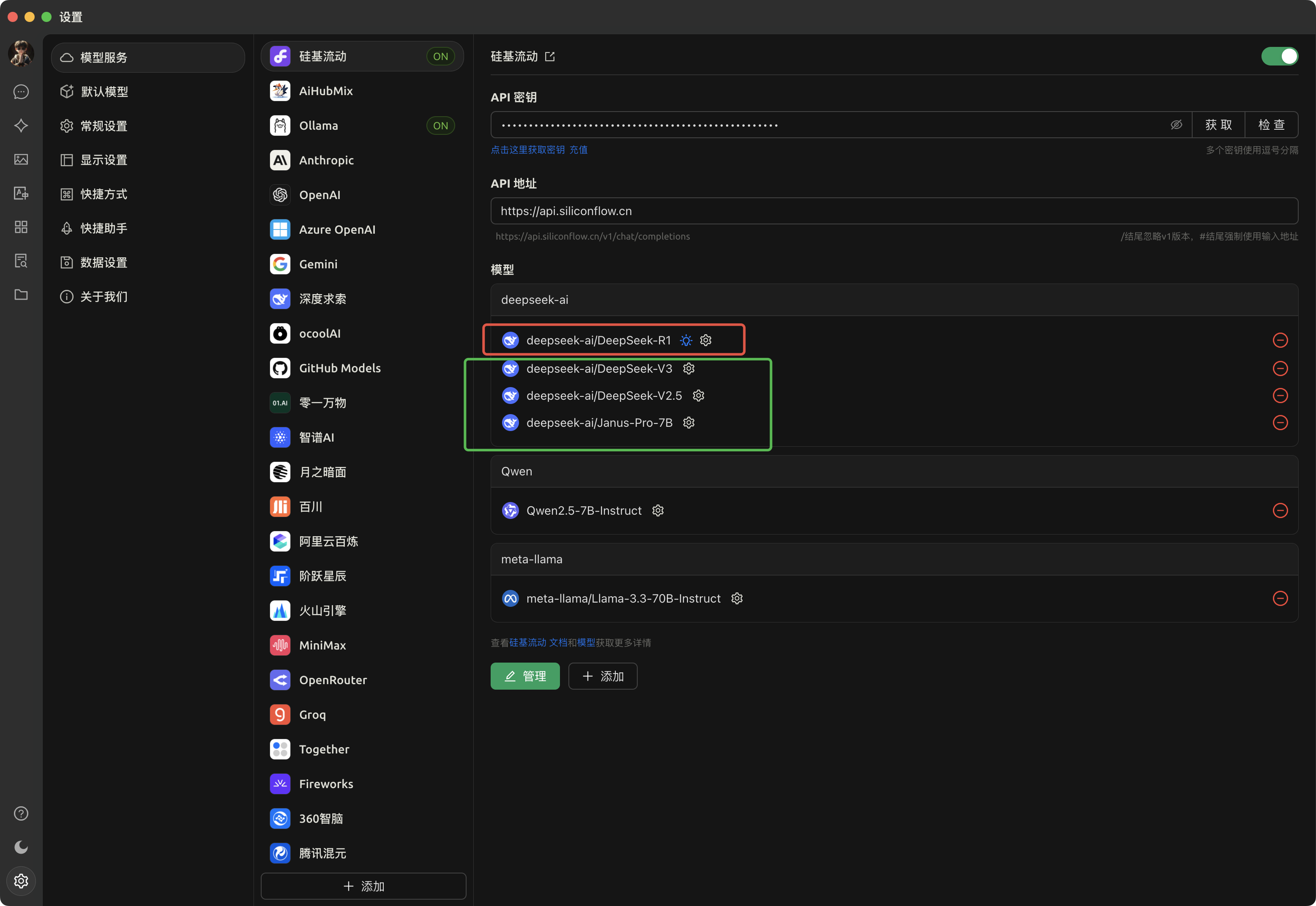

- 效果查看

- 我这里添加了4个

四、结束语

祝大家玩的愉快, 用不淘汰

7146

7146

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?