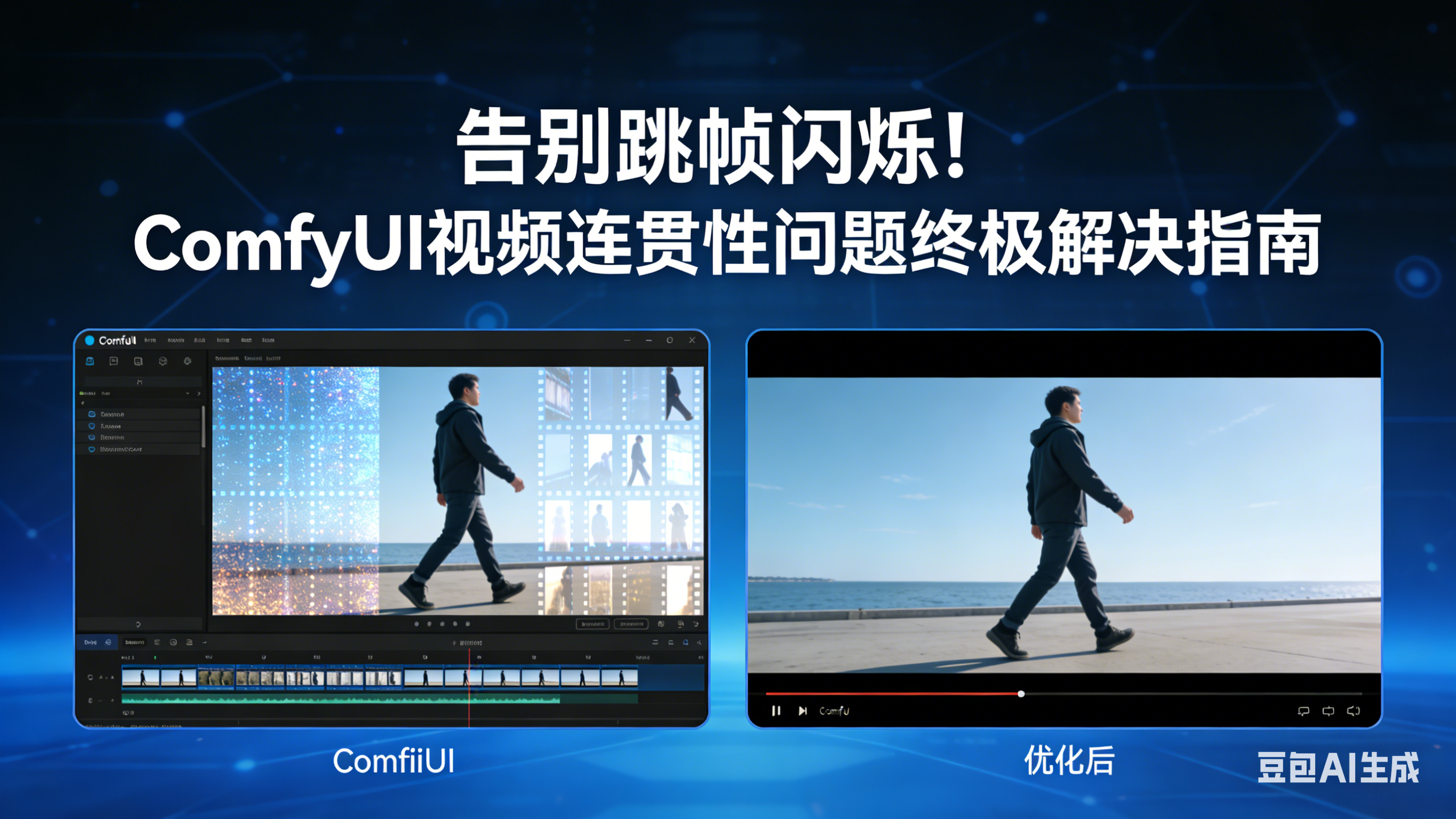

告别跳帧闪烁!ComfyUI视频连贯性问题终极解决指南

用ComfyUI做AI视频生成时,你是否遇到过这些糟心场景:人物动作突然“瞬移”、背景莫名闪烁、风格突然跑偏,明明单帧效果惊艳,合在一起却成了“PPT式幻灯片”?其实,视频连贯性差是ComfyUI用户的高频痛点,核心根源在于帧间特征关联不足、参数控制失当或工具使用不到位。本文将从问题本质出发,提供从基础参数调优到高级插件应用的全流程解决方案,帮你轻松生成丝滑流畅的AI视频。

一、先搞懂:视频连贯性差的3大核心表现与根源

在动手优化前,我们先明确问题类型,才能精准对症。ComfyUI视频连贯性问题主要体现在以下3个方面,背后原因各有侧重:

1. 常见表现

-

运动轨迹断裂:物体/人物位置突变(比如杯子从左边瞬移到右边)、动作衔接僵硬(走路像机器人);

-

视觉元素闪烁:背景细节频繁变化(比如墙壁纹理忽明忽暗)、光影效果突然切换;

-

风格与细节漂移:部分帧画风突变(写实变卡通)、人物面部特征不一致(五官时隐时现)。

2. 核心根源

-

模型预测不确定性:扩散模型本身对帧间动态关联捕捉不足,单帧生成时易出现随机偏差;

-

参数设置不合理:采样器、CFG Scale、噪声强度等参数帧间不一致,导致生成逻辑断裂;

-

关键帧与插值问题:关键帧密度不足或插值算法粗糙,无法实现平滑过渡;

-

缺乏帧间约束机制:未启用光流、参考帧等技术,帧与帧之间处于“孤立生成”状态。

二、基础优化:3步搞定80%的连贯性问题(新手必看)

很多时候,无需复杂工具,只要做好基础参数的统一与规范,就能显著提升连贯性。这部分是新手入门的核心,务必逐点落实。

1. 统一核心生成参数,避免帧间“逻辑冲突”

帧间参数不一致是连贯性差的最常见原因,所有生成帧必须保持以下参数完全统一:

| 参数类别 | 推荐设置 | 注意事项 |

|---|---|---|

| 采样器 | 优先选择DPM++ 2M Karras、Euler a(追求速度) | 严禁不同帧使用不同采样器,会导致风格断裂 |

| 采样步数 | 基础帧15-25步,关键帧20-30步 | 步数差异不超过5步,否则细节丰富度会突变 |

| CFG Scale | 7-12(通用场景),卡通动画可降至6-8 | 值过高易过度拟合(画面僵硬),过低易出现随机偏差(跳帧) |

| 噪声强度(Denoise) | 0.6-0.8(保留原特征),创意生成0.8-1.0 | 帧间差异不超过0.1,否则会出现“画面突变” |

| 分辨率与帧率 | 分辨率统一(如1080P),帧率24fps(标准视频帧率) | 避免中途调整分辨率,会导致画面拉伸或跳跃 |

| 关键技巧:在ComfyUI工作流中,将上述参数节点固定配置,复制生成帧时直接复用,避免手动调整导致的失误。 |

2. 优化Prompt工程,强化帧间语义连贯性

Prompt是生成逻辑的核心,混乱的Prompt会让模型“误解”帧间关系。建议遵循以下3个原则:

-

保持核心关键词一致:所有帧的正向Prompt需包含相同的主体描述(如“a girl in red dress”),仅调整动作或场景的动态部分(如“walking slowly”→“raising hand”);

-

加入时间维度描述:在Prompt中明确运动状态,如“smooth movement”“continuous rotation”“gradual light change”,引导模型捕捉帧间动态关联;

-

统一负Prompt:所有帧共用一套负Prompt,重点排除“blurry, low quality, distorted, inconsistent, flickering”等破坏连贯性的词汇。

3. 启用基础帧间关联:参考帧与图像重叠技术

通过简单的节点配置,让后一帧基于前一帧特征生成,避免“孤立创作”:

-

使用“Image Overlay”节点:将前一帧图像与当前帧生成结果进行局部融合,保留核心特征(如人物、主体物体),重叠强度设为0.3-0.5;

-

设置参考帧机制:在生成关键帧后,将其作为参考帧连接到后续帧的生成节点,通过“Reference Frame”参数控制参考强度(建议0.5-0.7),让模型在参考前帧特征的基础上生成新内容。

三、进阶强化:借助插件与工具,实现专业级连贯性

对于复杂场景(如长视频、动态转场、风格迁移),仅靠基础优化不够,需借助ComfyUI专用视频插件,这些工具能从底层强化帧间关联。

1. 必备插件:3款核心工具安装与使用指南

以下插件均支持通过ComfyUI Manager一键安装,新手优先从ComfyUI-VideoEditing入手:

(1)ComfyUI-VideoEditing:视频处理基础插件

核心功能:视频拆分(将视频转为图片序列)、帧间一致性增强、风格统一,是解决闪烁问题的“入门神器”。

-

安装方法:打开ComfyUI → 点击Manager → 搜索“VideoEditing” → 安装后重启;

-

关键节点使用:

Load Video to Images:拆分视频为图片序列,参数设置“帧间隔=1”(保留所有帧); -

VEdit Sampler:专用视频采样节点,内置帧间一致性优化,Attention Weight设为0.8-1.2(值越高一致性越强);

-

Video Combine:将处理后的图片序列合成为视频,帧率固定24fps。

-

典型应用:解决背景闪烁问题,通过“VEdit Sampler”节点的“Stable Background”功能,锁定背景特征,仅允许主体动态变化。

(2)ComfyUI-LTXVideo:高级关键帧与光流控制

适合需要精细控制动态效果的场景(如复杂转场、多提示时序切换),核心优势是通过关键帧精准控制帧间参数变化。

-

核心节点组合(推荐工作流):

CLIPTextEncode(多提示输入)→ LTXVConditioning(关键帧映射)→ STGGuiderAdvanced(动态参数)→ VAEDecodeTiled(解码输出)→ VHS_VideoCombine(视频合成) -

关键参数配置:

LTXVConditioning:设置关键帧时间点(如“(0), (10), (20)”代表第0、10、20帧为关键帧),分配不同Prompt权重; -

STGGuiderAdvanced:动态调整CFG和STG参数,相邻关键帧参数差值不超过0.15,避免参数突变;

-

光流加速:启用“LTXFlowEditCFGGuiderNode”,光流强度设为0.7-0.9,通过像素级运动场估计,实现帧间平滑过渡。

(3)Wan22FMLF:三帧控制实现丝滑动作

针对“动作断裂”痛点,只需提供起始、中间、结束3张姿势图,即可自动生成连续动作视频,适合人物动作、物体运动等场景。

-

核心参数设置:

middleframeratio:指定中间帧位置(如0.5代表中间帧在视频正中间); -

middleframestrength:中间帧参考强度(建议0.5,平衡自然度与准确性;设为1会导致动作僵硬)。

-

工作流搭建:Load Image(3张姿势图)→ WanFirstMiddleLastFrame → Wan2.2模型 → Video Combine,无需复杂参数调整,新手也能快速上手。

2. 光流技术深度应用:解决运动轨迹不自然问题

光流技术通过估计帧间像素运动轨迹,指导模型生成符合物理规律的过渡帧,是解决“动作瞬移”的核心手段:

-

工具选择:使用RAFT光流模型(ComfyUI可通过“Optical Flow”节点调用),或直接使用ComfyUI-LTXVideo的“LTXFlowEditCFGGuiderNode”;

-

关键参数:

光流强度:0.7-0.9(值越高过渡越平滑,但可能损失细节); -

引导帧间隔:每12-15帧设置一个关键引导帧,平衡精度与性能;

-

应用场景:人物走路、物体旋转、镜头移动等动态场景,启用后可显著改善运动轨迹的自然度。

四、高级技巧:帧间记忆与一致性约束(长视频必备)

对于时长超过10秒的长视频,需从模型层面强化帧间关联,避免长时间生成导致的风格漂移或动作断裂。

1. 启用帧间记忆机制:Transformer与LSTM架构应用

通过提取并存储多帧特征向量,让模型“记住”前序帧的核心特征,避免后续帧生成时出现偏差:

-

工具选择:使用ComfyUI-LTXVideo的“LTXVLoopingSampler”节点,支持时空分块技术,可生成任意长度视频;

-

核心设置:启用“AdaIn操作”防止色彩偏移,设置“重叠区域平滑过渡”(重叠率10%-20%),确保分块生成的视频无缝拼接。

2. 加入一致性约束:时间维度损失函数配置

通过自定义损失函数,强制模型在生成时保持帧间特征一致性(适合有一定技术基础的用户):

-

核心逻辑:设计包含时间维度的损失函数(如L1/L2距离、感知损失),计算相邻帧特征差异,约束模型生成时最小化该差异;

-

实现方式:在ComfyUI中通过“Custom Loss”节点配置,或使用修改后的扩散模型(如Animatediff的时间嵌入增强版本)。

3. ControlNet辅助:锁定核心特征不漂移

结合ControlNet的姿态检测(OpenPose)、深度图(Depth)、边缘检测(Canny)等功能,强制所有帧保持相同的主体结构:

-

工作流配置:ControlNet Preprocessor(如OpenPose)→ ControlNet Model → 生成节点;

-

参数设置:Control Weight设为0.6-0.8,启用“Resample”功能,确保帧间ControlNet特征平滑过渡。

五、实操案例:Animatediff工作流连贯性优化完整步骤

以“人物走路”视频生成为例,结合上述方法,搭建优化后的工作流:

-

加载基础模型:Animatediff模型 + 人物主题LoRA,确保模型支持视频生成;

-

配置核心参数:采样器DPM++ 2M Karras,采样步数25,CFG Scale 8,Denoise 0.75,分辨率1080P,帧率24fps;

-

设置关键帧:使用LTXVConditioning节点,设置3个关键帧(0秒、2秒、4秒),Prompt分别为“a girl walking, start pose”→“a girl walking, middle pose”→“a girl walking, end pose”;

-

启用光流控制:添加LTXFlowEditCFGGuiderNode,光流强度0.8,引导帧间隔12帧;

-

ControlNet辅助:添加OpenPose Preprocessor,提取关键帧姿态,Control Weight 0.7;

-

视频合成:使用VHS_VideoCombine节点,合并生成的图片序列,输出24fps视频。

优化效果:人物走路轨迹平滑,无瞬移现象,背景细节稳定,无闪烁或风格漂移。

六、避坑指南:常见问题与解决方案汇总

| 常见问题 | 解决方案 |

|---|---|

| 视频闪烁严重 | 1. 降低CFG Scale(至7-8);2. 启用ComfyUI-VideoEditing的“Stable Background”功能;3. 统一所有帧的噪声强度 |

| 动作僵硬/瞬移 | 1. 启用光流技术;2. 增加关键帧密度(每1-2秒1个关键帧);3. 使用Wan22FMLF节点控制中间帧 |

| 风格漂移 | 1. 统一Prompt核心关键词;2. 启用帧间记忆机制;3. 降低Denoise强度(≤0.8) |

| 处理速度慢/显存不足 | 1. 减少采样步数(至20步);2. 降低分辨率(如720P);3. 启用分块采样(tiled sampler);4. 设置VRAM Usage为“low” |

| 长视频中间帧质量下降 | 1. 使用LTXVLoopingSampler节点;2. 每16帧为一个处理单元;3. 启用重叠区域平滑过渡 |

七、总结:连贯性优化的核心逻辑

ComfyUI视频连贯性优化的核心,本质是“减少帧间不确定性,强化帧间关联性”:新手从统一参数、优化Prompt入手,快速解决基础问题;进阶用户借助VideoEditing、LTXVideo等插件,实现精细控制;高级用户通过帧间记忆、一致性约束,搞定长视频与复杂场景。

建议大家先从简单场景(如5秒短视频)练习,熟悉参数与插件的使用逻辑后,再逐步尝试长视频与复杂动态效果。如果在实操中遇到具体问题,欢迎在评论区留言交流!

2570

2570

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?