目录

决策树算法是一种直观且强大的监督学习算法,它广泛应用于分类和回归问题中。这种算法以树状结构为基础,通过一系列的分裂节点来展示决策过程,并依据特征的取值对实例进行分类或预测。下面,我将对决策树算法的基本概念和工作原理进行更为详细的描述和补充。

一、基本概念

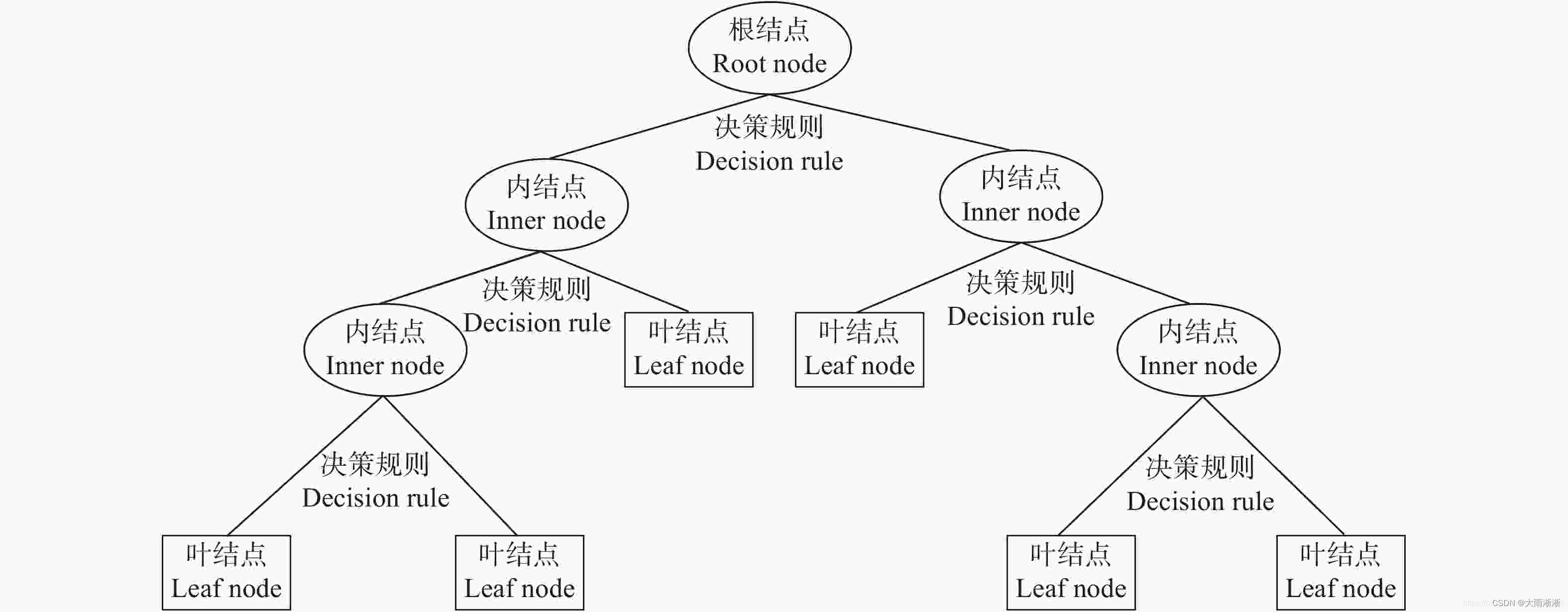

节点:在决策树中,每一个分叉点都称为一个节点。

根节点:作为整个决策树的起点,它包含了整个数据集的样本。

内部节点(或决策节点):这是根据某个特征的取值对样本进行分裂的节点。这些节点通常基于某种评估准则(如信息增益、增益率或基尼指数)来选择最佳的分裂特征。

叶节点(或终端节点):位于决策树的最底层,包含最终的决策结果。对于分类问题,这些节点通常表示某个类别标签;对于回归问题,它们可能表示一个具体的预测值或值的范围。

分支:从一个节点到其直接子节点的连接线称为分支,它代表了根据特征取值进行划分的方向。

特征:在决策树中,用于在节点处进行分裂的属性或变量被称为特征。特征的选择对于决策树的性能至关重要,因为它直接决定了树的分裂方式和最终的预测精度。

纯度:纯度是衡量节点内样本相似程度的一个指标。对于分类问题,一个节点的纯度越高,意味着该节点内的样本越可能属于同一个类别。纯度通常通过某种评估函数(如信息熵、基尼不纯度等)来计算。

二、工作原理

选择最优分裂特征:在构建决策树的过程中,算法需要选择最优的分裂特征来确保每次分裂后节点的纯度尽可能提高。这通常通过计算特征的信息增益、增益率或基尼指数等指标来实现。不同的决策树算法可能会使用不同的评估准则。

递归构建决策树:从根节点开始,算法会选择最优的分裂特征进行分裂,并生成相应的子节点。然后,对每个子节点递归地应用上述过程,直到满足某个停止条件(如节点内的样本都属于同一类别、节点中的样本数少于某个阈值、没有更多的特征可用于分裂

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?