一 文本表示

- 文本表示是自然语言处理的开始。

- 含义:把字词处理成向量或矩阵,以便计算机能进行处理。

- 按照细粒度划分,一般可分为字级别、词语级别和句子级别的文本表示。

- eg:刘诗诗实在太可爱了,我想娶”这句话拆成一个个的字:{刘,诗,实,在,太,可,爱,了,我,想,娶},然后把每个字用一个向量表示,那么这句话就转化为了由11个向量组成的矩阵。

- 文本表示分为离散表示和分布式表示。

- 离散表示的代表就是词袋模型,one-hot(也叫独热编码)、TF-IDF、n-gram都可以看作是词袋模型。

- 分布式表示也叫做词嵌入(word embedding),经典模型是word2vec,还包括后来的Glove、ELMO、GPT和最近很火的BERT。

二 词袋模型

- 假如现在有1000篇新闻文档,把这些文档拆成一个个的字,去重后得到3000个字,然后把这3000个字作为字典,进行文本表示的模型,叫做词袋模型。

- 特点是字典中的字没有特定的顺序,句子的总体结构也被舍弃。

(1)one-hot

- eg:有两句话“刘诗诗太漂亮了,我爱刘诗诗”,“我喜欢看刘诗诗的电视剧和电影”,把这两句话拆成一个个的字,整理得到17个不重复的字,这17个字决定了在文本表示时向量的长度为17。

- 下面这个表格的第一行是这两句话构成的一个词袋(或者说字典),有17个字。

- 要对两句话进行数值表示,那么先构造一个2×17的零矩阵;

- 然后找到第一句话中每个字在字典中出现的位置,把该位置的0替换为1,第二句话也这样处理。

- 只管字出现了没有(出现了就填入1,不然就是0),而不管这个字在句子中出现了几次。

- 表格中的二、三行就是这两句话的one-hot表示。

| 刘 | 诗 | 太 | 漂 | 亮 | 了 | 我 | 爱 | 喜 | 欢 | 看 | 的 | 电 | 视 | 剧 | 和 | 影 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 1 | 1 | 1 | 1 | 1 | 1 | 1 | 1 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 |

| 1 | 1 | 0 | 0 | 0 | 0 | 1 | 0 | 1 | 1 | 1 | 1 | 1 | 1 | 1 | 1 | 1 |

从表中我们可以看出以下几个问题:

-

数据稀疏和维度灾难。

- 数据稀疏:向量的大部分元素为0。

- 如果词袋中的字词达数百万个,那么由每篇文档转换成的向量的维度是数百万维,由于每篇文档去重后字数较少,因此向量中大部分的元素是0。

- 这样进行文本表示有几个问题。可见,尽管两个句子的长度不一样,但是one-hot编码后长度都一样了,方便进行矩阵运算。

-

没有考虑句中字的顺序性。

- 假定字之间相互独立。这意味着意思不同的句子可能得到一样的向量。

- eg:“我太漂亮了,刘诗诗爱我”,“刘诗诗喜欢看我的电视剧和电影”,得到的one-hot编码和上面两句话的是一样的。

-

没有考虑字的相对重要性。这种表示只管字出现没有,而不管出现的频率,但显然一个字出现的次数越多,一般而言越重要(除了一些没有实际意义的停用词)。

接下来用TF-IDF来解决字的相对重要性问题。

(2)TF-IDF

- TF-IDF用来评估字词对于文档集合中某一篇文档的重要程度。

- 字词的重要性与它在某篇文档中出现的次数成正比,与它在所有文档中出现的次数成反比。

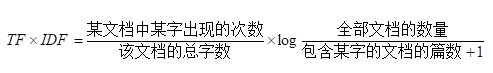

- 公式

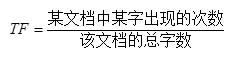

a TF:词频

- 用来衡量字在一篇文档中的重要性

- 公式

首先统计字典中每个字在句子中出现的次数:

| 刘 | 诗 | 太 | 漂 | 亮 | 了 | 我 | 爱 | 喜 | 欢 | 看 | 的 | 电 | 视 | 剧 | 和 | 影 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 2 | 4 | 1 | 1 | 1 | 1 | 1 | 1 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 |

| 1 | 2 | 0 | 0 | 0 | 0 | 1 | 0 | 1 | 1 | 1 | 1 | 2 | 1 | 1 | 1 | 1 |

再统计字典中每个字在句子中的频率,即TF值:

| 刘 | 诗 | 太 | 漂 | 亮 | 了 | 我 | 爱 | 喜 | 欢 | 看 | 的 | 电 | 视 | 剧 | 和 | 影 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 1/6 | 1/3 | 1/12 | 1/12 | 1/12 | 1/12 | 1/12 | 1/12 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 |

| 1/14 | 1/7 | 0 | 0 | 0 | 0 | 1/14 | 0 | 1/14 | 1/14 | 1/14 | 1/14 | 1/7 | 1/14 | 1/14 | 1/14 | 1/14 |

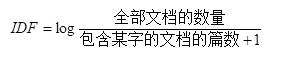

b IDF:逆文档频率

- 衡量某个字在所有文档集合中的常见程度。当包含某个字的文档的篇数越多时,这个字也就烂大街了,重要性越低。

- 公式

计算出来的IDF矩阵如下表:

| 刘 | 诗 | 太 | 漂 | 亮 | 了 | 我 | 爱 | 喜 | 欢 | 看 | 的 | 电 | 视 | 剧 | 和 | 影 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| -0.41 | -0.41 | 0 | 0 | 0 | 0 | -0.41 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 |

最后得到TF-IDF = TF × IDF,这里就不再计算了。

- TF-IDF算法的优点是简单快速,结果比较符合实际情况。

- 缺点:单纯以"词频"衡量一个词的重要性,不够全面,有时重要的词可能出现次数并不多。而且,这种算法无法体现词的位置信息,出现位置靠前的词与出现位置靠后的词,都被视为重要性相同,这是不正确的;数据稀疏。

(三)n-gram

上面词袋模型的两种表示方法假设字与字之间是相互独立的,没有考虑它们之间的顺序。于是引入n-gram(n元语法)的概念。n-gram是从一个句子中提取n个连续的字的集合,可以获取到字的前后信息。一般2-gram或者3-gram比较常见。

本文介绍了自然语言处理中的文本表示方法,重点讲解了词袋模型,包括one-hot编码、TF-IDF以及n-gram的概念和优缺点。词袋模型忽略了词序,one-hot编码导致数据稀疏,TF-IDF考虑了词的重要性,n-gram则考虑了相邻字的信息。

本文介绍了自然语言处理中的文本表示方法,重点讲解了词袋模型,包括one-hot编码、TF-IDF以及n-gram的概念和优缺点。词袋模型忽略了词序,one-hot编码导致数据稀疏,TF-IDF考虑了词的重要性,n-gram则考虑了相邻字的信息。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?