你是不是也想在自己的电脑上运行AI助手,而不用担心网络延迟和隐私问题?今天,我们就来手把手教你如何本地化部署DeepSeek,即使你是完全的新手,也能轻松上手!

前排提示,文末有大模型AGI-优快云独家资料包哦!

第一步:搭建基础环境(安装Ollama)

Ollama 是一个轻量级AI模型运行框架,支持多个开源模型,我们将用它来运行DeepSeek。

1. 下载 Ollama

-

访问 Ollama 官网

-

根据你的操作系统选择安装包(Windows 选择

.exe,Mac 选择.dmg)

-

下载完成后,按照提示进行安装:

-

Windows:双击安装包,一路“Next”即可

-

Mac:拖拽 Ollama 图标到

Applications文件夹

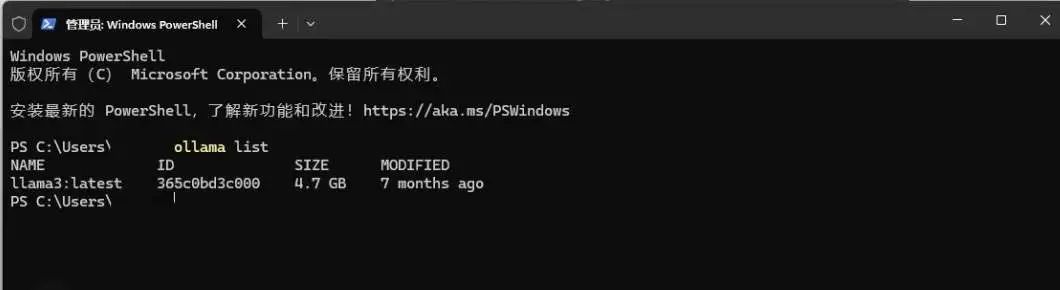

2. 验证安装 安装完成后,打开终端(Windows 按 Win + R 输入 cmd,Mac 直接打开 Terminal),输入:

`ollama list`

如果终端显示 llama3 之类的模型名称,说明安装成功!

注意事项

-

确保系统已更新,避免兼容性问题

-

关闭杀毒软件,以防拦截安装

-

保持网络畅通,下载过程中可能需要 300MB 以上的数据

第二步:部署DeepSeek模型

DeepSeek 提供多个参数版本,我们建议:

-

普通用户:选择

8B版本,适合日常对话、写作等 -

高性能显卡用户(显存 16GB 以上):可选

16B版本,体验更强大性能

1. 获取并安装模型

-

打开 Ollama 模型库,搜索

deepseek-r1 -

复制对应版本的安装命令,并在终端运行:

`ollama run deepseek-r1:8b`

(如果你选择 16B 版本,把 8b 替换为 16b)

首次运行时,系统会自动下载 5GB 左右的模型文件,耐心等待一下。

2. 测试模型是否正常运行 安装完成后,在终端输入:

`说一句有趣的新年祝福`

``

如果模型成功回应,说明部署无误!

第三步:安装可视化界面(Chatbox AI)

终端交互虽然好用,但如果你更喜欢类似 ChatGPT 那样的可视化界面,可以安装 Chatbox AI。

1. 下载 Chatbox

-

访问 Chatbox 官网 下载对应系统的安装包

-

按照默认设置完成安装

2. 连接本地模型

-

打开 Chatbox,进入

⚙️ 设置 -

在

模型设置里选择: -

API 类型:Ollama API

-

模型名称:deepseek-r1:8b

-

点击

检查连接,如果状态正常,就可以开始愉快地使用啦!

3. 进阶设置(可选)

-

温度值:建议

0.3-0.7,数值越低,AI 回答越保守 -

最大生成长度:建议

2048 tokens,这样回答更丰富 -

连续对话模式:开启后,能让对话更加连贯

第四步:优化交互和性能

为了让AI跑得更顺畅,这里有几个小技巧:

-

关闭其他大型程序,避免占用过多内存

-

复杂问题分步提问,能提高模型的理解力

-

使用英文关键词,有时能提升响应速度

-

定期重启 Ollama,释放内存,让AI保持最佳状态

常见问题及解决方案

Q1:运行时提示显存不足? A:尝试使用 8B 版本,或升级显卡驱动。

Q2:AI 回答乱码? A:在 Chatbox 设置中切换编码为 UTF-8。

Q3:如何更新模型? A:在终端执行:

`ollama pull deepseek-r1:8b`

就能获取最新版本。

总结

至此,你已经成功在本地部署了 DeepSeek,现在你拥有一个完全私密、无限制的 AI 助手,想用多少次都没问题!

最近,我的DeepSeek本地部署视频在B站播放量意外小爆,评论区被两类留言淹没:一类是技术爱好者追问“如何用消费级显卡跑通大模型”,另一类是职场人焦虑“我的工作会被AI取代吗?”这两个问题的背后,折射出一个残酷的真相:大模型技术正在重构所有行业的生存法则,而掌握这项技术的人将获得通往未来的船票。

DeepSeek的火爆对普通人意味着什么?

DeepSeek的火爆并非偶然。它代表了一种技术趋势:大模型技术正在从实验室走向大众。过去,大模型技术似乎只属于科技巨头和学术机构,普通人很难接触到。而现在,随着开源社区的活跃和技术的普及,像DeepSeek这样的工具已经可以让普通用户在自己的设备上部署和使用大模型。

对于普通人来说,DeepSeek的火爆意味着:

- 技术门槛降低:大模型技术不再遥不可及。通过本地部署,普通人也可以体验到强大的AI能力,无论是文本生成、对话系统还是其他AI应用。

- 个性化需求得到满足:大模型可以根据用户的需求进行定制化调整,满足个性化的应用场景。比如,你可以训练一个专门用于写作、编程或翻译的模型。

- 未来职业机会:大模型技术的普及将催生大量新的职业机会。无论是AI工程师、数据科学家,还是AI产品经理,掌握大模型技术将成为未来职场的重要竞争力。

DeepSeek的底层逻辑:大模型技术的核心

DeepSeek的底层逻辑正是基于大模型技术。大模型,顾名思义,是指参数量巨大、训练数据丰富的深度学习模型。这类模型通过海量数据的训练,能够捕捉到复杂的语言模式和知识结构,从而在各种任务中表现出色。

一、大模型岗位薪资揭密:应届生年薪40万起,跨界人才溢价300%

根据智联招聘《2024人工智能人才发展报告》,大模型相关岗位薪资较传统IT岗位平均高出67%,且呈现三大特征:

1.应届生起薪碾压传统行业

大模型算法工程师:本科28-40万/年,硕士40-60万/年

AI产品经理(无经验):25-35万/年

(数据来源:猎聘2024校招季统计)

2.跨界人才溢价惊人

医疗+大模型复合人才:薪资较纯医疗背景提升200-300%

金融风控+大模型工程师:年薪可达80-150万

(案例:某三甲医院影像科医生转型AI医疗,薪资从25万跃升至75万)

3.中小企业重金抢人

二线城市AI初创公司开出“北上广深同薪”政策

某成都电商企业为AI推荐算法工程师开出百万年薪

二、行业大地震:这些岗位正在消失,这些岗位正在爆发

▍消失中的岗位(3年内高危职业)

- 基础数据标注员(已被AutoML取代90%工作量)

- 初级代码工程师(GPT-4可完成60%基础代码)

▍爆发中的黄金岗位

1.大模型训练师

- 某直播公司开出82万年薪招聘“带货大模型调教师”

- 核心技能:Prompt工程+垂直领域知识(如美妆/3C)

2.AI业务流程重构师

- 制造业龙头企业50万年薪招聘“生产流程AI化专家”

- 典型案例:富士康通过大模型优化生产线,减少30%人力成本

3.AI伦理合规官

- 金融机构新增岗位“大模型风控总监”,年薪超百万

- 职责:防止AI在信贷审核、投资建议中出现歧视性输出

三、普通人破局指南:无需代码基础,三步抢占AI红利

我整理了全网稀缺的 《大模型落地应用实战资料包》,包含:

1.LLM大模型学习大纲+路线图

2.152个大模型各行业结合的落地案例集

3.大模型必读书籍PDF电子版

4.大模型全套系统学习视频

5.真实大厂岗位面试题库

6.640套AI大模型行业白皮书

👉👉获取方式:

结语:你正在经历人类史上最大规模的生产力革命

当东莞工厂用大模型替代500个质检员,当律所AI助理处理80%合同审查,当小红书博主用AI生成90%的图文内容——这场变革不再关乎“是否会发生”,而是“你站在哪一边”。

记住两个数字:

- 2023年全球大模型应用市场规模:270亿美元

- 2027年预测市场规模:4070亿美元

这中间3700亿美元的增量市场,就是普通人改写命运的机会。4年后你会感谢今天的决定。

7万+

7万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?