大数据运行环境的安装

1.文件准备

安装基本运行环境,需要用到:

hadoop-2.6.0-cdh5.14.2.tar.gz

jdk-8u221-linux-x64.tar.gz

zookeeper-3.4.6.tar.gz

hbase-1.2.0-cdh5.14.2.tar.gz

hive-1.1.0-cdh5.14.2.tar.gz

MySQL-client-5.6.46-1.el7.x86_64.rpm

MySQL-server-5.6.46-1.el7.x86_64.rpm

mysql-connector-java-5.1.0-bin.jar

把以上文件都拖到配置好的虚拟机,在根目录中建一个文件夹存放。

接下来开始解压文件。

tar -zxf hadoop-2.6.0-cdh5.14.2.tar.gz -C /opt

tar -zxf zookeeper-3.4.6.tar.gz -C /opt

tar -zxf hbase-1.2.0-cdh5.14.2.tar.gz -C /opt

tar -zxf hive-1.1.0-cdh5.14.2.tar.gz -C /opt

mv hadoop-2.6.0-cdh5.14.2/ hadoop

mv zookeeper-3.4.6 zookeeper

mv hbase-1.2.0-cdh5.14.2 hbase

mv hive-1.1.0-cdh5.14.2 hive

Hadoop安装配置

2.配置免密登录。

生成密钥(在家目录下操作)

ssh-keygen -t rsa -P ""

复制密钥到公钥

cat /root/.ssh/id_rsa.pub > /root/.ssh/authorized_keys

开启远程免密登录(@自己的主机地址)

ssh-copy-id -i .ssh/id_rsa.pub -p22 root@192.168.238.140

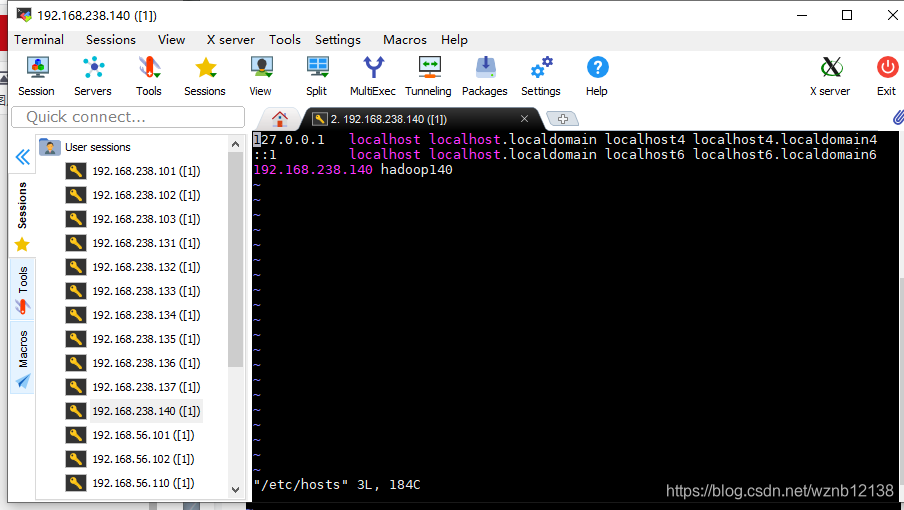

3.修改主机名和主机列表

修改主机名

vi /etc/hostname

把localhost 修改成自己想要的主机名,这个主机名在以后的安装中需要用到。

这里我用hadoop140。

添加主机

vi /etc/hosts

添加主机地址 和 主机名

让主机名修改即时生效

hostnamectl set-hostname hadoop140

4.配置运行环境

配置hadoop-evn.sh运行环境

cd /opt/hadoop/etc/hadoop

vi hadoop-env.sh

到25行,修改java_home路径

配置core-site.xml

vi core-site.xml

<!-- Put site-specific property overrides in this file. -->

<configuration>

<!-- 默认节点(写自己主机的ip)端口,端口默认为9000 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://192.168.238.140:9000</value>

</property>

<!-- hdfs的临时文件的目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/hadoop/tmp</value>

</property>

<property>

<name>hadoop.proxyuser.root.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.root.groups</name>

<value>*</value>

</property>

</configuration>

配置hdfs-site.xml

vi hdfs-site.xml

<!-- Put site-specific property overrides in this file. -->

<!--后面一个要输入自己的主机名 -->

<configuration>

<!-- 数字和集群机器数量相等 -->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<!-- namenode备用节点 -->

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>hadoop140:50090</value>

</property>

</configuration>

配置mapred-site文件

mv mapred-site.xml.template mapred-site.xml

vi mapred-site.xml

<!-- Put site-specific property overrides in this file. -->

<configuration>

<!-- mapreduce的工作模式:yarn -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<!-- mapreduce的工作地址 -->

<property>

<name>mapreduce.jobhistory.address</name>

<value>192.168.238.140:10020</value>

</property>

<!-- web页面访问历史服务端口的配置 -->

<property>

<name

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

339

339

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?